이스라엘 인공지능 스타트업 aiOla는 OpenAI의 Whisper를 개선하고 50% 더 빠른 새로운 오픈 소스 음성 인식 모델인 Whisper-Medusa를 출시했습니다. 이 모델은 Hugging Face Research의 MIT 라이선스에 따라 오픈 소스로 제공되며 상업적 사용이 허용됩니다. Downcodes의 편집자는 눈길을 끄는 이 새로운 모델에 대해 자세히 설명할 것입니다.

이스라엘 인공지능 스타트업인 aiOla는 최근 큰 움직임을 보이며 새로운 오픈 소스 음성 인식 모델인 Whisper-Medusa의 출시를 발표했습니다.

이 모델은 OpenAI의 유명한 Whisper보다 50% 더 빠르지 않습니다. Whisper를 기반으로 구축되었지만 한 번에 토큰 수를 예측하기 위해 새로운 "다중 헤드 어텐션" 아키텍처를 사용합니다. OpenAI보다 훨씬 뛰어납니다. 제품. 또한 코드와 가중치는 연구 및 상업적 사용이 허용되는 MIT 라이선스에 따라 Hugging Face에 공개되었습니다.

aiOla의 연구 담당 부사장인 Gill Hetz는 오픈 소스가 커뮤니티 혁신과 협력을 장려하여 더 빠르고 완벽하게 만들 수 있다고 말했습니다. 이 작업은 거의 실시간으로 사용자 질문을 이해하고 답변할 수 있는 복잡한 인공 지능 시스템의 토대를 마련할 수 있습니다.

기본 모델로도 다양한 콘텐츠를 제작할 수 있는 시대에 고급 음성인식은 여전히 매우 중요합니다. 예를 들어, Whisper는 다양한 언어와 억양으로 된 복잡한 음성을 처리할 수 있으며 한 달에 500만 번 이상 다운로드되고 많은 애플리케이션을 지원하며 음성 인식의 표준이 되었습니다.

그렇다면 aiOla의 Whisper-Medusa에는 어떤 특별한 점이 있나요?

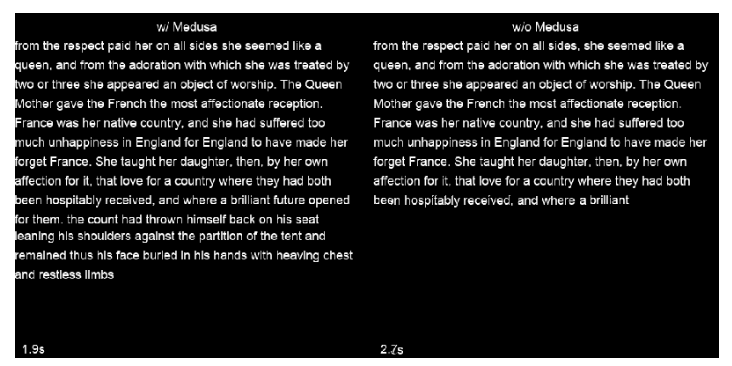

회사는 Whisper의 구조를 변경하고 다중 헤드 주의 메커니즘을 추가하여 한 번에 10개의 토큰을 예측하고 정확도에 영향을 주지 않고 속도를 50% 증가시킬 수 있습니다. 이 모델을 훈련하기 위해 약하게 지도되는 기계 학습 방법이 사용되었으며 앞으로 더 강력한 버전이 나올 예정입니다. 더욱이, Whisper-Medusa의 백본은 Whisper를 기반으로 구축되었기 때문에 속도 향상은 성능 저하를 초래하지 않습니다.

Whisper-Medusa를 훈련할 때 aiOla는 약한 감독이라는 기계 학습 방법을 사용했습니다. 그 일환으로 Whisper의 주요 구성 요소를 동결하고 모델에서 생성된 오디오 전사를 레이블로 사용하여 추가 토큰 예측 모듈을 교육했습니다.

Whisper-Medusa에 조기에 액세스할 수 있는 회사가 있는지 묻는 질문에 Hetz는 실제 기업 데이터 사용 사례에 대한 테스트를 거쳤으며 실제 시나리오에서 정확하게 실행될 수 있어 향후 음성 애플리케이션의 응답성이 더 높아질 수 있다고 말했습니다. 궁극적으로 그는 인식 및 전사 속도가 향상되면 음성 애플리케이션의 처리 시간이 더 빨라지고 실시간 응답을 제공할 수 있는 기반이 마련될 것이라고 믿습니다.

가장 밝은 부분:

?50% 더 빠름: aiOla의 Whisper-Medusa는 OpenAI의 Whisper 음성 인식보다 훨씬 빠릅니다.

?정확도 손실 없음: 원본 모델과 동일한 정확도를 유지하면서 속도가 향상됩니다.

광범위한 애플리케이션 전망: 음성 애플리케이션의 응답 속도를 높이고 효율성을 개선하며 비용을 절감할 것으로 예상됩니다.

전체적으로, 속도 이점과 오픈 소스 속성을 갖춘 aiOla의 Whisper-Medusa 모델은 음성 인식 분야에 새로운 물결을 일으키고 다양한 음성 애플리케이션에 상당한 성능 향상을 가져올 것으로 예상됩니다. Downcodes의 편집자는 이 모델의 후속 개발 및 커뮤니티 기여에 계속해서 주의를 기울일 것입니다.