AI 분야의 권위자 안드레이 카르파티(Andrej Karpathy)는 최근 인간 피드백 기반 강화학습(RLHF)에 대해 의문을 제기하며, 이것이 진정한 인간 수준의 AI를 달성하는 유일한 방법은 아니라고 믿고 업계에서 광범위한 우려와 열띤 논의를 불러일으켰습니다. . 그는 RLHF가 궁극적인 솔루션이라기보다는 임시방편에 가깝다고 믿으며, 실제 강화학습과 RLHF의 문제 해결 차이를 비교하기 위해 AlphaGo를 예로 들었습니다. Karpathy의 견해는 의심할 여지 없이 현재 AI 연구 방향에 대한 새로운 관점을 제공하고 미래 AI 개발에 새로운 도전을 가져옵니다.

최근 AI 업계의 저명한 연구자인 안드레이 카르파티(Andrej Karpathy)는 논란의 여지가 있는 관점을 제시했는데, 그는 현재 널리 호평을 받고 있는 인간 피드백 기반 강화학습(RLHF) 기술이 이를 달성하는 유일한 방법이 아닐 수도 있다고 생각합니다. 진정한 인간 수준의 문제 해결 능력. 이 발언은 의심할 여지없이 현재 AI 연구 분야에 큰 폭탄을 떨어뜨렸습니다.

RLHF는 한때 ChatGPT 등 대규모 언어 모델(LLM) 성공의 핵심 요소로 꼽혔으며, AI에 이해와 복종, 자연스러운 상호 작용 능력을 부여하는 비밀 무기로 호평받았다. 전통적인 AI 훈련 과정에서 RLHF는 일반적으로 사전 훈련과 SFT(Supervised Fine-Tuning) 후 마지막 링크로 사용됩니다. 그러나 Karpathy는 RLHF를 병목 현상 및 임시방편에 비유했으며 AI 진화를 위한 궁극적인 솔루션과는 거리가 멀다고 믿었습니다.

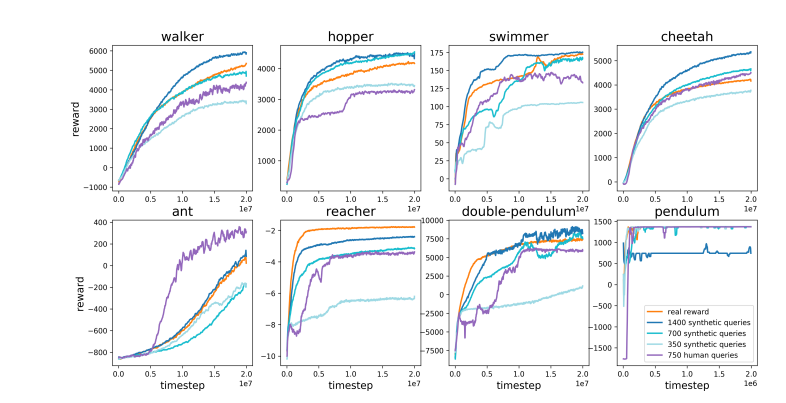

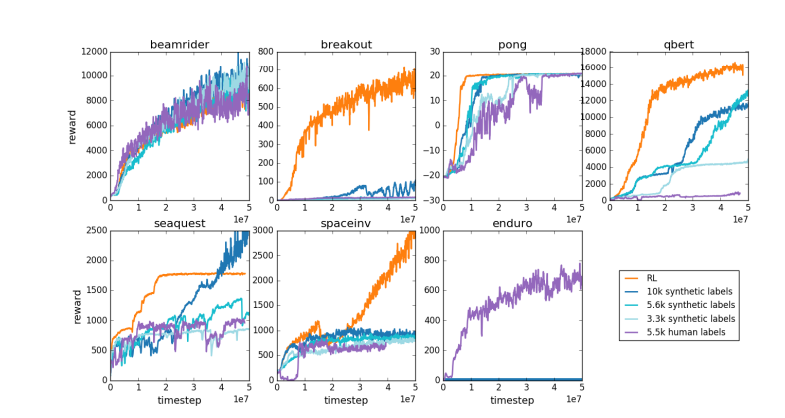

Karpathy는 RLHF를 DeepMind의 AlphaGo와 교묘하게 비교했습니다. AlphaGo는 진정한 RL(강화 학습) 기술을 사용하여 끊임없이 자기 자신과 대결하고 승률을 극대화함으로써 결국 인간의 개입 없이 최고의 인간 체스 플레이어를 능가했습니다. 이 접근 방식은 신경망을 최적화하여 게임 결과에서 직접 학습함으로써 초인적인 성능 수준을 달성합니다.

이와 대조적으로 Karpathy는 RLHF가 실제로 문제를 해결하기보다는 인간의 선호도를 모방하는 데 더 가깝다고 믿습니다. 그는 AlphaGo가 RLHF 방법을 채택한다면 인간 평가자는 수많은 게임 상태를 비교하고 선호도를 선택해야 할 것이라고 상상했습니다. 이 프로세스는 인간의 분위기 확인을 모방하는 보상 모델을 훈련하기 위해 최대 100,000번의 비교가 필요할 수 있습니다. 그러나 그러한 분위기에 기초한 판단은 바둑과 같은 엄격한 게임에서 오해의 소지가 있는 결과를 낳을 수 있습니다.

같은 이유로 현재 LLM 보상 모델은 비슷하게 작동합니다. 즉, 인간 평가자가 통계적으로 선호하는 것으로 보이는 높은 답변의 순위를 매기는 경향이 있습니다. 이는 진정한 문제 해결 능력을 반영하기보다는 피상적인 인간 선호도에 부응하는 에이전트에 가깝습니다. 더욱 걱정스럽게도 모델은 실제로 능력을 향상시키기보다는 이 보상 기능을 활용하는 방법을 빠르게 배울 수 있습니다.

Karpathy는 강화 학습이 Go와 같은 폐쇄된 환경에서는 잘 수행되지만, 개방형 언어 작업에서는 진정한 강화 학습이 여전히 어렵다고 지적합니다. 이는 주로 공개 작업에서 명확한 목표와 보상 메커니즘을 정의하기 어렵기 때문입니다. 기사 요약, pip 설치에 대한 모호한 질문에 대한 답변, 농담 또는 Java 코드를 Python으로 다시 작성하는 등의 작업에 대해 객관적인 보상을 제공하는 방법은 무엇입니까? Karpathy는 이러한 통찰력 있는 질문을 하며 이러한 방향으로 가는 것은 원칙이 아닙니다. 하지만 그것도 쉽지 않고 창의적인 사고가 필요합니다.

그럼에도 불구하고 Karpathy는 이 어려운 문제가 해결될 수 있다면 언어 모델이 인간의 문제 해결 능력과 실제로 일치하거나 심지어 능가할 수 있는 잠재력을 가지고 있다고 믿습니다. 이러한 견해는 개방성이 일반 인공지능(AGI)의 기초임을 지적한 구글 딥마인드(Google DeepMind)가 최근 발표한 논문과 일치합니다.

올해 OpenAI를 떠난 여러 수석 AI 전문가 중 한 명인 Karpathy는 현재 교육용 AI 스타트업을 진행하고 있습니다. 그의 발언은 의심할 여지없이 AI 연구 분야에 새로운 차원의 사고를 주입하고 AI 개발의 미래 방향에 대한 귀중한 통찰력을 제공했습니다.

Karpathy의 견해는 업계에서 광범위한 논의를 불러일으켰습니다. 지지자들은 그가 현재 AI 연구의 핵심 문제, 즉 단순히 인간의 행동을 모방하는 것이 아니라 AI가 진정으로 복잡한 문제를 해결할 수 있도록 만드는 방법을 밝히고 있다고 믿습니다. 반대자들은 RLHF의 조기 포기가 AI 개발 방향에서 이탈로 이어질 수 있다고 우려합니다.

논문 주소: https://arxiv.org/pdf/1706.03741

Karpathy의 견해는 AI의 미래 개발 방향에 대한 심층적인 논의를 촉발시켰습니다. RLHF에 대한 그의 의구심으로 인해 연구자들은 진정한 인공 지능을 달성한다는 궁극적인 목표를 가지고 현재의 AI 훈련 방법을 재검토하고 보다 효과적인 경로를 모색하게 되었습니다.