AI가 생성한 이미지를 사용해 재교육하면 어떻게 될까? 최근 스탠퍼드대와 캘리포니아대 버클리대 연구진이 이런 실험을 했는데 결과는 놀라웠다.

연구진은 AI 이미지 생성 모델이 스스로 생성한 이미지를 사용하도록 재교육했을 때 모델이 심하게 왜곡된 이미지를 생성한다는 사실을 발견했습니다. 더 나쁜 것은 이러한 왜곡이 재교육에 사용되는 텍스트 단서에만 국한되지 않는다는 점입니다. 일단 모델이 "오염"되면 나중에 실제 이미지만으로 재교육하더라도 모델을 완전히 복구하기가 어렵습니다.

실험의 출발점은 SD(Stable Diffusion)라는 오픈 소스 모델입니다. 연구진은 먼저 FFHQ 얼굴 데이터세트에서 70,000개의 고품질 얼굴 이미지를 선택하고 자동으로 분류했습니다. 그런 다음 이러한 실제 이미지를 입력으로 사용하여 Stable Diffusion 모델을 통해 특정 집단의 특성과 일치하는 900개의 이미지를 생성했습니다.

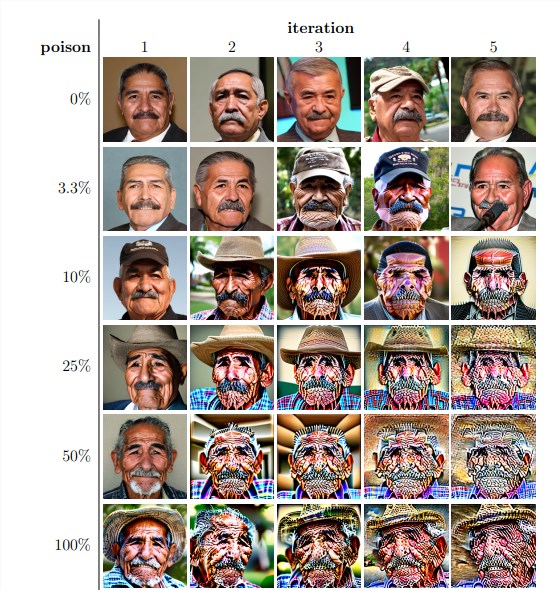

다음으로, 연구원들은 모델의 반복적인 재교육을 위해 이렇게 생성된 이미지를 사용했습니다. 그들은 재교육 데이터 세트에서 자체 생성 이미지의 비율에 관계없이 모델이 결국 붕괴되고 생성된 이미지의 품질이 급격히 떨어지는 것을 발견했습니다. 재학습 데이터에 자체 생성 이미지가 3%만 포함되어 있어도 모델 붕괴 현상이 여전히 존재합니다.

실험 결과에 따르면 Stable Diffusion 모델의 기본 버전은 텍스트 단서와 일치하고 시각적 품질이 높은 이미지를 생성합니다. 그러나 모델이 반복적으로 재학습되면서 생성된 이미지에 의미적 불일치와 시각적 왜곡이 나타나기 시작했습니다. 또한 연구원들은 모델 붕괴가 이미지 품질에 영향을 미칠 뿐만 아니라 생성된 이미지의 다양성이 부족하다는 사실도 발견했습니다.

이를 검증하기 위해 연구원들은 생성된 이미지의 색상 히스토그램을 조정하고 품질이 낮은 이미지를 제거하여 모델 붕괴의 영향을 완화하기 위한 통제된 실험도 수행했습니다. 그러나 결과는 이러한 조치가 모델 붕괴를 방지하는 데 효과적이지 않다는 것을 보여줍니다.

연구진은 또한 모델이 "오염"된 후 재훈련을 통해 복구할 수 있는지 여부도 조사했습니다. 그들은 어떤 경우에는 재훈련을 여러 번 반복한 후에 결과 이미지의 품질이 회복되었지만 모델 붕괴의 징후가 남아 있음을 발견했습니다. 이는 모델이 "오염"되면 그 효과가 장기적이거나 되돌릴 수 없을 수도 있음을 보여줍니다.

이 연구는 중요한 문제를 드러냅니다. 현재 널리 사용되는 확산 기반 텍스트-이미지 생성 AI 시스템은 데이터 "오염"에 매우 민감합니다. 이러한 "오염"은 온라인 소스에서 이미지를 무차별적으로 긁는 등 의도치 않게 발생할 수 있습니다. 또한 의도적으로 웹사이트에 "오염된" 데이터를 배치하는 등의 표적 공격일 수도 있습니다.

이러한 문제에 직면한 연구자들은 이미지 진위 탐지기를 사용하여 AI 생성 이미지를 제외하거나 생성된 이미지에 워터마크를 추가하는 등 몇 가지 가능한 솔루션을 제안했습니다. 불완전하기는 하지만 이러한 방법을 결합하면 데이터 "오염" 위험을 크게 줄일 수 있습니다.

이번 연구는 AI 기술의 발전에 위험이 따르지 않는다는 점을 상기시켜준다. AI 생성 콘텐츠가 모델과 데이터 세트에 장기적으로 부정적인 영향을 미치지 않도록 더욱 주의해야 합니다. 향후 연구에서는 AI 시스템이 이러한 유형의 데이터 "오염"에 대해 보다 탄력적으로 대처하도록 하거나 모델 "치유" 속도를 높일 수 있는 기술을 개발하는 방법을 추가로 조사해야 합니다.