Meta가 Llama 3.1을 출시한 후 Mistral AI는 1,230억의 매개변수 볼륨, 놀라운 128k의 컨텍스트 창, Llama 3.1과 비슷한 성능을 갖춘 주력 모델인 Mistral Large 2를 출시했습니다. 이 모델은 여러 언어와 프로그래밍 언어를 지원하고 단일 노드 추론을 위해 설계되었으며 효율적이고 비용 친화적입니다. 이 기사에서는 Mistral Large 2의 다양한 성능 지표, 사용 방법 및 다국어 처리, 코드 이해 및 지시 따르기 분야의 탁월한 성능을 심층적으로 살펴보고 상용 응용 프로그램 및 연구 분야에서의 잠재력을 분석합니다.

어제 Meta가 가장 강력한 오픈 소스 모델인 Llama3.1을 출시했다고 발표한 데 이어 Mistral AI는 오늘 아침 일찍 자사의 주력 모델인 Mistral Large2를 대대적으로 출시했습니다. Llama3.1과 비슷합니다.

Mistral Large2 모델 세부정보

Mistral Large2는 128k 컨텍스트 창을 갖추고 있으며 프랑스어, 독일어, 스페인어, 이탈리아어, 포르투갈어, 아랍어, 힌디어, 러시아어, 중국어, 일본어, 한국어는 물론 Python, Java, C, C++, 이상을 포함한 수십 가지 언어를 지원합니다. JavaScript, Bash를 포함한 80가지 코딩 언어.

Mistral Large2는 긴 컨텍스트 애플리케이션을 대상으로 하는 단일 노드 추론을 위해 설계되었습니다. 1,230억 개의 매개변수 크기를 통해 단일 노드에서 높은 처리량으로 실행할 수 있습니다. Mistral Large2는 Mistral Research License에 따라 출시되며 연구 및 비상업적 용도로 사용됩니다. 상업적인 필요가 있는 경우 사용자는 연락하여 상업용 라이센스를 받아야 합니다.

전반적인 성능:

성능 측면에서 Mistral Large2는 평가 지표에서 새로운 벤치마크를 확립했으며, 특히 MMLU 벤치마크 테스트에서 정확도 84.0%를 달성하여 성능과 서비스 비용 간의 강력한 균형을 입증했습니다.

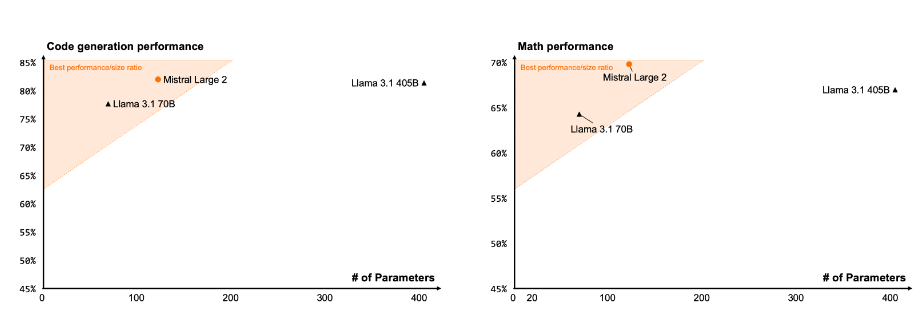

코드와 추론

Codestral22B 및 Codestral Mamba의 교육 경험을 통해 Mistral Large2는 GPT-4o, Claude3Opus 및 Llama3405B와 같은 상위 모델과 비교해도 코드 처리 성능이 뛰어납니다.

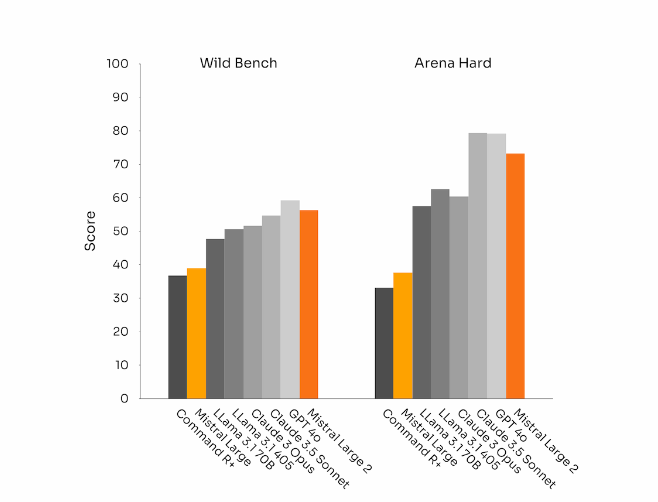

지침 준수 및 정렬

Mistral Large 2는 또한 특히 더 큰 유연성으로 복잡한 다중 회전 대화를 처리할 때 명령 따르기 및 대화 기능에서 상당한 발전을 이루었습니다. 일부 벤치마크에서는 더 긴 응답을 생성하면 점수가 향상되는 경향이 있습니다. 그러나 많은 상용 애플리케이션에서는 단순성이 매우 중요합니다. 모델 생성 시간이 짧을수록 상호 작용이 빨라지고 추론이 더욱 비용 효율적으로 이루어집니다.

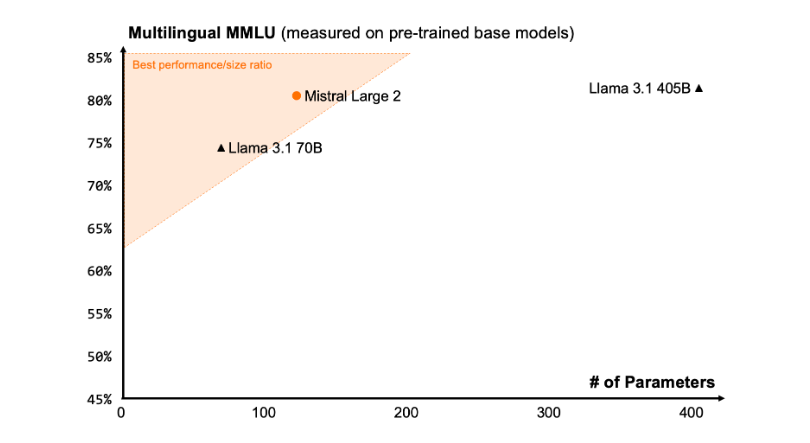

언어적 다양성

새로운 Mistral Large2는 다량의 다국어 데이터, 특히 영어, 프랑스어, 독일어, 스페인어, 이탈리아어, 포르투갈어, 네덜란드어, 러시아어, 중국어, 일본어, 한국어, 아랍어 및 힌디어로 훈련되었습니다. 탁월한 성능을 발휘합니다. 다음은 이전 Mistral Large, Llama3.1 모델 및 Cohere의 Command R+와 비교한 다국어 MMLU 벤치마크에서 Mistral Large2의 성능 결과입니다.

도구 사용법 및 함수 호출

Mistral Large2는 향상된 기능 호출 및 검색 기술을 갖추고 있으며 병렬 및 순차 기능 호출을 전문적으로 실행하도록 교육되어 복잡한 비즈니스 애플리케이션의 강력한 기능을 수행할 수 있습니다.

사용 방법:

현재 사용자는 mistral-large-2407 a la Plateforme(https://console.mistral.ai/)라는 이름으로 Mistral Large2를 사용할 수 있으며 le Chat에서 테스트되었습니다. 버전 24.07(모든 모델에 적용되는 YY.MM 버전 제어 시스템)과 API 이름 mistral-large-2407 에서 사용할 수 있습니다. 지시 모델의 가중치는 사용 가능하며 HuggingFace(https://huggingface.co/mistralai/Mistral-Large-Instruct-2407)에서도 호스팅됩니다.

La Plateforme의 제품에는 범용 모델인 Mistral Nemo와 Mistral Large, 전문 모델인 Codestral과 Embed가 있습니다. La Plateforme에서 이전 모델을 단계적으로 폐지하더라도 모든 Apache 모델(Mistral7B, Mixtral8x7B 및 8x22B, Codestral Mamba, Mathstral)은 SDK mistral-inference 및 mistral-finetune을 사용하여 계속 배포하고 미세 조정할 수 있습니다.

오늘부터 이 제품은 Plateforme의 미세 조정 기능을 확장합니다. 이러한 기능은 이제 Mistral Large, Mistral Nemo 및 Codestral에서 사용할 수 있습니다.

또한 Mistral AI는 여러 주요 클라우드 서비스 제공업체와 제휴하여 특히 Google Cloud Platform의 Vertex AI에서 Mistral Large2를 전 세계적으로 사용할 수 있도록 했습니다.

** 하이라이트: **

Mistral Large2에는 128k 컨텍스트 창이 있으며 최대 10개 언어와 80개 이상의 프로그래밍 언어를 지원합니다.

뛰어난 성능과 비용으로 MMLU 벤치마크 테스트에서 정확도 84.0%를 달성했습니다.

?사용자는 La Plateforme을 통해 새로운 모델에 접근할 수 있으며 클라우드 서비스 플랫폼에서 널리 사용됩니다.

전체적으로 Mistral Large 2는 강력한 성능, 광범위한 언어 지원 및 편리한 사용으로 대규모 언어 모델 분야에서 강력한 경쟁력을 입증했으며 연구 및 상업 응용 프로그램에 새로운 가능성을 제공합니다. 또한 오픈 소스 특성은 AI 분야의 혁신적인 개발을 더욱 촉진합니다.