LLM(대형 언어 모델)의 오픈 소스는 AI 기술 개발을 촉진하지만 지적 재산권 보호에 대한 과제도 가져옵니다. "쉘" 모델의 출현으로 인해 모델의 소스를 식별하는 것이 해결해야 할 시급한 문제가 되었습니다. 이 기사에서는 기존 모델 지문 식별 방법의 단점을 논의하고 새롭고 더욱 강력한 모델 지문 식별 방법인 REEF를 소개하고 "셸링" 문제를 효과적으로 해결하고 LLM의 지적 재산을 보호할 수 있는 방법을 소개합니다.

AI 시대에 대형 언어 모델(LLM)은 마치 무술의 비결과도 같다. 그들의 훈련 과정은 수년 동안 은둔 생활을 해온 무술 고수처럼 엄청난 컴퓨팅 파워와 데이터를 소모한다. 오픈 소스 모델의 출시는 마스터가 자신의 비밀을 공개하는 것과 같지만 지적 재산(IP)을 보호하기 위해 일부 라이센스(예: Apache2.0 및 LLaMA2 커뮤니티 라이센스)가 함께 제공됩니다.

그러나 세상은 위험하고, '포격' 사건은 늘 일어난다. 일부 개발자는 새로운 LLM을 교육했다고 주장하지만 실제로는 다른 기본 모델(예: Llama-2 및 MiniCPM-V)에 대한 래퍼 또는 미세 조정입니다. 이는 남의 무술을 몰래 배우면서 자신이 창작한 창작물이라고 주장하는 것과 같습니다. 이러한 일이 발생하지 않도록 하려면 모델 소유자와 제3자가 "쉘" 모델을 식별할 수 있는 방법이 필요합니다.

기존 모델 지문 인식 방법에는 크게 두 가지 유형이 있습니다.

주입지문 : 워터마크 방식 등 비밀장부를 은밀하게 표시하는 것과 같습니다. 이 방법은 모델 훈련 또는 미세 조정 프로세스 중에 일부 "트리거"를 인위적으로 추가하여 모델이 특정 조건에서 특정 콘텐츠를 생성할 수 있도록 함으로써 모델의 소스를 식별합니다. 그러나 이 접근 방식은 훈련 비용을 증가시키고 모델 성능에 영향을 미치며 제거될 수도 있습니다. 또한 이미 공개된 모델에는 이 방법을 적용할 수 없습니다.

고유 지문 인식: 이는 내용과 스타일을 기준으로 치트의 출처를 판단하는 것과 같습니다. 이 방법은 식별을 위해 모델 가중치 및 특징 표현을 포함하여 모델 자체의 속성을 활용합니다. 그 중 가중치 기반 지문 방식은 모델 가중치의 유사도를 계산하여 식별을 수행합니다. 그러나 이 방법은 가중치 순열, 가지치기, 미세 조정과 같은 가중치 변화에 취약합니다. 의미분석 기반 방법은 통계분석 모델에 의해 생성된 텍스트를 통해 인식을 수행한다. 그러나 두 방법 모두 견고성이 부족하다는 문제가 있습니다.

그렇다면 모델 성능에 영향을 주지 않고 "쉘" 모델을 효과적으로 식별하고 다양한 "멋진" 수정에 저항할 수 있는 방법이 있습니까?

상하이 인공 지능 연구소(Shanghai Artificial Intelligence Laboratory) 및 기타 기관의 연구원들은 새로운 모델 지문 식별 방법인 REEF를 제안했습니다.

REEF의 작동 원리는 다음과 같습니다.

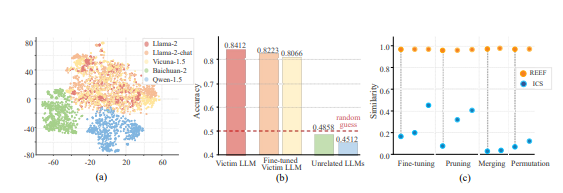

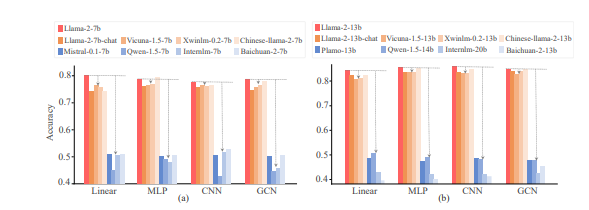

REEF는 특징 표현을 기반으로 한 지문 식별 방법입니다. 특정 레이어의 표현에 의존하지 않고 LLM의 강력한 표현 모델링 기능을 활용하여 다양한 레이어에서 특징을 추출하여 인식합니다.

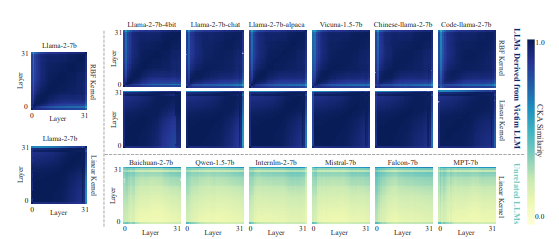

동일한 샘플에 대한 두 모델의 기능 표현의 CKA(중심 커널 정렬) 유사성을 비교합니다. CKA는 HSIC(Hilbert-Schmidt 독립 기준)을 기반으로 하는 유사성 지수로 두 세트의 확률 변수 간의 독립성을 측정할 수 있습니다.

유사성이 높으면 의심되는 모델이 피해자 모델에서 파생될 가능성이 높다는 의미이고, 그렇지 않으면 그럴 가능성이 낮다는 의미입니다.

REEF의 장점은 무엇인가요?

교육 필요 없음: 이는 모델 성능에 영향을 미치지 않으며 추가 교육 비용이 추가되지 않음을 의미합니다.

강력한 견고성: 모델 가지치기, 미세 조정, 병합, 배열 및 크기 조정 변환과 같은 다양한 후속 개발에 강력합니다. 의심되는 모델이 광범위한 미세 조정(최대 7000억 개의 데이터 토큰)을 거치더라도 REEF는 해당 모델이 피해자 모델에서 유래했는지 여부를 효과적으로 식별할 수 있습니다.

이론적 보증: 연구원들은 CKA가 열 배열 및 스케일링 변환에 변하지 않는다는 것을 이론적으로 입증했습니다.

실험 결과에 따르면 REEF는 "쉘" 모델을 식별하는 데 효과적이며 가중치 및 의미 분석을 기반으로 하는 기존 방법보다 성능이 뛰어납니다.

REEF의 출현은 LLM의 지적 재산을 보호하기 위한 새로운 도구를 제공하고 모델의 무단 사용이나 복사와 같은 비윤리적이거나 불법적인 행위를 방지하는 데 도움이 됩니다.

논문 주소: https://arxiv.org/pdf/2410.14273

전체적으로 REEF 방법은 LLM 오픈 소스 모델의 지적 재산 보호 문제에 대한 효과적이고 강력하며 효율적인 솔루션을 제공하고 보다 건강한 AI 생태 환경을 구축하는 데 기여합니다.