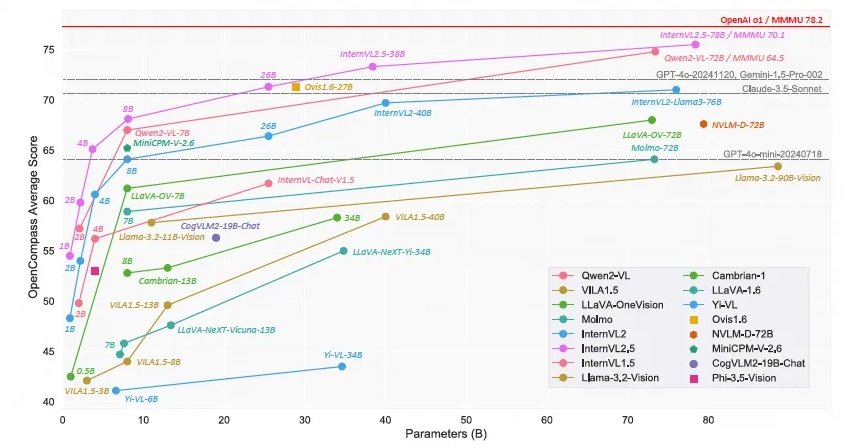

상하이 AI 연구소(Shanghai AI Laboratory)는 오픈 소스 다중 모드 대규모 언어 모델인 Scholar·Wanxiang InternVL2.5를 출시했습니다. 그 성능은 다중 모드 이해 벤치마크(MMMU)에서 70% 이상의 정확도에 도달했습니다. GPT-4o와 3.5-Sonnet과 같은 Claude-상용 모델은 비슷한 성능을 가지고 있습니다. InternVL2.5 모델은 연쇄 사고 추론 기술을 사용하여 여러 벤치마크 테스트, 특히 다분야 추론, 문서 이해 및 다중 모드 환각 감지에서 강력한 성능을 보여줍니다. 이 모델의 오픈 소스 특성은 다중 모드 AI 기술의 개발과 혁신을 크게 촉진할 것입니다.

최근 상하이 AI 연구소는 Scholar·Wanxiang InternVL2.5 모델 출시를 발표했습니다. 뛰어난 성능을 갖춘 이 오픈 소스 다중 모드 대규모 언어 모델은 GPT-4o 및 Claude와 같은 상용 모델과 경쟁하면서 MMMU(Multi-modal Understanding Benchmark)에서 정확도 70%를 초과한 최초의 오픈 소스 모델이 되었습니다. -3.5-Sonnet 비교 가능한 성능.

InternVL2.5 모델은 CoT(Chain of Thinking) 추론 기술을 통해 3.7% 포인트 개선을 달성하여 강력한 테스트 시간 확장 가능성을 보여주었습니다. 이 모델은 InternVL2.0을 기반으로 추가 개발되어 훈련 및 테스트 전략을 강화하고 데이터 품질을 향상시켜 성능을 더욱 향상시킵니다. 모델 크기와 성능 간의 관계를 탐색하기 위해 시각적 인코더, 언어 모델, 데이터 세트 크기 및 테스트 시간 구성에 대한 심층 연구를 수행합니다.

InternVL2.5는 특히 다분야 추론, 문서 이해, 다중 이미지/비디오 이해, 현실 세계 이해, 다중 모드 환각 감지, 시각적 접지, 다중 언어 기능 및 순수 언어 처리 등 여러 벤치마크에서 경쟁력 있는 성능을 보여줍니다. 그리고 다른 분야. 이 성과는 오픈 소스 커뮤니티에 다중 모드 AI 시스템의 개발 및 적용을 위한 새로운 표준을 제공할 뿐만 아니라 인공 지능 분야의 연구 및 적용을 위한 새로운 가능성을 열어줍니다.

InternVL2.5는 이전 버전인 InternVL1.5 및 InternVL2.0과 동일한 모델 아키텍처를 유지하고 "ViT-MLP-LLM" 패러다임을 따르며 새로운 증분 사전 훈련된 InternViT-6B 또는 InternViT-300M을 다양한 기능과 통합하여 구현합니다. 다양한 크기와 유형의 사전 훈련된 LLM은 무작위로 초기화된 2계층 MLP 프로젝터를 사용하여 함께 통합됩니다. 고해상도 처리의 확장성을 높이기 위해 연구팀은 픽셀 셔플 작업을 적용하여 시각적 토큰 수를 원래 수의 절반으로 줄였습니다.

모델의 오픈 소스 특성은 연구원과 개발자가 InternVL2.5에 자유롭게 액세스하고 사용할 수 있음을 의미하며, 이는 다중 모드 AI 기술의 개발과 혁신을 크게 촉진할 것입니다.

모델 링크:

https://www.modelscope.cn/collections/InternVL-25-fbde6e47302942

InternVL2.5의 오픈 소스 릴리스는 다중 모드 AI 연구를 위한 귀중한 리소스를 제공합니다. 뛰어난 성능과 확장성은 이 분야에서 추가적인 혁신을 촉진하고 보다 혁신적인 애플리케이션의 탄생을 촉진할 것으로 예상됩니다. 앞으로 InternVL2.5를 기반으로 더욱 놀라운 결과가 나올 것으로 기대됩니다.