NVIDIA의 최신 개방형 시각적 언어 모델인 NVILA는 정확성과 효율성 면에서 획기적인 발전을 이루며 시각적 AI 분야의 또 다른 이정표가 되었습니다. NVILA는 다른 대규모 비전 모델과 비교하여 훈련 비용, 메모리 사용량 및 대기 시간이 크게 감소했으며 여러 벤치마크 테스트에서도 일부 경쟁사를 능가하는 뛰어난 성능을 보여주었습니다. 이 기사에서는 모델의 정확성과 효율성의 균형을 맞추는 것을 목표로 "먼저 확장하고 나중에 압축" 기술은 물론 동적 S2 확장, DeltaLoss 기반 데이터 세트 정리 및 기타 최적화 전략을 포함하여 NVILA의 기술적 세부 사항을 자세히 소개합니다. 이는 시각적 언어 모델 기술이 보다 경제적이고 효율적인 방향으로 발전하고 있음을 의미합니다.

최근 NVIDIA는 차세대 개방형 시각적 언어 모델인 NVILA를 출시했습니다. 정확성과 효율성을 최적화하도록 설계되었으며 뛰어난 성능으로 시각 AI 분야의 선두주자로 자리매김했습니다.

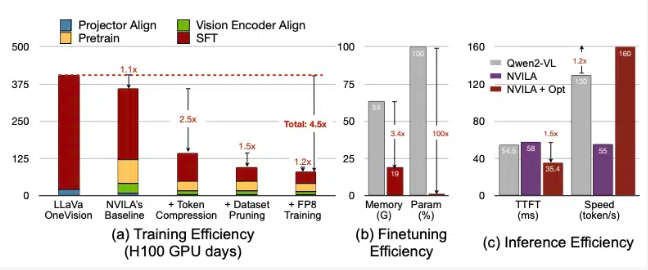

NVIDIA에 따르면 NVILA는 훈련 비용을 4.5배 줄이고, 미세 조정에 필요한 메모리를 3.4배 줄이며, 사전 채우기 및 디코딩 지연 시간을 거의 2배 줄입니다. 이 데이터는 또 다른 대형 비전 모델인 LLaVa OneVision과 비교됩니다.

비디오 벤치마크에서 NVILA는 GPT4o Mini보다 성능이 뛰어났으며 GPT4o, Sonnet3.5 및 Gemini1.5Pro와 비교해도 좋은 성능을 보였습니다. 또한 NVILA는 Llama3.2와의 비교에서도 소폭의 승리를 거두었습니다. 그럼에도 불구하고 엔비디아는 해당 모델이 아직 Hugging Face 플랫폼에 출시되지 않았다고 밝혔으며, 모델의 재현성을 높이기 위해 곧 코드와 모델을 공개하겠다고 약속했습니다.

NVIDIA는 시각적 언어 모델을 훈련하는 데 드는 비용이 매우 높다고 지적했습니다. 7B 매개변수 시각적 언어 모델을 훈련하는 데 약 400 GPU 일이 소요됩니다. 동시에, 이러한 모델을 미세 조정하는 것도 메모리 집약적이며, 7B 매개변수 모델에는 64GB 이상의 GPU 메모리가 필요합니다.

따라서 NVIDIA는 모델 정확도와 효율성의 균형을 맞추기 위해 확장 후 압축이라는 기술을 사용합니다. 사진과 비디오의 크기를 줄이는 대신 모델은 고해상도 이미지와 비디오의 여러 프레임을 사용하여 세부 사항이 손실되지 않도록 합니다.

압축 프로세스 중에 모델은 시각적 정보를 더 적은 수의 토큰으로 압축하고 픽셀을 그룹화하여 중요한 정보를 유지함으로써 입력 데이터의 크기를 줄입니다. NVIDIA는 해상도를 두 배로 늘리면 시각적 토큰의 수가 두 배로 늘어나 훈련 및 추론 비용이 2배 이상 증가할 것이라고 논문에서 언급했습니다. 따라서 공간/시간 토큰을 압축하여 이 비용을 줄입니다.

NVIDIA는 또한 일부 모델의 시연을 선보였으며 NVILA는 사진이나 비디오를 기반으로 여러 질문에 답할 수 있습니다. 출력 결과도 NVIDIA가 이전에 출시한 VILA1.5 모델과 비교합니다. 또한 NVIDIA는 동적 S2 확장, DeltaLoss 기반 데이터 세트 정리, FP8 정밀도를 사용한 양자화 등과 같은 몇 가지 다른 기술도 자세히 소개했습니다.

이러한 기법은 8B 매개변수 모델에 적용되었으며, 구체적인 내용은 Arxiv에서 확인할 수 있습니다.

논문 입구: https://arxiv.org/pdf/2412.04468

가장 밝은 부분:

? NVILA 모델은 훈련 비용을 4.5배 줄여 시각적 AI의 효율성을 향상시킵니다.

? NVILA는 고해상도 이미지와 비디오 프레임을 통해 입력 정보의 무결성을 보장합니다.

? NVIDIA는 연구의 재현성을 촉진하기 위해 곧 코드와 모델을 출시할 것을 약속합니다.

전체적으로 NVILA의 출현은 시각적 언어 모델 개발에 새로운 가능성을 가져왔습니다. NVILA의 효율적인 훈련 및 추론 프로세스는 시각적 AI 애플리케이션의 문턱을 낮추고 이 분야의 추가 개발을 촉진할 것입니다. 엔비디아의 코드와 모델의 조기 공개를 통해 더 많은 연구자들이 참여하고 시각 AI 기술의 발전을 공동으로 추진할 수 있기를 기대합니다.