Nexa AI는 엣지 장치에 최적화된 강력한 도구인 최신 OmniAudio-2.6B 오디오 언어 모델을 출시했습니다. 자동 음성 인식(ASR)과 언어 모델을 통합 프레임워크로 통합하여 처리 속도와 효율성을 크게 향상시키고 기존 아키텍처의 구성 요소 간 연결로 인해 발생하는 비효율성과 지연 문제를 해결합니다. 이 모델은 웨어러블, 자동차 시스템, IoT 장치 등 컴퓨팅 리소스가 제한된 장치에 특히 적합합니다.

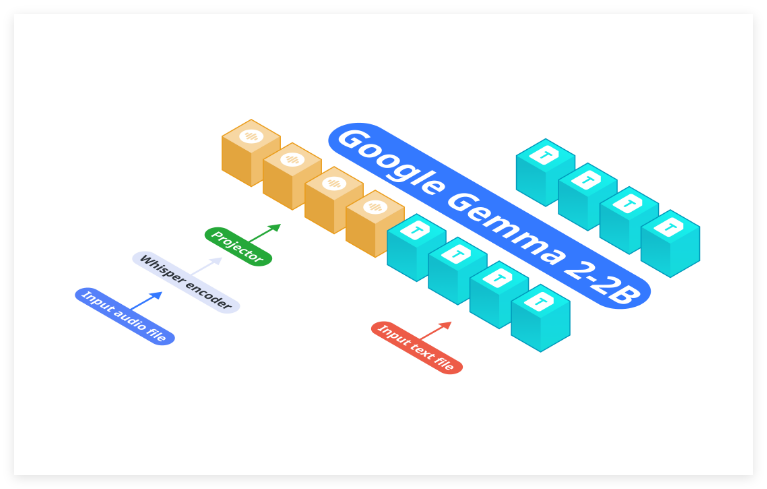

Nexa AI는 최근 에지 장치의 효율적인 배포 요구 사항을 충족하도록 설계된 새로운 OmniAudio-2.6B 오디오 언어 모델을 출시했습니다. 자동 음성 인식(ASR)과 언어 모델을 분리하는 기존 아키텍처와 달리 OmniAudio-2.6B는 Gemma-2-2b, Whisper Turbo 및 맞춤형 프로젝터를 통합 프레임워크에 통합합니다. 이 설계는 기존 시스템으로 인한 비효율성과 대기 시간을 제거합니다. 네트워크의 다양한 구성 요소를 연결하는 것은 컴퓨팅 리소스가 제한된 장치에 특히 적합합니다.

주요 하이라이트:

처리 속도: OmniAudio-2.6B는 성능이 뛰어납니다. 2024Mac Mini M4Pro에서 Nexa SDK와 FP16GGUF 형식을 사용하여 모델은 초당 35.23개의 토큰을 달성했고, Q4_K_M GGUF 형식에서는 초당 66개의 토큰을 달성했습니다. 이에 비해 Qwen2-Audio-7B는 유사한 하드웨어에서 초당 6.38개의 토큰만 처리할 수 있어 상당한 속도 이점을 보여줍니다. 리소스 효율성: 이 모델의 컴팩트한 디자인은 클라우드 리소스에 대한 의존도를 효과적으로 줄여 전력 및 대역폭이 제한된 웨어러블, 자동차 시스템 및 IoT 장치에 이상적입니다. 이 기능을 사용하면 제한된 하드웨어 조건에서도 효율적인 작업이 가능합니다. 높은 정확성과 유연성: OmniAudio-2.6B는 속도와 효율성에 중점을 두지만 정확성 측면에서도 우수한 성능을 발휘하며 전사, 번역, 요약 등과 같은 다양한 작업에 적합합니다. 실시간 음성 처리이든 복잡한 언어 작업이든 OmniAudio-2.6B는 정확한 결과를 제공할 수 있습니다.

OmniAudio-2.6B의 출시는 오디오 언어 모델 분야에서 Nexa AI의 또 다른 중요한 발전을 의미합니다. 최적화된 아키텍처는 처리 속도와 효율성을 향상시킬 뿐만 아니라 엣지 컴퓨팅 장치에 더 많은 가능성을 제공합니다. 사물 인터넷과 웨어러블 장치의 인기가 높아짐에 따라 OmniAudio-2.6B는 다양한 애플리케이션 시나리오에서 중요한 역할을 할 것으로 예상됩니다.

모델 주소: https://huggingface.co/NexaAIDev/OmniAudio-2.6B

제품 주소: https://nexa.ai/blogs/omniaudio-2.6b

전체적으로 OmniAudio-2.6B는 효율적인 아키텍처와 탁월한 성능을 통해 엣지 장치의 오디오 처리에 혁신적인 변화를 가져와 향후 AI 애플리케이션의 광범위한 대중화를 위한 견고한 기반을 마련했습니다. Nexa AI의 혁신이 기대됩니다.