Answer.AI와 LightOn은 Google BERT에 비해 크게 개선되었으며 속도, 효율성 및 품질이 크게 향상된 오픈 소스 언어 모델 ModernBERT를 공동 출시했습니다. ModernBERT는 BERT보다 4배 빠르게 처리하고, 더 적은 메모리를 사용하며, 기존 모델보다 16배 빠른 최대 8192개의 토큰까지 텍스트를 처리할 수 있습니다. 또한 처음으로 프로그래밍 코드 인코딩 분야에서 획기적인 발전을 이루며 StackOverflow Q&A 데이터세트에서 80점 이상을 기록하며 신기록을 세웠습니다. 더 중요한 것은 ModernBERT가 대규모 텍스트 처리 비용을 크게 줄이고 일반 소비자급 하드웨어에서 실행될 수 있어 GPT-4와 같은 모델보다 비용 효율적이라는 것입니다.

ModernBERT의 설계를 통해 최대 8192개의 토큰 길이까지 텍스트를 처리할 수 있습니다. 이는 기존 인코딩 모델의 일반적인 512개 토큰 제한보다 16배 향상된 것입니다. 또한 ModernBERT는 광범위하게 훈련된 최초의 프로그래밍 코드 인코딩 모델로서 StackOverflow Q&A 데이터 세트에서 80점 이상의 점수를 달성하여 인코딩 모델에 대한 새로운 기록을 세웠습니다.

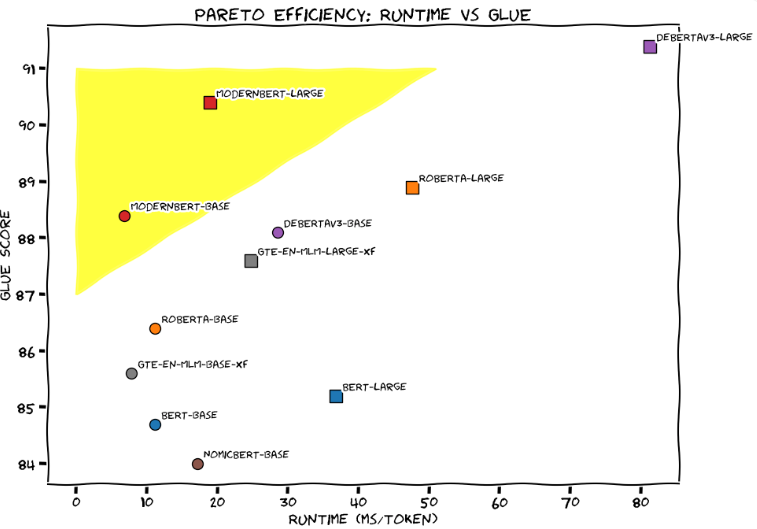

일반 언어 이해 평가(GLUE)에서 ModernBERT-Large는 토큰당 약 20밀리초의 처리 시간과 90점으로 처리 속도와 정확성 사이에서 최상의 균형을 달성했습니다. 개발팀은 ModernBERT를 튜닝된 Honda Civic과 생생하게 비교하여 일상 애플리케이션에서의 신뢰성과 효율성을 강조했습니다.

GPT-4 등 기존의 대규모 언어 모델에 비해 ModernBERT는 대규모 텍스트 처리 비용을 대폭 절감합니다. GPT-4는 쿼리당 비용이 매우 적게 드는 반면 ModernBERT는 로컬에서 실행되며 더 빠르고 저렴합니다. 예를 들어 FineWeb Edu 프로젝트가 150억 개의 태그를 필터링했을 때 BERT 모델을 사용하는 데 드는 비용은 6만 달러였으며, Google의 Gemini Flash 디코더를 사용해도 비용이 100만 달러가 넘었습니다.

개발팀은 ModernBERT가 검색 증강 생성(RAG) 시스템, 코드 검색 및 콘텐츠 검토를 포함한 다양한 실제 애플리케이션에 매우 적합하다고 말합니다. 특수 하드웨어가 필요한 GPT-4와 달리 ModernBERT는 일반 소비자 게임 GPU에서 효과적으로 실행될 수 있습니다.

현재 ModernBERT는 두 가지 버전으로 제공됩니다. 기본 모델에는 1억 3900만 개의 매개변수가 포함되어 있고 대형 버전에는 3억 9500만 개의 매개변수가 포함되어 있습니다. 이제 두 버전 모두 Hugging Face에 출시되었으며 사용자는 기존 BERT 모델을 직접 교체할 수 있습니다. 개발팀은 내년에 더 큰 버전을 출시할 계획이지만 다중 모드 기능에 대한 계획은 없습니다. 새로운 앱 개발을 촉진하기 위해 그들은 또한 5명의 최고의 발표자에게 $100와 6개월 Hugging Face 프로 구독권을 수여하는 콘테스트를 시작할 예정입니다.

Google이 2018년 BERT를 출시한 이후 이 모델은 가장 인기 있는 언어 모델 중 하나로 HuggingFace에서 월간 다운로드 수가 6,800만 건 이상을 기록했습니다.

프로젝트 입구: https://huggingface.co/blog/modernbert

가장 밝은 부분:

ModernBERT는 BERT보다 4배 빠르며 최대 8192개의 토큰 길이의 텍스트를 처리할 수 있습니다.

GPT-4와 비교하여 ModernBERT의 대규모 텍스트 처리 비용은 크게 절감되고 작업 효율성도 향상됩니다.

이 모델은 프로그래밍 코드 처리에 특히 뛰어나며 StackOverflow Q&A 데이터 세트에서 80점 이상을 기록하며 새로운 기록을 세웠습니다.

즉, ModernBERT의 오픈 소스 릴리스는 개발자에게 효율적이고 경제적이며 강력한 언어 모델 선택을 제공합니다. 이는 속도, 효율성 및 긴 텍스트 처리 능력에서 상당한 이점을 가지며 더 많은 AI 애플리케이션의 혁신적인 개발을 촉진할 것으로 예상됩니다. . 향후 업데이트와 더 폭넓은 적용을 기대합니다.