Zhiyuan Research Institute와 Tencent는 LLM(대형 언어 모델)의 긴 텍스트 이해 및 추론 기능을 평가하기 위한 벤치마크 테스트 플랫폼인 LongBench v2를 공동 출시했습니다. LongBench v2는 503개의 까다로운 4지선다형 객관식 문제를 포함해 텍스트 길이와 평가 난이도를 대폭 개선해 인간 전문가도 단시간에 높은 정확도를 얻기 어렵게 만들었다. 벤치마크는 6가지 주요 작업 범주를 다루며 결과의 신뢰성과 정확성을 높이기 위한 평가 방법론의 개선을 포함합니다. 이러한 움직임은 긴 텍스트 처리에서 대규모 언어 모델의 발전을 촉진하고 관련 연구에 대한 보다 효과적인 평가 도구를 제공하는 것을 목표로 합니다.

2024년 12월 19일 기자 회견에서 Zhiyuan Research Institute와 Tencent는 실제 긴 텍스트 다중 작업에서 LLM(대형 언어 모델)의 깊은 이해와 추론 기능을 평가하도록 설계된 LongBench v2의 출시를 발표했습니다. 벤치마크를 설계했습니다. 이 플랫폼은 이해와 추론에 있어 긴 텍스트 모델의 발전을 촉진하는 것을 목표로 하며, 긴 텍스트와 큰 언어 모델을 적용하는 데 있어 현재의 과제에 대응합니다.

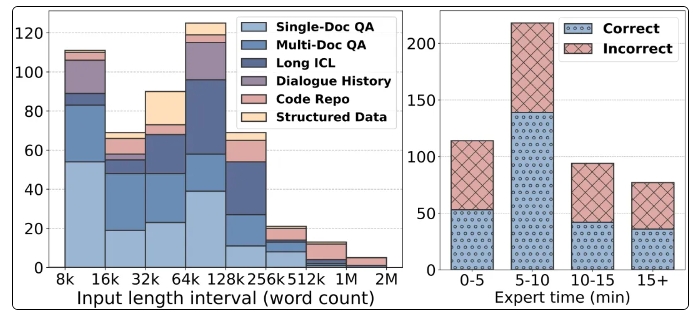

LongBench v2의 주목할만한 기능은 8,000개에서 2,000,000개의 단어에 이르는 더 긴 텍스트 길이에 대한 지원을 포함하고 있으며 난이도가 더 높은 503개의 까다로운 4지선다형 문제를 포함하고 있으며 심지어 15분 안에 인간 전문가의 평균 정확도도 53.7%에 불과합니다. . 또한 벤치마크는 단일 문서 Q&A, 다중 문서 Q&A, 긴 텍스트 컨텍스트 학습 등 6가지 주요 작업 범주를 다루며 광범위한 애플리케이션 시나리오를 보장합니다.

평가의 신뢰성을 보장하기 위해 LongBench v2의 모든 질문은 객관식 질문 형식으로 되어 있으며 엄격한 수동 주석 및 검토 프로세스를 거칩니다. 데이터 수집 과정에서 질문의 품질과 난이도를 보장하기 위해 최고 대학의 주석가를 모집했습니다. LongBench v2는 제어 변수를 도입함으로써 원래의 Bradley-Terry 통계 알고리즘을 개선하여 교란 요인의 영향을 줄이고 모델 순위를 더욱 과학적이고 정확하게 만듭니다.

평가 결과, 연구팀은 10개의 오픈소스 LLM과 6개의 비공개 소스 LLM을 테스트한 결과, 제어변수 도입 후 모델의 성능이 크게 향상되는 것을 확인했다. 특히, GPT-4o 모델은 더 많은 추론 단계를 도입한 후 다중 문서 질문 응답 및 긴 텍스트 컨텍스트 학습과 같은 작업에서 좋은 성능을 발휘하여 추론 능력의 중요성을 보여줍니다.

LongBench v2의 출시는 대규모 언어 모델을 평가하기 위한 새로운 도구를 제공할 뿐만 아니라 모델 자체의 이해 및 추론 능력을 향상시키는 것이 중요하다는 점을 강조하면서 향후 연구 방향을 제시합니다. Zhiyuan 연구소와 Tencent의 협력은 AI 기술 분야의 추가적인 발전을 의미합니다. 이번 벤치마크 테스트는 장문 이해 및 추론 기술의 발전을 촉진할 수 있을 것으로 기대됩니다.

홈페이지: https://longbench2.github.io

논문: https://arxiv.org/abs/2412.15204

데이터 및 코드: https://github.com/THUDM/LongBench

LongBench v2의 출시는 대규모 언어 모델 평가의 새로운 단계를 의미합니다. 더욱 엄격한 평가 표준과 더욱 포괄적인 테스트 콘텐츠는 긴 텍스트 이해 및 추론 기능에서 대규모 언어 모델의 지속적인 개선을 촉진하는 데 도움이 될 것입니다. 앞으로 LongBench v2를 기반으로 한 더 많은 연구 결과가 나타나 AI 기술 발전을 더욱 촉진할 수 있기를 기대합니다.