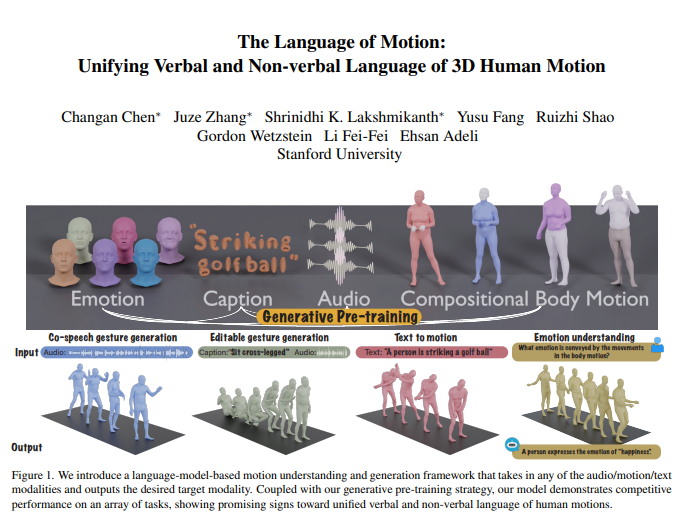

Li Feifei 팀은 최근 인간 행동을 이해하고 생성할 수 있으며 언어 모델을 교묘하게 결합하여 언어 및 비언어적 언어의 통합 처리를 달성할 수 있는 새로운 다중 모드 모델이라는 획기적인 연구 결과를 발표했습니다. 이러한 혁신을 통해 기계는 인간의 지시를 이해할 수 있을 뿐만 아니라 행동 이면의 감정도 해석할 수 있으므로 인간과 컴퓨터의 상호 작용이 더욱 자연스럽고 원활해집니다. 모델의 핵심은 오디오, 동작, 텍스트 등 여러 입력을 통합하고 해당 모달 데이터를 출력할 수 있는 다중 모드 언어 모델 프레임워크에 있습니다. 협업 음성 제스처 생성과 같은 작업에서 잘 수행되고, 모델 훈련에 필요한 데이터 양을 크게 줄이며, 편집 가능한 제스처 생성 및 동작을 통한 감정 예측과 같은 새로운 애플리케이션 시나리오를 확장합니다.

Li Feifei 팀은 인간 행동을 이해하고 생성할 수 있는 새로운 다중 모드 모델을 출시했으며, 언어 모델을 결합하여 언어 및 비언어적 언어의 통합 처리를 달성합니다. 이 획기적인 연구를 통해 기계는 인간의 지시를 이해할 뿐만 아니라 행동에 포함된 감정도 읽을 수 있어 보다 자연스러운 인간-컴퓨터 상호 작용이 가능해졌습니다.

모델의 핵심은 오디오, 동작, 텍스트 등 다양한 형태의 입력을 수신하고 필요한 모달 데이터를 출력할 수 있는 다중 모드 언어 모델 프레임워크에 있습니다. 생성적 사전 훈련 전략과 결합된 이 모델은 여러 작업에서 탁월한 성능을 보여줍니다. 예를 들어, 협업 음성 제스처 생성에서 모델은 최신 기술을 능가할 뿐만 아니라 훈련에 필요한 데이터 양을 크게 줄입니다. 또한 이 모델은 편집 가능한 제스처 생성 및 동작을 통한 감정 예측과 같은 새로운 애플리케이션 시나리오도 잠금 해제합니다.

인간의 의사소통은 본질적으로 다양하며 말, 얼굴 표정, 신체 자세와 같은 언어적, 비언어적 단서를 포함합니다. 이러한 다중 모드 동작을 이해하는 이 모델의 능력은 게임, 영화, 가상 현실과 같은 응용 프로그램에서 자연스럽게 소통하는 가상 캐릭터를 만드는 데 중요합니다. 그러나 기존 동작 생성 모델은 특정 입력 양식(음성, 텍스트 또는 동작 데이터)으로 제한되는 경우가 많으며 사용 가능한 데이터의 다양성을 완전히 활용하지 못합니다.

이 모델은 언어 모델을 활용하여 다음 세 가지 주요 이유로 언어 및 비언어적 언어를 통합합니다.

언어 모델은 자연스럽게 다양한 양식을 연결합니다.

음성은 의미론적이므로 농담에 대한 반응 모델링과 같은 작업에는 강력한 의미론적 추론 기능이 필요합니다.

언어 모델은 광범위한 사전 훈련을 통해 강력한 의미론적 이해 능력을 습득합니다.

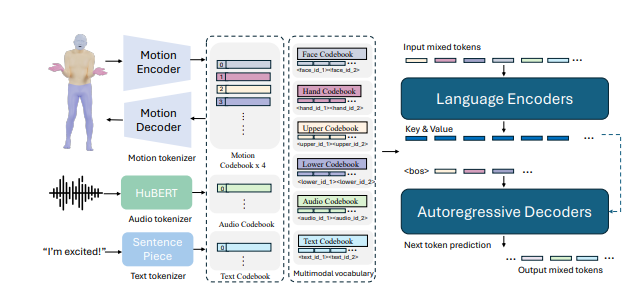

이를 위해 연구팀은 먼저 신체를 여러 부위(얼굴, 손, 상체, 하체)로 나누고 각 부위에 움직임을 나타내는 라벨을 붙였다. 텍스트와 음성 토크나이저를 결합하면 모든 형식의 입력을 언어 모델에서 사용할 일련의 토큰으로 표현할 수 있습니다. 모델은 2단계 훈련 프로세스를 채택합니다. 첫 번째 사전 훈련은 신체 움직임이 결합된 다양한 양식의 정렬과 오디오 및 텍스트의 정렬을 달성하기 위한 것입니다. 이후 다운스트림 작업은 지침으로 변환되고 모델은 이러한 지침에 따라 학습되어 다양한 작업 지침을 따를 수 있습니다.

이 모델은 BEATv2 협업 음성 제스처 생성 벤치마크에서 기존 모델을 훨씬 능가하는 우수한 성능을 보였습니다. 특히 데이터가 부족한 경우 사전 훈련 전략의 효과도 검증되어 강력한 일반화 능력을 보여줍니다. 음성 동작 및 텍스트 동작 작업에 대한 사후 학습을 통해 모델은 오디오 및 텍스트 프롬프트를 따를 수 있을 뿐만 아니라 동작 데이터에서 감정을 예측하는 등의 새로운 기능도 달성할 수 있습니다.

기술적인 세부 사항에서 모델은 다양한 입력 양식을 처리하기 위해 양식별 토크나이저를 사용합니다. 특히 이 모델은 얼굴, 손, 상체, 하체 움직임을 개별 마커로 변환하는 결합된 신체 동작 VQ-VAE를 훈련합니다. 이러한 양식별 어휘(오디오 및 텍스트)는 통합된 다중 양식 어휘로 결합됩니다. 훈련 중에는 다양한 양식의 혼합 토큰이 입력으로 사용되며 출력은 인코더-디코더 언어 모델에 의해 생성됩니다.

또한 이 모델은 다중 모드 어휘를 활용하여 다양한 모달 데이터를 처리를 위한 통합 형식으로 변환합니다. 사전 훈련 단계에서 모델은 양식 간 변환 작업을 수행하여 다양한 양식 간의 일치성을 학습합니다. 예를 들어 모델은 상체 움직임을 하체 움직임으로 변환하거나 오디오를 텍스트로 변환하는 방법을 학습할 수 있습니다. 또한 모델은 특정 동작 프레임을 무작위로 마스킹하여 동작의 시간적 진화를 학습합니다.

학습 후 단계에서 모델은 쌍을 이루는 데이터를 사용하여 미세 조정되어 공동 음성 제스처 생성 또는 텍스트-액션 생성과 같은 다운스트림 작업을 수행합니다. 모델이 자연스러운 인간 지시를 따를 수 있도록 연구원들은 오디오-액션, 텍스트-액션, 감정-액션과 같은 작업을 지침으로 변환하는 템플릿을 따르는 다중 작업 지침을 구축했습니다. 또한 이 모델에는 텍스트 및 오디오 신호를 기반으로 몸 전체의 조화로운 움직임을 생성하기 위해 제스처를 편집하는 기능도 있습니다.

마지막으로, 이 모델은 행동에서 감정을 예측하는 새로운 기능도 제공합니다. 이는 정신 건강이나 정신의학과 같은 분야에 중요한 의미를 갖습니다. 이 모델은 다른 모델보다 행동으로 표현되는 감정을 더 정확하게 예측할 수 있어 강력한 신체 언어 이해 능력을 보여줍니다.

연구에 따르면 인간 행동의 언어적, 비언어적 언어를 통합하는 것이 실제 적용에 매우 중요하며 언어 모델은 이를 위한 강력한 프레임워크를 제공합니다.

논문 주소: https://arxiv.org/pdf/2412.10523v1

전체적으로 이 연구는 다중 모드 인공 지능 분야에 상당한 진전을 가져왔습니다. 인간-컴퓨터 상호 작용, 가상 캐릭터 생성 및 감정 인식에 대한 응용 잠재력은 엄청나며 더 많은 관심과 연구가 필요합니다. 앞으로 이 모델은 더 많은 분야에서 역할을 하고 인공지능 기술 발전을 촉진할 것으로 기대된다.