NVIDIA는 GB300 및 B300 GPU를 신속하게 출시하여 GB200 및 B200 출시 후 불과 반년 만에 특히 추론 모델에서 상당한 성능 향상을 달성했습니다. 이는 단순한 하드웨어 업그레이드일 뿐만 아니라 AI 가속 분야에서 NVIDIA의 전략적 레이아웃 조정을 나타내며 업계에 지대한 영향을 미칠 것입니다. 이번 업그레이드의 핵심은 추론 성능의 큰 도약은 물론 메모리 및 아키텍처의 최적화에 있으며, 이는 대규모 언어 모델의 효율성과 비용에 직접적인 영향을 미칩니다.

GB200과 B200이 출시된 지 불과 6개월 만에 엔비디아는 다시 한번 새로운 GPU인 GB300과 B300을 출시했습니다. 이는 작은 업그레이드처럼 보일 수 있지만 실제로는 큰 변화가 포함되어 있으며, 특히 추론 모델의 성능이 크게 향상되어 전체 산업에 지대한 영향을 미칠 것입니다.

B300/GB300: 추론 성능의 큰 도약

B300GPU는 TSMC의 4NP 프로세스 노드를 사용하며 컴퓨팅 칩에 최적화되어 있습니다. 이로 인해 B300의 FLOPS 성능은 B200보다 50% 더 높아졌습니다. 성능 개선의 일부는 TDP 증가에서 비롯됩니다. GB300과 B300HGX의 TDP는 각각 1.4KW와 1.2KW에 이릅니다(GB200과 B200은 각각 1.2KW와 1KW). 나머지 성능 향상은 CPU와 GPU 간의 동적 전력 할당과 같은 아키텍처 개선 및 시스템 수준 최적화에서 비롯됩니다.

FLOPS 증가와 더불어 메모리도 12-Hi HBM3E로 업그레이드되었으며, 각 GPU의 HBM 용량도 288GB로 늘어났습니다. 하지만 핀 속도는 변함이 없으므로 GPU당 메모리 대역폭은 여전히 8TB/s입니다. 삼성이 GB200이나 GB300의 공급망 진입에 실패했다는 점은 주목할 만하다.

또한 Nvidia는 가격도 조정했습니다. 이는 Blackwell 제품의 이익률에 어느 정도 영향을 미치겠지만, 더 중요한 것은 B300/GB300의 성능 향상이 주로 추론 모델에 반영된다는 것입니다.

추론 모델에 맞게 맞춤화됨

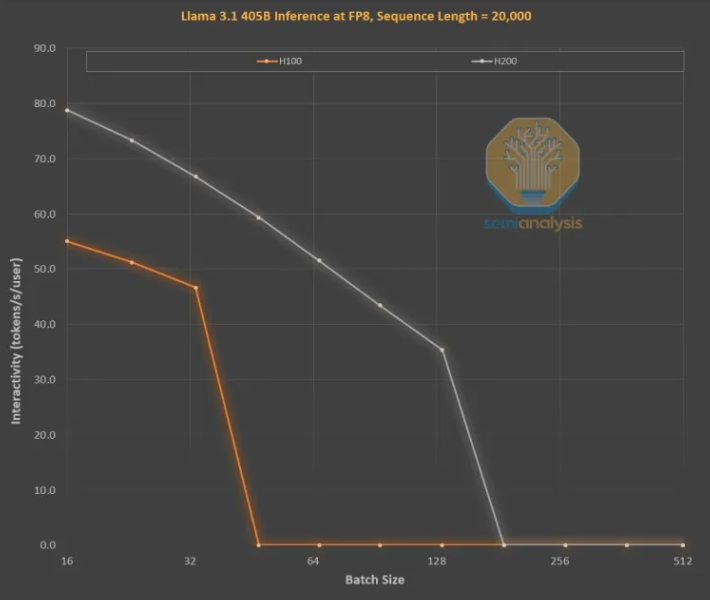

긴 시퀀스가 KVCache를 증가시켜 중요한 배치 크기와 대기 시간을 제한하므로 OpenAI O3 스타일 LLM 추론 훈련에서는 메모리 개선이 매우 중요합니다. H100에서 H200으로의 업그레이드(주로 메모리 증가)는 다음 두 가지 측면에서 개선을 가져왔습니다.

더 높은 메모리 대역폭(H200의 경우 4.8TB/s, H100의 경우 3.35TB/s)으로 인해 모든 유사한 배치 크기에서 상호 작용이 일반적으로 43% 향상되었습니다.

H200은 H100보다 더 큰 배치 크기를 실행하므로 초당 생성되는 토큰 수가 3배 증가하고 비용은 약 3배 감소합니다. 이 차이는 주로 전체 배치 크기를 제한하는 KVCache로 인해 발생합니다.

더 큰 메모리 용량의 성능 향상은 엄청납니다. 두 GPU 간의 성능과 경제적 차이는 해당 사양에서 제시하는 것보다 훨씬 큽니다.

요청과 응답 사이에 상당한 대기 시간이 있기 때문에 추론 모델에 대한 사용자 경험이 좋지 않을 수 있습니다. 추론 시간을 대폭 단축할 수 있다면 사용자의 사용 의향과 지불 의향이 높아질 것입니다.

중간 세대 메모리 업그레이드를 통한 하드웨어 성능의 3배 향상은 무어의 법칙, 황의 법칙 또는 우리가 본 다른 하드웨어 개선보다 훨씬 더 빠르고 놀랍습니다.

전체적으로 NVIDIA B300/GB300의 출시는 GPU 기술의 또 다른 도약일 뿐만 아니라 AI 추론 모델 적용을 강력하게 촉진하여 사용자 경험을 크게 향상하고 비용을 절감하여 AI 산업을 선도할 것입니다. 새로운 발전 단계에 진입합니다.