최근 Google 딥 러닝 팀과 여러 대학의 연구원들은 동적 비디오에서 카메라 매개 변수와 깊이 맵을 효율적으로 추정할 수 있는 "MegaSaM"이라는 새로운 시스템을 출시했습니다. 이는 컴퓨터 비전 분야에서 획기적인 발전을 의미하며 비디오 처리 기술에 혁명을 일으키고 다양한 분야에 널리 응용될 것으로 예상됩니다. 기존 방식은 동적 장면을 처리할 때 많은 한계가 있었습니다. MegaSaM의 등장은 이러한 문제를 효과적으로 해결하고 동적 영상 분석을 위한 새로운 솔루션을 제공합니다.

최근 구글 딥러닝팀과 여러 대학 연구진이 공동으로 일반 동적 영상에서 카메라 매개변수와 깊이 맵을 빠르고 정확하게 추정할 수 있는 'MegaSaM'이라는 새로운 시스템을 출시했습니다. 이 기술의 출현은 우리가 일상에서 기록하는 영상, 특히 역동적인 장면을 포착하고 분석하는 측면에서 더 많은 가능성을 가져올 것입니다.

전통적인 SfM(Structure from Motion) 및 SLAM(Monocular Simultaneous Localization and Mapping) 기술은 일반적으로 정적 장면의 비디오 입력이 필요하며 시차 요구 사항이 높습니다. 동적 장면에 직면할 때 정적 배경이 없으면 알고리즘에 오류가 발생하기 쉽기 때문에 이러한 방법의 성능이 만족스럽지 못한 경우가 많습니다. 최근 몇 년 동안 일부 신경망 기반 방법이 이 문제를 해결하려고 시도했지만 이러한 방법은 종종 계산 오버헤드가 크며 동적 비디오의 안정성이 부족합니다. 특히 카메라 움직임이 제어되지 않거나 시야를 알 수 없는 경우 더욱 그렇습니다.

MegaSaM의 등장으로 이러한 상황이 바뀌었습니다. 연구팀은 특히 카메라 경로가 제한되지 않는 경우 복잡한 동적 장면에 적응할 수 있도록 딥 비전 SLAM 프레임워크를 신중하게 수정했습니다. 일련의 실험을 통해 연구원들은 MegaSaM이 카메라 포즈 및 깊이 추정 측면에서 이전 관련 기술보다 훨씬 뛰어난 성능을 발휘했으며 실행 시간 측면에서도 일부 방법과 비교할 수 있을 정도로 우수한 성능을 발휘한다는 사실을 발견했습니다.

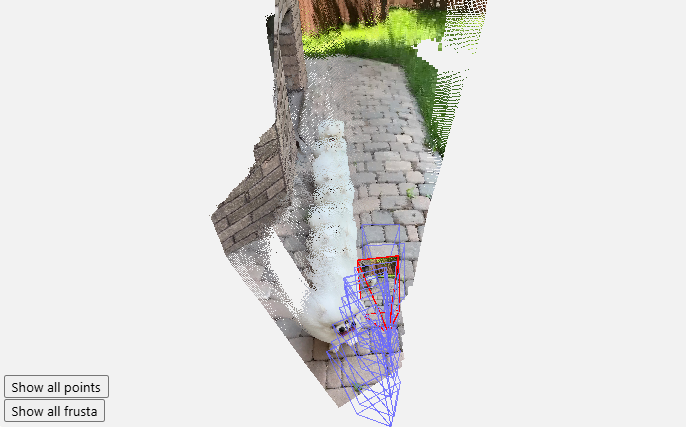

강력한 시스템 덕분에 촬영 중 강렬한 움직임이나 장면 역학이 있을 수 있는 일반 영상을 포함하여 거의 모든 비디오를 처리할 수 있습니다. MegaSaM은 초당 약 0.7프레임의 속도로 원본 영상을 처리하여 뛰어난 성능을 보여줍니다. 또한 연구팀은 실제 응용 프로그램에서의 효율성을 입증하기 위해 갤러리에 더 많은 처리 결과를 표시합니다.

이번 연구 결과는 컴퓨터 비전 분야에 새로운 바람을 불러일으킬 뿐만 아니라, 사용자들의 일상생활에서 영상 처리에 대한 새로운 가능성을 제시하며 앞으로 더 많은 장면에서 MegaSaM을 볼 수 있기를 기대합니다.

프로젝트 입구: https://mega-sam.github.io/#demo

하이라이트:

MegaSaM 시스템은 일반 동적 비디오에서 카메라 매개변수와 깊이 맵을 빠르고 정확하게 추정할 수 있습니다.

이 기술은 역동적인 장면에서 기존 방식의 단점을 극복하고 복잡한 환경의 실시간 처리에 적응합니다.

실험 결과에 따르면 MegaSaM은 정확성과 운영 효율성 측면에서 이전 기술을 능가하는 것으로 나타났습니다.

MegaSaM 시스템의 출현은 동적 비디오 처리에 혁명적인 변화를 가져왔고, 효율적이고 정확한 성능은 향후 더 많은 응용 시나리오에 대한 가능성을 제공합니다. 지속적인 기술 개발과 개선을 통해 MegaSaM은 더 많은 분야에서 중요한 역할을 담당하고 사람들의 삶에 더 많은 편리함을 가져다 줄 것으로 믿습니다.