Magic Square Quantitative는 최근 차세대 대형 모델인 DeepSeek-V3를 출시했습니다. 6,710억 개의 매개변수 규모와 MoE 아키텍처로 인해 최고의 비공개 소스 모델과 비교할 수 있는 성능을 제공하며, 이는 또한 저비용 및 고효율이라는 특징을 갖고 있어 널리 보급되었습니다. 업계의 주목. DeepSeek-V3는 많은 테스트에서 좋은 성적을 거두었으며, 특히 수학적 능력 테스트에서 기존 모델을 모두 능가했으며, GPT-4와 같은 모델보다 훨씬 저렴한 가격으로 API 서비스를 제공하여 개발자와 기업에 비용 효율적인 AI 솔루션을 제공합니다. 본 글에서는 DeepSeek-V3의 성능, 비용, 상용화 전략을 자세히 분석하고, 그것이 AI 산업에 미치는 영향에 대해 논의할 것이다.

Magic Square Quantitative는 12월 26일 저녁 차세대 대형 모델 DeepSeek-V3를 출시하여 놀라운 기술 혁신을 보여주었습니다. MoE(Mixed Experts) 아키텍처를 사용하는 이 모델은 최고의 비공개 소스 모델과 성능면에서 비교할 수 있을 뿐만 아니라 저비용, 고효율 기능이 업계의 주목을 받았습니다.

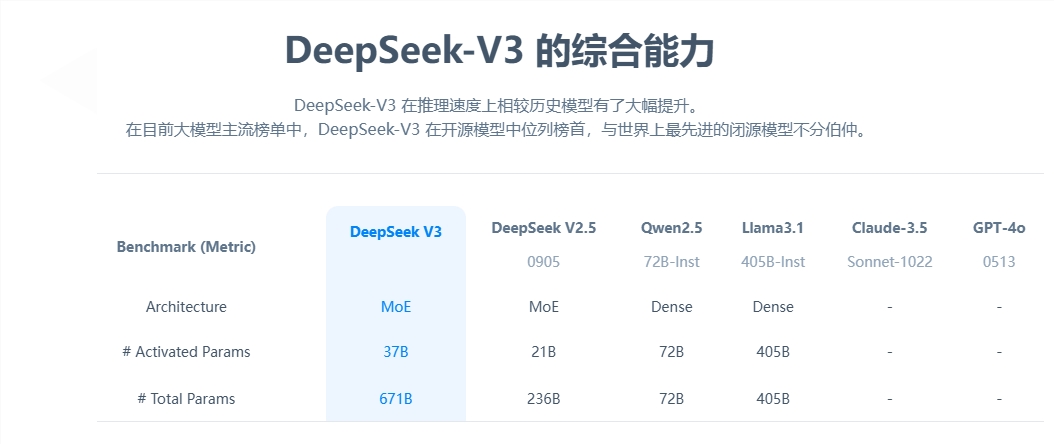

핵심 매개변수 측면에서 DeepSeek-V3는 6,710억 개의 매개변수를 보유하고 있으며 그 중 370억 개가 활성화 매개변수이며 14.8조 토큰의 데이터 규모로 사전 훈련을 완료했습니다. 이전 세대 제품과 비교하여 신형 모델의 생성 속도는 3배 증가했으며 초당 60개의 토큰을 처리할 수 있어 실제 응용 프로그램의 효율성이 크게 향상되었습니다.

성능평가에서는 DeepSeek-V3가 뛰어난 강점을 보인다. Qwen2.5-72B 및 Llama-3.1-405B와 같은 잘 알려진 오픈 소스 모델을 능가할 뿐만 아니라 여러 테스트에서 GPT-4 및 Claude-3.5-Sonnet과 동등합니다. 특히 수학적 능력 테스트에서는 기존의 모든 오픈소스 모델과 클로즈드소스 모델을 능가하며 우수한 결과를 보였다.

가장 눈에 띄는 점은 DeepSeek-V3의 저가형 장점이다. 오픈 소스 문서에 따르면 GPU 시간당 미화 2달러로 계산된 모델의 총 훈련 비용은 미화 557만 6천 달러에 불과합니다. 이 획기적인 결과는 알고리즘, 프레임워크 및 하드웨어의 공동 최적화 덕분입니다. OpenAI 공동 창업자인 Karpathy는 이를 높이 평가하며 DeepSeek-V3가 단 280만 GPU 시간 만에 Llama3를 능가하는 성능을 달성했으며 컴퓨팅 효율성이 약 11배 향상되었다고 지적했습니다.

상용화 측면에서는 DeepSeek-V3의 API 서비스 가격이 이전 세대에 비해 인상되었음에도 여전히 높은 가성비를 유지하고 있다. 새 버전의 가격은 백만 입력 토큰당 0.5~2위안, 백만 출력 토큰당 8위안으로 총 비용은 약 10위안입니다. 이에 비해 GPT-4의 등가 서비스 가격은 약 140위안으로 가격 격차가 상당하다.

포괄적인 오픈 소스 대형 모델인 DeepSeek-V3의 출시는 중국 AI 기술의 발전을 보여줄 뿐만 아니라 개발자와 기업에 고성능, 저비용 AI 솔루션을 제공합니다.

DeepSeek-V3의 등장은 대규모 언어 모델 분야에서 중국 AI 기술의 획기적인 발전을 의미합니다. 저렴한 비용과 고성능 이점으로 인해 상용 응용 프로그램에서 경쟁력이 높아졌으며 향후 개발을 기대할 가치가 있습니다. . 이 모델의 오픈 소스는 글로벌 AI 커뮤니티에 귀중한 리소스를 제공하고 AI 기술의 공유 및 개발을 촉진합니다.