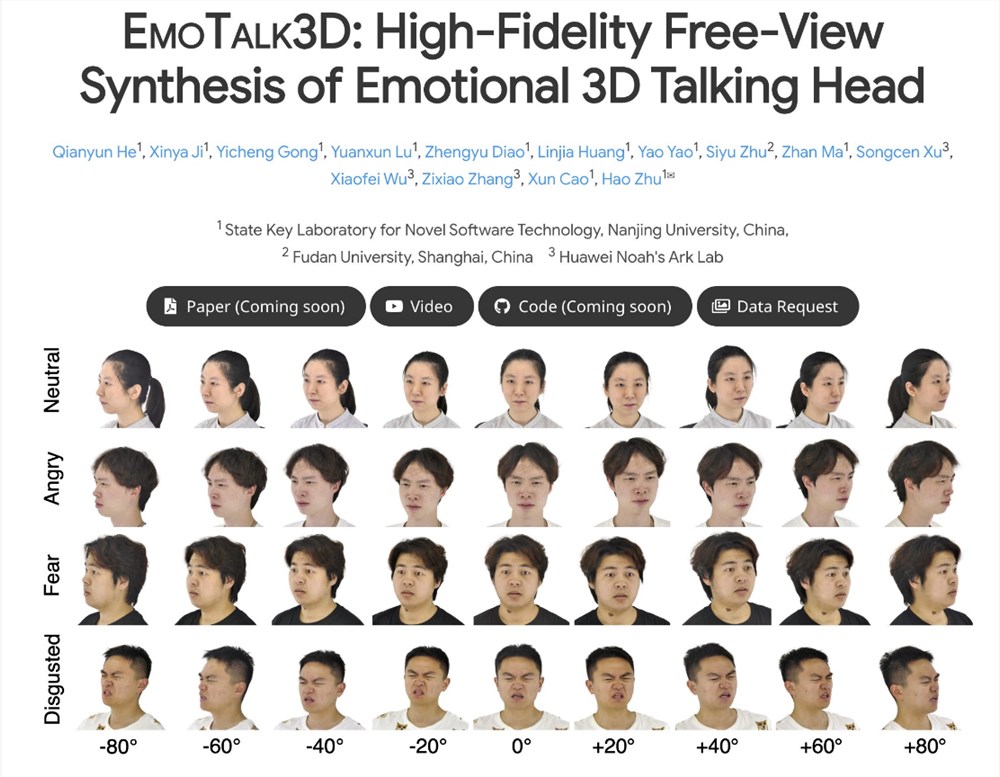

EmoTalk3D 프로젝트는 인공 지능 분야에서 획기적인 발전을 이루었습니다. 그 핵심은 충실도가 높고 감성이 풍부한 3D 말하는 아바타를 성공적으로 합성하는 데 있습니다. 본 프로젝트는 기존 기술의 문제점인 다시점 일관성과 감정 표현의 부적합성을 해결합니다. 프레임워크는 3D 기하학적 시퀀스를 정확하게 예측하고, 4D 가우시안 표현을 기반으로 3D 아바타 모양을 합성하며, 궁극적으로 미묘한 표정과 주름까지도 사실적으로 표현할 수 있는 프리뷰 말하는 아바타 애니메이션을 구현할 수 있습니다.

EmoTalk3D 프로젝트 연구팀은 다시점 일관성과 감정 표현 측면에서 현재 3D 말하는 아바타 기술의 단점을 보완하기 위해 새로운 합성 방식을 제안한 것으로 파악된다. 이 접근 방식은 향상된 입술 동기화 및 렌더링 품질을 가능하게 할 뿐만 아니라 생성된 말하는 아바타에서 제어 가능한 감정 표현도 가능하게 합니다.

연구팀은 "음성-기하학-외관" 매핑 프레임워크를 설계했습니다. 프레임워크는 먼저 오디오 특징으로부터 충실한 3D 기하학적 시퀀스를 예측한 다음 이러한 기하학적 구조를 기반으로 4D 가우스로 표현되는 3D 말하는 머리의 모양을 합성합니다. 이 과정에서 외모는 표준 및 동적 가우스 구성 요소로 더욱 분해되며, 이는 다시점 비디오 학습을 통해 융합되어 자유 보기 대화 아바타 애니메이션을 렌더링합니다.

EmoTalk3D 프로젝트의 연구팀은 주름 표현, 미묘한 표정 등 얼굴의 역동적인 디테일을 포착하는 데 있어 이전 방법의 어려움을 성공적으로 해결했다는 점도 언급할 가치가 있습니다. 실험 결과에 따르면 이 방법은 충실도가 높고 감정적으로 제어할 수 있는 3D 말하는 아바타를 생성하는 데 상당한 이점이 있는 동시에 입술 모션 생성에서 더 나은 렌더링 품질과 안정성을 나타내는 것으로 나타났습니다.

현재 EmoTalk3D 프로젝트의 코드와 데이터 세트는 전 세계 연구자와 개발자가 참조하고 사용할 수 있도록 지정된 HTTPS URL에 공개되었습니다. 이러한 혁신적인 기술 혁신은 의심할 바 없이 3D 말하는 아바타 분야의 발전에 새로운 활력을 불어넣을 것이며, 향후 가상 현실, 증강 현실, 영화 및 TV 제작 등 다양한 분야에서 사용될 것으로 예상됩니다.

EmoTalk3D 프로젝트의 성공은 3D 디지털 캐릭터 제작에 새로운 가능성을 가져왔습니다. 충실도가 높고 감성적인 3D 아바타 기술은 가상 현실, 증강 현실, 영화 및 TV 제작 분야에 혁신적인 변화를 가져올 것입니다. 앞으로는 EmoTalk3D 기술을 기반으로 하는 더 많은 제품과 애플리케이션이 등장하여 사람들에게 더욱 몰입감 있는 경험을 제공할 수 있기를 기대합니다.