Kimi 개방형 플랫폼은 매우 기대되는 컨텍스트 캐싱 기능의 내부 테스트를 곧 시작할 예정입니다. 이 혁신적인 기술은 긴 텍스트 대형 모델의 사용자 경험을 크게 향상시킬 것입니다. 중복된 토큰 콘텐츠를 캐싱함으로써 컨텍스트 캐싱은 사용자가 동일한 콘텐츠를 요청하는 비용을 크게 줄이고 API 인터페이스 응답 속도를 크게 향상시킬 수 있습니다. 이는 대규모 및 매우 반복적인 프롬프트 시나리오와 같이 빈번한 요청과 다수의 초기 컨텍스트에 대한 반복적인 참조가 필요한 애플리케이션 시나리오에 특히 중요합니다.

6월 20일 ChinaZ.com 소식: Kimi Open Platform은 최근 많은 기대를 모았던 컨텍스트 캐싱 기능이 곧 내부 테스트를 시작할 것이라고 발표했습니다. 이 혁신적인 기능은 긴 텍스트의 대규모 모델을 지원하고 효율적인 컨텍스트 캐싱 메커니즘을 통해 사용자에게 전례 없는 경험을 제공합니다.

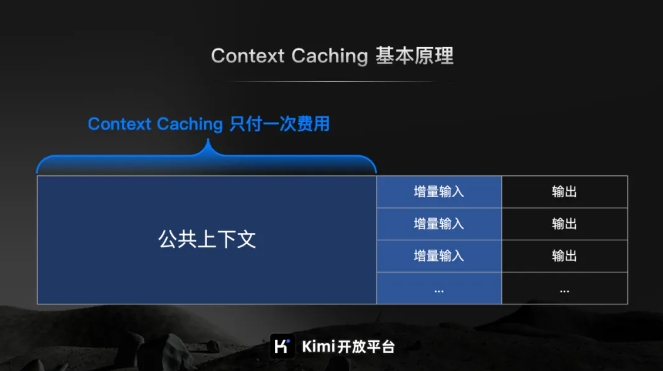

Kimi Open Platform의 공식 소개에 따르면 컨텍스트 캐싱은 중복된 토큰 콘텐츠를 캐싱하여 동일한 콘텐츠를 요청하는 사용자의 비용을 크게 절감하도록 설계된 최첨단 기술입니다. 작동 원리는 사용자가 다시 요청할 때 처리된 텍스트 조각을 지능적으로 식별하고 저장하는 것입니다. 이를 통해 시스템은 캐시에서 해당 조각을 신속하게 검색할 수 있으므로 API 인터페이스 응답 속도가 크게 향상됩니다.

대규모이고 매우 반복적인 프롬프트 시나리오의 경우 컨텍스트 캐싱 기능의 이점이 특히 중요합니다. 빈번하게 발생하는 대량의 요청에 신속하게 대응하고 처리 효율성을 크게 향상시키는 동시에 캐시된 콘텐츠를 재사용하여 비용을 절감할 수 있습니다.

컨텍스트 캐싱 기능은 빈번한 요청과 다수의 초기 컨텍스트에 대한 반복 참조가 필요한 애플리케이션 시나리오에 특히 적합하다는 점을 언급할 가치가 있습니다. 이 기능을 통해 사용자는 효율적인 컨텍스트 캐싱을 쉽게 구현할 수 있어 작업 효율성이 향상되고 운영 비용이 절감됩니다.

컨텍스트 캐싱 기능의 내부 테스트가 곧 시작될 예정이며, 이는 대형 모델의 효율성을 향상하고 사용자 비용을 절감하기 위해 Kimi 개방형 플랫폼이 취한 중요한 단계입니다.