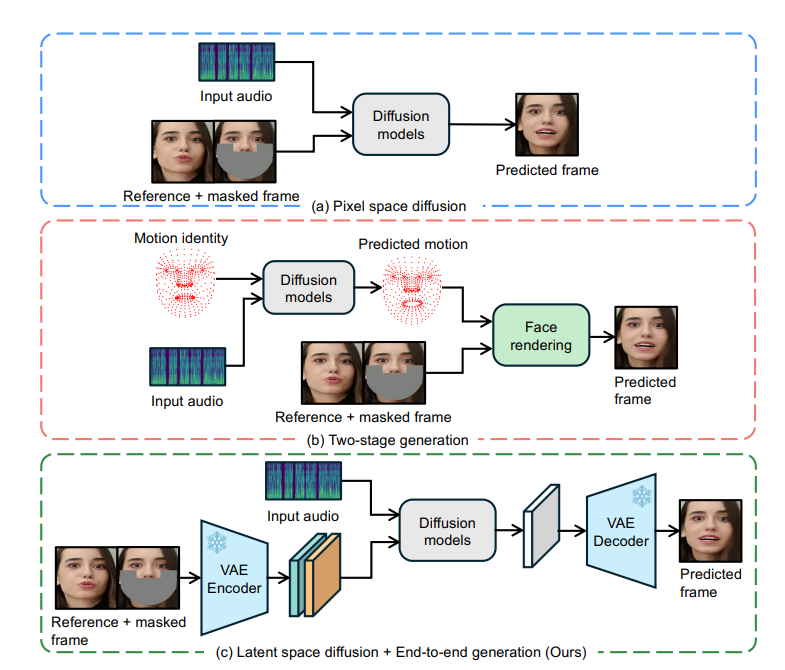

ByteDance는 오디오 조건의 잠재 확산 모델을 기반으로 하며 비디오에서 캐릭터의 입술 움직임을 오디오와 정확하게 동기화하는 LatentSync라는 혁신적인 입술 동기화 기술을 오픈 소스로 제공했습니다. 중간 동작 표현 없이 Stable Diffusion의 기능을 직접 활용하고 복잡한 시청각 연관성을 효과적으로 모델링하며 TREPA(Temporal Representation Alignment) 기술을 통해 시간적 일관성을 향상시킵니다. 또한 LatentSync는 SyncNet의 수렴 문제를 최적화하고 립싱크 정확도를 크게 향상시킵니다. 이 기술은 엔드투엔드 프레임워크, 고품질 생성, 시간적 일관성 및 SyncNet 최적화 측면에서 상당한 이점을 갖고 있어 오디오 기반 인물 애니메이션을 위한 새로운 솔루션을 제공합니다.

확산 기반 립 동기화 방법은 서로 다른 프레임 간의 확산 과정의 불일치로 인해 시간적 일관성 측면에서 성능이 떨어지는 것으로 나타났습니다. 이 문제를 해결하기 위해 LatentSync에서는 TREPA(Time Representation Alignment) 기술을 도입합니다. TREPA는 대규모 자체 감독 비디오 모델에서 추출된 시간적 표현을 활용하여 생성된 프레임을 실제 프레임과 정렬함으로써 립싱크 정확도를 유지하면서 시간적 일관성을 향상시킵니다.

또한 연구팀은 싱크넷의 융합 문제에 대한 심층적인 연구도 진행했으며, 다수의 실증적 연구를 통해 모델 아키텍처, 하이퍼파라미터 학습, 데이터 전처리 방법 등 싱크넷의 융합에 영향을 미치는 주요 요인을 파악했다. 이러한 요소를 최적화함으로써 HDTF 테스트 세트에 대한 SyncNet의 정확도가 91%에서 94%로 크게 향상되었습니다. SyncNet의 전반적인 훈련 프레임워크는 변경되지 않으므로 이 경험은 SyncNet을 활용하는 다른 입술 동기화 및 오디오 기반 인물 애니메이션 방법에도 적용될 수 있습니다.

LatentSync의 장점

엔드투엔드 프레임워크: 중간 모션 표현 없이 오디오에서 직접 동기화된 입술 움직임을 생성합니다.

고품질 생성: Stable Diffusion의 강력한 기능을 사용하여 역동적이고 사실적인 말하기 비디오를 생성합니다.

시간적 일관성: TREPA 기술을 통해 비디오 프레임 간의 시간적 일관성을 향상합니다.

SyncNet 최적화: SyncNet의 수렴 문제를 해결하고 립싱크의 정확도를 크게 향상시킵니다.

작동 원리

LatentSync의 핵심은 마스크된 이미지를 참조로 입력해야 하는 이미지 대 이미지 복구 기술을 기반으로 합니다. 원본 영상의 얼굴 시각적 특징을 통합하기 위해 모델은 참조 이미지도 입력합니다. 채널 스플라이싱 후 이러한 입력 정보는 처리를 위해 U-Net 네트워크에 입력됩니다.

이 모델은 사전 훈련된 오디오 특징 추출기 Whisper를 사용하여 오디오 임베딩을 추출합니다. 입술 움직임은 주변 프레임의 오디오에 의해 영향을 받을 수 있으므로 모델은 더 많은 시간적 정보를 제공하기 위해 여러 주변 프레임의 오디오를 입력으로 묶습니다. 오디오 임베딩은 교차 관심 레이어를 통해 U-Net에 통합됩니다.

SyncNet은 이미지 공간 입력이 필요한 문제를 해결하기 위해 모델은 먼저 잡음 공간에서 예측한 후 단일 단계 방법을 통해 추정된 깨끗한 잠재 공간을 얻습니다. 이 연구는 픽셀 공간에서 SyncNet을 훈련하는 것이 잠재 공간에서 훈련하는 것보다 낫다는 것을 발견했는데, 이는 VAE 인코딩 중에 입술 영역의 정보가 손실되기 때문일 수 있습니다.

학습 과정은 두 단계로 나누어집니다. 첫 번째 단계에서는 U-Net이 픽셀 공간 디코딩 없이 시각적 특징을 학습하고 SyncNet 손실을 추가합니다. 두 번째 단계에서는 디코딩된 픽셀 공간 감독 방법을 사용하여 SyncNet 손실을 추가하고 LPIPS 손실을 사용하여 이미지의 시각적 품질을 향상시킵니다. 모델이 시간 정보를 올바르게 학습하려면 입력 노이즈도 시간적으로 일관되어야 하며 모델은 혼합 노이즈 모델을 사용합니다. 또한 데이터 전처리 단계에서는 얼굴 정면화를 달성하기 위해 아핀 변환도 사용됩니다.

트레파 기술

TREPA는 생성된 이미지 시퀀스와 실제 이미지 시퀀스의 시간적 표현을 정렬하여 시간적 일관성을 향상시킵니다. 이 방법은 대규모 자체 감독 비디오 모델 VideoMAE-v2를 사용하여 시간적 표현을 추출합니다. 이미지 간의 거리 손실만 사용하는 방법과 달리 시간 표현은 이미지 시퀀스의 시간적 상관 관계를 포착하여 전반적인 시간적 일관성을 향상시킬 수 있습니다. 연구에 따르면 TREPA는 입술 동기화의 정확성을 손상시키지 않을 뿐만 아니라 실제로 향상시킬 수 있습니다.

SyncNet 융합 문제

연구에 따르면 SyncNet의 훈련 손실은 0.69 근처에 머무르는 경향이 있으며 더 이상 줄일 수 없습니다. 연구진은 광범위한 실험 분석을 통해 배치 크기, 입력 프레임 수, 데이터 전처리 방법이 싱크넷 융합에 중요한 영향을 미친다는 사실을 발견했습니다. 모델 아키텍처도 수렴에 영향을 주지만 그 정도는 적습니다.

실험 결과에 따르면 LatentSync는 여러 지표에서 다른 최첨단 립싱크 방법보다 성능이 뛰어난 것으로 나타났습니다. 특히 립싱크 정확도 측면에서 최적화된 SyncNet 및 오디오 교차 주의 레이어 덕분에 오디오와 입술 움직임 사이의 관계를 더 잘 포착할 수 있습니다. 또한 TREPA 기술 덕분에 LatentSync의 시간 일관성이 크게 향상되었습니다.

프로젝트 주소: https://github.com/bytedance/LatentSync

LatentSync의 오픈 소스는 립싱크 기술 개발에 새로운 혁신을 가져왔습니다. 효율적이고 정확한 성능과 최적화된 훈련 방법은 연구 및 적용할 가치가 있습니다. 앞으로 이 기술은 영상제작, 가상현실 등 다양한 분야에서 더 큰 역할을 할 것으로 기대된다.