알리바바다모아카데미 연구팀은 NeurIPS 2024 컨퍼런스에서 'SHMT: Self-supervised Hierarchical Make-up Transfer'라는 제목의 논문을 발표했다. 이 기술은 Latent Diffusion Model을 이용하여 메이크업 이미지를 정확하게 생성하는 기술로, 메이크업 응용 및 이미지 처리 분야에서 활용 가능성이 높습니다. SHMT 모델은 메이크업 참고 사진과 대상 인물의 사진만 있으면 메이크업 효과를 대상 얼굴에 전달할 수 있어 메이크업 효과의 편집 및 적용 과정이 크게 단순화됩니다. 팀은 연구원들의 추가 연구 및 개발을 촉진하기 위해 훈련 코드, 테스트 코드 및 사전 훈련된 모델을 오픈 소스로 제공했습니다.

최근 알리바바 다모 아카데미(Alibaba Damo Academy) 연구팀은 "SHMT: Self-supervised Hierarchical Make Transfer"라는 중요한 연구 결과를 발표했으며, 이 논문은 최고의 국제 학술 컨퍼런스인 NeurIPS2024에 게재되었습니다. 본 연구에서는 잠재 확산 모델(Latent Diffusion Models)을 활용하여 정확한 메이크업 이미지 생성을 구현하고 메이크업 적용 및 이미지 처리 분야에 새로운 활력을 불어넣는 새로운 메이크업 효과 전달 기술을 입증합니다.

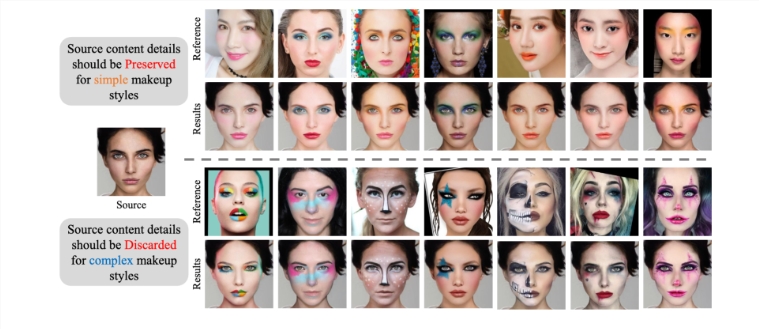

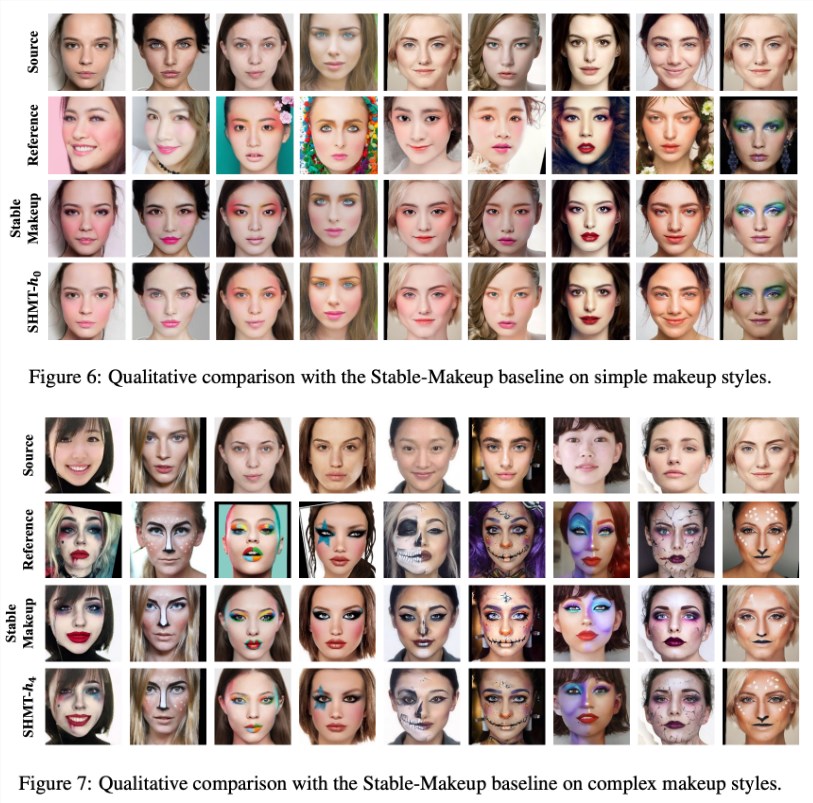

간단히 말해서, SHMT는 메이크업 참고 사진과 대상 캐릭터의 사진을 이용하면 메이크업 효과를 대상 얼굴에 전달할 수 있는 기술입니다.

팀은 프로젝트에서 오픈 소스 접근 방식을 채택하고 훈련 코드, 테스트 코드 및 사전 훈련 모델을 공개하여 연구자들이 관련 연구 개발을 더 쉽게 수행할 수 있도록 했습니다.

모델 구축 과정에서 팀은 사용자에게 "ldm"이라는 conda 환경을 만들고 제공된 환경 파일을 통해 설정을 빠르게 완료할 것을 권장합니다. 또한, 본 연구에서는 사전 훈련된 자동 인코딩 모델로 VQ-f4를 선택했습니다. 사용자는 이를 다운로드하여 지정된 체크포인트 폴더에 넣어야 원활한 추론을 시작할 수 있습니다.

데이터 준비는 SHMT 모델의 성공적인 운영에 핵심입니다. 연구팀은 'BeautyGAN'에서 제공하는 메이크업 전송 데이터 세트를 다운로드하고 다양한 메이크업 이미지와 비메이크업 이미지를 통합할 것을 권장합니다. 동시에 얼굴 분석 및 3D 얼굴 데이터 준비도 중요하며, 사용자가 효과적으로 데이터를 준비할 수 있도록 관련 도구와 데이터 경로가 연구에 자세히 설명되어 있습니다.

모델 훈련 및 추론 측면에서 연구팀은 사용자가 자신의 필요에 따라 매개변수를 조정할 수 있도록 상세한 명령줄 스크립트를 제공합니다. 또한 팀은 특히 데이터 구조의 중요성을 강조하여 사용자에게 데이터 준비 방법을 안내하는 명확한 디렉토리 구조 예를 제공했습니다.

SHMT 모델의 출시는 메이크업 효과 전달 분야에서 자기 지도 학습이 성공적으로 적용되었음을 의미하며 향후 미용, 화장품, 이미지 처리 및 기타 산업에서 널리 사용될 수 있습니다. 이번 연구는 기술의 잠재력을 보여줄 뿐만 아니라, 관련 분야에 대한 심도 있는 연구를 위한 탄탄한 기반을 마련합니다.

프로젝트 입구: https://github.com/Snowfallingplum/SHMT

하이라이트:

1. SHMT 모델은 잠재 확산 모델을 사용하여 메이크업 효과 전달을 달성하며 NeurIPS2024에서 승인되었습니다.

2. 팀은 연구자의 적용과 개선을 촉진하기 위해 완전한 오픈 소스 코드와 사전 훈련된 모델을 제공합니다.

3. 데이터 준비 및 매개변수 조정이 중요하며, 연구에서는 운영 프로세스 및 디렉토리 구조에 대한 자세한 지침을 제공합니다.

전체적으로 SHMT 모델의 오픈 소스 릴리스는 메이크업 효과 마이그레이션 연구를 위한 강력한 도구와 리소스를 제공하며 뷰티, 화장품 및 이미지 처리 분야에서의 응용 전망은 기대할만한 가치가 있습니다. 본 연구의 혁신성과 실용성은 해당 분야에서 중요한 돌파구가 되며 향후 관련 연구를 위한 탄탄한 기반을 마련합니다.