비디오 데이터 양이 폭발적으로 증가함에 따라 지식 검색 및 질문 답변을 위해 비디오 정보를 효과적으로 사용하는 방법이 연구 핫스팟이 되었습니다. 전통적인 검색 증강 생성(RAG) 시스템은 대부분 텍스트 정보에 의존하며 비디오에 포함된 풍부한 다중 모드 정보를 완전히 활용하기가 어렵습니다. 이 기사에서는 쿼리와 관련된 비디오를 동적으로 검색하고 시각적 및 텍스트 정보를 효과적으로 통합하여 보다 정확하고 유용한 답변을 생성할 수 있는 VideoRAG라는 새로운 프레임워크를 소개합니다. 프레임워크는 LVLM(대형 비디오 언어 모델)을 활용하여 다중 모드 데이터의 원활한 통합을 달성하고 자동 음성 인식 기술을 통해 자막이 없는 비디오를 처리하여 검색 및 생성 효율성을 크게 향상시킵니다.

비디오 기술의 급속한 발전으로 비디오는 정보 검색과 복잡한 개념 이해를 위한 중요한 도구가 되었습니다. 비디오는 시각적, 시간적, 상황별 데이터를 결합하여 정적 이미지와 텍스트를 뛰어넘는 다중 모드 표현을 제공합니다. 오늘날 비디오 공유 플랫폼의 확산과 교육 및 정보 제공 비디오의 확산으로 비디오를 지식 소스로 활용하는 것은 상세한 맥락, 공간 이해 및 프로세스 시연이 필요한 쿼리를 해결할 수 있는 전례 없는 기회를 제공합니다.

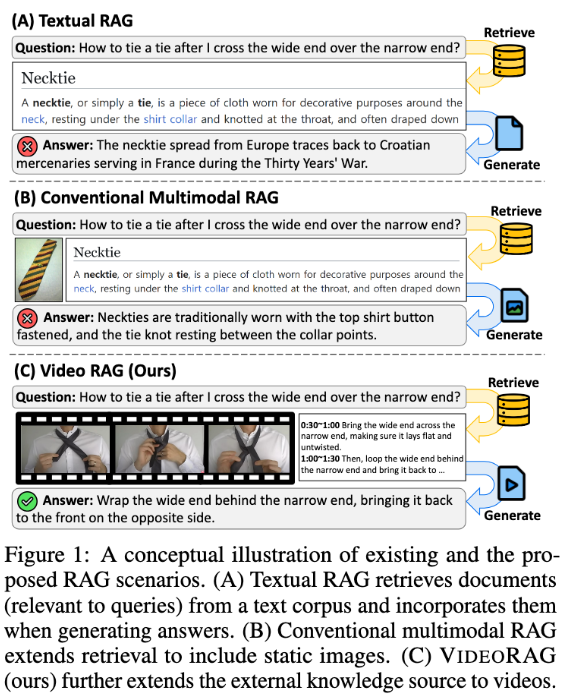

그러나 기존 RAG(검색 증강 생성) 시스템은 비디오 데이터의 전체 잠재력을 간과하는 경우가 많습니다. 이러한 시스템은 종종 텍스트 정보에 의존하고 때때로 정적 이미지를 사용하여 쿼리 응답을 지원하지만 복잡한 작업에 중요한 비디오에 포함된 시각적 역학 및 다중 모드 단서를 캡처하지 못합니다. 기존 접근 방식은 검색 없이 쿼리 관련 비디오를 사전 정의하거나 비디오를 텍스트 형식으로 변환하여 중요한 시각적 맥락과 시간적 역학을 잃어 정확하고 유익한 답변을 제공하는 능력을 제한했습니다.

이러한 문제를 해결하기 위해 한국과학기술원(KaIST) 연구팀과 DeepAuto.ai는 새로운 프레임워크인 VideoRAG를 제안했습니다. 프레임워크는 쿼리와 관련된 비디오를 동적으로 검색하고 시각적 및 텍스트 정보를 생성 프로세스에 통합할 수 있습니다. VideoRAG는 고급 LVLM(대규모 비디오 언어 모델)을 활용하여 다중 모드 데이터의 원활한 통합을 달성하여 검색된 비디오가 사용자 쿼리와 상황에 맞게 일치하고 비디오 콘텐츠의 시간적 풍부함을 유지하도록 보장합니다.

VideoRAG의 작업 흐름은 검색과 생성이라는 두 가지 주요 단계로 나뉩니다. 검색 단계에서 프레임워크는 쿼리를 통해 시각적, 텍스트적 특징과 유사한 비디오를 식별합니다.

생성 단계에서는 자동 음성인식 기술을 이용하여 자막이 없는 영상에 대한 보조 텍스트 데이터를 생성함으로써 모든 영상에 대한 응답 생성이 효과적으로 정보를 제공할 수 있도록 보장합니다. 검색된 관련 비디오는 비디오 프레임, 자막 및 쿼리 텍스트와 같은 다중 모드 데이터를 통합하고 LVLM의 도움으로 처리하여 길고 풍부하며 정확하고 상황에 맞는 응답을 생성하는 생성 모듈에 추가로 입력됩니다.

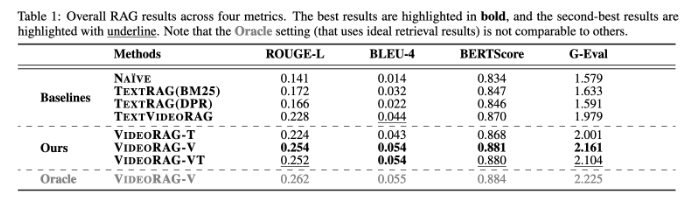

VideoRAG는 WikiHowQA 및 HowTo100M과 같은 데이터세트에 대해 광범위한 실험을 수행했으며, 그 결과 응답 품질이 기존 방법보다 훨씬 더 나은 것으로 나타났습니다. 이 새로운 프레임워크는 검색 향상 생성 시스템의 기능을 향상시킬 뿐만 아니라 미래의 다중 모드 검색 시스템에 대한 새로운 표준을 설정합니다.

논문: https://arxiv.org/abs/2501.05874

가장 밝은 부분:

**새로운 프레임워크**: VideoRAG는 관련 비디오를 동적으로 검색하고 시각적 정보와 텍스트 정보를 융합하여 생성 효과를 향상시킵니다.

**실험적 검증**: 여러 데이터 세트에서 테스트되었으며 기존 RAG 방법보다 훨씬 더 나은 응답 품질을 보여주었습니다.

**기술 혁신**: VideoRAG는 대규모 비디오 언어 모델을 사용하여 다중 모드 데이터 통합의 새로운 장을 열었습니다.

전체적으로 VideoRAG 프레임워크는 비디오 기반 검색 향상 작업을 위한 새로운 솔루션을 제공합니다. 다중 모드 데이터 통합 및 정보 검색의 획기적인 발전은 미래의 보다 스마트하고 정확한 정보 검색 시스템에 대한 중요한 정보를 제공합니다. 이번 연구 결과는 교육, 의료 등 다양한 분야에서 폭넓게 활용될 것으로 기대된다.