대규모 모델 추론의 효율성을 향상시키는 것은 인공지능 분야의 핵심 과제입니다. 높은 추론 부하, 높은 비용 및 긴 응답 시간은 대형 모델의 적용을 심각하게 제한합니다. 이러한 문제를 해결하기 위해 Kimi Company는 Tsinghua University의 MADSys Laboratory와 협력하여 KVCache 기반의 Mooncake 추론 시스템을 공동 개발했으며 2024년 6월에 공식 출시될 예정입니다. 이 시스템은 혁신적인 PD 분리 아키텍처와 스토리지 변환 중심 개념을 채택하여 추론 처리량을 크게 향상시킵니다. 기술의 응용과 대중화를 촉진하기 위해 Mooncake 프로젝트는 공식적으로 오픈 소스입니다.

Kimi Company는 Tsinghua University의 MADSys Laboratory와 협력하여 KVCache를 기반으로 한 Mooncake 추론 시스템 설계 계획을 시작했으며 2024년 6월에 공식 출시될 예정입니다.

Mooncake 추론 시스템은 혁신적인 PD 분리 아키텍처와 스토리지 변환 중심 개념을 통해 추론 처리량을 크게 향상시켜 업계의 폭넓은 관심을 끌고 있습니다. 이 기술 프레임워크의 적용과 대중화를 더욱 촉진하기 위해 Kimi와 Tsinghua University의 MADSys Laboratory는 9#AISoft, Alibaba Cloud, Huawei Storage 등과 같은 여러 회사와 협력하여 오픈 소스 프로젝트 Mooncake를 출시했습니다. . 11월 28일, Mooncake의 기술 프레임워크가 GitHub 플랫폼에 공식적으로 출시되었습니다.

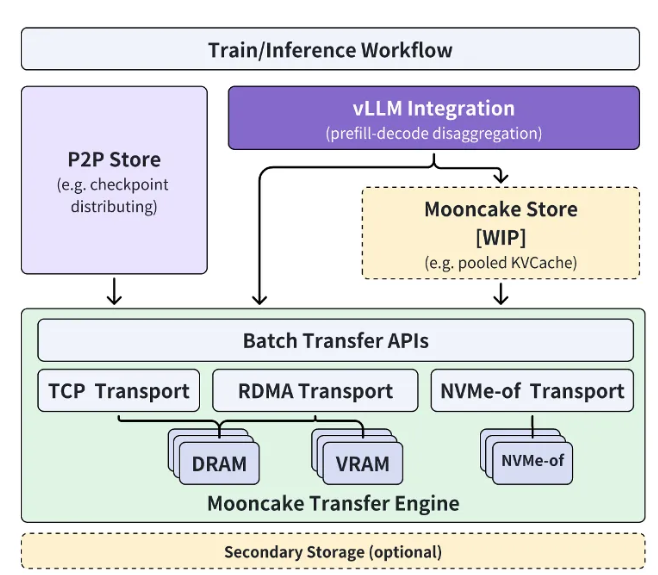

Mooncake 오픈 소스 프로젝트는 초대형 KVCache 캐시 풀을 중심으로 진행되며 고성능 KVCache 다중 레벨 캐시 Mooncake Store를 단계적으로 오픈 소스화하기 위해 노력하고 있습니다. 동시에 이 프로젝트는 다양한 추론 엔진과 기본 저장 및 전송 리소스와 호환됩니다.

현재 Transfer Engine 부분은 GitHub에서 전 세계적으로 오픈 소스로 공개되었습니다. Mooncake 프로젝트의 궁극적인 목표는 대형 모델 시대에 맞는 고성능 메모리 의미 저장을 위한 새로운 표준 인터페이스를 구축하고 관련 참조 구현 솔루션을 제공하는 것입니다.

Kimi Company의 엔지니어링 부사장인 Xu Xinran은 다음과 같이 말했습니다. “Tsinghua University의 MADSys 연구소와의 긴밀한 협력을 통해 우리는 분리된 대형 모델 추론 아키텍처인 Mooncake를 공동으로 만들어 추론 리소스의 궁극적인 최적화를 달성했습니다.

Mooncake는 사용자 경험을 향상시킬 뿐만 아니라 비용을 절감하여 긴 텍스트 및 높은 동시성 요구 사항을 처리하는 데 효과적인 솔루션을 제공합니다. 그는 더 많은 기업과 연구 기관이 Mooncake 프로젝트에 참여하여 보다 효율적인 모델 추론 시스템 아키텍처를 공동으로 탐구함으로써 AI 비서와 같은 대형 모델 기술을 기반으로 한 제품이 더 많은 사람들에게 혜택을 줄 수 있기를 바랍니다.

프로젝트 입구: https://github.com/kvcache-ai/Mooncake

가장 밝은 부분:

Kimi와 Tsinghua University는 AI 추론의 효율성을 높이기 위해 Mooncake 추론 시스템을 공동으로 출시했습니다.

Mooncake 프로젝트는 GitHub에서 오픈소스로 공개되었으며 고성능 메모리 시맨틱 스토리지 표준 인터페이스를 구축하는 것을 목표로 합니다.

AI 기술 발전을 공동으로 추진하기 위해 더 많은 기업과 연구기관의 참여를 기대합니다.

Mooncake 오픈 소스 프로젝트의 출시는 대규모 모델 추론 시스템 아키텍처의 새로운 단계를 의미합니다. 효율적인 성능과 개방형 협력 모델은 인공지능 기술의 발전과 적용을 효과적으로 촉진하고 더 스마트한 세상을 구축하는 데 기여할 것입니다.