Chatgpt 및 Wen Xin과 같은 AI와 다른 AI가 어떻게 말했는지 궁금하십니까? 그들은 큰 언어 모델 (LLM)을 기반으로합니다. 이 기사는 2 학년 초등학교에서 수학 수준 만 있더라도 LLM의 운영 원리를 이해할 수 있습니다. 우리는 신경망의 기본 개념에서 시작하여 디지털화, 모델 교육, 고급 기술, GPT 및 변압기 아키텍처와 같은 핵심 기술을 점차적으로 설명하여 LLM의 미스터리를 공개 할 것입니다.

신경망 : 숫자 마법

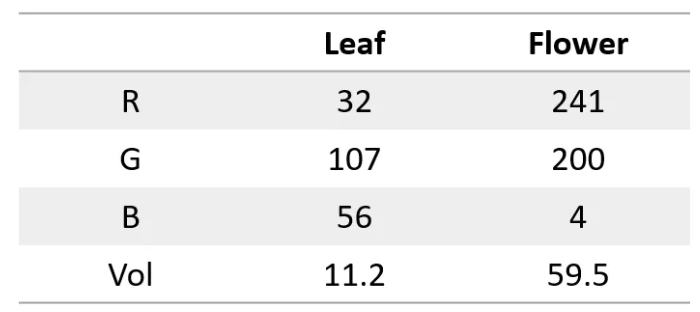

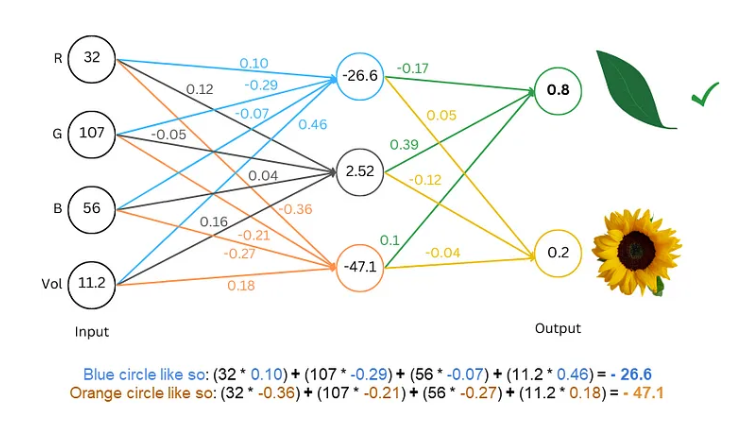

우선, 신경망은 슈퍼 계산기와 같으며 숫자 만 처리 할 수 있음을 알아야합니다. 입력 또는 출력 모두 숫자 여야합니다. 그렇다면 우리는 어떻게 텍스트를 이해하게합니까?

비밀은 텍스트를 숫자로 바꾸는 것입니다! 이런 식으로 신경망은 텍스트를 "이해"할 수 있습니다.

훈련 모델 : 온라인으로 "학습"언어를 보자

디지털 텍스트를 사용하면 신경망의 "학습"언어를 제공하기 위해 모델을 교육해야합니다.

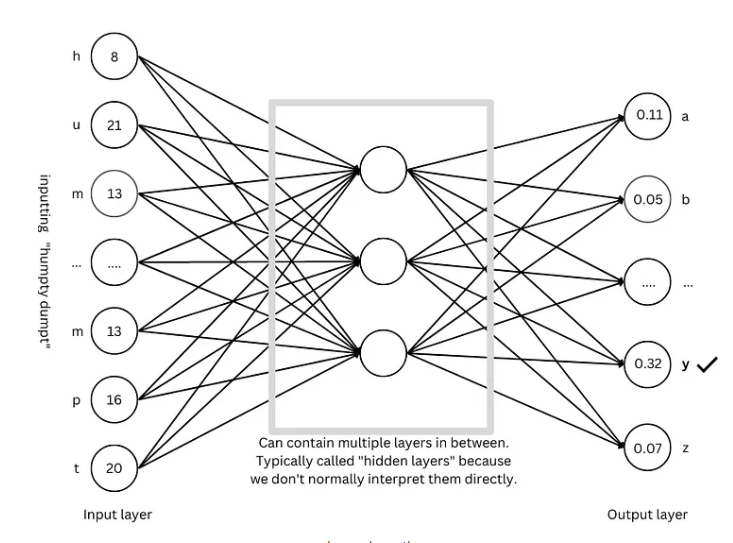

훈련 과정은 퍼즐 게임을하는 것과 같습니다. 우리는 인터넷의 "Humpty Dumpty"와 같은 몇 가지 텍스트를 읽은 다음 다음 편지가 무엇인지 추측하게합니다. 그것이 추측한다면, 우리는 그것을 잘못 추측한다면, 우리는 그것을 처벌 할 것입니다. 추측하고 조정함으로써 네트워크는 점점 더 정확하게 다음 문자를 예측할 수 있으며, "험프티 덤프티가 벽에 앉아있는"과 같은 완전한 문장을 생성 할 수 있습니다.

고급 팁 : 모델을보다 "스마트"하게 만듭니다.

모델을보다 "스마트"하게하기 위해 연구원들은 다음과 같은 많은 고급 기술을 발명했습니다.

단어 내장 : 우리는 더 이상 간단한 숫자를 사용하여 문자를 나타내지 않지만 각 단어를 나타내는 숫자 세트 (벡터)를 사용하여 단어의 의미를보다 포괄적으로 설명 할 수 있습니다.

하위 조상 단어 : 단어를 "고양이"와 같은 작은 단위 (하위 단어)로 "고양이"및 "S"로 분해하여 어휘를 줄이고 효율성을 향상시킬 수 있습니다.

자체 -입장 메커니즘 : 모델이 다음 단어를 예측할 때, 우리가 읽을 때의 문맥에 따라 단어의 의미를 이해하는 것처럼, 상황의 모든 단어에 따라 예측의 가중치가 조정됩니다.

잔류 연결 : 훈련의 어려움을 피하기 위해 연구원들은 잔류 연결을 발명하여 네트워크를보다 쉽게 배울 수 있도록했습니다.

다중주의 메커니즘 : 평행 한 다중주의 메커니즘을 통해 모델은 다른 각도의 컨텍스트를 이해하여 예측의 정확도를 향상시킬 수 있습니다.

위치 인코딩 : 모델이 단어의 순서를 이해하도록하기 위해, 연구원들은 읽을 때 단어의 순서에주의를 기울이는 것처럼 단어가 포함 된 단어에 위치 정보를 추가 할 것입니다.

GPT 아키텍처 : 대형 언어 모델의 "청사진"

GPT 아키텍처는 가장 인기있는 대형 언어 모델 아키텍처 중 하나입니다. GPT 아키텍처는 상기 언급 된 고급 기술을 영리하게 결합하여 모델이 언어를 효율적으로 학습하고 생성 할 수 있도록합니다.

변압기 아키텍처 : 언어 모델의 "혁명"

Transformer Architecture는 최근 몇 년 동안 언어 모델 분야에서 주요 획기적인 획기적인 것입니다. 예측의 정확성을 향상시킬뿐만 아니라 훈련의 어려움을 줄이고 대형 언어 모델 개발의 토대를 마련합니다. GPT 아키텍처는 또한 변압기 아키텍처에 따라 진화됩니다.

참조 자료 : https://towardsdatascience.com/understnding-llms-from-us-middle-sthool-math-e602766

이 기사의 설명을 통해, 나는 당신이 큰 언어 모델에 대한 예비 이해를 가지고 있다고 생각합니다. LLM의 내부 메커니즘은 매우 복잡하지만 핵심 원칙은이 기사 가이 놀라운 기술을 더 잘 이해하는 데 도움이되기를 바랍니다.