오디오 기반 이미지 애니메이션 기술은 최근 몇 년 동안 상당한 발전을 이루었지만 기존 모델의 복잡성과 효율성 문제로 인해 적용이 제한됩니다. 이러한 문제를 해결하기 위해 연구진은 혁신적인 2단계 설계를 통해 오디오 기반 이미지 애니메이션의 품질, 효율성 및 적용 범위를 크게 향상시키는 JoyVASA라는 신기술을 개발했습니다. JoyVASA는 긴 애니메이션 비디오를 생성할 수 있을 뿐만 아니라 사람의 초상화와 동물 얼굴에도 애니메이션을 적용하고 여러 언어를 지원합니다.

최근 연구자들은 오디오 기반 이미지 애니메이션 효과를 향상시키는 것을 목표로 하는 JoyVASA라는 새로운 기술을 제안했습니다. 딥 러닝 및 확산 모델의 지속적인 개발로 오디오 기반 인물 애니메이션은 비디오 품질과 입술 동기화 정확도가 크게 향상되었습니다. 그러나 기존 모델의 복잡성으로 인해 훈련 및 추론의 효율성이 높아지는 동시에 비디오의 지속 시간과 프레임 간 연속성이 제한됩니다.

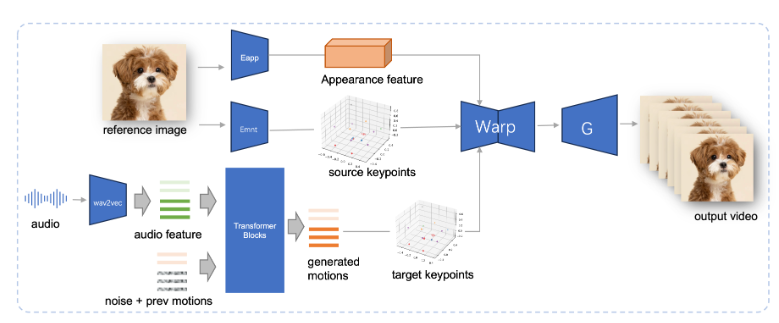

JoyVASA는 2단계 디자인을 채택합니다. 첫 번째 단계에서는 동적 얼굴 표정과 정적 3차원 얼굴 표현을 분리하는 분리된 얼굴 표현 프레임워크를 도입합니다.

이러한 분리를 통해 시스템은 정적 3D 얼굴 모델을 동적 동작 시퀀스와 결합하여 더 긴 애니메이션 비디오를 생성할 수 있습니다. 두 번째 단계에서 연구팀은 캐릭터 정체성과 무관한 프로세스인 오디오 신호에서 직접 액션 시퀀스를 생성할 수 있는 확산 변환기를 훈련했습니다. 마지막으로 1단계 학습을 기반으로 한 생성기는 3D 얼굴 표현과 생성된 동작 시퀀스를 입력으로 사용하여 고품질 애니메이션 효과를 렌더링합니다.

특히 JoyVASA는 인간 초상화 애니메이션에만 국한되지 않고 동물 얼굴도 원활하게 애니메이션화할 수 있습니다. 이 모델은 비공개 중국어 데이터와 공개 영어 데이터를 결합한 혼합 데이터 세트로 학습되었으며 우수한 다국어 지원 기능을 보여줍니다. 실험 결과는 이 방법의 효율성을 입증합니다. 향후 연구에서는 실시간 성능을 향상하고 표현 제어를 개선하여 이미지 애니메이션에서 이 프레임워크의 적용을 더욱 확장하는 데 중점을 둘 것입니다.

JoyVASA의 등장은 오디오 기반 애니메이션 기술의 중요한 혁신을 의미하며 애니메이션 분야의 새로운 가능성을 촉진합니다.

프로젝트 입구: https://jdh-algo.github.io/JoyVASA/

가장 밝은 부분:

JoyVASA 기술은 3D 모델에서 얼굴 표정을 분리하여 더 긴 애니메이션 비디오 생성을 가능하게 합니다.

이 기술은 오디오 신호를 기반으로 액션 시퀀스를 생성할 수 있으며 캐릭터 애니메이션과 동물 애니메이션의 이중 기능을 갖추고 있습니다.

JoyVASA는 중국어 및 영어 데이터 세트에 대한 교육을 받았으며 다국어 지원을 제공하며 전 세계 사용자에게 서비스를 제공합니다.

JoyVASA 기술의 혁신은 오디오 기반 이미지 애니메이션 기술의 향후 개발을 위한 새로운 방향을 제시하는 분리된 디자인과 효율적인 오디오 큐 사용에 있습니다. 또한 다중 언어 지원 및 효율적인 애니메이션 생성 기능을 통해 널리 사용됩니다. 전망. 향후 JoyVASA는 실시간 성능을 더욱 향상시켜 보다 정교한 표현 제어가 가능해질 것으로 기대된다.