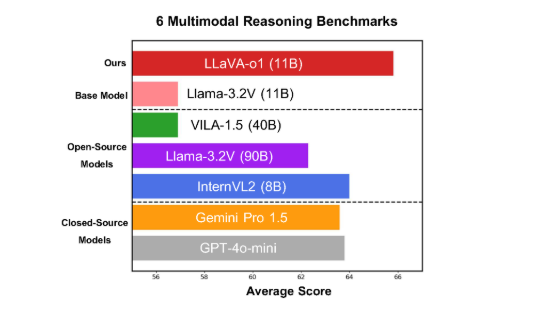

Peking University와 같은 연구 팀은 최근 멀티 모드 오픈 소스 모델 LLAVA-O1을 발표했습니다. 체계적인 추론. 성능은 GPT-O1과 비슷합니다. Llava-O1은 추론 프로세스를 요약, 시각적 해석, 논리적 추론 및 결론 생성의 네 단계로 분해하기위한 "느린 사고"추론 메커니즘을 채택하여 전통적인 모델 추론 프로세스를 단순화하여 발생하는 오류를 효과적으로 피합니다. 이 모델은 6 개의 도전적인 벤치 마크 테스트에서 잘 수행되었으며, 많은 경쟁자를 능가했으며, 더 큰 또는 폐쇄 된 소스의 비교에서 잘 수행되었습니다.

최근 Peking University와 같은 과학 연구 팀은 Llava-O1이라는 멀티 모드 오픈 소스 모델의 출시를 발표했습니다. O1.

이 모델은 6 개의 도전적인 멀티 모드 벤치 마크 테스트에서 잘 수행되었습니다.

LLAVA-O1은 LLAMA-3.2-VISION 모델을 기반으로합니다.

멀티 모드 추론 벤치 마크 테스트에서 Llava-O1의 성능은 기본 모델 8.9%를 초과했습니다. 이 모델의 독창성은 추론 과정이 요약, 시각적 해석, 논리적 추론 및 결론 생성의 네 단계로 나뉘어져 있다는 것입니다. 기존 모델에서 추론 프로세스는 종종 비교적 간단하며 Llava-O1은 구조화 된 다중 단계 추론을 통해보다 정확한 출력을 유발할 수 있습니다.

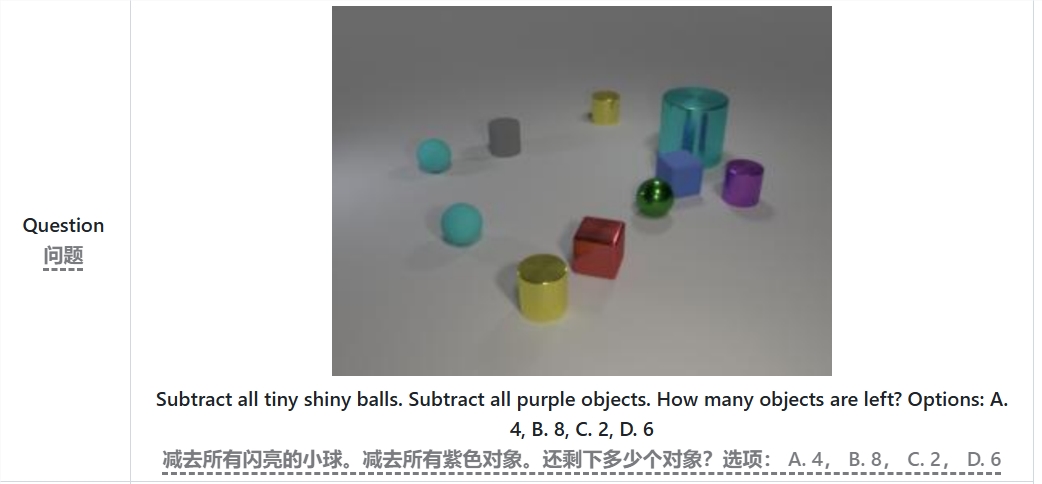

예를 들어, "모든 작은 밝은 공과 자주색 물체를 모두 빼고 남은 물체 수"의 문제를 해결할 때 Llava-O1은 먼저 문제를 요약 한 다음 이미지에서 정보를 추출한 다음 점차적으로 추출합니다. 그것을주기 위해. 대답. 이것은 -위상 방법으로 모델의 시스템 추론 기능을 향상시키고 복잡한 문제를 처리 할 때 더 효율적입니다.

Llava-O1이 추론 과정에서 단계 수준의 빔 검색 방법을 도입했음을 언급 할 가치가 있습니다. 이 방법을 사용하면 모델이 각 추론 단계에서 여러 후보 답변을 생성하고 다음 추론 단계를 계속하려면 최상의 답변을 선택하여 전체 추론 품질을 크게 향상시킵니다. 미세 조정 및 합리적인 교육 데이터를 감독함으로써 Llava-O1은 더 큰 또는 폐쇄 소스와 비교하여 잘 수행되었습니다.

Peking University 팀의 연구 결과는 멀티 모달 AI의 개발을 촉진했을뿐만 아니라 미래의 시각적 언어 이해 모델을위한 새로운 아이디어와 방법을 제공했습니다. 이 팀은 LLAVA-O1의 코드, 사전 훈련 교육 중량 및 데이터 세트가 완전히 오픈 소스가 될 것이라고 밝혔으며, 더 많은 연구원과 개발자 가이 혁신적인 모델을 탐색하고 적용 할 것으로 예상됩니다.

논문 : https://arxiv.org/abs/2411.10440

github : https : //github.com/pku- yuanroup/llava-o1

전철기:

Llava-O1은 Peking University와 같은 팀이 발표 한 새로운 멀티 모달 추론 모델로, "천천히 생각"할 수있는 능력이 있습니다.

성능은 다중 모드 추론 벤치 마크 테스트에서 기본 모델의 8.9%를 초과합니다.

Llava-O1은 정확성을 보장하고 가까운 시일 내에 오픈 소스가 될 수 있도록 구조화 된 다중 단계 추론을 통한 LLAVA-O1.

Llava-O1의 오픈 소스는 다중 모달 AI 필드의 연구 및 개발을 촉진하고보다 지능적이고 강력한 시각적 언어 모델의 건설을위한 견고한 기초를 제공 할 것입니다. 향후 응용 프로그램에서 더 많은 잠재력을 보여주기를 기대합니다. 논문과 Github 링크는 연구원들이 모델을 깊이 이해하고 사용하기에 편리합니다.