대형 모델의 훈련 비용을 줄이는 비용은 인공 지능 분야의 현재 연구 핫스팟입니다. Tencent Mixed Yuan Team이 발표 한 최근 연구에 따르면 저 효율성 교육 모델에 대한 새로운 아이디어를 제공하는 저급 플로팅 -지점 정량적 훈련 규모의 법칙에 대해 깊이 논의했습니다. 이 연구는 많은 수의 실험을 통해 모델 크기, 훈련 데이터, 정량적 정확도 및 기타 요인의 효과를 분석하고, 다른 정확도 하에서 최상의 효과를 얻기 위해 훈련 자원을 효과적으로 할당하는 방법에 대한 법칙을 얻었습니다. 이 연구는 중요한 이론적 중요성을 가질뿐만 아니라 대형 모델의 실제 적용에 대한 귀중한 지침을 제공합니다.

오늘날, LLM (Lange Language Model)의 빠른 발전, 모델의 훈련 비용과 추론은 점점 더 연구 및 응용의 초점이되고 있습니다. 최근 Tencent Mixed Yuan 팀은 낮은 수준의 부유 -지점 정량적 훈련의 "스케일링 법", 즉 부동 -지점 정량적 훈련의 규모 훈련의 규모 법칙에 대해 깊이 논의한 중요한 연구를 발표했습니다. 이 연구의 핵심은 모델의 정확성을 줄이고 성능을 잃지 않음으로써 계산 및 저장 비용을 줄이는 것입니다.

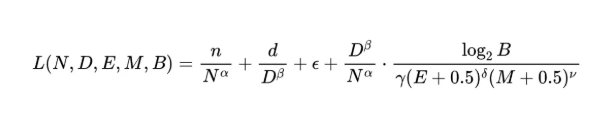

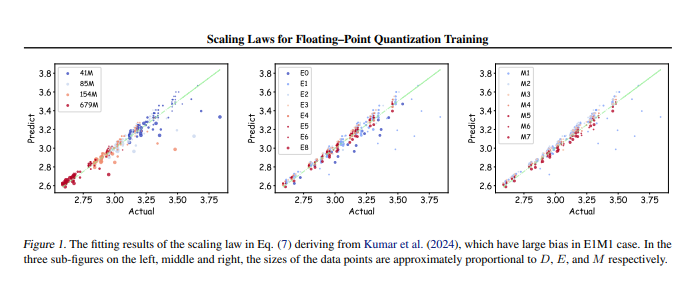

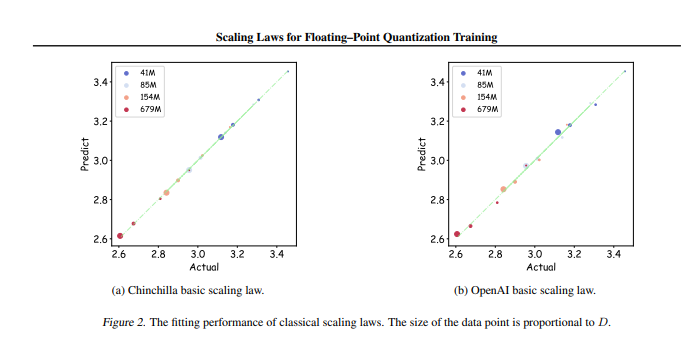

연구팀은 다양한 매개 변수와 정확도에 대한 366 세트의 플로팅 -포인트 정량적 훈련을 실시했습니다. 모델 (n)의 크기, 훈련 데이터의 양을 포함하여 다양한 요인을 체계적으로 분석했습니다. ), 인덱스 비트 (e) ,,,,,, 인덱스 비트 (e) ,,, 크기 (b). 이러한 실험을 통해 연구원들은 통합 스케일링 법을 얻었으며, 최상의 교육 결과를 얻기 위해 다른 정확도로 교육 데이터 및 모델 매개 변수를 효과적으로 구성하는 방법을 밝혀 냈습니다.

가장 중요한 것은 연구에 따르면 저렴한 플로팅 -포인트 정량적 훈련에서 "제한 효과", 즉 특정 양의 데이터에 따라 모델의 성능이 최적의 감소에 도달한다는 것입니다 . 또한,이 연구는 또한 이론적으로 최상의 비용 효율적인 부유 -지점 정량적 훈련 정확도가 4 ~ 8 개의 물린이어야하며, 이는 효율적인 LLM에 중요한 유도를 가져야한다는 것을 발견했다.

이 연구는 플로팅 -포인트 정량적 훈련 분야의 격차를 메울뿐만 아니라 미래의 하드웨어 제조업체에 대한 참조를 제공하여 플로팅 포인트 컴퓨팅 기능을 다른 정확도로 최적화 할 수 있도록 도와줍니다. 결국,이 연구는 제한된 자원의 경우 여전히 효율적인 교육 효과를 달성 할 수 있도록 대규모 모델 교육 실무를위한 명확한 방향을 제공합니다.

논문 주소 : https : //arxiv.org/pdf/2501.02423

요컨대, Tencent 하이브리드 팀 의이 연구는 대규모 교육 모델의 비용을 줄이기위한 효과적인 솔루션을 제공했습니다. 이 연구는 높은 효율성과 낮은 코스트 모델 교육의 방향을 지적했으며, 주목할 가치가 있고 깊은 연구에서 가치가 있습니다.