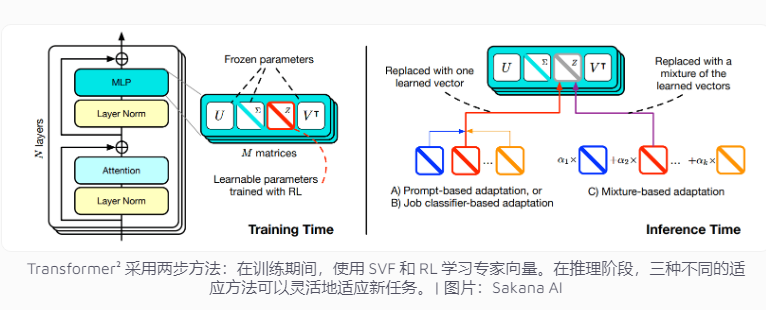

일본 회사 Sakana AI는 최근 언어 모델 작업의 적응성을 향상시키기 위해 설계된 혁신적인 기술인 Transformer²를 출시했습니다. 한 번에 여러 작업을 처리해야 하는 기존 AI 시스템과 달리 Transformer²는 전문가 벡터와 SVF(Singular Value Fine-Tuning) 기술을 사용하는 2단계 학습을 사용하므로 전체 네트워크를 재교육하지 않고도 새로운 작업에 효율적으로 적응할 수 있습니다. 이는 리소스 소비를 크게 줄이고 모델 유연성과 정확성을 향상시킵니다. 이 기술은 네트워크 연결의 중요성을 제어하는 전문가 벡터를 학습하여 수학적 연산, 프로그래밍, 논리적 추론과 같은 특정 작업에 중점을 두고 강화 학습을 결합하여 모델 성능을 더욱 최적화합니다.

현재 인공 지능 시스템은 일반적으로 한 번의 훈련으로 여러 작업을 처리해야 하지만 새로운 작업에 직면할 때 예상치 못한 문제에 직면하기 쉬우므로 모델의 적응성이 제한됩니다. Transformer²의 설계 컨셉은 전문가 벡터 및 SVF(Singular Value Fine-Tuning) 기술을 사용하여 모델이 전체 네트워크를 재교육하지 않고도 새로운 작업에 유연하게 대처할 수 있도록 하는 것입니다.

기존 훈련 방법에서는 전체 신경망의 가중치를 조정해야 하는데, 이는 비용이 많이 들 뿐만 아니라 모델이 이전에 학습한 지식을 "잊게" 만들 수도 있습니다. 이와 대조적으로 SVF 기술은 각 네트워크 연결의 중요성을 제어하는 전문가 벡터를 학습하여 이러한 문제를 방지합니다. 전문가 벡터는 네트워크 연결의 가중치 매트릭스를 조정하여 모델이 수학적 연산, 프로그래밍, 논리적 추론과 같은 특정 작업에 집중할 수 있도록 도와줍니다.

이 접근 방식은 모델을 새로운 작업에 적용하는 데 필요한 매개변수 수를 크게 줄입니다. 예를 들어 LoRA 방법에는 682만 개의 매개변수가 필요한 반면 SVF에는 16만 개의 매개변수만 필요합니다. 이는 메모리 소비와 처리 능력을 줄일 뿐만 아니라 모델이 특정 작업에 집중하는 동안 다른 지식을 잊어버리는 것을 방지합니다. 가장 중요한 것은 이러한 전문가 벡터가 효과적으로 함께 작동하여 다양한 작업에 대한 모델의 적응성을 향상시킬 수 있다는 것입니다.

적응성을 더욱 향상시키기 위해 Transformer²는 강화 학습을 도입했습니다. 훈련 과정에서 모델은 작업 솔루션을 제안하고 피드백을 받아 전문가 벡터를 지속적으로 최적화하여 새로운 작업에 대한 성능을 향상시킵니다. 팀은 이러한 전문 지식을 활용하기 위해 적응형 단서, 작업 분류자 및 소수의 적응이라는 세 가지 전략을 개발했습니다. 특히 퓨샷 적응 전략은 새로운 작업의 예를 분석하고 전문가 벡터를 조정하여 모델의 유연성과 정확성을 더욱 향상시킵니다.

Transformer²는 여러 벤치마크에서 기존 방법인 LoRA보다 성능이 뛰어납니다. 수학적 작업에서는 성능이 16% 향상되었으며 필요한 매개변수가 크게 감소했습니다. 새로운 작업에 직면했을 때 Transformer²의 정확도는 원래 모델보다 4% 더 높았지만 LoRA는 예상한 결과를 달성하지 못했습니다.

Transformer²는 복잡한 수학적 문제를 해결할 뿐만 아니라 프로그래밍과 논리적 추론 기능을 결합하여 도메인 간 지식 공유를 달성합니다. 예를 들어, 팀은 전문가 벡터를 전송하여 더 큰 모델의 지식을 활용하여 더 작은 모델이 성능을 향상시킬 수 있다는 사실을 발견했습니다. 이는 모델 간의 지식 공유에 대한 새로운 가능성을 제공합니다.

Transformer²는 작업 적응성 측면에서 상당한 진전을 이루었지만 여전히 몇 가지 제한 사항에 직면해 있습니다. 현재 SVF를 사용하여 훈련된 전문가 벡터는 사전 훈련된 모델의 기존 기능에만 의존할 수 있으며 완전히 새로운 기술을 추가할 수는 없습니다. 진정한 지속적인 학습은 모델이 새로운 기술을 독립적으로 학습할 수 있음을 의미합니다. 이 목표를 달성하는 데는 여전히 시간이 걸립니다. 700억 개 이상의 매개변수가 있는 대규모 모델에서 이 기술을 어떻게 확장할 것인지는 아직 해결되지 않은 문제로 남아 있습니다.

전체적으로 Transformer²는 지속적인 학습 분야에서 큰 잠재력을 보여주며, 효율적인 자원 활용과 상당한 성능 향상은 미래 언어 모델 개발에 새로운 방향을 제시합니다. 그러나 기존의 한계를 극복하고 진정한 지속적인 학습 목표를 달성하려면 기술을 지속적으로 개선해야 합니다.