긴 비디오를 이해하는 것은 비디오 분석 분야에서 항상 주요 과제였습니다. 기존 모델은 긴 비디오를 처리할 때 비효율적이며 핵심 정보를 효과적으로 추출하기가 어렵습니다. 본 논문에서는 HiCo라는 계층적 비디오 마크업 압축 기술과 이 기술을 기반으로 한 "VideoChat-Flash" 시스템을 소개합니다. 컴퓨팅 요구 사항. 연구팀은 모델 훈련 및 평가를 위해 30만 시간의 비디오와 2억 단어의 주석이 포함된 대규모 데이터세트를 구축했습니다.

특히 HiCo는 긴 비디오를 짧은 세그먼트로 분할하고 중복 정보를 압축함으로써 계산 복잡성을 줄이는 동시에 사용자 쿼리와의 의미론적 연관성을 활용하여 처리되는 태그 수를 더욱 줄입니다. "VideoChat-Flash"는 먼저 감독된 미세 조정을 위해 짧은 비디오를 사용한 다음 점차적으로 긴 비디오 교육을 도입하고 마지막으로 혼합 길이 코퍼스에 대한 포괄적인 이해를 달성하는 다단계 학습 방식을 채택합니다. 또한 개선된 "건초 더미 속의 바늘" 작업은 상황 및 멀티 홉 비디오 구성에 대한 모델의 이해를 향상시킵니다.

긴 비디오 처리의 구체적인 구현에서 "VideoChat-Flash"는 짧은 비디오에서 긴 비디오까지 다단계 학습 방식을 채택합니다. 연구자들은 먼저 감독된 미세 조정을 위해 짧은 비디오와 해당 주석을 사용한 다음 점차적으로 훈련을 위해 긴 비디오를 도입하여 마침내 혼합 길이 코퍼스에 대한 포괄적인 이해를 달성했습니다. 이 방법은 모델의 시각적 인식 기능을 향상시킬 뿐만 아니라 긴 비디오 처리를 위한 풍부한 데이터 지원을 제공합니다. 연구팀은 30만 시간의 비디오와 2억 단어의 주석을 포함하는 거대한 데이터 세트를 구축했습니다.

또한 멀티 홉 비디오 구성에 대한 연구에서는 향상된 "건초 더미 속의 바늘" 작업이 제안되었습니다. 새로운 벤치마크를 통해 모델은 비디오에서 단일 대상 이미지를 찾아야 할 뿐만 아니라 상호 관련된 여러 이미지 시퀀스를 이해해야 하므로 모델의 맥락 이해 능력이 향상됩니다.

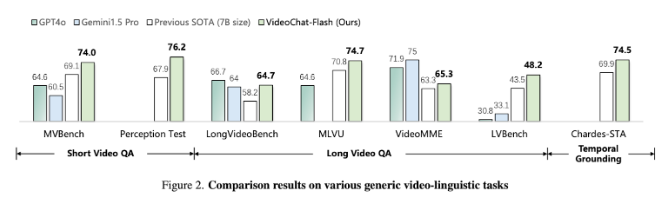

실험 결과, 제안된 방법은 계산량을 2배 정도 감소시켰으며, 특히 짧은 비디오와 긴 비디오의 벤치마크 테스트에서 좋은 성능을 보여 짧은 비디오 이해라는 새로운 분야의 리더가 되었습니다. 동시에 이 모델은 장시간 영상 이해에서도 기존 오픈소스 모델을 능가하며 강력한 시간 위치 파악 기능을 보여줍니다.

논문: https://arxiv.org/abs/2501.00574

가장 밝은 부분:

연구원들은 긴 비디오 처리에 필요한 계산 요구 사항을 크게 줄이는 계층적 비디오 태그 압축 기술인 HiCo를 제안했습니다.

'VideoChat-Flash' 시스템은 다단계 학습 방식을 채택하고 짧은 영상과 긴 영상을 결합해 훈련해 모델의 이해력을 높인다.

실험 결과에 따르면 이 방법은 여러 벤치마크 테스트에서 새로운 성능 표준에 도달하고 긴 비디오 처리 분야에서 고급 모델이 되는 것으로 나타났습니다.

전체적으로, 이 연구는 효율적인 장편 영상 이해를 위한 새로운 솔루션을 제공합니다. HiCo 기술과 VideoChat-Flash 시스템은 계산 효율성과 모델 성능에 있어서 획기적인 발전을 이루었으며, 미래의 장편 영상 분석 애플리케이션을 위한 기반을 마련했습니다. 연구결과는 중요한 이론적 의의와 실무적 응용가치를 갖고 있다.