Mistral이 출시한 최신 오픈소스 코딩 모델인 Codestral 25.01은 성능이 크게 향상되었으며 이전 세대보다 2배 더 빠릅니다. Codestral의 업그레이드 버전인 Codestral 25.01은 낮은 대기 시간과 높은 빈도의 작동 특성을 계승하고 기업 수준 애플리케이션에 최적화되어 코드 수정, 테스트 생성, 중간 채우기 등의 작업을 지원합니다. Python 코딩 테스트에서 뛰어난 성능, 특히 HumanEval 테스트에서 86.6%의 높은 점수를 획득하여 현재 헤비급 코딩 모델 중 선두주자로 자리매김하여 많은 유사한 제품을 능가합니다.

원래 Codestral과 유사하게 Codestral 25.01은 여전히 짧은 대기 시간과 높은 빈도의 작업에 중점을 두고 코드 수정, 테스트 생성 및 중간 채우기 작업을 지원합니다. Mistral은 이 버전이 더 많은 데이터와 모델 상주가 필요한 기업에 특히 적합하다고 말했습니다. 벤치마크 테스트에 따르면 Codestral25.01은 이전 버전인 Codellama70B Instruct 및 DeepSeek Coder33B Instruct를 훨씬 능가하는 HumanEval 테스트 점수 86.6%로 Python 코딩 테스트에서 기대 이상의 성능을 발휘하는 것으로 나타났습니다.

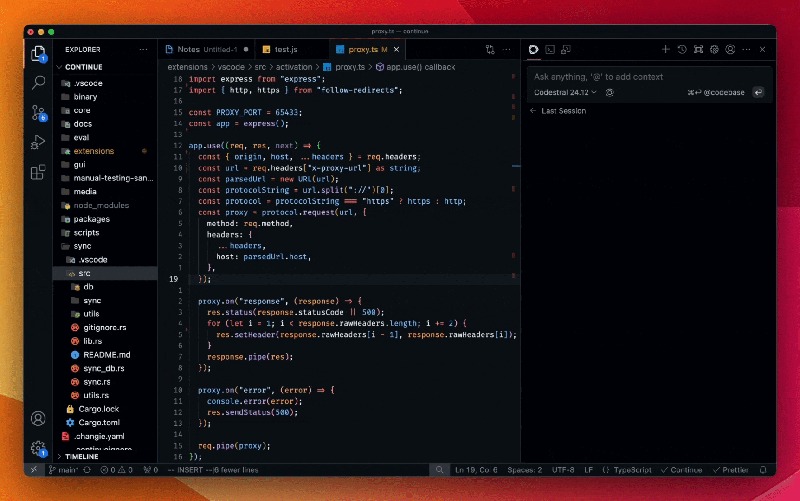

개발자는 Mistral IDE 플러그인과 로컬 배포 도구인 Continue를 통해 모델에 액세스할 수 있습니다. 또한 Mistral은 Google Vertex AI 및 Mistral la Plateforme를 통해 API에 대한 액세스도 제공합니다. 이 모델은 현재 Azure AI Foundry에서 미리 보기로 제공되고 있으며 Amazon Bedrock 플랫폼에서도 곧 제공될 예정입니다.

작년 출시 이후 Codestral by Mistral은 코드 중심 오픈 소스 모델의 리더가 되었습니다. Codestral의 첫 번째 버전은 최대 80개 언어를 지원하고 많은 유사한 제품보다 코딩 성능이 뛰어난 22B 매개변수 모델입니다. 그 직후 Mistral은 더 긴 코드 문자열을 처리하고 더 많은 입력 요구 사항에 대처할 수 있는 Mamba 아키텍처 기반의 코드 생성 모델인 Codestral-Mamba를 출시했습니다.

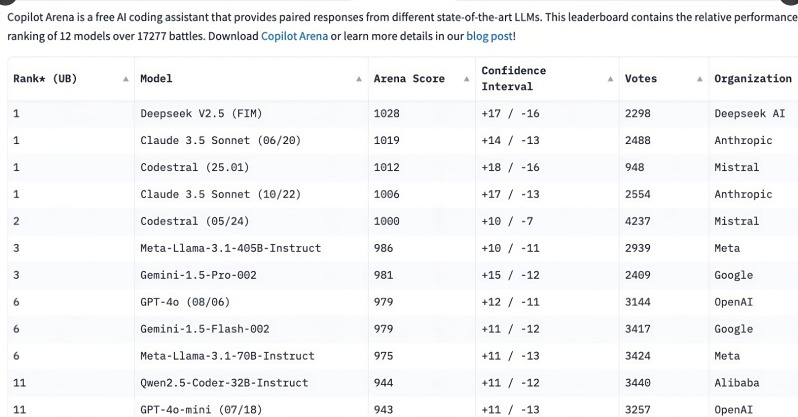

Codestral 25.01의 출시는 개발자들의 폭넓은 관심을 끌었으며, 출시 후 불과 몇 시간 만에 C o 파일럿 아레나 순위 1위를 차지했습니다. 이러한 추세는 특히 코딩 작업 분야에서 전문 코딩 모델이 개발자의 첫 번째 선택이 되고 있음을 보여줍니다. 다기능 일반 모델과 비교할 때 집중 코딩 모델의 필요성이 점점 더 분명해지고 있습니다.

OpenAI의 o3 및 Anthropic의 Claude와 같은 범용 모델도 인코딩할 수 있지만 특별히 최적화된 인코딩 모델이 더 나은 성능을 발휘하는 경향이 있습니다. 지난 해 여러 회사에서 Alibaba의 Qwen2.5-Coder, 중국의 DeepSeek Coder 등 코딩 전용 모델을 출시했으며, 후자는 GPT-4Turbo를 능가하는 최초의 모델이 되었습니다. 또 마이크로소프트는 코딩뿐만 아니라 수학적 문제도 풀 수 있는 MOE(혼합 전문가 모델) 기반의 GRIN-MoE도 출시했다.

개발자들은 여전히 범용 모델을 선택할지, 특수 모델을 선택할지 논쟁을 벌이고 있지만, 코딩 모델의 급속한 증가로 인해 효율적이고 정확한 코딩 도구에 대한 필요성이 커지고 있습니다. Codestral25.01은 코딩 작업을 위해 특별히 교육을 받았다는 장점을 통해 의심할 여지 없이 코딩의 미래에서 자리를 차지할 것입니다.

Codestral25.01의 출시는 전문 코딩 모델 분야에서 또 다른 발전을 의미합니다. 탁월한 성능과 편리한 액세스는 개발자에게 보다 효율적인 코딩 경험을 제공하고 소프트웨어 개발 분야에서 인공 지능의 발전을 촉진할 것입니다. 앞으로는 더 많은 유사한 전문 모델이 등장하여 개발자에게 더 많은 선택권을 제공할 수 있기를 기대합니다.