Sakana AI는 비싼 미세 조정없이 추론 과정에서 새로운 작업에 동적으로 학습하고 적응하는 고유 한 2 단계 동적 무게 조정 메커니즘을 사용하는 혁신적인 적응 형 언어 모델 Transformer²를 출시합니다. 이는 LLM (Lange Language Model) 기술의 주요 획기적인 획기적인 것으로 나타 났으며 LLM이보다 효율적이고 개인화되며 실용적으로 적용되는 방식을 바꿀 것으로 예상됩니다. 전통적인 미세 조정 방법과 비교하여 변압기 ²는 단수 값 분해 (SVD)와 SVF (Singular Value Fine Tuning) 기술을 통해 모델 가중치의 주요 구성 요소를 선택적으로 조정하여 실시간으로 성능을 최적화하여 시간 소모 재 훈련을 피합니다. 테스트 결과는 변압기 ²가 매개 변수가 적은 여러 작업에서 LORA 모델보다 우수하며 강력한 지식 전송 기능을 보여줍니다.

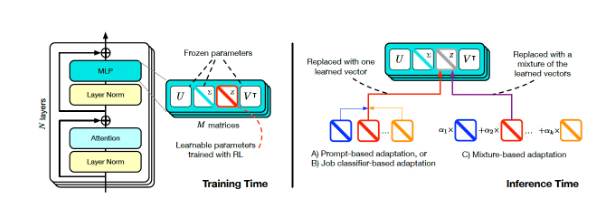

Transformer²의 핵심 혁신은 고유 한 2 단계 동적 무게 조정 메커니즘에 있습니다. 먼저, 들어오는 사용자 요청을 분석하고 작업 요구 사항을 이해하고 SVD (Singular Value Decomposition)를 통해 모델 가중치를 작업 요구 사항과 정렬합니다. Model Weights의 주요 구성 요소를 선택적으로 조정함으로써 Transformer²는 시간 소모적 재교육없이 실시간 성능을 최적화 할 수 있습니다. 이는 전통적인 미세 조정 방법과는 대조적으로, 훈련 후 매개 변수를 정적으로 유지하거나 저 순위 적응 (LORA)과 같은 방법을 사용하여 소수의 매개 변수 만 수정해야합니다.

트랜스포머 스퀘어 훈련 및 추론 (출처 : ARXIV)

동적 조정을 달성하기 위해 연구원들은 SVF (Singular Value Fine Tuning) 방법을 채택했습니다. 교육 중에 SVF는 모델의 SVD 구성 요소에서 Z- 벡터라는 기술 표현 세트를 배웁니다. 추론 할 때 Transformer²는 프롬프트를 분석 한 다음 해당 Z- 벡터를 구성하여 각 프롬프트에 맞게 응답하는 응답을 달성하여 필요한 기술을 결정합니다.

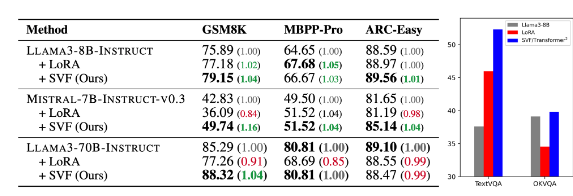

테스트 결과는 수학, 코딩, 추론 및 시각적 질문 및 답변과 같은 다양한 작업에서 Transformer²가 LORA 모델보다 우수하며 매개 변수가 적습니다. 더욱 주목할만한 것은 모델에 지식 전송 기능이 있음, 즉 한 모델에서 배운 Z-Vector가 다른 모델에 적용될 수 있으므로 광범위한 응용 프로그램에 대한 가능성을 보여줍니다.

기본 모델 및 LORA와 변압기 제곱 (테이블의 SVF) 비교 (출처 : ARXIV)

Sakana AI는 Github 페이지의 Transformer² 구성 요소에 대한 교육 코드를 발표하여 다른 연구원과 개발자를위한 문을 열었습니다.

기업이 LLM의 적용을 계속 탐색함에 따라 추론 사용자 정의 기술이 점차 주류 트렌드가되고 있습니다. Transformer²는 Google의 Titans와 같은 다른 기술과 함께 LLM이 사용되는 방식을 변경하여 사용자가 재교육없이 특정 요구에 따라 모델을 동적으로 조정할 수 있습니다. 이 기술 발전은 더 넓은 범위에서 LLM을보다 유용하고 실용적으로 만들 것입니다.

Sakana AI의 연구원들은 Transformer²는 정적 인공 지능과 생명 지능 사이의 다리를 나타내며 효율적이고 개인화되고 완전히 통합 된 AI 도구를위한 토대를 마련했습니다.

Transformer²의 오픈 소스 릴리스는 LLM 기술의 개발 및 적용을 크게 촉진하고보다 효율적이고 개인화 된 인공 지능 시스템을 구축하기위한 새로운 방향을 제공 할 것입니다. 동적으로 학습하고 새로운 작업에 적응하는 능력은 다양한 분야에서 큰 응용 프로그램 잠재력을 가지고 있으며 향후 개발을 기대할 가치가 있습니다.