Allen Institute of Artificial Intelligence (AI2)는 최근 70 억 파라미터를 가진 스파 스 하이브리드 전문가 (MOE) 모델 인 새로운 대규모 언어 모델 Olmoe를 발표했지만 각 입력 마크는 10 억 개의 매개 변수 만 사용하여 횟수를 크게 줄입니다. 비용 및 메모리 요구 사항. Olmoe에는 두 가지 버전이 있습니다. Universal 버전 Olmoe-1B-7B와 명령 미세 조정 버전 Olmoe-1B-7B 비는 벤치 마크에서 다른 대형 모델보다 더 큰 모델을 능가합니다. AI2는 MOE 모델 분야에서 특히 소중한 Olmoe의 완전한 오픈 소스를 강조하고 학술 연구를위한 귀중한 자원을 제공합니다.

Olmoe는 70 억 개의 매개 변수를 가진 Sparse Hybrid Expert (MOE) 아키텍처를 채택하지만 입력 태그 당 10 억 매개 변수 만 사용됩니다. 더 일반적인 Olmoe-1B-7B와 명령 조정 된 Olmoe-1B-7B- 보수의 두 가지 버전으로 제공됩니다.

AI2는 폐쇄 소스 인 대부분의 다른 하이브리드 전문가 모델과 달리 Olmoe가 완전히 오픈 소스라고 강조합니다. 그들은 논문에서 "대부분의 MOE 모델은 폐쇄 소스입니다. 일부는 모델 가중치를 공개하지만 교육 데이터, 코드 또는 레시피에 대한 정보는 매우 제한적입니다."

AI2 리서치 과학자 인 Nathan Lambert는 소셜 미디어에서 Olmoe가 정책 결정에 도움이 될 것이라고 말했습니다. 또한 Olmoe 모델의 출시는 오픈 소스 모델을 개발하고 성능을 폐쇄 된 모델과 비교하는 AI2의 목표의 일부라고 언급했습니다.

Model Building 측면에서 AI2는 64 명의 소규모 전문가를 미세한 라우팅에 사용하고 런타임에 8 개만 활성화하기로 결정했습니다. 실험에 따르면 Olmoe는 성능의 다른 모델과 비슷하지만 추론 비용 및 메모리 저장에서 크게 줄어 듭니다. Olmoe는 또한 AI2 전에 오픈 소스 모델 OLMO1.7-7B를 구축하여 4096 태그 컨텍스트 Windows를 지원합니다. Olmoe 교육 데이터는 Common Crawl, Dolma CC, Wikipedia 등을 포함한 여러 출처에서 제공됩니다.

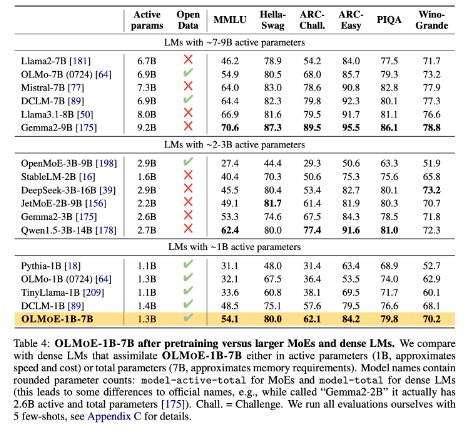

벤치 마크에서 Olmoe-1B-7B는 유사한 매개 변수를 가진 모델과 비교할 때 많은 기존 모델을 능가하며 LLAMA2-13B-Chat 및 DeepSeekmoe-16B와 같은 더 큰 모델을 능가합니다.

AI2의 목표 중 하나는 연구원에게 하이브리드 전문가 아키텍처를 포함하여보다 완전한 오픈 소스 AI 모델을 제공하는 것입니다. 많은 개발자들이 MOE 아키텍처를 사용하지만 AI2는 대부분의 다른 AI 모델이 충분히 열려 있다고 생각합니다.

Huggingface : https://huggingface.co/collections/allenai/olmoe-66cf678c047657a30c8cd3da

종이 입구 : https://arxiv.org/abs/2409.02060

핵심 사항 :

-AI2가 발표 한 새로운 오픈 소스 모델 Olmoe는 성능과 비용 측면에서 경쟁력이 있습니다.

-Olmoe는 추론 비용 및 메모리 요구 사항을 효과적으로 줄일 수있는 희소 하이브리드 전문가 아키텍처를 채택합니다.

-AI2는 학업 연구 및 개발을 촉진하는 완전히 오픈 소스 AI 모델을 제공하기 위해 최선을 다하고 있습니다.

요컨대, Olmoe의 오픈 소스 릴리스는 대규모 언어 모델의 분야에서 주요 발전입니다. AI2의 움직임은 오픈 소스 AI의 개발에 대한 확고한 헌신을 반영하며 향후 유사한 기여를 기대할 가치가 있습니다.