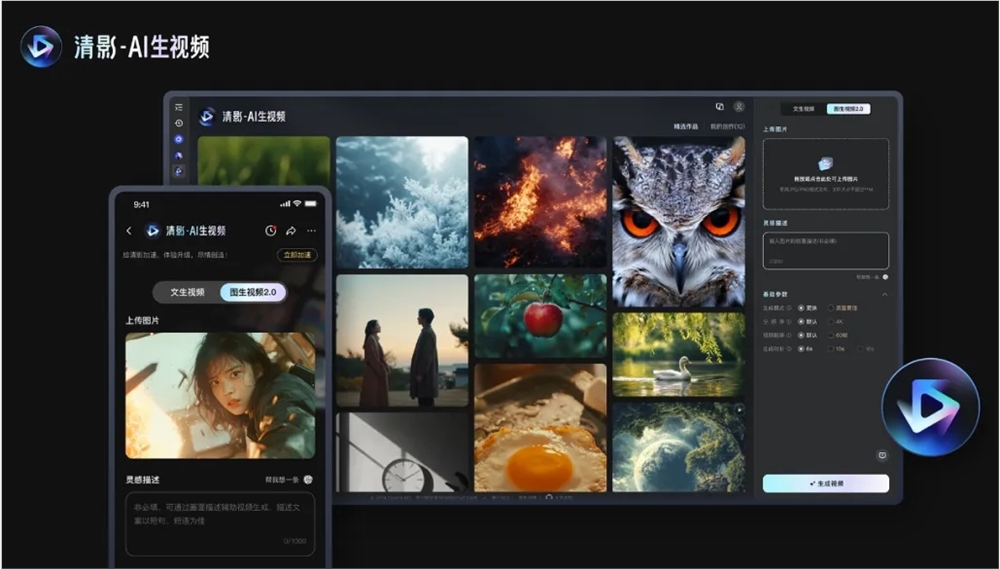

Beijing Zhipu Huazhang Technology Co., Ltd.는 Cogvideox v1.5 오픈 소스 모델을 출시하여 비디오 생성 분야에서 상당한 돌파구를 만들었습니다. 8 월 초에 출시 된 Cogvideox 시리즈는 최고의 기술과 개발자 친화적 인 기능을 통해 업계의 초점이되었습니다. 이 업데이트는 더 길고 고도로 정의 비디오 생성 지원뿐만 아니라 이미지 생성 비디오의 품질 및 의미 론적 이해를 크게 개선하여 AI 비디오 생성 경험을 제공하는 등 많은 개선을 가져 왔습니다. 주목할만한 가치는 새 버전이 Qingying 플랫폼과 Cogsound 사운드 효과 모델을 통합하여 비디오 생태계를 더욱 향상 시킨다는 것입니다.

이 오픈 소스의 내용에는 Cogvideox v1.5-5B와 Cogvideox v1.5-5B-I2V의 두 가지 모델이 포함됩니다. 새 버전은 Qingying 플랫폼에서 동시에 출시 될 예정이며, 새로 출시 된 Cogsound 사운드 효과 모델과 결합하여 품질 향상, 초고 정의 해상도 지원, 다양한 재생 시나리오, 다중 채널에 적응하기위한 가변 비율을 제공합니다. 출력 및 음향 효과가있는 AI 비디오.

기술적 수준에서 Cogvideox v1.5는 자동화 된 필터링 프레임 워크를 통한 동적 연결이 부족한 비디오 데이터를 필터링하고 엔드 투 엔드 비디오 이해 모델, CogVLM2- 캡션을 사용하여 정확한 비디오 컨텐츠 설명을 생성하고 텍스트 이해 및 교육 준수를 개선합니다. 기능. 또한, 새 버전은 컨텐츠 일관성 문제를 해결하기 위해 효율적인 3 차원 변형 자동 인코 코더 (3D VAE)를 채택하고 3 차원 텍스트, 시간 및 공간을 통합하는 변압기 아키텍처를 독립적으로 개발하고 전통적인 교차 변형 모듈을 취소합니다. 및 전문가 적응 계층 정규화 기술은 확산 모델에서 시간 단계 정보의 활용을 최적화합니다.

교육 측면에서 Cogvideox v1.5는 효율적인 확산 모델 교육 프레임 워크를 구축하고 다양한 병렬 컴퓨팅 및 시간 최적화 기술을 통해 긴 비디오 시퀀스의 빠른 교육을 달성합니다. 이 회사는 비디오 생성 분야의 스케일링 법의 효과를 확인했으며 향후 데이터 볼륨과 모델 규모를 확장하고 혁신적인 모델 아키텍처를 탐색하여보다 효율적으로 비디오 정보를 압축하고 텍스트 및 비디오 컨텐츠를 더 잘 통합 할 수 있다고 말했다.

코드 : https://github.com/thudm/cogvideo

모델 : https://huggingface.co/thudm/cogvideox1.5-5b-sat

Cogvideox v1.5의 오픈 소스는 비디오 생성 기술 개발을위한 새로운 자극을 제공하고 개발자에게보다 강력한 도구를 제공합니다. Zhipu Huazhang의 지속적인 기술 혁신과 오픈 소스 정신은 인정할 가치가 있으며,이 모델의 미래의 응용 전망은 기대할 가치가 있습니다. Cogvideox v1.5를 기반으로하는보다 혁신적인 응용 프로그램을 기대합니다.