Meta Fair Lab은 최근 "Sparsh"라는 획기적인 멀티 모달 손가락 촉각 지각 기술을 발표했으며, 이는 로봇 조작 분야에 완전히 혁명을 일으킬 것으로 예상됩니다. Sparsh 모델은 자체 감독 학습을 사용하여 460,000 개 이상의 촉각 이미지를 미리 훈련시키고 데이터의 수동 라벨링없이 일반 촉각 표현을 배우고 인간과 유사한 로봇의 촉각 인식 능력을 실현합니다. 그것은 다양한 시각적 햅틱 센서와 호환되며 힘 추정 및 슬라이딩 탐지와 같은 여러 작업에서 잘 수행됩니다. 특히 데이터가 제한 될 때 성능이 기존 모델의 성능을 훨씬 능가합니다.

Sparsh 모델은 사전 훈련을 위해 460,000 개가 넘는 촉각 이미지를 사용하여 자체 감독 학습을 채택하고 데이터의 수동 라벨링없이 일반 촉각 표현을 배웁니다.

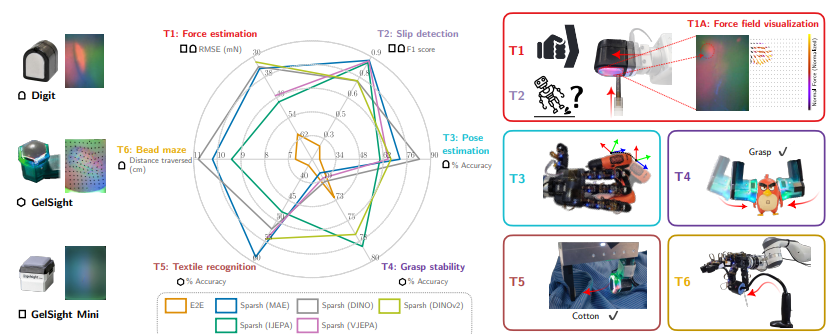

이 모델은 Digit, Gelsight2017 및 Gelsight Mini를 포함한 다양한 유형의 시각적 햅틱 센서를 지원할 수 있으며 힘 추정, 슬라이딩 탐지, 포즈 추정, 잡기 안정성 예측 및 직물 식별과 같은 촉각 인식 작업에 대한 로봇 성능을 크게 향상시킬 수 있습니다. 등. 연구원들은 또한 다양한 작업에서 다양한 햅틱 센서 및 모델의 성능을 평가하기 위해 Tacbench라는 표준화 된 벤치마킹 플랫폼을 구성했습니다.

테스트 결과에 따르면 Sparsh 모델은 Tacbench의 6 가지 작업에서 특히 데이터 볼륨이 제한되어 있으며 성능이 전통적인 작업 별 및 센서 별 모델을 훨씬 뛰어 넘는 것으로 나타났습니다. 예를 들어, 강제 추정 및 슬라이딩 감지 작업에서 Sparsh 모델은 주석 데이터의 1% 만 사용하더라도 만족스러운 결과를 얻을 수 있습니다. 이것은 Sparsh가 로봇이 물체의 물리적 특성을 더 잘 이해하고보다 세련된 조작을 수행하도록 도울 수 있음을 의미합니다.

Sparsh 모델의 출시는 AI Haptic 인식 분야에서 큰 획기적인 획기적인 것으로 나타납니다. 앞으로 더 많은 데이터가 축적되고 모델의 추가 최적화로 Sparsh는 로봇이 물리적 세계와 상호 작용하는 방식을 완전히 바꾸고 더 넓은 범위의 로봇 공학의 적용을 촉진 할 것으로 예상됩니다.

종이 주소 :

https://scontent-sjc3-1.xx.fbcdn.net/v/t39.2365-6/46496941_1107633400780143_7479102347328147009_N.pdf?_NC_CAT=11311-7/CCB=1-7> _nc_ohc = y8ui1hew3bqq7knvgfe-epu & _nc_zt = 14 & _nc_ht = scontent-sjc3-1. xx & _nc_gid = aeafsuzziasvwpffmqseozqu & oh = 00_AYAMQXGQ0ATCYSDXZWB0ZT8BGSKOGYMJ13C9F3YTVTKMSG & OE = 672DEEE4

Sparsh 기술의 출현은 로봇 햅틱 인식 기술이 새로운 이정표에 도달했음을 나타냅니다. 정제 된 조작 및 인간 컴퓨터 상호 작용의 잠재력은 크며 향후 적용 전망은 기대할 가치가 있습니다.