AMD의 최신 Strix Point APU 시리즈 프로세서는 AI Big Language Model (LLM) 애플리케이션에서 상당한 이점을 보여주고 Intel Lunar Lake 시리즈를 능가합니다. 모바일 플랫폼 용으로 설계된 일련의 프로세서는 AI 워크로드에 대한 증가하는 수요를 충족시키기 위해 더 높은 성능과 낮은 대기 시간을 제공하도록 설계되었습니다. AMD는 LLM 작업을 처리 할 때 Ryzen AI 프로세서의 뛰어난 성능을 강조하고 LM Studio 도구를 시작하여 대형 언어 모델과 낮은 사용자 임계 값의 사용을 단순화합니다.

최근 AMD는 최신 Strix Point APU 시리즈를 발표하여 AI Big Language Model (LLM) 응용 프로그램 에서이 시리즈의 뛰어난 성능을 강조하여 인텔의 Lunar Lake 시리즈 프로세서를 훨씬 능가했습니다. AI 워크로드에 대한 수요가 증가함에 따라 하드웨어 경쟁이 점점 치열 해지고 있습니다. 시장에 대처하기 위해 AMD는 높은 성능과 낮은 대기 시간을 위해 설계된 모바일 플랫폼 용으로 설계된 AI 프로세서를 출시했습니다.

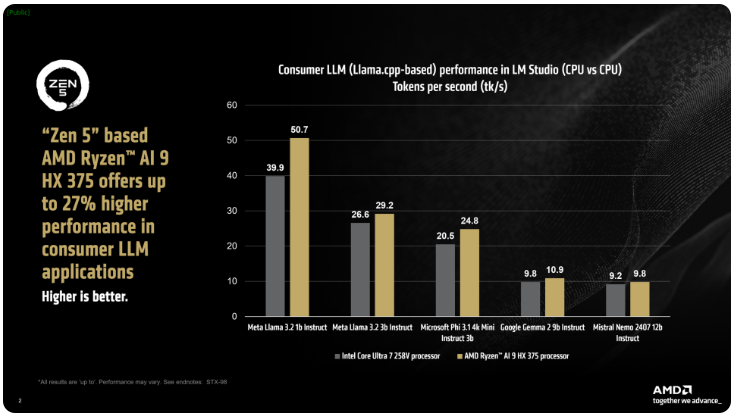

AMD는 IX Point 시리즈의 Ryzen AI300 프로세서는 AI LLM 작업을 처리 할 때 초당 처리 된 토큰 수를 크게 증가시킬 수 있으며 Ryzen AI9375는 Intel의 핵심 ULTRA258V에 비해 27%의 성능 개선을 가졌다 고 말했다. Core Ultra7V는 L Lake 제품군에서 가장 빠른 모델은 아니지만 핵심 및 스레드 수는 고급 음력 호수 프로세서에 가깝기 때문에이 지역의 AMD 제품의 경쟁력을 보여줍니다.

AMD의 LM Studio Tool은 LLAMA.CPP 프레임 워크를 기반으로하는 소비자 지향 애플리케이션으로, 대형 언어 모델의 사용을 단순화하도록 설계되었습니다. 이 프레임 워크는 X86CPU의 성능을 최적화하며 LLM을 실행하는 데 GPU가 필요하지는 않지만 GPU를 사용하면 처리 속도가 더 높아질 수 있습니다. 테스트에 따르면 Ryzen AI9HX375는 Meta LLAMA3.21B 명령 모델에서 35 배 더 낮은 대기 시간을 달성하고 초당 50.7 토큰을 프로세스 할 수 있습니다.

뿐만 아니라 Strix Point APU에는 RDNA3.5를 기반으로 한 강력한 Radeon 통합 그래픽 카드가 장착되어 있으며 Ulkan API를 통해 작업을 IGPU에 오프로드하여 LLM의 성능을 더욱 향상시킵니다. Ryzen AI300 프로세서는 변경 그래픽 메모리 (VGM) 기술을 사용하여 메모리 할당을 최적화하고 에너지 효율을 향상 시키며 궁극적으로 최대 60%의 성능 향상을 달성 할 수 있습니다.

비교하여 AMD는 Intel AI Playground 플랫폼에서 동일한 설정을 사용했으며 Ryzen AI9HX375가 Core Ultra7258V보다 Microsoft PHI3.1에서 87% 더 빠르고 Mistral7B instruct 0.3 모델에서 13% 더 빠릅니다. 그럼에도 불구하고 음력 호수 범위의 플래그십 코어 ULTRA9288V와 비교하면 결과가 더욱 흥미로울 것입니다. 현재 AMD는 LM Studio를 통해 대형 언어 모델의 사용을보다 인기있게 만드는 데 중점을 두어보다 비 기술적 인 사용자가 쉽게 시작할 수 있도록하기 위해 중점을두고 있습니다.

핵심 사항 :

AMD Strix Point Apus는 AI LLM 응용 프로그램에서 Intel Lunar Lake보다 성능을 27% 향상시킵니다.

Ryzen AI9HX375는 Meta LLAMA3.2 모델에서 3.5 배 낮은 대기 시간을 수행합니다.

LM 스튜디오 도구는 대형 언어 모델을보다 쉽고 비 기술적 인 사용자에게 사용하도록 설계되었습니다.

요컨대, AI LLM 애플리케이션 필드에서 AMD Strix Point APU 시리즈의 강력한 성능과 사용하기 쉬운 LM 스튜디오 도구는 AI 하드웨어 시장에서 AMD의 활성 레이아웃과 경쟁력을 나타내므로 소비자가보다 편리하게 제공합니다. 및 효율적인 AI 경험.