Rakuten Group은 일본의 인공 지능 개발을 촉진하기 위해 최초의 일본 대형 언어 모델 (LLM) Rakuten AI2.0 및 Smm (Small Language Model) Rakuten AI2.0mini를 발표했습니다. Rakuten AI2.0은 하이브리드 전문가 (MOE) 아키텍처를 채택하며 일본어 및 영어 데이터 교육을 통해 효율적인 텍스트 처리 기능을 제공합니다. Rakuten AI2.0mini는 Edge Device Deployment 용으로 설계된 15 억 개의 매개 변수를 갖춘 소형 모델로 비용 효율성 및 응용 프로그램 용이성을 고려합니다. 두 모델 모두 오픈 소스이며 다양한 텍스트 생성 작업을 지원하기 위해 미세 조정 및 선호도 최적화 버전을 제공합니다.

Rakuten Group은 Rakuten AI2.0 및 Rakuten AI2.0 Mini라는 최초의 일본 대형 언어 모델 (LLM) 및 SLM (Small Language Model)의 출시를 발표했습니다.

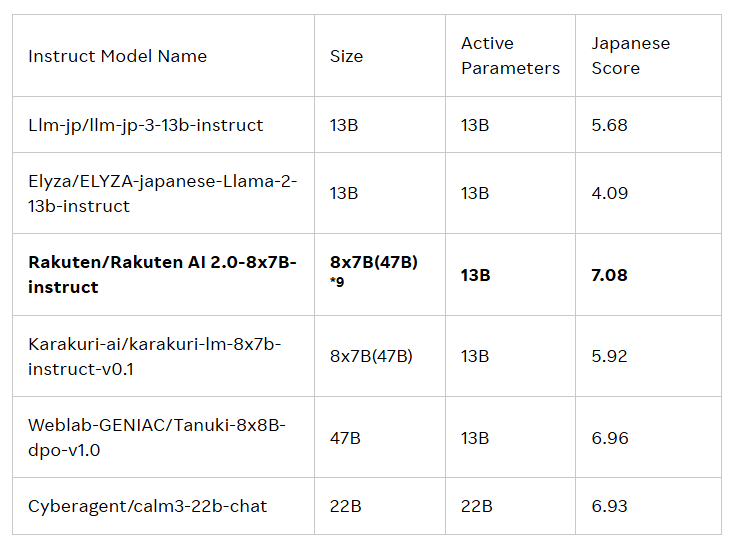

이 두 모델의 출시는 일본에서 인공 지능 (AI)의 발전을 주도하기위한 것입니다. Rakuten AI2.0은 하이브리드 전문가 (MOE) 아키텍처를 기반으로하며 70 억 개의 매개 변수를 가진 8 개의 모델로 구성된 8x7b 모델이며 각 전문가로서 사용됩니다. 입력 토큰이 처리 될 때마다 시스템은이를 가장 관련성이 높은 전문가에게 보내고 라우터는이를 선택할 책임이 있습니다. 이 전문가와 라우터는 많은 양의 고품질 일본어 및 영어 이중 언어 데이터를 통해 끊임없이 함께 훈련하고 있습니다.

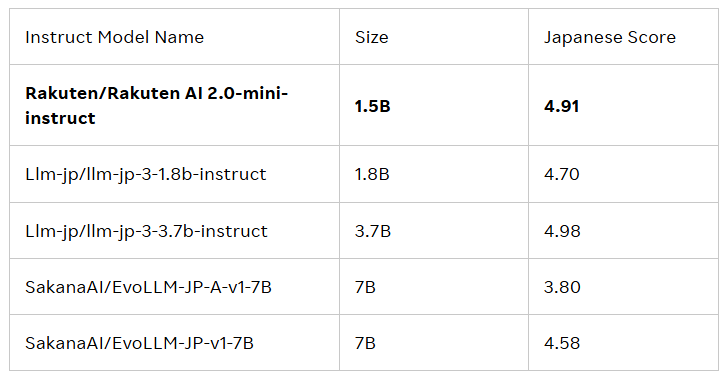

Rakuten AI2.0mini는 매개 변수량이 15 억의 새로운 밀도가 높은 모델로 비용 효율적인 에지 장치 배포를 위해 설계되었으며 특정 응용 프로그램 시나리오에 적합합니다. 또한 편리한 솔루션을 제공하기 위해 일본과 영국의 혼합 데이터에 대해 교육을 받았습니다. 두 모델 모두 미세 조정 및 선호되었으며 AI 애플리케이션 개발에 기업 및 전문가를 지원하기 위해 기본 모델 및 교육 모델을 출시했습니다.

모든 모델은 APACHE2.0 라이센스 계약에 따라 Rakuten Group의 공식 도서관에서 텍스트 생성, 컨텐츠 요약, 질문 및 답변 및 대화 시스템 구성을 포함합니다. 또한 이러한 모델은 다른 모델의 기초가되어 추가 개발 및 응용 프로그램을 용이하게 할 수 있습니다.

Rakuten Group의 Cai Ting은 다음과 같이 말했습니다 :“우리 팀이 데이터, 엔지니어링 및 과학을 결합하여 Rakuten AI2.0을 시작하는 방법을 매우 자랑스럽게 생각합니다. 기업은 지능적인 결정을 내리고, 가치 실현을 가속화하고, 공개 모델을 통해 새로운 가능성을 열어 주면서, 우리는 일본의 AI 개발을 가속화하고, 모든 일본 기업이 상생 협력 커뮤니티를 구축, 실험 및 성장하고 홍보하도록 장려합니다. . "

공식 블로그 : https://global.rakuten.com/corp/news/press/2025/0212_02.html

핵심 사항 :

Rakuten Group은 LLM (Lakuten AI2.0 및 Rakuten AI2.0 Mini)이라는 최초의 일본 대형 언어 모델 (LLM)과 SLM (Small Language Model)을 출시합니다.

Rakuten AI2.0은 하이브리드 전문가 아키텍처를 기반으로하며 일본 및 영어 이중 언어 데이터를 효율적으로 처리하기 위해 70 억 매개 변수를 가진 8 개의 전문가 모델을 보유하고 있습니다.

모든 모델은 공식 Rakuten Hugging Face Library에서 제공되며 다양한 텍스트 생성 작업에 적합하며 다른 모델의 기초가됩니다.

요컨대, Rakuten AI2.0과 Rakuten AI2.0Mini의 출시는 대형 언어 모델 분야에서 일본의 또 다른 중요한 진전을 표시하며 일본 AI 생태계의 건축 및 개발을 촉진 할 것입니다. 향후 적용 및 영향에.