Doubao Big Model Team의 공식 공식 계정에 따르면 Beijing Jiaotong University와 중국 과학 기술 대학의 공동 연구하에 Doubao Big Model 팀이 제안한 "VideoWorld"비디오 생성 실험 모델이 최근 공식적으로 개설되었습니다.

이 모델의 가장 큰 하이라이트는 더 이상 전통적인 언어 모델에 의존하지 않지만 시각 정보만으로도 세상을 인식하고 이해할 수 있다는 것입니다. 이 획기적인 연구는 Li Feifei 교수의 개념에서 영감을 얻었습니다. "어린 아이들은 TED 연설에서 언급 된 언어에 의존하지 않고 실제 세계를 이해할 수 있습니다".

"Videoworld"는 많은 양의 비디오 데이터를 분석하고 처리하여 복잡한 추론, 계획 및 의사 결정 기능을 실현합니다. 연구팀의 실험은이 모델이 300m 파라미터만으로 중요한 결과를 얻은 것으로 나타났습니다. 언어 또는 태그 데이터에 의존하는 기존 모델과 달리 Videoworld는 특히 종이 접기 및 활 타이와 같은 복잡한 작업에서 지식을 독립적으로 배울 수 있으며, 이는보다 직관적 인 학습 방법을 제공 할 수 있습니다.

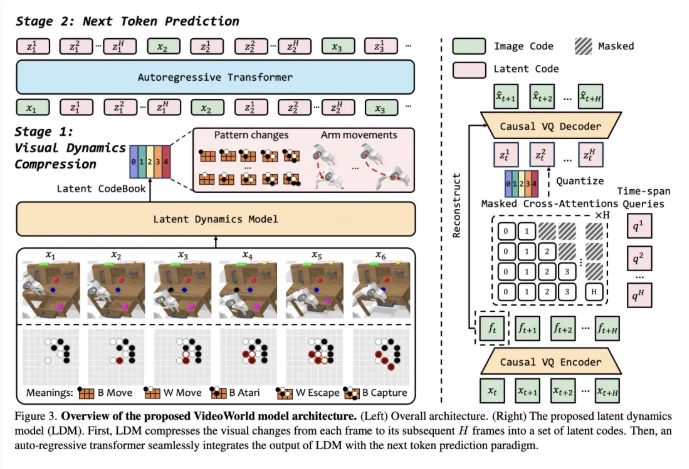

이 모델의 효과를 확인하기 위해 연구팀은 Go Battle과 Robot Simulation Control의 두 가지 실험 환경을 확립했습니다. 전략적인 게임으로서 Go는 모델의 규칙 학습 및 추론 능력을 효과적으로 평가할 수 있으며 로봇 작업은 제어 및 계획에서 모델의 성능을 조사합니다. 교육 단계 에서이 모델은 많은 양의 비디오 데모 데이터를 시청하여 미래의 사진을 예측할 수있는 능력을 점차적으로 설정합니다.

비디오 학습의 효율성을 향상시키기 위해 팀은 비디오 프레임 간의 시각적 변화를 압축하여 중요한 정보를 추출하도록 설계된 잠재적 인 동적 모델 (LDM)을 도입했습니다. 이 방법은 중복 정보를 줄일뿐만 아니라 복잡한 지식의 모델의 학습 효율성을 향상시킵니다. Videoworld는이 혁신을 통해 GO 및 로봇 작업에서 뛰어난 능력을 보여 주며 전문 5 단계 GO의 수준에 도달합니다.

종이 링크 : https://arxiv.org/abs/2501.09781

코드 링크 : https://github.com/bytedance/videoworld

프로젝트 홈페이지 : https://maverickren.github.io/videoworld.github.io

핵심 사항 :

"Videoworld"모델은 시각적 정보만으로 지식 학습을 실현할 수 있으며 언어 모델에 의존하지 않습니다.

이 모델은 GO 및 로봇 시뮬레이션 작업에서 우수한 추론 및 계획 기능을 보여줍니다.

프로젝트 코드와 모델은 공개적으로 공급되었으며 모든 생계의 사람들은 경험과 교환에 참여할 수 있습니다.