인공 지능 기술의 빠른 발전으로 언어 모델은 여러 분야에서 점점 더 널리 사용되고 있습니다. 그러나 새로운 OpenAi 연구에 따르면 이러한 모델은 사실적인 질문에 대답 할 때 AI의 지식을 습득 할 수있는 능력을 다시 생각할 때 기대치가 떨어졌습니다.

OpenAI의 최근 연구에 따르면 인공 지능 기술의 빠른 발전에도 불구하고 현재 가장 진보 된 언어 모델은 사실적인 질문에 대답하는 데 성공률이 훨씬 낮습니다.

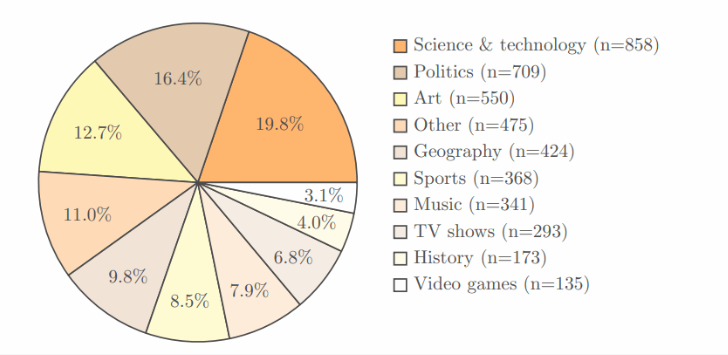

이 연구는 과학, 정치 및 예술과 같은 여러 분야를 다루는 4,326 개의 영역을 포함하는 OpenAI의 자체 SimpleQA 벤치 마크 테스트를 채택했으며 각 질문에는 명확하고 정답이 있습니다.

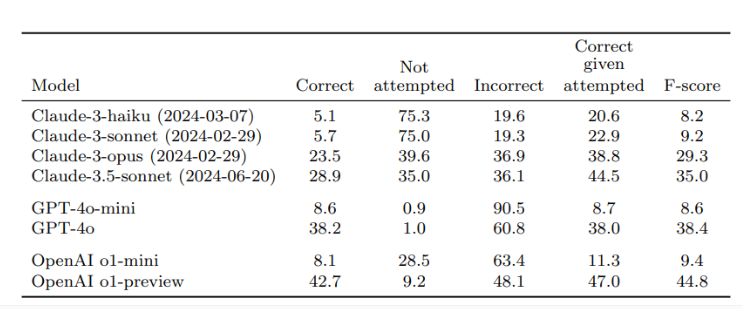

두 명의 독립적 인 검토 자에 의한 검증 후, 결과는 OpenAI의 최고의 모델 인 O1- 프리뷰의 정확도가 42.7%에 불과한 반면 GPT-4O는 약간 낮았으며 38.2%에 불과했습니다. 더 작은 GPT-4O- 미니의 경우 정확도는 8.6%에 불과합니다. 대조적으로, Anthropic의 Claude 모델은 Claude-3.5-Sonnet의 정확도율이 28.9%에 불과하면서 더 나빠졌습니다.

이 연구의 핵심은 AI의 성능을 테스트 할뿐만 아니라 지식 습득 측면에서 AI 모델의 한계를 깨닫게하는 테스트 설계입니다. 연구원들은 이러한 모델을 사용할 때 사용자가 지식 소스에 전적으로 의존하기보다는 정보 처리 도구로 간주해야한다고 강조합니다. 보다 정확한 답변을 얻으려면 내장 지식에만 의존하기보다는 AI에 대한 신뢰할 수있는 데이터를 제공하는 것이 가장 좋습니다.

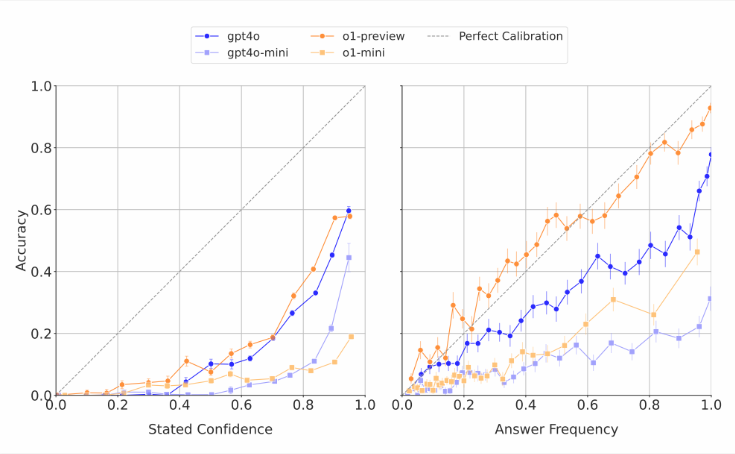

AI 모델은 종종 자신의 능력을 추정한다는 점은 주목할 가치가 있습니다. 연구원들은이 모델들이 자신의 반응에 대한 자신감을 얻도록 요청 받았을 때 일반적으로 과장된 정확도 점수를 주었다는 것을 발견했습니다. 동일한 질문에 반복적으로 답변하는 테스트에서 모델이 동일한 답변을 여러 번 제공하더라도 실제 성공률은 여전히 자기 평가의 정확도보다 낮습니다. 이것은 종종 언어 모델에 대한 터무니없는 답변을 만들어 내지 만 자신감있는 것처럼 보이는 외부 세계의 비판과 일치합니다.

연구원들은 현재 AI 시스템의 사실 정확도에 분명한 차이가 있다고 생각하며 시급히 개선이 필요하다고 생각합니다. 동시에, 그들은 짧은 사실 질문에 응답하는 AI의 성과가 더 길고 더 복잡한 답변을 다룰 때 그것이 어떻게 수행되는지 예측할 수 있는지 여부도 공개적인 질문을했습니다. 보다 신뢰할 수있는 언어 모델의 개발을 지원하기 위해 OpenAi는 GitHub에서 SimpleQA 벤치 마크에 대한 데이터를 공개했습니다.

핵심 사항 :

OpenAi Research에 따르면 가장 진보 된 언어 모델은 사실 질문에 대답 할 때 성공률이 낮고 최대 성공률은 42.7%에 불과합니다.

이 AI 모델은 종종 능력을 과대 평가하고 신뢰 점수는 일반적으로 과장됩니다.

OpenAi는보다 신뢰할 수있는 언어 모델을 연구하기 위해 SimpleQA 벤치 마크 대중을 만들었습니다.

이 연구는 AI 기술의 상당한 진전에도 불구하고 실제 응용 분야에서주의를 기울여야하고 기술 개선을 계속 촉진해야한다는 것을 상기시켜줍니다.