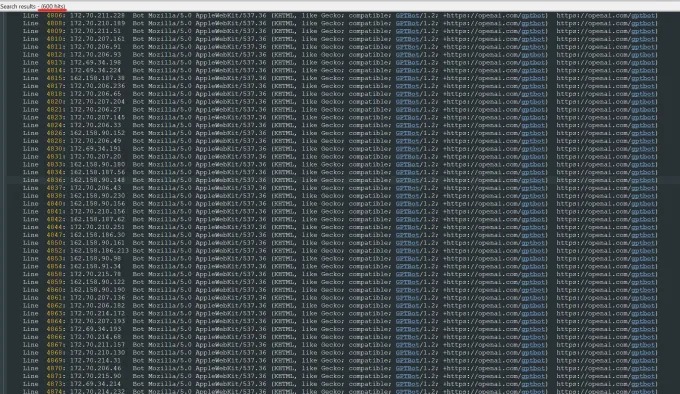

최근 Trilegangers의 CEO 인 Oleksandr Tomchuk는 회사의 전자 상거래 웹 사이트가 갑자기 마비되었다는 비상 경고를 받았습니다. 심층적 인 조사 후, 그는 문제의 근본이 전체 웹 사이트의 내용을 끊임없이 크롤링하는 Openai 로봇에 있다는 것을 발견했습니다. Trilegangers의 웹 사이트에는 65,000 개가 넘는 제품이 있으며 각각 세부 페이지와 3 개 이상의 이미지가 있습니다. OpenAi의 로봇은 수십만 개의 서버 요청을 보냈습니다. 수십만 개의 이미지와 설명을 포함하여 모든 것을 다운로드하려고 시도했습니다.

Tomchuk은 Openai의 크롤러가 웹 사이트에 심각한 영향을 미쳤으며, 이는 분산 서비스 거부 (DDO) 공격과 거의 동등한 영향을 미쳤다고 지적했다. Trilegangers의 주요 사업은 3D 아티스트, 비디오 게임 개발자 및 실제 인간 특성을 디지털 방식으로 재현 해야하는 다른 사용자에게 3D 객체 파일 및 이미지를 제공하는 것입니다. 이 문서에는 손에서 머리카락, 피부 및 전신까지의 상세한 스캔 데이터가 포함됩니다.

Trilegangers의 웹 사이트는 사업의 핵심입니다. 이 회사는 실제 인체의 3D 스캔에서 네트워크에서 가장 큰 "인간 디지털 독립형"데이터베이스를 구축하는 데 10 년이 넘었습니다. Tomchuk의 팀은 우크라이나에 본사를두고 있지만 미국 플로리다 주 탬파에서 라이센스를 받았습니다. 웹 사이트에는 무단 로봇 크롤링을 명시 적으로 금지하는 서비스 약관이 있지만 OpenAI의 로봇을 효과적으로 차단하지는 않았습니다.

로봇 크롤링을 효과적으로 방지하려면 웹 사이트는 Robot.txt 파일을 올바르게 구성해야합니다. BOT 제외 프로토콜이라고도하는 robot.txt는 검색 엔진에 색인화되어서는 안되는 컨텐츠에 정보를 제공하도록 설계되었습니다. OpenAi는 공식 페이지에서 웹 사이트에 크롤링이 금지되는 태그로 구성 될 때 파일을 존중한다고 말하지만 업데이트 된 Robot.txt 파일을 인식하는 데 로봇이 최대 24 시간이 걸릴 수 있다고 경고합니다.

Tomchuk은 웹 사이트가 Robot.txt를 올바르게 사용하지 않으면 OpenAi 및 기타 회사가 마음대로 데이터를 크롤링 할 수 있다고 생각할 수 있다고 강조했습니다. 이것은 선택적 시스템이 아니라 웹 사이트의 내용을 보호하는 데 필요한 조치입니다. 더 나쁜 것은, Trilegangers가 US 근무 시간 동안 Openai의 로봇에 의해 오프라인 상태 였을뿐만 아니라 로봇의 대규모 CPU 및 다운로드 활동으로 인해 AWS 청구서가 크게 증가 할 것으로 예상했습니다.

그러나 Robot.txt는 완전한 솔루션이 아닙니다. AI 회사 가이 계약을 준수하는지 여부는 전적으로 자발적으로 의존합니다. 지난 여름, 또 다른 AI 스타트 업인 Perplexity는 Robot.txt 프로토콜을 준수하지 않은 것으로 의심되는 유선으로 조사되었으며, 이는 광범위한 관심을 끌었습니다.

Tomchuk은 OpenAi에 연락하여 물어볼 방법을 찾을 수 없다고 말했다. OpenAi는 또한 TechCrunch의 의견 요청에 응답하지 않았습니다. 또한 OpenAi는 지금까지 옵트 아웃 도구에 대한 장기적인 약속을 제공하지 못해 문제가 더욱 복잡해집니다.

이것은 트레일 겐저에게 특히 까다로운 문제입니다. Tomchuk은 그들이 참여한 사업에는 실제 사람들을 스캔하고 있기 때문에 심각한 권리 문제가 포함된다고 지적했습니다. 유럽 GDPR 및 기타 법률에 따라 허가없이 온라인으로 라이브 사진을 사용하는 것은 불법입니다.

아이러니하게도, Openai 로봇의 탐욕스러운 행동은 Trilegangers가 웹 사이트의 취약성을 알게 만들었습니다. Tomchuk은 로봇이 데이터를보다 부드럽게 기어 다니면 문제를 눈치 채지 못할 수도 있다고 말했다.

Tomchuk는“이 회사들이 크롤링 데이터에 대한 취약성을 악용하는 것처럼 보이기 때문에 무섭습니다.‘태그로 Robot.txt를 업데이트하면 옵트 아웃 할 수 있습니다.’라고 Tomchuk은 말했습니다. 그러나 이것은 실제로 비즈니스 소유자에게 비난을 받아이 로봇을 막는 방법을 이해하도록 요청합니다.

Tomchuk은 다른 소규모 온라인 비즈니스가 AI 봇이 웹 사이트에서 저작권 자산을 훔치는 지 여부를 발견하는 유일한 방법이 적극적으로이를 찾는 것임을 알기를 희망합니다. 그는 AI 로봇에 의해 어려움을 겪는 유일한 사람은 아닙니다. 다른 웹 사이트의 소유자는 또한 OpenAi의 봇이 웹 사이트를 방해하고 AWS 수수료를 증가시키는 방법을 비즈니스 내부자에게 공개했습니다.

2024 년 까지이 문제는 더욱 악화 될 것으로 예상됩니다. 디지털 광고 회사의 새로운 연구에 따르면 AI 크롤러와 크롤러는 실제 사용자가 아니라 봇의 활동에서 나오는 "일반적인 무효 트래픽"이 86% 증가한 것으로 나타났습니다.