>>> Clique aqui para instalar o Fooocus <<<

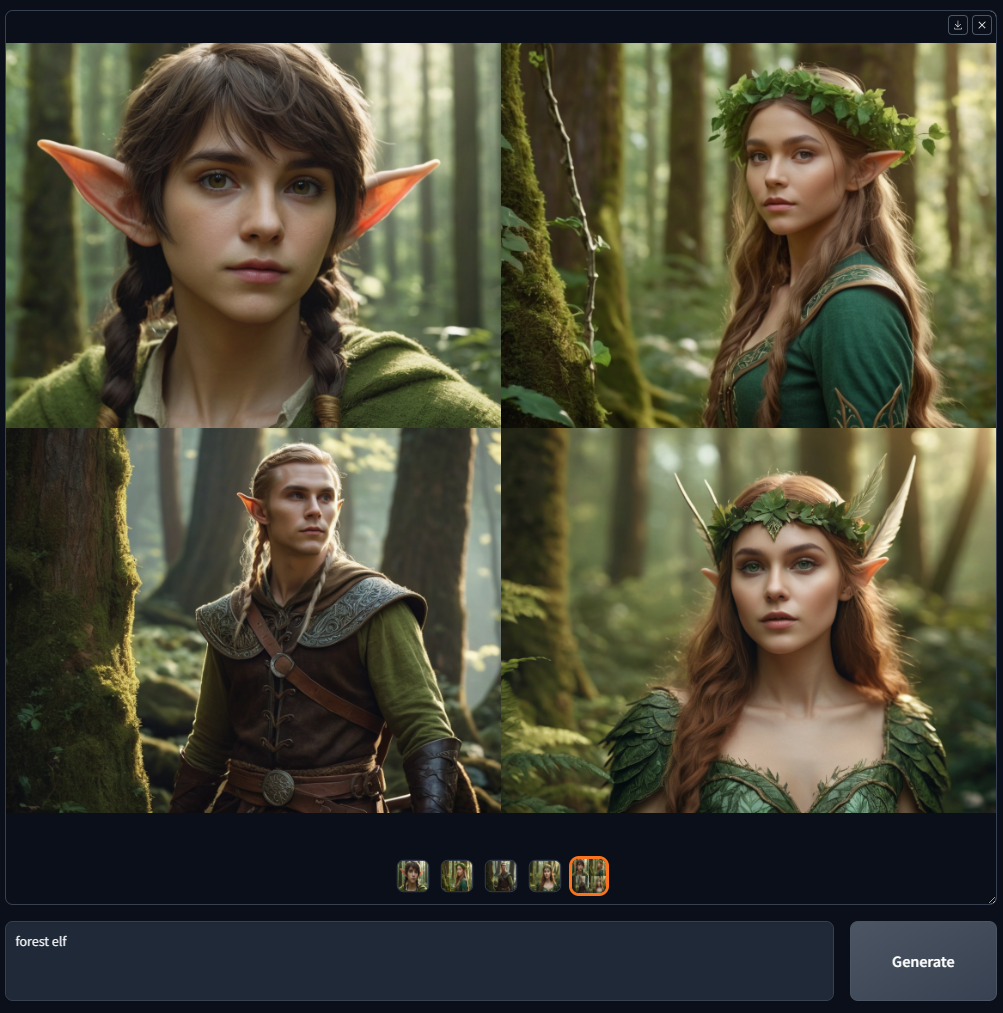

Fooocus é um software de geração de imagens (baseado em Gradio).

Fooocus apresenta uma reformulação dos designs de geradores de imagens. O software é offline, de código aberto e gratuito e, ao mesmo tempo, semelhante a muitos geradores de imagens online como Midjourney, o ajuste manual não é necessário e os usuários só precisam se concentrar nos prompts e nas imagens. Fooocus também simplificou a instalação: entre pressionar “download” e gerar a primeira imagem, o número de cliques necessários do mouse é estritamente limitado a menos de 3. O requisito mínimo de memória da GPU é de 4 GB (Nvidia).

Recentemente, existem muitos sites falsos no Google quando você pesquisa “fooocus”. Não confie neles – aqui está a única fonte oficial do Fooocus.

O projeto Fooocus, construído inteiramente na arquitetura Stable Diffusion XL , está agora em um estado de suporte limitado de longo prazo (LTS) apenas com correções de bugs. Como as funcionalidades existentes são consideradas quase livres de problemas programáticos (graças aos enormes esforços do mashb1t), as atualizações futuras se concentrarão exclusivamente na resolução de quaisquer bugs que possam surgir.

Não há planos atuais para migrar ou incorporar arquiteturas de modelos mais recentes. No entanto, isso pode mudar com o tempo com o desenvolvimento da comunidade de código aberto. Por exemplo, se a comunidade convergir para um único método dominante de geração de imagens (o que pode realmente acontecer em meio ou um ano, dada a situação atual), Fooocus também poderá migrar para esse método exato.

Para aqueles interessados em utilizar modelos mais recentes, como Flux , recomendamos explorar plataformas alternativas, como WebUI Forge (também nossa), ComfyUI/SwarmUI. Além disso, vários garfos excelentes de Fooocus estão disponíveis para experimentação.

Novamente, recentemente existem muitos sites falsos no Google quando você pesquisa “fooocus”. NÃO obtenha o Fooocus nesses sites – esta página é a única fonte oficial do Fooocus. Nunca tivemos nenhum site como “fooocus.com”, “fooocus.net”, “fooocus.co”, “fooocus.ai”, “fooocus.org”, “fooocus.pro”, “fooocus.one”. Esses sites são TODOS FALSOS. Eles não têm ABSOLUTAMENTE nenhuma relação conosco. Fooocus é um software de código aberto off-line 100% não comercial.

Abaixo está uma lista rápida usando exemplos de Midjourney:

| Meio da jornada | Fooocus |

|---|---|

| Texto para imagem de alta qualidade sem a necessidade de muita engenharia imediata ou ajuste de parâmetros. (Método desconhecido) | Texto para imagem de alta qualidade sem a necessidade de muita engenharia imediata ou ajuste de parâmetros. (Fooocus tem um mecanismo de processamento de prompts off-line baseado em GPT-2 e muitas melhorias de amostragem para que os resultados sejam sempre lindos, não importa se seu prompt é tão curto quanto “casa no jardim” ou até 1000 palavras) |

| V1 V2 V3 V4 | Imagem de entrada -> Upscale ou Variação -> Variar (sutil) / Variar (forte) |

| U1 U2 U3 U4 | Imagem de entrada -> Upscale ou Variação -> Upscale (1,5x) / Upscale (2x) |

| Inpaint / Cima / Baixo / Esquerda / Direita (Pan) | Imagem de entrada -> Inpaint ou Outpaint -> Inpaint / Acima / Abaixo / Esquerda / Direita (Fooocus usa seu próprio algoritmo de inpaint e modelos de inpaint para que os resultados sejam mais satisfatórios do que todos os outros softwares que usam método/modelo de inpaint SDXL padrão) |

| Solicitação de imagem | Imagem de entrada -> Prompt de imagem (Fooocus usa seu próprio algoritmo de prompt de imagem para que a qualidade do resultado e a compreensão imediata sejam mais satisfatórias do que todos os outros softwares que usam métodos SDXL padrão, como adaptadores IP padrão ou revisões) |

| --estilo | Avançado -> Estilo |

| --estilizar | Avançado -> Avançado -> Orientação |

| --niji | Vários lançadores: "run.bat", "run_anime.bat" e "run_realistic.bat". Fooocus suporta modelos SDXL no Civitai (Você pode pesquisar no Google “Civitai” se não souber) |

| --qualidade | Avançado -> Qualidade |

| --repita | Avançado -> Número da imagem |

| Várias solicitações (::) | Basta usar várias linhas de prompts |

| Pesos imediatos | Você pode usar "Estou (feliz: 1,5)". Fooocus usa o algoritmo de reponderação do A1111 para que os resultados sejam melhores do que o ComfyUI se os usuários copiarem os prompts diretamente do Civitai. (Porque se os prompts forem escritos na reponderação do ComfyUI, os usuários estarão menos propensos a copiar os textos dos prompts, pois preferem arrastar os arquivos) Para usar a incorporação, você pode usar "(embedding:file_name:1.1)" |

| --não | Avançado -> Prompt Negativo |

| --ar | Avançado -> Proporções |

| InsightFace | Imagem de entrada -> Prompt de imagem -> Avançado -> FaceSwap |

| Descrever | Imagem de entrada -> Descrever |

Abaixo está uma lista rápida usando exemplos do LeonardoAI:

| LeonardoAI | Fooocus |

|---|---|

| Alerta mágico | Avançado -> Estilo -> Fooocus V2 |

| Parâmetros avançados de amostragem (como contraste/nitidez/etc) | Avançado -> Avançado -> Nitidez da Amostragem / etc |

| ControlNets fáceis de usar | Imagem de entrada -> Prompt de imagem -> Avançado |

Além disso, clique aqui para navegar pelos recursos avançados.

Você pode baixar Fooocus diretamente com:

>>> Clique aqui para baixar <<<

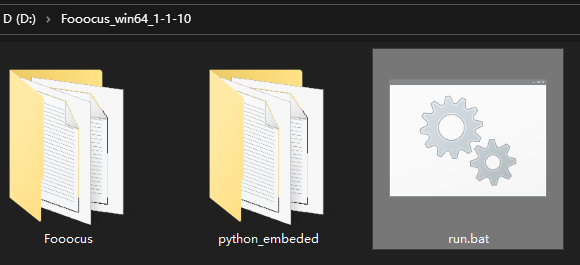

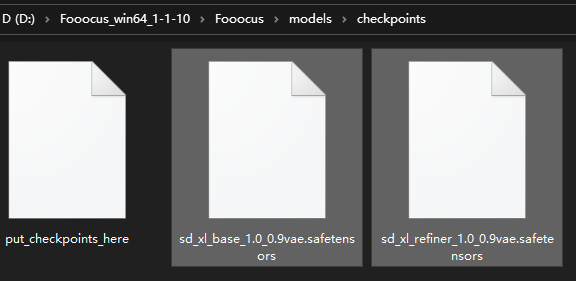

Depois de baixar o arquivo, descompacte-o e execute o "run.bat".

Na primeira vez que você iniciar o software, ele baixará automaticamente os modelos:

Ele fará o download dos modelos padrão para a pasta "Fooocusmodelscheckpoints", com diferentes predefinições. Você pode baixá-los com antecedência se não quiser o download automático.

Observe que se você usar inpaint, na primeira vez que pintar uma imagem, ele fará o download do modelo de controle inpaint do próprio Fooocus daqui como o arquivo "Fooocusmodelsinpaintinpaint_v26.fooocus.patch" (o tamanho deste arquivo é 1,28 GB).

Após o Fooocus 2.1.60, você também terá run_anime.bat e run_realistic.bat . São predefinições de modelos diferentes (e requerem modelos diferentes, mas serão baixados automaticamente). Confira aqui mais detalhes.

Após o Fooocus 2.3.0 você também pode alternar predefinições diretamente no navegador. Lembre-se de adicionar estes argumentos se quiser alterar o comportamento padrão:

Use --disable-preset-selection para desativar a seleção de predefinições no navegador.

Use --always-download-new-model para baixar modelos ausentes na opção predefinida. O padrão é o fallback para previous_default_models definido na predefinição correspondente, consulte também a saída do terminal.

Se você já possui esses arquivos, pode copiá-los para os locais acima para acelerar a instalação.

Observe que se você vir "MetadataIncompleteBuffer" ou "PytorchStreamReader" , seus arquivos de modelo estão corrompidos. Baixe os modelos novamente.

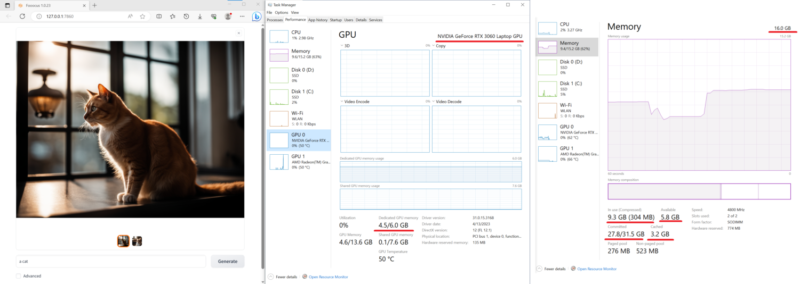

Abaixo está um teste em um laptop relativamente simples com 16 GB de RAM de sistema e 6 GB de VRAM (laptop Nvidia 3060). A velocidade nesta máquina é de cerca de 1,35 segundos por iteração. Bastante impressionante – hoje em dia os laptops com 3060 costumam ter um preço muito aceitável.

Além disso, recentemente muitos outros softwares relataram que o driver Nvidia acima de 532 às vezes é 10x mais lento que o driver Nvidia 531. Se o tempo de geração for muito longo, considere baixar o Nvidia Driver 531 Laptop ou o Nvidia Driver 531 Desktop.

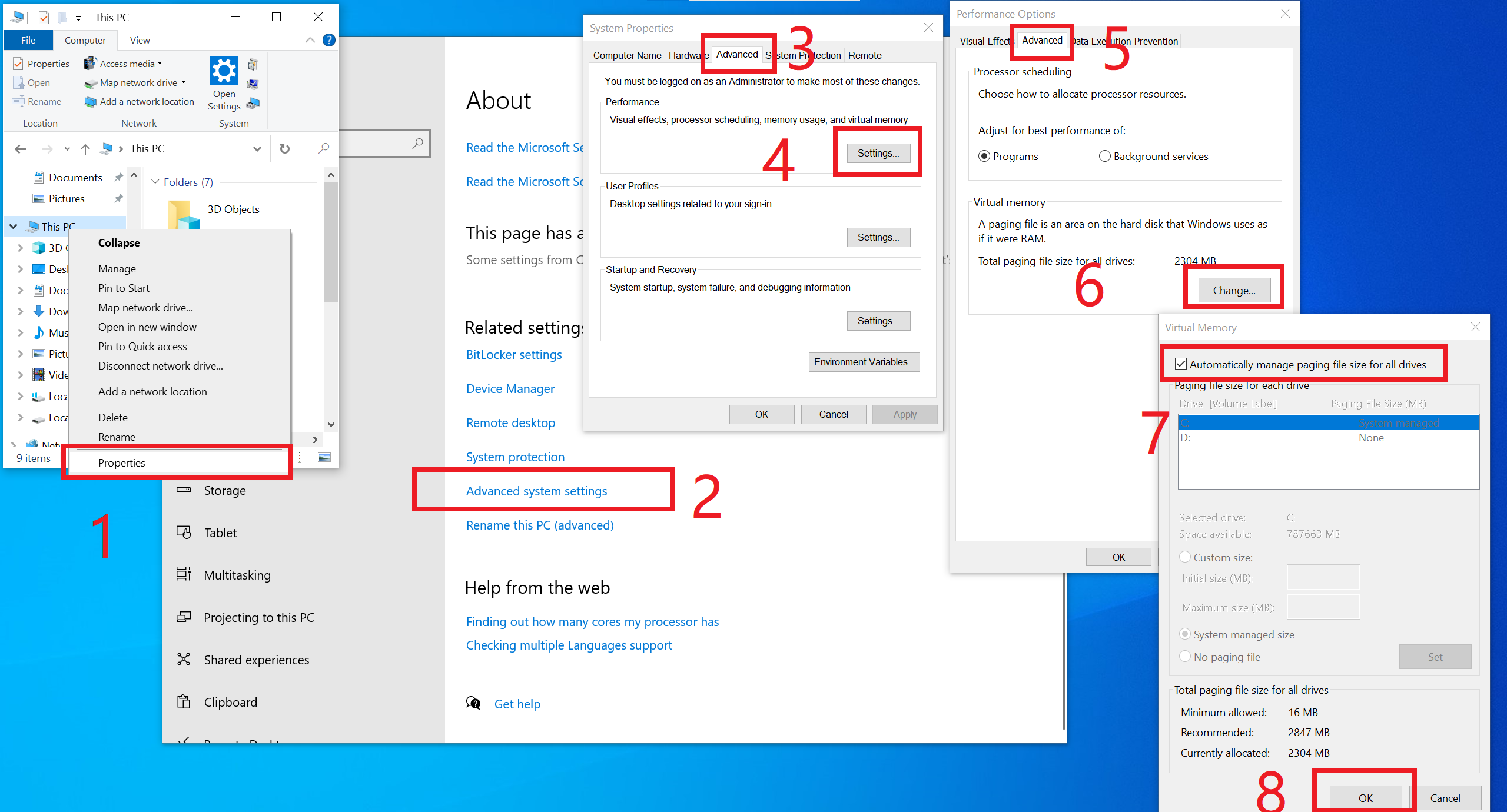

Observe que o requisito mínimo é 4 GB de memória GPU Nvidia (4 GB VRAM) e 8 GB de memória de sistema (8 GB de RAM) . Isso requer o uso da técnica Virtual Swap da Microsoft, que é habilitada automaticamente pela instalação do Windows na maioria dos casos, portanto, muitas vezes você não precisa fazer nada a respeito. No entanto, se você não tiver certeza, ou se você o desativou manualmente (alguém realmente faria isso?), ou se você vir algum "RuntimeError: CPUAllocator" , você pode habilitá-lo aqui:

E certifique-se de ter pelo menos 40 GB de espaço livre em cada unidade se ainda vir "RuntimeError: CPUAllocator"!

Abra um problema se você usa dispositivos semelhantes, mas ainda não consegue obter desempenhos aceitáveis.

Observe que o requisito mínimo para diferentes plataformas é diferente.

Veja também os problemas comuns e soluções aqui.

(Último teste - 12 de agosto de 2024 por mashb1t)

| Colab | Informações |

|---|---|

| Oficial Fooocus |

No Colab, você pode modificar a última linha para !python entry_with_update.py --share --always-high-vram ou !python entry_with_update.py --share --always-high-vram --preset anime ou !python entry_with_update.py --share --always-high-vram --preset realistic para Fooocus Default/Anime/Realistic Edition.

Você também pode alterar a predefinição na IU. Esteja ciente de que isso pode levar a tempos limites após 60 segundos. Se for esse o caso, aguarde até que o download termine, altere a predefinição para inicial e volte para aquela que você selecionou ou recarregue a página.

Observe que este Colab desativará o refinador por padrão porque os recursos do Colab gratuito são relativamente limitados (e alguns recursos "grandes", como o prompt de imagem, podem causar a desconexão do Colab de nível gratuito). Garantimos que a conversão básica de texto em imagem esteja sempre funcionando no Colab de nível gratuito.

O uso de --always-high-vram muda a alocação de recursos de RAM para VRAM e atinge o melhor equilíbrio geral entre desempenho, flexibilidade e estabilidade na instância T4 padrão. Encontre mais informações aqui.

Obrigado ao camenduru pelo modelo!

Se você quiser usar Anaconda/Miniconda, você pode

git clone https://github.com/lllyasviel/Fooocus.git cd Fooocus conda env create -f environment.yaml conda activate fooocus pip install -r requirements_versions.txt

Em seguida, baixe os modelos: baixe os modelos padrão para a pasta "Fooocusmodelscheckpoints". Ou deixe o Fooocus baixar automaticamente os modelos usando o inicializador:

conda activate fooocus python entry_with_update.py

Ou, se quiser abrir uma porta remota, use

conda activate fooocus python entry_with_update.py --listen

Use python entry_with_update.py --preset anime ou python entry_with_update.py --preset realistic para Fooocus Anime/Realistic Edition.

Seu Linux precisa ter o Python 3.10 instalado, e digamos que seu Python possa ser chamado com o comando python3 com seu sistema venv funcionando; você pode

git clone https://github.com/lllyasviel/Fooocus.git cd Fooocus python3 -m venv fooocus_env source fooocus_env/bin/activate pip install -r requirements_versions.txt

Consulte as seções acima para downloads de modelos. Você pode iniciar o software com:

source fooocus_env/bin/activate python entry_with_update.py

Ou, se quiser abrir uma porta remota, use

source fooocus_env/bin/activate python entry_with_update.py --listen

Use python entry_with_update.py --preset anime ou python entry_with_update.py --preset realistic para Fooocus Anime/Realistic Edition.

Se você sabe o que está fazendo e seu Linux já possui o Python 3.10 instalado, e seu Python pode ser chamado com o comando python3 (e Pip com pip3 ), você pode

git clone https://github.com/lllyasviel/Fooocus.git cd Fooocus pip3 install -r requirements_versions.txt

Consulte as seções acima para downloads de modelos. Você pode iniciar o software com:

python3 entry_with_update.py

Ou, se quiser abrir uma porta remota, use

python3 entry_with_update.py --listen

Use python entry_with_update.py --preset anime ou python entry_with_update.py --preset realistic para Fooocus Anime/Realistic Edition.

Observe que o requisito mínimo para diferentes plataformas é diferente.

O mesmo com as instruções acima. Você precisa mudar a tocha para a versão AMD

pip uninstall torch torchvision torchaudio torchtext functorch xformers pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/rocm5.6

A AMD não é testada intensivamente, entretanto. O suporte AMD está em beta.

Use python entry_with_update.py --preset anime ou python entry_with_update.py --preset realistic para Fooocus Anime/Realistic Edition.

Observe que o requisito mínimo para diferentes plataformas é diferente.

O mesmo acontece com o Windows. Baixe o software e edite o conteúdo de run.bat como:

.python_embededpython.exe -m pip uninstall torch torchvision torchaudio torchtext functorch xformers -y .python_embededpython.exe -m pip install torch-directml .python_embededpython.exe -s Fooocusentry_with_update.py --directml pause

Em seguida, execute o run.bat .

A AMD não é testada intensivamente, entretanto. O suporte AMD está em beta.

Para AMD, use .python_embededpython.exe entry_with_update.py --directml --preset anime ou .python_embededpython.exe entry_with_update.py --directml --preset realistic para Fooocus Anime/Realistic Edition.

Observe que o requisito mínimo para diferentes plataformas é diferente.

O Mac não é testado intensivamente. Abaixo está uma diretriz não oficial para usar o Mac. Você pode discutir problemas aqui.

Você pode instalar o Fooocus no Apple Mac Silicon (M1 ou M2) com macOS ‘Catalina’ ou uma versão mais recente. Fooocus é executado em computadores Apple Silicon por meio da aceleração de dispositivo PyTorch MPS. Os computadores Mac Silicon não vêm com placa gráfica dedicada, resultando em tempos de processamento de imagem significativamente mais longos em comparação com computadores com placas gráficas dedicadas.

Instale o gerenciador de pacotes conda e o pytorch todas as noites. Leia o treinamento Accelerated PyTorch no Mac Guia do desenvolvedor da Apple para obter instruções. Certifique-se de que o pytorch reconheça seu dispositivo MPS.

Abra o aplicativo macOS Terminal e clone este repositório com git clone https://github.com/lllyasviel/Fooocus.git .

Mude para o novo diretório Fooocus, cd Fooocus .

Crie um novo ambiente conda, conda env create -f environment.yaml .

Ative seu novo ambiente conda, conda activate fooocus .

Instale os pacotes exigidos pelo Fooocus, pip install -r requirements_versions.txt .

Inicie o Fooocus executando python entry_with_update.py . (Alguns usuários de Mac M2 podem precisar python entry_with_update.py --disable-offload-from-vram para acelerar o carregamento/descarregamento do modelo.) Na primeira vez que você executar o Fooocus, ele baixará automaticamente os modelos SDXL de difusão estável e levará um tempo significativo quantidade de tempo, dependendo da sua conexão com a internet.

Use python entry_with_update.py --preset anime ou python entry_with_update.py --preset realistic para Fooocus Anime/Realistic Edition.

Veja docker.md

Veja as diretrizes aqui.

Abaixo está o requisito mínimo para executar o Fooocus localmente. Se a capacidade do seu dispositivo for inferior a esta especificação, talvez você não consiga usar o Fooocus localmente. (Informe-nos, em qualquer caso, se a capacidade do seu dispositivo for menor, mas o Fooocus ainda funcionar.)

| Sistema operacional | GPU | Memória GPU mínima | Memória mínima do sistema | Troca de sistema | Observação |

|---|---|---|---|---|---|

| Janelas/Linux | Nvidia RTX 4XXX | 4GB | 8GB | Obrigatório | mais rápido |

| Janelas/Linux | Nvidia RTX3XXX | 4GB | 8GB | Obrigatório | geralmente mais rápido que RTX 2XXX |

| Janelas/Linux | Nvidia RTX 2XXX | 4GB | 8GB | Obrigatório | geralmente mais rápido que GTX 1XXX |

| Janelas/Linux | Nvidia GTX 1XXX | 8 GB (* 6 GB incerto) | 8GB | Obrigatório | apenas um pouco mais rápido que a CPU |

| Janelas/Linux | Nvidia GTX 9XX | 8GB | 8GB | Obrigatório | mais rápido ou mais lento que a CPU |

| Janelas/Linux | Nvidia GTX <9XX | Não compatível | / | / | / |

| Windows | GPU AMD | 8 GB (atualizado em 30 de dezembro de 2023) | 8GB | Obrigatório | via DirectML (* ROCm está em espera), cerca de 3x mais lento que Nvidia RTX 3XXX |

| Linux | GPU AMD | 8GB | 8GB | Obrigatório | via ROCm, cerca de 1,5x mais lento que Nvidia RTX 3XXX |

| Mac | MPS M1/M2 | Compartilhado | Compartilhado | Compartilhado | cerca de 9x mais lento que Nvidia RTX 3XXX |

| Windows/Linux/Mac | use apenas CPU | 0 GB | 32 GB | Obrigatório | cerca de 17x mais lento que Nvidia RTX 3XXX |

* AMD GPU ROCm (em espera): A AMD ainda está trabalhando no suporte ao ROCm no Windows.

* Nvidia GTX 1XXX 6GB incerta: Algumas pessoas relatam sucesso de 6GB na GTX 10XX, mas outras pessoas relatam casos de falha.

Observe que Fooocus serve apenas para geração de imagens de qualidade extremamente alta. Não apoiaremos modelos menores para reduzir os requisitos e sacrificar a qualidade do resultado.

Veja os problemas comuns aqui.

Dados objetivos diferentes, os modelos e configurações padrão do Fooocus são diferentes:

| Tarefa | Windows | Argumentos do Linux | Modelo Principal | Refinador | Configuração |

|---|---|---|---|---|---|

| Em geral | correr.bat | juggernautXL_v8Rundiffusion | não usado | aqui | |

| Realista | run_realistic.bat | --preset realista | realistaStockPhoto_v20 | não usado | aqui |

| Anime | run_anime.bat | --predefinição de anime | animaPencilXL_v500 | não usado | aqui |

Observe que o download é automático – você não precisa fazer nada se a conexão com a internet estiver boa. No entanto, você pode baixá-los manualmente se tiver (ou movê-los de outro lugar) sua própria preparação.

Além de rodar em localhost, o Fooocus também pode expor sua UI de duas maneiras:

Ouvinte de UI local: use --listen (especifique a porta, por exemplo, com --port 8888 ).

Acesso à API: use --share (registra um endpoint em .gradio.live ).

Em ambas as formas, o acesso não é autenticado por padrão. Você pode adicionar autenticação básica criando um arquivo chamado auth.json no diretório principal, que contém uma lista de objetos JSON com as chaves user e pass (veja o exemplo em auth-example.json).

Expansão de prompt baseada em GPT2 como um estilo dinâmico "Fooocus V2". (semelhante ao pré-processamento oculto e modo "bruto" do Midjourney, ou ao Prompt Magic do LeonardoAI).

Troca de refinador nativo dentro de um único amostrador k. A vantagem é que o modelo refinador agora pode reutilizar o momento do modelo base (ou os parâmetros históricos do ODE) coletados da amostragem k para obter uma amostragem mais coerente. Na correção de alta resolução do Automatic1111 e no sistema de nós do ComfyUI, o modelo básico e o refinador usam dois k-samplers independentes, o que significa que o impulso é amplamente desperdiçado e a continuidade da amostragem é quebrada. Fooocus usa sua própria amostragem avançada de difusão k que garante troca contínua, nativa e contínua em uma configuração de refinador. (Atualização em 13 de agosto: Na verdade, discuti isso com o Automatic1111 há vários dias, e parece que a “troca de refinador nativo dentro de um único k-sampler” foi mesclada no ramo de desenvolvimento do webui. Ótimo!)

Orientação negativa da ADM. Como o nível de resolução mais alto do XL Base não tem atenção cruzada, os sinais positivos e negativos para o nível de resolução mais alto do XL não podem receber contrastes suficientes durante a amostragem CFG, fazendo com que os resultados pareçam um pouco plásticos ou excessivamente suaves em certos casos. Felizmente, como o nível de resolução mais alto do XL ainda está condicionado às proporções de imagem (ADM), podemos modificar o adm no lado positivo/negativo para compensar a falta de contraste CFG no nível de resolução mais alto. (Atualização em 16 de agosto, o aplicativo IOS Draw Things oferecerá suporte à orientação negativa de ADM. Ótimo!)

Implementamos uma variação cuidadosamente ajustada da Seção 5.1 de "Melhorando a qualidade da amostra de modelos de difusão usando orientação de autoatenção". O peso está definido para muito baixo, mas esta é a garantia final da Fooocus para garantir que o XL nunca produzirá uma aparência excessivamente lisa ou plástica (exemplos aqui). Isto pode quase eliminar todos os casos para os quais o XL ocasionalmente ainda produz resultados excessivamente suaves, mesmo com orientação negativa do ADM. (Atualização de 18 de agosto de 2023, o kernel gaussiano do SAG foi alterado para um kernel anisotrópico para melhor preservação da estrutura e menos artefatos.)

Modificamos um pouco os modelos de estilo e adicionamos o "cinematic-default".

Testamos o "sd_xl_offset_example-lora_1.0.safetensors" e parece que quando o peso do lora está abaixo de 0,5, os resultados são sempre melhores que o XL sem lora.

Os parâmetros dos amostradores são cuidadosamente ajustados.

Como o XL usa codificação posicional para resolução de geração, as imagens geradas por várias resoluções fixas parecem um pouco melhores do que aquelas de resoluções arbitrárias (porque a codificação posicional não é muito boa para lidar com números inteiros que não são vistos durante o treinamento). Isso sugere que as resoluções na IU podem ser codificadas para obter melhores resultados.

Prompts separados para dois codificadores de texto diferentes parecem desnecessários. Prompts separados para o modelo base e o refinador podem funcionar, mas os efeitos são aleatórios e evitamos implementar isso.

A família DPM parece adequada para XL, já que XL às vezes gera textura excessivamente suave, mas a família DPM às vezes gera detalhes de textura excessivamente densos. O seu efeito conjunto parece neutro e atraente para a percepção humana.

Um sistema cuidadosamente projetado para equilibrar vários estilos, bem como expansão imediata.

Usando o método automatic1111 para normalizar a ênfase do prompt. Isso melhora significativamente os resultados quando os usuários copiam prompts diretamente do civitai.

O sistema de troca conjunta do refinador agora também suporta img2img e upscale de forma contínua.

Escala CFG e correção TSNR (ajustada para SDXL) quando CFG for maior que 10.

Após a primeira vez que você executar o Fooocus, um arquivo de configuração será gerado em Fooocusconfig.txt . Este arquivo pode ser editado para alterar o caminho do modelo ou os parâmetros padrão.

Por exemplo, um Fooocusconfig.txt editado (este arquivo será gerado após a primeira inicialização) pode ter a seguinte aparência:

{ "path_checkpoints": "D:Fooocusmodelscheckpoints", "path_loras": "D:Fooocusmodelsloras", "path_embeddings": "D:Fooocusmodelsembeddings", "path_vae_approx": "D:Fooocusmodelsvae_approx", "path_upscale_models": "D:Fooocusmodelsupscale_models", "path_inpaint": "D:Fooocusmodelsinpaint", "path_controlnet": "D:Fooocusmodelscontrolnet", "path_clip_vision": "D:Fooocus modelsclip_vision", "path_fooocus_expansion": "D:Fooocusmodelsprompt_expansionfooocus_expansion", "path_outputs": "D:Fooocusoutputs", "default_model": "realisticStockPhoto_v10.safetensors", "default_refiner": "", "default_loras": [[" lora_filename_1.safetensors", 0,5], ["lora_filename_2.safetensors", 0.5]], "default_cfg_scale": 3.0, "default_sampler": "dpmpp_2m", "default_scheduler": "karras", "default_negative_prompt": "baixa qualidade", "default_positivo_prompt": "", " default_styles": [ "Fooocus V2", "Fotografia Fooocus", "Fooocus Negativo"

]

} Muitas outras chaves, formatos e exemplos estão em Fooocusconfig_modification_tutorial.txt (este arquivo será gerado após a primeira inicialização).

Pense duas vezes antes de realmente alterar a configuração. Se você estiver quebrando alguma coisa, basta excluir Fooocusconfig.txt . Fooocus voltará ao padrão.

Uma maneira mais segura é tentar "run_anime.bat" ou "run_realistic.bat" - eles já devem ser bons o suficiente para diferentes tarefas.

Observe que user_path_config.txt está obsoleto e será removido em breve. (Editar: já foi removido.)

entry_with_update.py [-h] [--listen [IP]] [--port PORT] [--disable-header-check [ORIGIN]] [--web-upload-size WEB_UPLOAD_SIZE] [--hf-mirror HF_MIRROR] [--external-working-path PATH [PATH ...]] [--output-path OUTPUT_PATH] [--temp-path TEMP_PATH] [--cache-path CACHE_PATH] [--in-browser] [--disable-in-browser] [--gpu-device-id DEVICE_ID] [--async-cuda-allocation | --disable-async-cuda-allocation] [--disable-attention-upcast] [--all-in-fp32 | --all-in-fp16] [--unet-in-bf16 | --unet-in-fp16 | --unet-in-fp8-e4m3fn | --unet-in-fp8-e5m2] [--vae-in-fp16 | --vae-in-fp32 | --vae-in-bf16] [--vae-in-cpu] [--clip-in-fp8-e4m3fn | --clip-in-fp8-e5m2 | --clip-in-fp16 | --clip-in-fp32] [--directml [DIRECTML_DEVICE]] [--disable-ipex-hijack] [--preview-option [none,auto,fast,taesd]] [--attention-split | --attention-quad | --attention-pytorch] [--disable-xformers] [--always-gpu | --always-high-vram | --always-normal-vram | --always-low-vram | --always-no-vram | --always-cpu [CPU_NUM_THREADS]] [--always-offload-from-vram] [--pytorch-deterministic] [--disable-server-log] [--debug-mode] [--is-windows-embedded-python] [--disable-server-info] [--multi-user] [--share] [--preset PRESET] [--disable-preset-selection] [--language LANGUAGE] [--disable-offload-from-vram] [--theme THEME] [--disable-image-log] [--disable-analytics] [--disable-metadata] [--disable-preset-download] [--disable-enhance-output-sorting] [--enable-auto-describe-image] [--always-download-new-model] [--rebuild-hash-cache [CPU_NUM_THREADS]]

Exemplo de prompt: __color__ flower

Processado para prompt positivo e negativo.

Seleciona um curinga aleatório em uma lista predefinida de opções, neste caso o arquivo wildcards/color.txt . O curinga será substituído por uma cor aleatória (aleatoriedade baseada na semente). Você também pode desativar a aleatoriedade e processar um arquivo curinga de cima para baixo, ativando a caixa de seleção Read wildcards in order no modo de depuração do desenvolvedor.

Os curingas podem ser aninhados e combinados, e vários curingas podem ser usados no mesmo prompt (por exemplo, consulte wildcards/color_flower.txt ).

Exemplo de prompt: [[red, green, blue]] flower

Processado apenas para prompt positivo.

Processa o array da esquerda para a direita, gerando uma imagem separada para cada elemento do array. Neste caso seriam geradas 3 imagens, uma para cada cor. Aumente o número da imagem para 3 para gerar todas as 3 variantes.

Os arrays não podem ser aninhados, mas vários arrays podem ser usados no mesmo prompt. Suporta LoRAs inline como elementos de array!

Exemplo de prompt: flower <lora:sunflowers:1.2>

Processado apenas para prompt positivo.

Aplica um LoRA ao prompt. O arquivo LoRA deve estar localizado no diretório models/loras .

Clique aqui para navegar pelos recursos avançados.

Abaixo estão alguns Forks para Fooocus:

| Garfos de Fooocus |

|---|

| fenneishi/Fooocus-Control runew0lf/RuinedFooocus MoonRide303/Fooocus-MRE metercai/SimpleSDXL mashb1t/Fooocus e assim por diante ... |

Muito obrigado a twri e 3Diva e Marc K3nt3L por criar estilos SDXL adicionais disponíveis no Fooocus.

O projeto começa com uma mistura de bases de código Stable Diffusion WebUI e ComfyUI.

Além disso, obrigado daswer123 por contribuir com o Canvas Zoom!

O registro está aqui.

Você pode colocar arquivos JSON na pasta language para traduzir a interface do usuário.

Por exemplo, abaixo está o conteúdo de Fooocus/language/example.json :

{ "Gerar": "生成", "Imagem de entrada": "入力画像", "Avançado": "고급", "Modelo SAI 3D": "Modelo SAI 3D"} Se você adicionar --language example arg, Fooocus lerá Fooocus/language/example.json para traduzir a IU.

Por exemplo, você pode editar a linha final do Windows run.bat como

.python_embededpython.exe -s Fooocusentry_with_update.py --language example

Ou run_anime.bat como

.python_embededpython.exe -s Fooocusentry_with_update.py --language example --preset anime

Ou run_realistic.bat como

.python_embededpython.exe -s Fooocusentry_with_update.py --language example --preset realistic

Para uma tradução prática, você pode criar seu próprio arquivo como Fooocus/language/jp.json ou Fooocus/language/cn.json e então usar o sinalizador --language jp ou --language cn . Aparentemente, esses arquivos não existem agora. Precisamos da sua ajuda para criar esses arquivos!

Observe que se nenhum --language for fornecido e ao mesmo tempo Fooocus/language/default.json existir, Fooocus sempre carregará Fooocus/language/default.json para tradução. Por padrão, o arquivo Fooocus/language/default.json não existe.