Kai Li 1 , Wendi Sang 1 , Chang Zeng 2 , Runxuan Yang 1 , Guo Chen 1 , Xiaolin Hu 1

1 Universidade de Tsinghua, China

2 Instituto Nacional de Informática, Japão

Papel | Demonstração

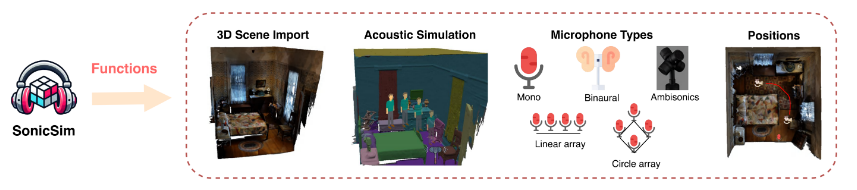

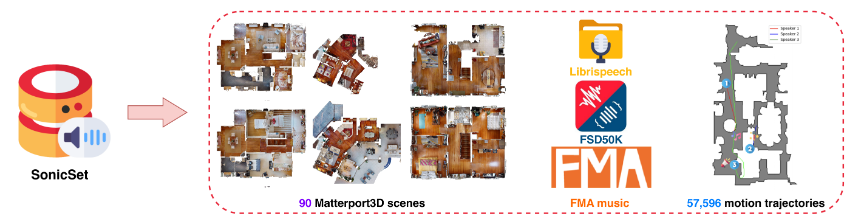

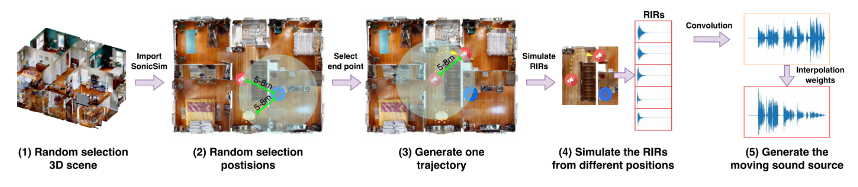

Apresentamos o SonicSim, um kit de ferramentas sintético projetado para gerar dados altamente personalizáveis para fontes sonoras em movimento. SonicSim é desenvolvido com base na plataforma de simulação de IA incorporada, Habitat-sim, suportando ajustes de parâmetros de vários níveis, incluindo nível de cena, nível de microfone e nível de fonte, gerando assim dados sintéticos mais diversos. Aproveitando o SonicSim, construímos um conjunto de dados de referência de fonte sonora em movimento, SonicSet, usando o conjunto de dados LibriSpeech, o Freesound Dataset 50k (FSD50K) e o Free Music Archive (FMA), e 90 cenas do Matterport3D para avaliar modelos de separação e aprimoramento de fala.

[2024-10-30] Corrigimos os bugs de instalação do ambiente e atualizamos o código de treinamento para separação de fala e modelos de aprimoramento no conjunto de dados SonicSet.

[2024-10-23] Lançamos o training code para modelos de separação e aprimoramento de fala no conjunto de dados SonicSet.

[2024-10-03] Divulgamos o artigo sobre arxiv

[2024-10-01] Lançamos o conjunto de dados de separação de fala do mundo real, que visa avaliar o desempenho de modelos de separação de fala em cenários do mundo real.

[2024-07-31] Lançamos o SonicSim dataset , que inclui tarefas de separação e aprimoramento de fala.

[2024-07-24] Lançamos os scripts para dataset construction e os modelos pré-treinados para speech separation and enhancement .

Importação de cena 3D: suporta a importação de uma variedade de ativos 3D de conjuntos de dados como Matterport3D, permitindo a geração eficiente e escalável de ambientes acústicos complexos.

Simulação de Ambiente Acústico:

Simula reflexões sonoras em geometrias de salas usando modelagem acústica interna e algoritmos de rastreamento de caminho bidirecional.

Mapeia rótulos semânticos de cenas 3D para propriedades de materiais, definindo os coeficientes de absorção, dispersão e transmissão de superfícies.

Sintetiza dados móveis de fontes sonoras com base em caminhos de origem, garantindo alta fidelidade às condições do mundo real.

Configurações de microfone: oferece uma ampla variedade de configurações de microfone, incluindo mono, binaural e Ambisonics, além de suporte para conjuntos de microfones lineares e circulares personalizados.

Posicionamento da fonte e do microfone: Fornece personalização ou randomização das posições da fonte de som e do microfone. Suporta trajetórias de movimento para simulações de fontes sonoras em movimento, adicionando realismo a cenários acústicos dinâmicos.

Você pode baixar o conjunto de dados pré-construído no seguinte link:

| Nome do conjunto de dados | Onedrive | Disco Baidu |

|---|---|---|

| pasta train (40 arquivos rar divididos, 377G) | [Link para download] | [Link para download] |

| val.rar (4.9G) | [Link para download] | [Link para download] |

| teste.rar (2.2G) | [Link para download] | [Link para download] |

| dados de referência de setembro (8,57G) | [Link para download] | [Link para download] |

| dados de benchmark enh (7,70G) | [Link para download] | [Link para download] |

| Nome do conjunto de dados | Onedrive | Disco Baidu |

|---|---|---|

| Conjunto de dados do mundo real (1.0G) | [Link para download] | [Link para download] |

Conjunto de dados RealMAN: RealMAN

Para construir o conjunto de dados você mesmo, consulte o README na pasta SonicSim-SonicSet/data-script . Este documento fornece instruções detalhadas sobre como usar os scripts fornecidos para gerar o conjunto de dados.

Para configurar o ambiente para treinamento e inferência, use o arquivo YAML fornecido:

conda criar -n SonicSim-Train python=3.10 conda ativar SonicSim-Train pip instalar Cython==3.0.10 numpy==1.26.4 pip instalar tocha==2.0.1 torchvision==0.15.2 torchaudio==2.0.2 --index-url https://download.pytorch.org/whl/cu118 pip install -r requisitos.txt -i https://mirrors.tuna.tsinghua.edu.cn/pypi/web/simple

Navegue até o diretório separation e execute o script a seguir para gerar o conjunto de validação fixo:

separação de CD python generate_fixed_validation.py --raw_dir=../SonicSim-SonicSet/SonicSet/scene_datasets/mp3d/val --save_dir=../SonicSim-SonicSet/SonicSet/scene_datasets/mp3d/val-sep-2 --is_mono python generate_fixed_test.py --raw_dir=/home/pod/SonicSim/SonicSim/SonicSim-SonicSet/SonicSet/scene_datasets/mp3d/test --is_mono

Navegue até o diretório enhancement e execute o script a seguir para gerar o conjunto de validação fixo:

aprimoramento de cd python generate_fixed_validation.py --raw_dir=../SonicSim-SonicSet/SonicSet/scene_datasets/mp3d/val --save_dir=../SonicSim-SonicSet/SonicSet/scene_datasets/mp3d/val-enh-noise --is_mono python generate_fixed_test.py --raw_dir=/home/pod/SonicSim/SonicSim/SonicSim-SonicSet/SonicSet/scene_datasets/mp3d/test --is_mono

Navegue até o diretório separation e execute o script de treinamento com o arquivo de configuração especificado:

separação de CD python train.py --conf_dir=configs/afrcnn.yaml

Navegue até o diretório enhancement e execute o script de treinamento com o arquivo de configuração especificado:

aprimoramento de cd python train.py --conf_dir=config/dccrn.yaml

Verifique o conteúdo de README.md nas pastas sep-checkpoints e enh-checkpoints, baixe os modelos pré-treinados apropriados em Release e descompacte-os nas pastas apropriadas.

Navegue até o diretório separation e execute o script de inferência com o arquivo de configuração especificado:

separação de CD python inference.py --conf_dir=../sep-checkpoints/TFGNet-Noise/config.yaml

Navegue até o diretório enhancement e execute o script de inferência com o arquivo de configuração especificado:

aprimoramento de cd python inference.py --conf_dir=../enh-checkpoints/TaylorSENet-Noise/config.yaml

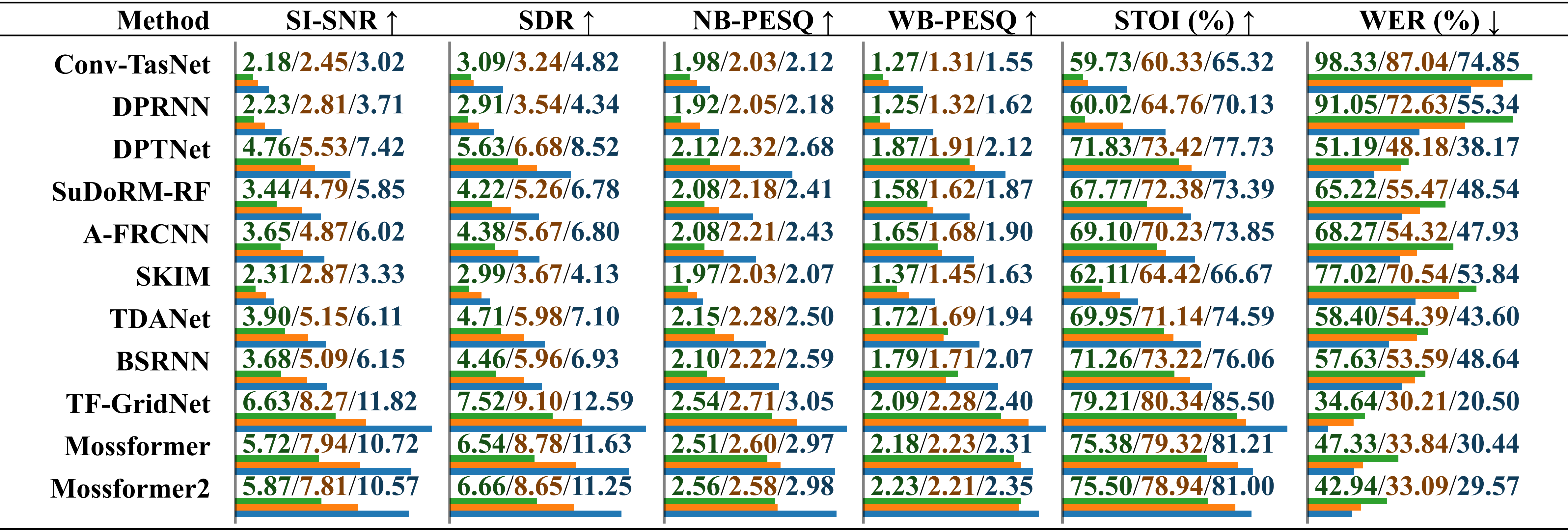

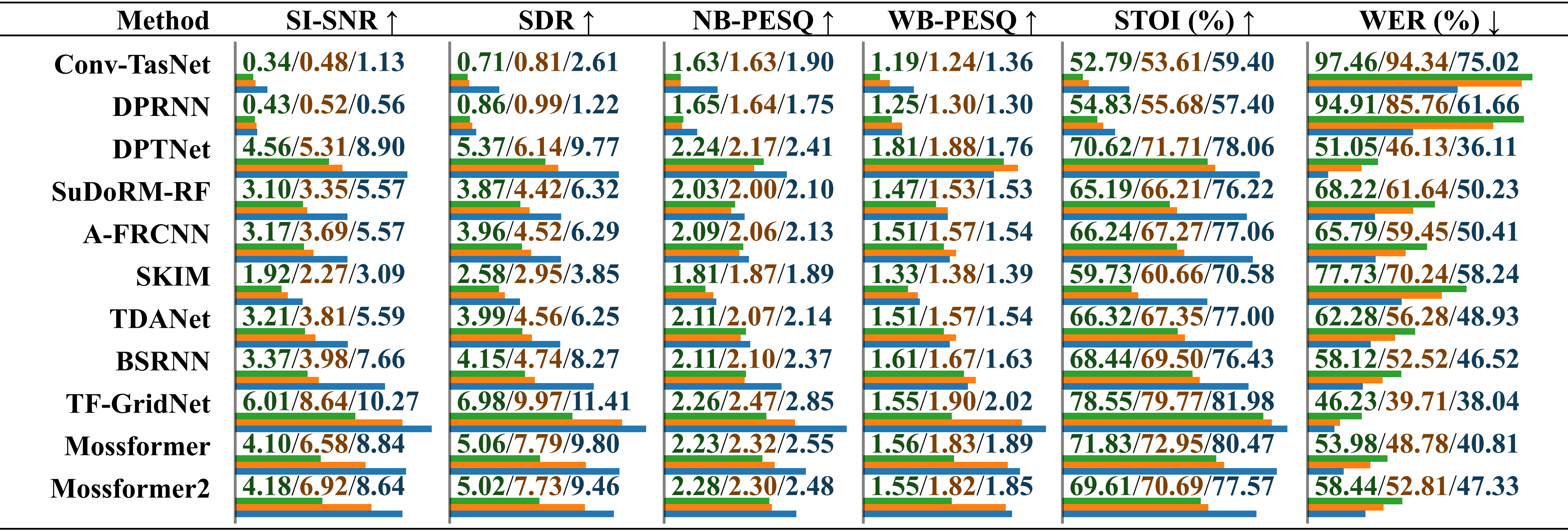

Avaliação comparativa de desempenho de modelos treinados em diferentes conjuntos de dados usando áudio gravado real com ruído ambiental . Os resultados são relatados separadamente para “treinado em LRS2-2Mix”, “treinado em Libri2Mix” e “treinado em SonicSet”, diferenciados por uma barra. O comprimento relativo é indicado abaixo do valor por barras horizontais.

Avaliação comparativa de desempenho de modelos treinados em diferentes conjuntos de dados usando áudio gravado real com ruído musical . Os resultados são relatados separadamente para “treinado em LRS2-2Mix”, “treinado em Libri2Mix” e “treinado em SonicSet”, diferenciados por uma barra.

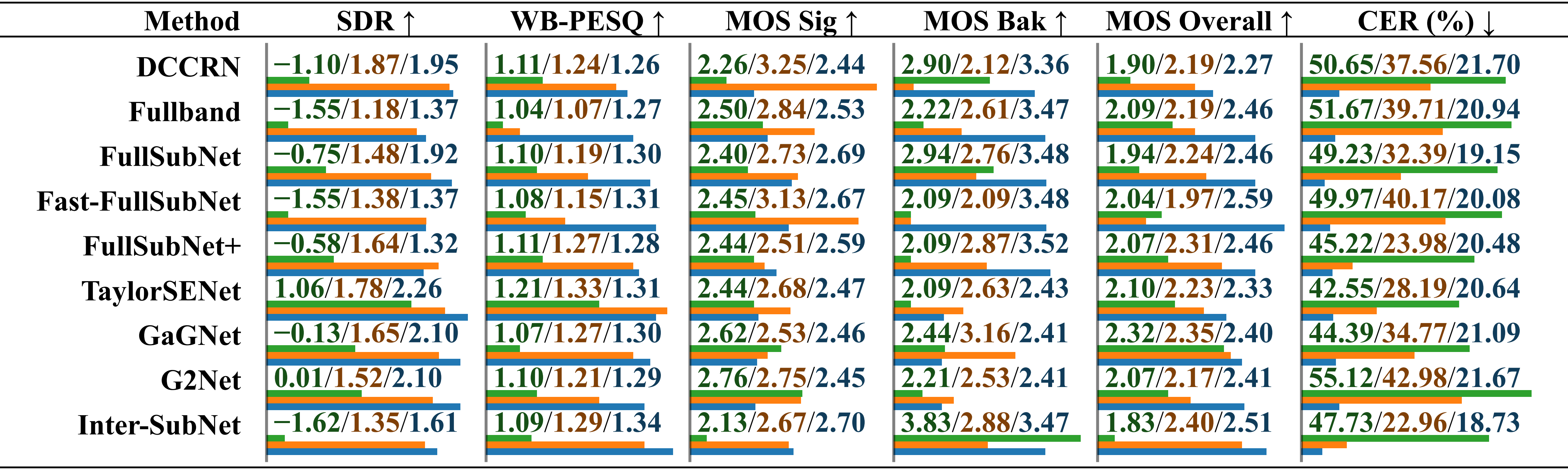

Avaliação comparativa de desempenho de modelos treinados em diferentes conjuntos de dados usando o conjunto de dados RealMAN. Os resultados são relatados separadamente para “treinado em VoiceBank+DEMAND”, “treinado em DNS Challenge” e “treinado em SonicSet”, diferenciados por uma barra.

Treinamos modelos de separação e aprimoramento no conjunto de dados SonicSet. Os resultados são os seguintes:

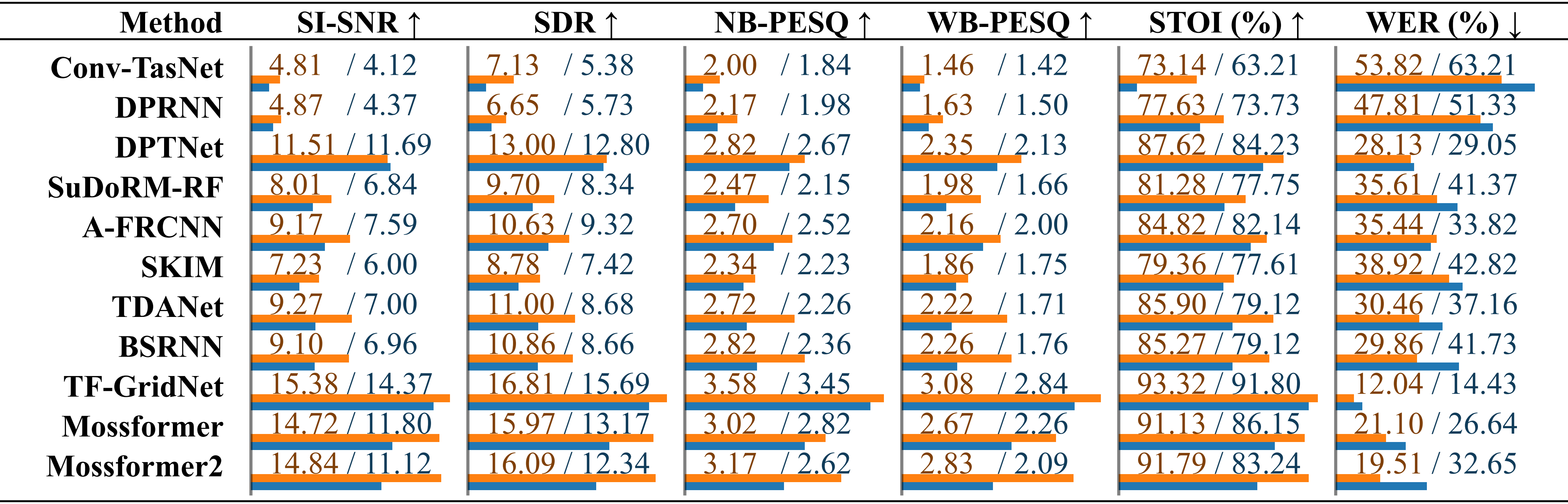

Comparação de métodos de separação de fala existentes no conjunto de dados SonicSet. O desempenho de cada modelo é listado separadamente para resultados em “ruído ambiental” e “ruído musical”, diferenciados por uma barra.

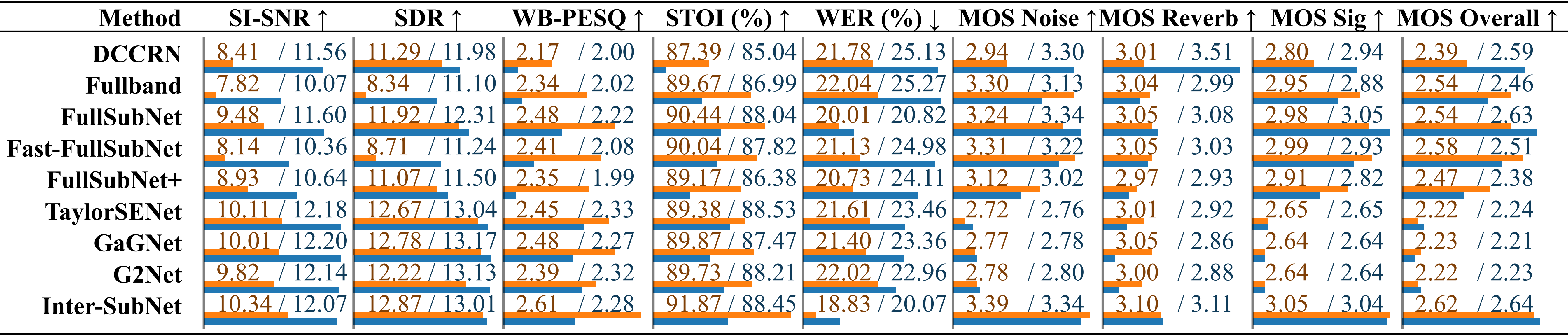

Comparação de métodos de aprimoramento de fala existentes noComparação de métodos de aprimoramento de fala usando o conjunto de testes SonicSet. As métricas são listadas separadamente em “ruído ambiental” e “ruído musical”, diferenciados por uma barra.

Gostaríamos de expressar nossa gratidão aos seguintes:

LibriSpeech por fornecer os dados de fala.

SoundSpaces para o ambiente de simulação.

Apple por fornecer scripts de síntese de áudio dinâmico.

Este trabalho está licenciado sob uma Licença Internacional Creative Commons Attribution-ShareAlike 4.0.