· Papel · Benchmark · Homepage · Documento ·

✅ [2024/07/25] Visual PEFT Benchmark começa a liberar conjunto de dados, código, etc.

✅ [2024/06/20] A página inicial do Visual PEFT Benchmark foi criada.

✅ [2024/06/01] O repositório Visual PEFT Benchmark é criado.

Introdução

Começando

Estrutura de código

Início rápido

Resultados e pontos de verificação

Comunidade e contato

Citação

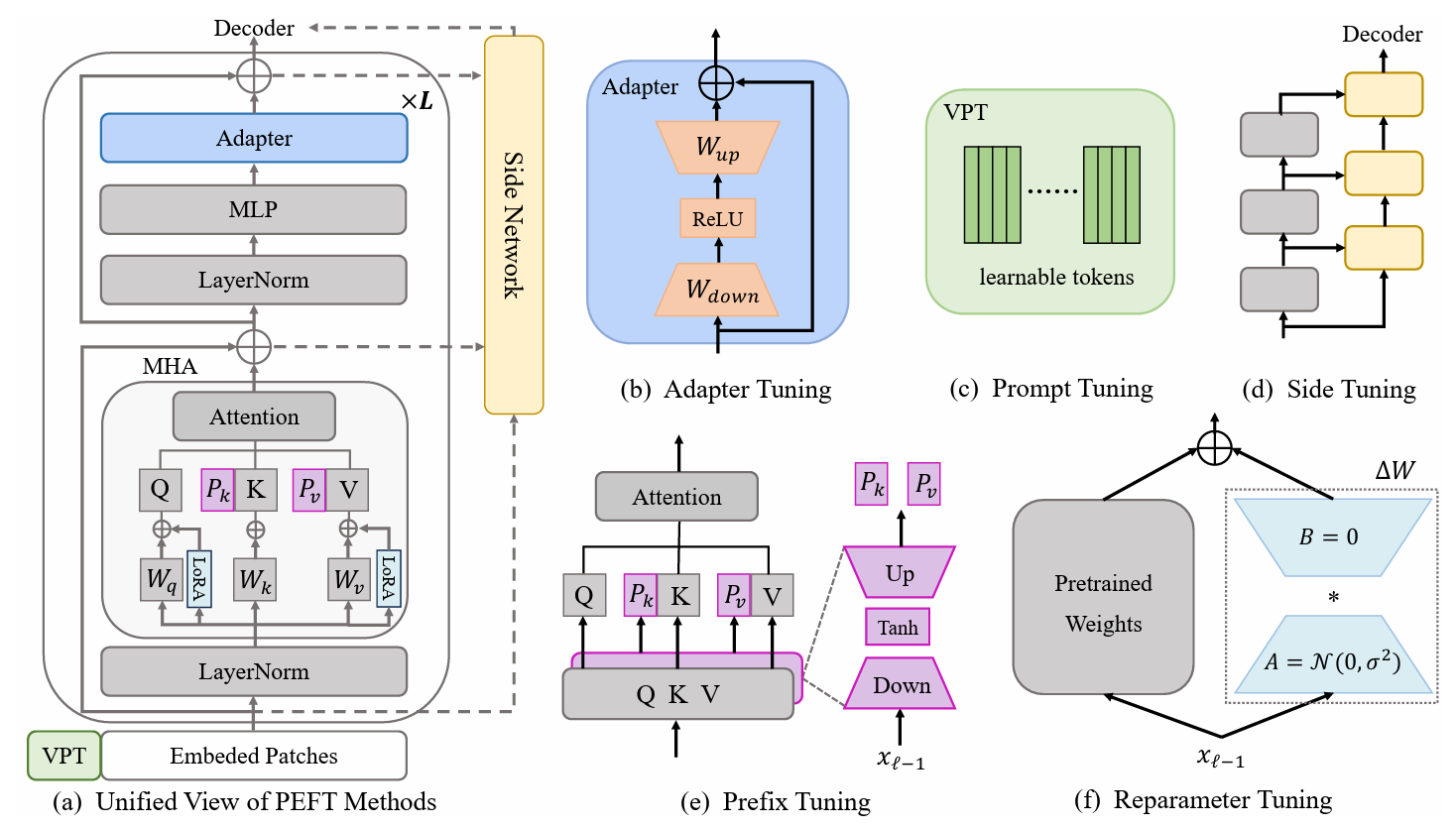

Os métodos de aprendizagem por transferência com eficiência de parâmetros (PETL) mostram-se promissores na adaptação de um modelo pré-treinado a várias tarefas posteriores, enquanto treina apenas alguns parâmetros. No domínio da visão computacional (CV), numerosos algoritmos PETL foram propostos, mas seu emprego direto ou comparação permanece inconveniente. Para enfrentar esse desafio, construímos um benchmark PETL visual unificado (V-PETL Bench) para o domínio CV, selecionando 30 conjuntos de dados diversos, desafiadores e abrangentes de reconhecimento de imagem, reconhecimento de ação de vídeo e tarefas densas de previsão . Nesses conjuntos de dados, avaliamos sistematicamente 25 algoritmos PETL dominantes e abrimos uma base de código modular e extensível para uma avaliação justa desses algoritmos.

Tarefas de classificação visual refinada (FGVC)

O FGVC compreende 5 conjuntos de dados de classificação visual refinados. Os conjuntos de dados podem ser baixados seguindo os links oficiais. Dividimos os dados de treinamento se o conjunto de validação público não estiver disponível. O conjunto de dados dividido pode ser encontrado aqui: Link para download.

CUB200 2011

NABirds

Flores Oxford

Cães de Stanford

Carros de Stanford

Referência de adaptação de tarefas visuais (VTAB)

O VTAB compreende 19 conjuntos de dados de classificação visual diversos. Processamos todo o conjunto de dados e os dados podem ser baixados aqui: Link para download. Para procedimentos e dicas de processamento específicos, consulte VTAB_SETUP.

Cinética-400

Baixe o conjunto de dados em Download Link ou Download Link.

Pré-processe o conjunto de dados redimensionando a borda curta do vídeo para 320px . Você pode consultar o benchmark de dados MMAction2.

Gere anotações necessárias para o dataloader ("<video_id> <video_class>" nas anotações). A anotação geralmente inclui train.csv , val.csv e test.csv . O formato do arquivo *.csv é semelhante a:

video_1.mp4 label_1 video_2.mp4 label_2 video_3.mp4 label_3 ... video_N.mp4 label_N

Algo-Algo V2 (SSv2)

Baixe o conjunto de dados no link de download.

Pré-processe o conjunto de dados alterando a extensão do vídeo de webm para .mp4 com a altura original de 240px . Você pode consultar o benchmark de dados MMAction2.

Gere anotações necessárias para o dataloader ("<video_id> <video_class>" nas anotações). A anotação geralmente inclui train.csv , val.csv e test.csv . O formato do arquivo *.csv é semelhante a:

video_1.mp4 label_1 video_2.mp4 label_2 video_3.mp4 label_3 ... video_N.mp4 label_N

MS-COCO

MS-COCO estão disponíveis neste link de download.

ADE20K

O conjunto de treinamento e validação do ADE20K pode ser baixado neste link de download. Também podemos baixar o conjunto de testes no link de download.

PASCAL VOC

Pascal VOC 2012 pode ser baixado no link de download. Além disso, os trabalhos mais recentes no conjunto de dados Pascal VOC geralmente exploram dados extras de aumento, que podem ser encontrados no link de download.

Baixe e coloque o modelo pré-treinado ViT-B/16 em /path/to/pretrained_models .

mkdir pretrained_models wget https://storage.googleapis.com/vit_models/imagenet21k/ViT-B_16.npz

ou você pode baixar o modelo pré-treinado Swin-B. Observe que você também precisa renomear o ckpt Swin-B baixado de swin_base_patch4_window7_224_22k.pth para Swin-B_16.pth .

mkdir pretrained_models wget https://github.com/SwinTransformer/storage/releases/download/v1.0.0/swin_base_patch4_window7_224_22k.pth mv swin_base_patch4_window7_224_22k.pth Swin_B_16.pth

Outra maneira é baixar modelos pré-treinados no link abaixo e colocá-los em /path/to/pretrained_models .

| Backbone pré-treinado | Objetivo pré-treinado | Conjunto de dados pré-treinado | Ponto de verificação |

|---|---|---|---|

| ViT-B/16 | Supervisionado | ImageNet-21K | Link para baixar |

| ViT-L/16 | Supervisionado | ImageNet-21K | Link para baixar |

| ViT-H/16 | Supervisionado | ImageNet-21K | Link para baixar |

| Swin-B | Supervisionado | ImageNet-22K | Link para baixar |

| Swin-L | Supervisionado | ImageNet-22K | Link para baixar |

| ViT-B (VídeoMAE) | Auto-supervisionado | Cinética-400 | Link para baixar |

| Vídeo Swin-B | Supervisionado | Cinética-400 | Link para baixar |

ImageClassification/configs : lida com parâmetros de configuração para os experimentos.

ImageClassification/config/vtab/cifar100.yaml : configurações principais para experimentos e explicação para cada conjunto de dados.

.....

ImageClassification/dataloader : carregamento e configuração de conjuntos de dados de entrada.

ImageClassification/dataloader/transforms : Transformações de imagem.

ImageClassification/dataloader/loader : Constrói o carregador de dados para o conjunto de dados fornecido.

ImageClassification/models : lida com arcos e cabeças de backbone para diferentes protocolos de ajuste fino

ImageClassification/models/vision_transformer_adapter.py : uma pasta contém os mesmos backbones na pasta vit_backbones , especificada para Adapter.

ImageClassification/models/vision_transformer_sct.py : uma pasta contém os mesmos backbones na pasta vit_backbones , especificada para SCT.

.....

ImageClassification/train : uma pasta contém a pasta training file ,

ImageClassification/train/train_model_adapter.py : chame este para treinar e avaliar um modelo com um tipo de transferência especificado, especificado para Adaptador.

ImageClassification/train/train_model_sct.py : chame este para treinar e avaliar um modelo com um tipo de transferência especificado, especificado para SCT.

.....

ImageClassification/scripts : uma pasta contém a pasta de scripts file ,

ImageClassification/scripts/run_vit_adapter.sh : você pode executar o método Adapter em todos os conjuntos de dados de uma vez.

ImageClassification/scripts/run_vit_sct.sh : você pode executar o método Adapter em todos os conjuntos de dados de uma vez.

.....

ImageClassification/Visualize : Ferramentas de visualização.

ImageClassification/Visualize/AttentionMap.py : Visualização do mapa de atenção.

ImageClassification/Visualize/TSNE.py : visualização T-SNE.

ImageClassification/utils : Criar registrador, Definir semente, etc.

❗️Nota❗️: Se você deseja criar seu próprio algoritmo PETL, preste atenção em `ImageClassification/models`.

Este é um exemplo de como configurar o V-PETL Bench localmente.

Para obter uma cópia local, siga estas etapas simples de exemplo.

clone do git https://github.com/synbol/Parameter-Efficient-Transfer-Learning-Benchmark.git

O banco V-PETL é construído em pytorch, com torchvision, torchaudio e timm, etc.

Para instalar os pacotes necessários, você pode criar um ambiente conda.

conda criar --nome v-petl-bench python=3.8

Ative o ambiente conda.

conda ativar v-petl-bench

Use pip para instalar os pacotes necessários.

cd Parâmetro-Eficiente-Transferência-Aprendizagem-Benchmark pip instalar -r requisitos.txt

Fornecemos uma demonstração específica de treinamento e avaliação, tomando como exemplo LoRA no VTAB Cifar100.

sistema de importação

sys.path.append("Parâmetro-Efficient-Transfer-Learning-Benchmark")

importar tocha

dos utilitários de importação ImageClassification

de ImageClassification.dataloader importar vtab

de ImageClassification.train importar trem# obter métodos lora de timm.scheduler.cosine_lr importar CosineLRScheduler

de ImageClassification.models importar vision_transformer_lora

importar timm# caminho para salvar o modelo e logsexp_base_path = '../output'utils.mkdirss(exp_base_path)# create loggerlogger = utils.create_logger(log_path=exp_base_path, log_name='training')# dataset config parâmetroconfig = utils.get_config(' model_lora', 'vtab', 'cifar100')# obter vtab datasetdata_path = '/home/ma-user/work/haozhe/synbol/vtab-1k'train_dl, test_dl = vtab.get_data(data_path, 'cifar100', logger, avaliar=Falso, train_aug=config['train_aug'], batch_size =config['batch_size'])# obter modelo pré-treinadomodel = timm.models.create_model('vit_base_patch16_224_in21k_lora', checkpoint_path='./released_models/ViT-B_16.npz', drop_path_rate=0.1, tuning_mode='lora')

model.reset_classifier(config['class_num'])# parâmetros de treinamentotrainable = []for n, p in model.named_parameters(): se 'linear_a' em n ou 'linear_b' em n ou 'head' em n:

treinável.append(p)

logger.info(str(n))

outro:

p.requires_grad = Falso

opt = torch.optim.AdamW(treinável, lr=1e-4, peso_decay=5e-2)

agendador = CosineLRScheduler(opt, t_initial=config['epochs'], warmup_t=config['warmup_epochs'], lr_min=1e-5, warmup_lr_init=1e-6, cycle_decay = 0.1)# crossEntropyLoss functioncriterion = torch.nn.CrossEntropyLoss( )#modelodetreinamento = train.train(config, modelo, critério, train_dl, opt, agendador, logger, config['épocas'], 'vtab', 'cifar100')# avaliaçãoeval_acc = train.test(model, test_dl, 'vtab')Você pode treinar com um algoritmo PETL em um conjunto de dados.

python python train/train_model_sct.py --dataset cifar100 --task vtab --lr 0.012 --wd 0.6 --eval True --dpr 0.1 --tuning_mode $tuning_mode --model_type $model_type --model $model --model_checkpoint $ modelo_ponto de verificação

ou você pode treinar com um algoritmo PETL em todos os conjuntos de dados

scripts bash/run_model_sct.sh

Avaliamos 13 algoritmos PETL em cinco conjuntos de dados com modelos ViT-B/16 pré-treinados em ImageNet-21K.

Para obter o ponto de verificação, faça o download no link de download.

| Método | CUB-200-2011 | NABirds | Flores Oxford | Cães de Stanford | Carros de Stanford | Significar | Parâmetros. | PPT |

|---|---|---|---|---|---|---|---|---|

| Ajuste fino completo | 87,3 | 82,7 | 98,8 | 89,4 | 84,5 | 88,54 | 85,8 milhões | - |

| Sondagem linear | 85,3 | 75,9 | 97,9 | 86,2 | 51.3 | 79,32 | 0 milhões | 0,79 |

| Adaptador | 87,1 | 84,3 | 98,5 | 89,8 | 68,6 | 85,66 | 0,41 milhões | 0,84 |

| AdaptFormer | 88,4 | 84,7 | 99,2 | 88,2 | 81,9 | 88,48 | 0,46 milhões | 0,87 |

| Ajuste de prefixo | 87,5 | 82,0 | 98,0 | 74,2 | 90,2 | 86,38 | 0,36 milhões | 0,85 |

| U-ajuste | 89,2 | 85,4 | 99,2 | 84,1 | 92,1 | 90,00 | 0,36 milhões | 0,89 |

| BitFit | 87,7 | 85,2 | 99,2 | 86,5 | 81,5 | 88.02 | 0,10 milhões | 0,88 |

| VPT-raso | 86,7 | 78,8 | 98,4 | 90,7 | 68,7 | 84,66 | 0,25 milhões | 0,84 |

| VPT profundo | 88,5 | 84,2 | 99,0 | 90,2 | 83,6 | 89,10 | 0,85 milhões | 0,86 |

| SSF | 89,5 | 85,7 | 99,6 | 89,6 | 89,2 | 90,72 | 0,39 milhões | 0,89 |

| LoRA | 85,6 | 79,8 | 98,9 | 87,6 | 72,0 | 84,78 | 0,77 milhões | 0,82 |

| GPS | 89,9 | 86,7 | 99,7 | 92,2 | 90,4 | 91,78 | 0,66 milhões | 0,90 |

| TGV | 89,2 | 85,8 | 99,6 | 89,5 | 88,2 | 90,46 | 0,78 milhões | 0,88 |

| DURAR | 88,5 | 84,4 | 99,7 | 86,0 | 88,9 | 89,50 | 0,66 milhões | 0,87 |

| SNF | 90,2 | 87,4 | 99,7 | 89,5 | 86,9 | 90,74 | 0,25 milhões | 0,90 |

Resultados de referência no VTAB. Avaliamos 18 algoritmos PETL em 19 conjuntos de dados com modelos ViT-B/16 pré-treinados em ImageNet-21K.

Para obter o ponto de verificação, faça o download no link de download.

| Método | CIFAR-100 | Caltech101 | DTD | Flores102 | Animais de estimação | SVHN | Dom397 | Patch Camelyon | EuroSAT | Resisc45 | Retinopatia | Clevr/contagem | Nível/distância | DMLab | KITTI/distância | dSprites/loc | dSprites/ori | PequenoNORB/azi | PequenoNORB/ele | Significar | Parâmetros. | PPT |

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| Ajuste fino completo | 68,9 | 87,7 | 64,3 | 97,2 | 86,9 | 87,4 | 38,8 | 79,7 | 95,7 | 84,2 | 73,9 | 56,3 | 58,6 | 41,7 | 65,5 | 57,5 | 46,7 | 25,7 | 29.1 | 65,57 | 85,8 milhões | - |

| Sondagem linear | 63,4 | 85,0 | 63,2 | 97,0 | 86,3 | 36,6 | 51,0 | 78,5 | 87,5 | 68,6 | 74,0 | 34,3 | 30,6 | 33.2 | 55,4 | 12,5 | 20,0 | 9.6 | 19.2 | 52,94 | 0M | 0,53 |

| Adaptador | 69,2 | 90,1 | 68,0 | 98,8 | 89,9 | 82,8 | 54,3 | 84,0 | 94,9 | 81,9 | 75,5 | 80,9 | 65,3 | 48,6 | 78,3 | 74,8 | 48,5 | 29,9 | 41,6 | 71,44 | 0,16 milhões | 0,71 |

| VPT-raso | 77,7 | 86,9 | 62,6 | 97,5 | 87,3 | 74,5 | 51.2 | 78,2 | 92,0 | 75,6 | 72,9 | 50,5 | 58,6 | 40,5 | 67,1 | 68,7 | 36,1 | 20.2 | 34.1 | 64,85 | 0,08 milhões | 0,65 |

| VPT profundo | 78,8 | 90,8 | 65,8 | 98,0 | 88,3 | 78,1 | 49,6 | 81,8 | 96,1 | 83,4 | 68,4 | 68,5 | 60,0 | 46,5 | 72,8 | 73,6 | 47,9 | 32,9 | 37,8 | 69,43 | 0,56 milhões | 0,68 |

| BitFit | 72,8 | 87,0 | 59,2 | 97,5 | 85,3 | 59,9 | 51,4 | 78,7 | 91,6 | 72,9 | 69,8 | 61,5 | 55,6 | 32,4 | 55,9 | 66,6 | 40,0 | 15,7 | 25.1 | 62.05 | 0,10 milhões | 0,61 |

| LoRA | 67,1 | 91,4 | 69,4 | 98,8 | 90,4 | 85,3 | 54,0 | 84,9 | 95,3 | 84,4 | 73,6 | 82,9 | 69,2 | 49,8 | 78,5 | 75,7 | 47,1 | 31,0 | 44,0 | 72,25 | 0,29 milhões | 0,71 |

| AdaptFormer | 70,8 | 91,2 | 70,5 | 99,1 | 90,9 | 86,6 | 54,8 | 83,0 | 95,8 | 84,4 | 76,3 | 81,9 | 64,3 | 49,3 | 80,3 | 76,3 | 45,7 | 31,7 | 41.1 | 72,32 | 0,16 milhões | 0,72 |

| SSF | 69,0 | 92,6 | 75,1 | 99,4 | 91,8 | 90,2 | 52,9 | 87,4 | 95,9 | 87,4 | 75,5 | 75,9 | 62,3 | 53,3 | 80,6 | 77,3 | 54,9 | 29,5 | 37,9 | 73,10 | 0,21 milhões | 0,72 |

| NOÉ | 69,6 | 92,7 | 70,2 | 99,1 | 90,4 | 86,1 | 53,7 | 84,4 | 95,4 | 83,9 | 75,8 | 82,8 | 68,9 | 49,9 | 81,7 | 81,8 | 48,3 | 32,8 | 44,2 | 73,25 | 0,43 milhões | 0,72 |

| SCT | 75,3 | 91,6 | 72,2 | 99,2 | 91,1 | 91,2 | 55,0 | 85,0 | 96,1 | 86,3 | 76,2 | 81,5 | 65,1 | 51,7 | 80,2 | 75,4 | 46,2 | 33.2 | 45,7 | 73,59 | 0,11 milhões | 0,73 |

| Fato | 70,6 | 90,6 | 70,8 | 99,1 | 90,7 | 88,6 | 54.1 | 84,8 | 96,2 | 84,5 | 75,7 | 82,6 | 68,2 | 49,8 | 80,7 | 80,8 | 47,4 | 33.2 | 43,0 | 73,23 | 0,07 milhões | 0,73 |

| RepAdapter | 72,4 | 91,6 | 71,0 | 99,2 | 91,4 | 90,7 | 55.1 | 85,3 | 95,9 | 84,6 | 75,9 | 82,3 | 68,0 | 50,4 | 79,9 | 80,4 | 49,2 | 38,6 | 41,0 | 73,84 | 0,22 milhões | 0,72 |

| Hidra | 72,7 | 91,3 | 72,0 | 99,2 | 91,4 | 90,7 | 55,5 | 85,8 | 96,0 | 86,1 | 75,9 | 83,2 | 68,2 | 50,9 | 82,3 | 80,3 | 50,8 | 34,5 | 43,1 | 74,21 | 0,28 milhões | 0,73 |

| LST | 59,5 | 91,5 | 69,0 | 99,2 | 89,9 | 79,5 | 54,6 | 86,9 | 95,9 | 85,3 | 74,1 | 81,8 | 61,8 | 52.2 | 81,0 | 71,7 | 49,5 | 33,7 | 45,2 | 71,70 | 2,38 milhões | 0,65 |

| DTL | 69,6 | 94,8 | 71,3 | 99,3 | 91,3 | 83,3 | 56,2 | 87,1 | 96,2 | 86,1 | 75,0 | 82,8 | 64,2 | 48,8 | 81,9 | 93,9 | 53,9 | 34,2 | 47,1 | 74,58 | 0,04 milhões | 0,75 |

| TGV | 76,7 | 94,1 | 74,8 | 99,6 | 91,1 | 91,2 | 52,3 | 87,1 | 96,3 | 88,6 | 76,5 | 85,4 | 63,7 | 52,9 | 81,7 | 87,2 | 56,8 | 35,8 | 52.1 | 75,99 | 0,78 milhões | 0,74 |

| GPS | 81,1 | 94,2 | 75,8 | 99,4 | 91,7 | 91,6 | 52,4 | 87,9 | 96,2 | 86,5 | 76,5 | 79,9 | 62,6 | 55,0 | 82,4 | 84,0 | 55,4 | 29,7 | 46,1 | 75,18 | 0,22 milhões | 0,74 |

| DURAR | 66,7 | 93,4 | 76,1 | 99,6 | 89,8 | 86,1 | 54,3 | 86,2 | 96,3 | 86,8 | 75,4 | 81,9 | 65,9 | 49,4 | 82,6 | 87,9 | 46,7 | 32,3 | 51,5 | 74,15 | 0,66 milhões | 0,72 |

| SNF | 84,0 | 94,0 | 72,7 | 99,3 | 91,3 | 90,3 | 54,9 | 87,2 | 97,3 | 85,5 | 74,5 | 82,3 | 63,8 | 49,8 | 82,5 | 75,8 | 49,2 | 31.4 | 42.1 | 74,10 | 0,25 milhões | 0,73 |

Resultados de benchmark em SSv2 e HMDB51. Avaliamos 5 algoritmos PETL com ViT-B do VideoMAE e Video Swin Transformer.

Para obter o ponto de verificação, faça o download no link de download.

| Método | Modelo | Pré-treino | Parâmetros. | SSv2 (Principal1) | SSv2 (PPT) | HMDB51 (Top1) | HMDB51 (PPT) |

|---|---|---|---|---|---|---|---|

| Ajuste fino completo | ViT-B | Cinética 400 | 85,97 milhões | 53,97% | - | 46,41% | - |

| Congelado | ViT-B | Cinética 400 | 0 milhões | 29,23% | 0,29 | 49,84% | 0,50 |

| AdaptFormer | ViT-B | Cinética 400 | 1,19 milhões | 59,02% | 0,56 | 55,69% | 0,53 |

| BAPAT | ViT-B | Cinética 400 | 2,06 milhões | 57,78% | 0,53 | 57,18% | 0,53 |

| Ajuste fino completo | Vídeo Swin-B | Cinética 400 | 87,64 milhões | 50,99% | - | 68,07% | - |

| Congelado | Vídeo Swin-B | Cinética 400 | 0 milhões | 24,13% | 0,24 | 71,28% | 0,71 |

| LoRA | Vídeo Swin-B | Cinética 400 | 0,75M | 38,34% | 0,37 | 62,12% | 0,60 |

| BitFit | Vídeo Swin-B | Cinética 400 | 1,09 milhões | 45,94% | 0,44 | 68,26% | 0,65 |

| AdaptFormer | Vídeo Swin-B | Cinética 400 | 1,56 milhões | 40,80% | 0,38 | 68,66% | 0,64 |

| Ajuste de prefixo | Vídeo Swin-B | Cinética 400 | 6,37 milhões | 39,46% | 0,32 | 56,13% | 0,45 |

| BAPAT | Vídeo Swin-B | Cinética 400 | 6,18 milhões | 53,36% | 0,43 | 71,93% | 0,58 |

Resultados de referência em COCO. Avaliamos 9 algoritmos PETL com modelos Swin-B pré-treinados em ImageNet-22K.

Para obter o ponto de verificação, faça o download em Em breve.

| Swin-B | Parâmetros. | Memória | COCO ( | COCO (PPT) | COCO ( | COCO (PPT) |

|---|---|---|---|---|---|---|

| Ajuste fino completo | 86,75 milhões | 17.061MB | 51,9% | - | 45,0% | - |

| Congelado | 0,00M | 7.137MB | 43,5% | 0,44 | 38,6% | 0,39 |

| Bitfit | 0,20 M | 13.657MB | 47,9% | 0,47 | 41,9% | 0,42 |

| SINTONIA LN | 0,06 M | 12.831MB | 48,0% | 0,48 | 41,4% | 0,41 |

| Parcial-1 | 12,60 milhões | 7.301MB | 49,2% | 0,35 | 42,8% | 0h30 |

| Adaptador | 3,11 milhões | 12.557MB | 50,9% | 0,45 | 43,8% | 0,39 |

| LoRA | 3,03 milhões | 11.975MB | 51,2% | 0,46 | 44,3% | 0,40 |

| AdaptFormer | 3,11 milhões | 13.186MB | 51,4% | 0,46 | 44,5% | 0,40 |

| Lo Rand | 1,20 milhões | 13.598MB | 51,0% | 0,49 | 43,9% | 0,42 |

| E$^3$VA | 1,20 milhões | 7.639MB | 50,5% | 0,48 | 43,8% | 0,42 |

| Mona | 4,16 milhões | 13.996 MB | 53,4% | 0,46 | 46,0% | 0,40 |

Resultados de referência em PASCAL VOC e ADE20K. Avaliamos 9 algoritmos PETL com modelos Swin-L pré-treinados em ImageNet-22K.

Para obter o ponto de verificação, faça o download em Em breve.

| Swin-L | Parâmetros. | Memória (VOC) | Pascal VOC ( | Pascal COV (PPT) | ADE20K ( | ADE20K (PPT) |

|---|---|---|---|---|---|---|

| Ajuste fino completo | 198,58 milhões | 15.679MB | 83,5% | - | 52,10% | - |

| Congelado | 0,00M | 3.967MB | 83,6% | 0,84 | 46,84% | 0,47 |

| Bitfit | 0,30M | 10.861MB | 85,7% | 0,85 | 48,37% | 0,48 |

| SINTONIA LN | 0,09M | 10.123MB | 85,8% | 0,86 | 47,98% | 0,48 |

| Parcial-1 | 28,34 milhões | 3.943 MB | 85,4% | 0,48 | 47,44% | 0,27 |

| Adaptador | 4,66 milhões | 10.793MB | 87,1% | 0,74 | 50,78% | 0,43 |

| LoRA | 4,57 milhões | 10.127MB | 87,5% | 0,74 | 50,34% | 0,43 |

| AdaptFormer | 4,66 milhões | 11.036MB | 87,3% | 0,74 | 50,83% | 0,43 |

| Lo Rand | 1,31 milhões | 11.572MB | 86,8% | 0,82 | 50,76% | 0,48 |

| E$^3$VA | 1,79 milhões | 4.819MB | 86,5% | 0,81 | 49,64% | 0,46 |

| Mona | 5,08 milhões | 11.958MB | 87,3% | 0,73 | 51,36% | 0,43 |

A comunidade V-PETL Bench é mantida por:

Yi Xin ([email protected]), Universidade de Nanjing.

Siqi Luo ([email protected]), Universidade Jiao Tong de Xangai.

Se você achar nossa pesquisa e repositório úteis para sua pesquisa, cite-os abaixo:

@artigo{xin2024bench, título={V-PETL Bench: um benchmark de aprendizagem de transferência eficiente em parâmetros visuais unificados}, autor={Yi Xin, Siqi Luo, Xuyang Liu, Haodi Zhou, Xinyu Cheng, Christina Luoluo Lee, Junlong Du, Yuntao Du., Haozhe Wang, MingCai Chen, Ting Liu, Guimin Hu, Zhongwei Wan, Rongchao Zhang, Aoxue Li, Mingyang Yi, Xiaohong Liu}, ano={2024}}