Clone este repositório no Your ComfyUI root directoryComfyUIcustom_nodes e instale pacotes Python dependentes:

cd Seu_ComfyUI_root_directoryComfyUIcustom_nodes clone do git https://github.com/Bin-sam/DynamicPose-ComfyUI.git pip instalar -r requisitos.txt

Baixe modelos pré-treinados:

./pretrained_weights/

|-- denoising_unet.pth

|-- motion_module.pth

|-- pose_guider.pth

|-- reference_unet.pth

|-- rtmpose

| |-- rtmw-x_simcc-cocktail14_pt-ucoco_270e-384x288-f840f204_20231122.pth

| |-- rtmw-x_8xb320-270e_cocktail14-384x288.py

| |-- rtmdet_m_640-8xb32_coco-person.py

| |-- rtmdet_m_8xb32-100e_coco-obj365-person-235e8209.pth

| |-- rtmpose-x_8xb256-700e_coco-384x288.py

| |-- rtmpose-x_simcc-body7_pt-body7_700e-384x288-71d7b7e9_20230629.pth

|-- DWPose

| |-- dw-ll_ucoco_384.onnx

| |-- yolox_l.onnx Baixe o codificador de imagem do clipe (por exemplo, sd-image-variations-diffusers) e coloque-o em Your_ComfyUI_root_directoryComfyUImodelsclip_vision

Baixe vae (por exemplo, sd-vae-ft-mse) e coloque-o em Your_ComfyUI_root_directoryComfyUImodelsvae

Baixe stable-diffusion-v1-5 (por exemplo, stable-diffusion-v1-5) e coloque-o em Your_ComfyUI_root_directoryComfyUImodelsdiffusers

difusão estável-v1-5_unet

Modelos pré-treinados Moore-AnimateAnyone

Os links para download do modelo DWpose estão sob o título "DWPose for ControlNet".

Os modelos acima precisam ser colocados na pasta pretrained_weights conforme segue:

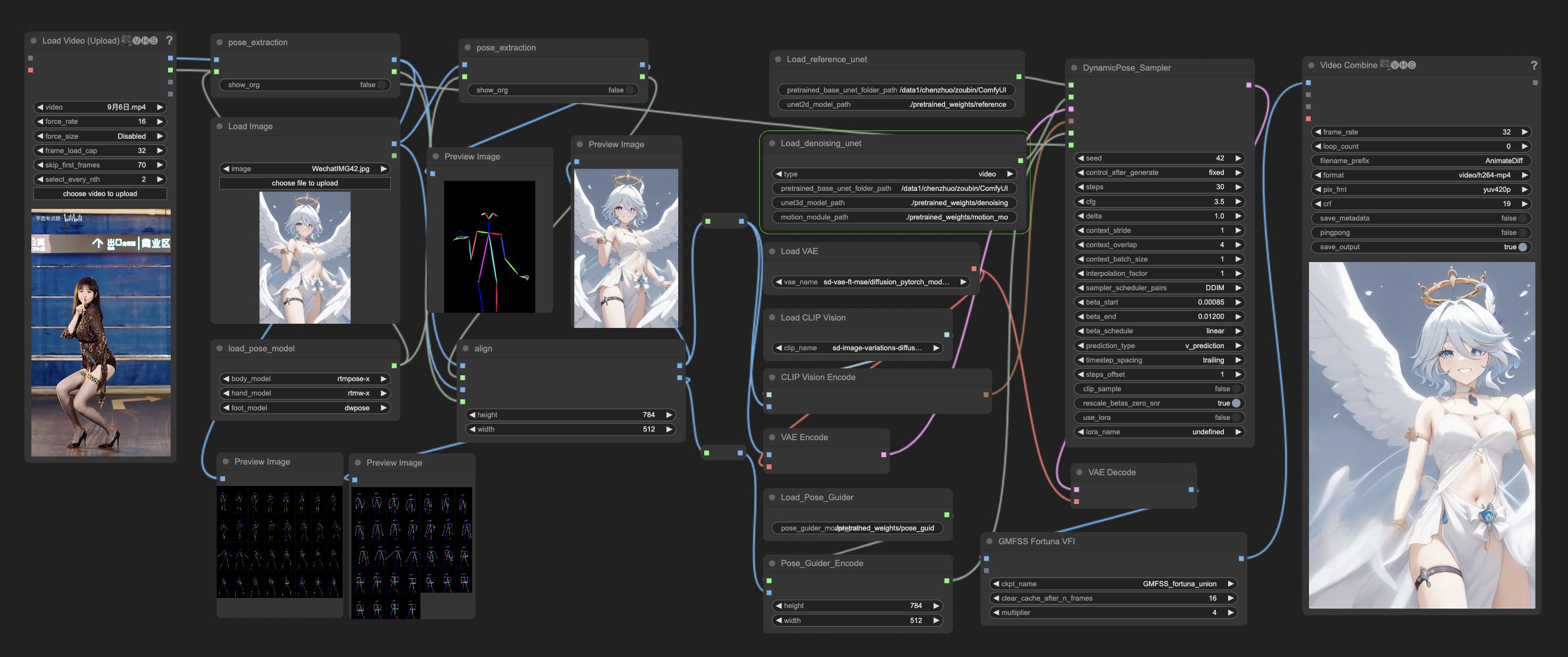

Usando exemplos de pipeline

este fluxo de trabalho é Pose_to_video