Este é um aplicativo de demonstração Swift para modelos SAM 2 Core ML.

SAM 2 (Segment Anything in Images and Videos), é uma coleção de modelos básicos da FAIR que visa resolver a segmentação visual imediata em imagens e vídeos. Consulte o documento SAM 2 para obter mais informações.

Baixe a versão compilada Clique aqui.

Se você preferir compilar você mesmo ou quiser usar um modelo maior, basta baixar o repositório, compilar com o Xcode e executar. O app vem com a versão Small do modelo, mas você pode substituí-la por um dos modelos suportados:

SAM 2.1 minúsculo

SAM 2.1 Pequeno

Base SAM 2.1

SAM 2.1 Grande

Para os modelos mais antigos, verifique a organização da Apple no HuggingFace.

Esta demonstração suporta imagens, o suporte de vídeo virá mais tarde.

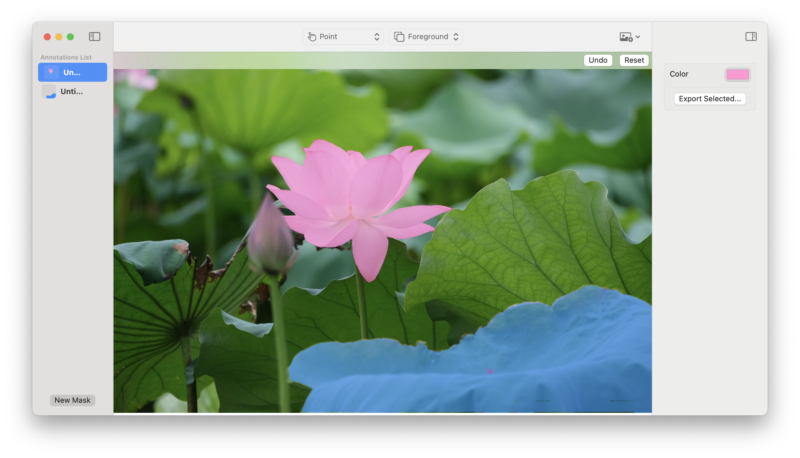

Você pode selecionar um ou mais pontos de primeiro plano para escolher objetos na imagem. Cada ponto adicional é interpretado como um refinamento da máscara anterior.

Use um ponto de fundo para indicar uma área a ser removida da máscara atual.

Você pode usar uma caixa para selecionar uma área aproximada que contém o objeto de seu interesse.

Se quiser usar um modelo ajustado, você pode convertê-lo usando este fork do repositório SAM 2. Por favor, deixe-nos saber para que você o usa!

Feedback, questões e PRs são bem-vindos! Por favor, sinta-se à vontade para entrar em contato.

Para citar o artigo, modelo ou software do SAM 2, use o seguinte:

@article{ravi2024sam2,

title={SAM 2: Segment Anything in Images and Videos},

author={Ravi, Nikhila and Gabeur, Valentin and Hu, Yuan-Ting and Hu, Ronghang and Ryali, Chaitanya and Ma, Tengyu and Khedr, Haitham and R{"a}dle, Roman and Rolland, Chloe and Gustafson, Laura and Mintun, Eric and Pan, Junting and Alwala, Kalyan Vasudev and Carion, Nicolas and Wu, Chao-Yuan and Girshick, Ross and Doll{'a}r, Piotr and Feichtenhofer, Christoph},

journal={arXiv preprint arXiv:2408.00714},

url={https://arxiv.org/abs/2408.00714},

year={2024}

}