中文 | 한국어 | 日本語 | Russo | Alemão | Français | Espanhol | Português | Turquia | Tiếng Việt | العربية

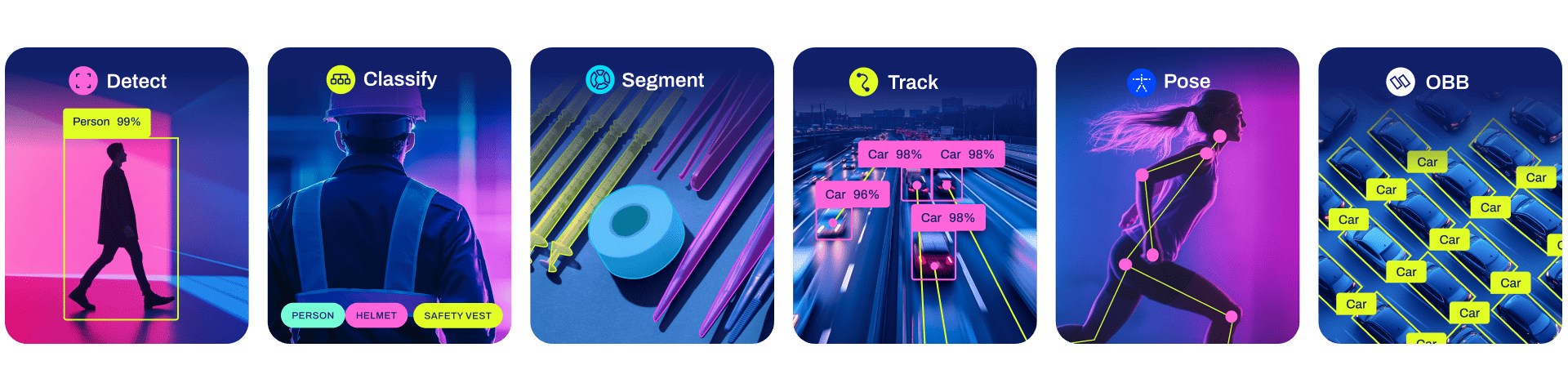

Ultralytics YOLO11 é um modelo de última geração (SOTA) que se baseia no sucesso das versões anteriores do YOLO e introduz novos recursos e melhorias para aumentar ainda mais o desempenho e a flexibilidade. O YOLO11 foi projetado para ser rápido, preciso e fácil de usar, tornando-o uma excelente escolha para uma ampla gama de tarefas de detecção e rastreamento de objetos, segmentação de instâncias, classificação de imagens e estimativa de pose.

Esperamos que os recursos aqui ajudem você a aproveitar ao máximo o YOLO. Navegue pelos documentos do Ultralytics para obter detalhes, levante um problema no GitHub para suporte, perguntas ou discussões, torne-se um membro do Ultralytics Discord, Reddit e Forums!

Para solicitar uma licença empresarial, preencha o formulário em Licenciamento Ultralytics.

Documentação

Veja abaixo exemplos de instalação e uso de início rápido e consulte nossos documentos para obter documentação completa sobre treinamento, validação, previsão e implantação.

Pip instala o pacote ultralytics incluindo todos os requisitos em um ambiente Python>=3.8 com PyTorch>=1.8 .

pip instalar ultralíticos

Para métodos de instalação alternativos, incluindo Conda, Docker e Git, consulte o Guia de início rápido.

YOLO pode ser usado diretamente na interface de linha de comando (CLI) com um comando yolo :

yolo prever modelo=yolo11n.pt source='https://ultralytics.com/images/bus.jpg'

yolo pode ser usado para uma variedade de tarefas e modos e aceita argumentos adicionais, ou seja, imgsz=640 . Consulte os documentos YOLO CLI para obter exemplos.

YOLO também pode ser usado diretamente em um ambiente Python e aceita os mesmos argumentos do exemplo CLI acima:

from ultralytics import YOLO# Carregar um modelomodel = YOLO("yolo11n.pt")# Treinar o modelotrain_results = model.train( data="coco8.yaml", # caminho para o conjunto de dados YAML epochs=100, # número de épocas de treinamento imgsz= 640, # tamanho da imagem de treinamento device="cpu", # dispositivo para execução, ou seja, device=0 ou device=0,1,2,3 ou device=cpu)# Avaliar o desempenho do modelo na validação setmetrics = model.val()# Executar a detecção de objetos em uma imagemresults = model("path/to/image.jpg")results[0].show()# Exportar o modelo para ONNX formatpath = model.export(format="onnx") # caminho de retorno para o modelo exportadoConsulte YOLO Python Docs para obter mais exemplos.

Modelos

Os modelos YOLO11 Detect, Segment e Pose pré-treinados no conjunto de dados COCO estão disponíveis aqui, bem como os modelos YOLO11 Classify pré-treinados no conjunto de dados ImageNet. O modo Track está disponível para todos os modelos Detect, Segment e Pose.

Todos os modelos são baixados automaticamente da versão mais recente do Ultralytics na primeira utilização.

Consulte os documentos de detecção para obter exemplos de uso com esses modelos treinados no COCO, que incluem 80 classes pré-treinadas.

| Modelo | tamanho (pixels) | valor mAP 50-95 | Velocidade CPU ONNX (EM) | Velocidade Tensor T4RT10 (EM) | parâmetros (M) | FLOPs (B) |

|---|---|---|---|---|---|---|

| YOLO11n | 640 | 39,5 | 56,1±0,8 | 1,5±0,0 | 2.6 | 6,5 |

| YOLO11s | 640 | 47,0 | 90,0±1,2 | 2,5±0,0 | 9.4 | 21,5 |

| YOLO11m | 640 | 51,5 | 183,2±2,0 | 4,7±0,1 | 20.1 | 68,0 |

| YOLO11l | 640 | 53,4 | 238,6±1,4 | 6,2±0,1 | 25.3 | 86,9 |

| YOLO11x | 640 | 54,7 | 462,8±6,7 | 11,3±0,2 | 56,9 | 194,9 |

Os valores mAP val são para escala única de modelo único no conjunto de dados COCO val2017.

Reproduzir por yolo val detect data=coco.yaml device=0

Média de velocidade em imagens COCO val usando uma instância P4d do Amazon EC2.

Reproduzir por yolo val detect data=coco.yaml batch=1 device=0|cpu

Consulte os Documentos de Segmentação para obter exemplos de uso com esses modelos treinados no COCO-Seg, que incluem 80 classes pré-treinadas.

| Modelo | tamanho (pixels) | caixa mapa 50-95 | máscara mAP 50-95 | Velocidade CPU ONNX (EM) | Velocidade Tensor T4RT10 (EM) | parâmetros (M) | FLOPs (B) |

|---|---|---|---|---|---|---|---|

| YOLO11n-seg | 640 | 38,9 | 32,0 | 65,9±1,1 | 1,8±0,0 | 2.9 | 10.4 |

| YOLO11s-seg | 640 | 46,6 | 37,8 | 117,6±4,9 | 2,9±0,0 | 10.1 | 35,5 |

| YOLO11m-seg | 640 | 51,5 | 41,5 | 281,6±1,2 | 6,3±0,1 | 22.4 | 123,3 |

| YOLO11l-seg | 640 | 53,4 | 42,9 | 344,2±3,2 | 7,8±0,2 | 27,6 | 142,2 |

| YOLO11x-seg | 640 | 54,7 | 43,8 | 664,5±3,2 | 15,8±0,7 | 62,1 | 319,0 |

Os valores mAP val são para escala única de modelo único no conjunto de dados COCO val2017.

Reproduzir por yolo val segment data=coco-seg.yaml device=0

Média de velocidade em imagens COCO val usando uma instância P4d do Amazon EC2.

Reproduzir por yolo val segment data=coco-seg.yaml batch=1 device=0|cpu

Consulte a documentação de classificação para obter exemplos de uso com esses modelos treinados no ImageNet, que incluem 1.000 classes pré-treinadas.

| Modelo | tamanho (pixels) | conta topo1 | conta cinco principais | Velocidade CPU ONNX (EM) | Velocidade Tensor T4RT10 (EM) | parâmetros (M) | FLOPs (B) em 640 |

|---|---|---|---|---|---|---|---|

| YOLO11n-cls | 224 | 70,0 | 89,4 | 5,0 ± 0,3 | 1,1±0,0 | 1.6 | 3.3 |

| YOLO11s-cls | 224 | 75,4 | 92,7 | 7,9±0,2 | 1,3±0,0 | 5.5 | 12.1 |

| YOLO11m-cls | 224 | 77,3 | 93,9 | 17,2±0,4 | 2,0 ± 0,0 | 10.4 | 39,3 |

| YOLO11l-cls | 224 | 78,3 | 94,3 | 23,2±0,3 | 2,8±0,0 | 12,9 | 49,4 |

| YOLO11x-cls | 224 | 79,5 | 94,9 | 41,4±0,9 | 3,8±0,0 | 28,4 | 110,4 |

os valores acc são precisões do modelo no conjunto de validação do conjunto de dados ImageNet.

Reproduzido por yolo val classify data=path/to/ImageNet device=0

Média de velocidade em imagens ImageNet val usando uma instância P4d do Amazon EC2.

Reproduzir por yolo val classify data=path/to/ImageNet batch=1 device=0|cpu

Consulte Pose Docs para exemplos de uso com esses modelos treinados no COCO-Pose, que incluem 1 turma pré-treinada por pessoa.

| Modelo | tamanho (pixels) | pose do mapa 50-95 | pose do mapa 50 | Velocidade CPU ONNX (EM) | Velocidade Tensor T4RT10 (EM) | parâmetros (M) | FLOPs (B) |

|---|---|---|---|---|---|---|---|

| YOLO11n-pose | 640 | 50,0 | 81,0 | 52,4±0,5 | 1,7±0,0 | 2.9 | 7.6 |

| Pose YOLO11s | 640 | 58,9 | 86,3 | 90,5±0,6 | 2,6±0,0 | 9,9 | 23.2 |

| YOLO11m-pose | 640 | 64,9 | 89,4 | 187,3±0,8 | 4,9±0,1 | 20,9 | 71,7 |

| YOLO11l-pose | 640 | 66,1 | 89,9 | 247,7±1,1 | 6,4±0,1 | 26.2 | 90,7 |

| Pose YOLO11x | 640 | 69,5 | 91,1 | 488,0±13,9 | 12,1±0,2 | 58,8 | 203,3 |

Os valores mAP val são para escala única de modelo único no conjunto de dados COCO Keypoints val2017.

Reproduzir por yolo val pose data=coco-pose.yaml device=0

Média de velocidade em imagens COCO val usando uma instância P4d do Amazon EC2.

Reproduzir por yolo val pose data=coco-pose.yaml batch=1 device=0|cpu

Consulte os documentos OBB para exemplos de uso com esses modelos treinados em DOTAv1, que incluem 15 classes pré-treinadas.

| Modelo | tamanho (pixels) | teste mAP 50 | Velocidade CPU ONNX (EM) | Velocidade Tensor T4RT10 (EM) | parâmetros (M) | FLOPs (B) |

|---|---|---|---|---|---|---|

| YOLO11n-obb | 1024 | 78,4 | 117,6±0,8 | 4,4±0,0 | 2.7 | 17.2 |

| YOLO11s-obb | 1024 | 79,5 | 219,4±4,0 | 5,1±0,0 | 9.7 | 57,5 |

| YOLO11m-obb | 1024 | 80,9 | 562,8±2,9 | 10,1±0,4 | 20,9 | 183,5 |

| YOLO11l-obb | 1024 | 81,0 | 712,5±5,0 | 13,5±0,6 | 26.2 | 232,0 |

| YOLO11x-obb | 1024 | 81,3 | 1408,6±7,7 | 28,6±1,0 | 58,8 | 520,2 |

Os valores de teste mAP são para multiescala de modelo único no conjunto de dados DOTAv1.

Reproduza por yolo val obb data=DOTAv1.yaml device=0 split=test e envie os resultados mesclados para avaliação DOTA.

Média de velocidade em imagens DOTAv1 val usando uma instância P4d do Amazon EC2.

Reproduzir por yolo val obb data=DOTAv1.yaml batch=1 device=0|cpu

Integrações

Nossas principais integrações com as principais plataformas de IA ampliam a funcionalidade das ofertas da Ultralytics, aprimorando tarefas como rotulagem de conjuntos de dados, treinamento, visualização e gerenciamento de modelos. Descubra como o Ultralytics, em colaboração com W&B, Comet, Roboflow e OpenVINO, pode otimizar seu fluxo de trabalho de IA.

![]()

![]()

![]()

| HUB ultralítico? | W&B | Cometa ⭐ NOVO | Magia Neural |

|---|---|---|---|

| Simplifique os fluxos de trabalho YOLO: rotule, treine e implante sem esforço com o Ultralytics HUB. Experimente agora! | Acompanhe experimentos, hiperparâmetros e resultados com pesos e preconceitos | Gratuito para sempre, o Comet permite salvar modelos YOLO11, retomar o treinamento e visualizar e depurar previsões de forma interativa | Execute a inferência YOLO11 até 6x mais rápido com Neural Magic DeepSparse |

HUB Ultralítico

Experimente IA perfeita com Ultralytics HUB ⭐, a solução completa para visualização de dados, YOLO11 ? treinamento e implantação de modelo, sem qualquer codificação. Transforme imagens em insights acionáveis e dê vida às suas visões de IA com facilidade usando nossa plataforma de ponta e o aplicativo Ultralytics fácil de usar. Comece sua jornada gratuitamente agora!

Contribuir

Adoramos sua contribuição! O Ultralytics YOLO não seria possível sem a ajuda da nossa comunidade. Consulte nosso Guia de contribuição para começar e preencha nossa pesquisa para nos enviar feedback sobre sua experiência. Obrigado ? a todos os nossos colaboradores!

Licença

Ultralytics oferece duas opções de licenciamento para acomodar diversos casos de uso:

Licença AGPL-3.0 : Esta licença de código aberto aprovada pela OSI é ideal para estudantes e entusiastas, promovendo colaboração aberta e compartilhamento de conhecimento. Consulte o arquivo LICENSE para obter mais detalhes.

Licença Empresarial : Projetada para uso comercial, esta licença permite a integração perfeita do software Ultralytics e modelos de IA em bens e serviços comerciais, ignorando os requisitos de código aberto do AGPL-3.0. Se o seu cenário envolve a incorporação de nossas soluções em uma oferta comercial, entre em contato por meio do Licenciamento Ultralytics.

Contato

Para relatórios de bugs e solicitações de recursos do Ultralytics, visite GitHub Issues. Torne-se um membro do Ultralytics Discord, Reddit ou Fóruns para fazer perguntas, compartilhar projetos, aprender discussões ou para obter ajuda com tudo relacionado ao Ultralytics!