5/8/2024 : Atualização do código de inferência GPT-3.5 e LLama2 e resultados para a Figura 6, que mostra a natureza emergente da sinergia cognitiva.3/15/2024 : Este artigo foi aceito como artigo da conferência principal na NAACL2024! pip install -r requirements.txt

config_template.sh e execute source config_template.sh para configurar as variáveis de ambiente (observe que estamos usando a API do Azure em nossos experimentos) Fornecemos scripts de execução para cada uma das três tarefas. Confira os comentários nos scripts ".sh" para obter mais informações:

bash scripts/trivia_creative_writing.shbash scripts/codenames_collaborative.shbash scripts/logic_grid_puzzle.sh Todos os prompts podem ser encontrados na pasta prompts/ .

Todos os conjuntos de dados podem ser encontrados na pasta data/ .

Os resultados experimentais no artigo para cada tarefa podem ser encontrados na pasta logs/ . gpt4_w_sys_mes e gpt4_wo_sys_mes contém resultados correspondentes à Tabela 2 em nosso artigo. Também incluímos os resultados gpt-3.5 e llama2-13b correspondentes aos resultados da Figura 6, onde os hiperparâmetros, como adicionar ou não mensagem do sistema, seguem as escolhas de melhor desempenho nos experimentos gpt4.

"test_output_infos" : contém métricas de avaliação para cada instância, por exemplo, # respostas corretas mencionadas."*raw_responses" : respostas brutas de cada chamada de API."*parsing_flag" : se a resposta bruta foi analisada com sucesso. (para tarefa Codenames, este campo é separado em "parsing_success_flag_spymaster" e "parsing_success_flag_guesser")"unwrapped_output" : saída analisada que será usada para calcular métricas de avaliação. (para a tarefa Codenames, este campo é separado em "spymaster_output" e "guesser_output"; há um campo adicional chamado "hint_word" que é analisado a partir da saída do spymaster e inserido na entrada do Guesser; a métrica de avaliação é calculada com base no " adivinhador_saída")"task data" : dados para a instância da tarefa atual, por exemplo, perguntas, respostas, palavras-alvo, etc."usage" : registro do número de tokens e custos gastos até o momento.Por favor, cite o artigo e marque este repositório se você achar este trabalho interessante/útil.

@article{wang2023unleashing,

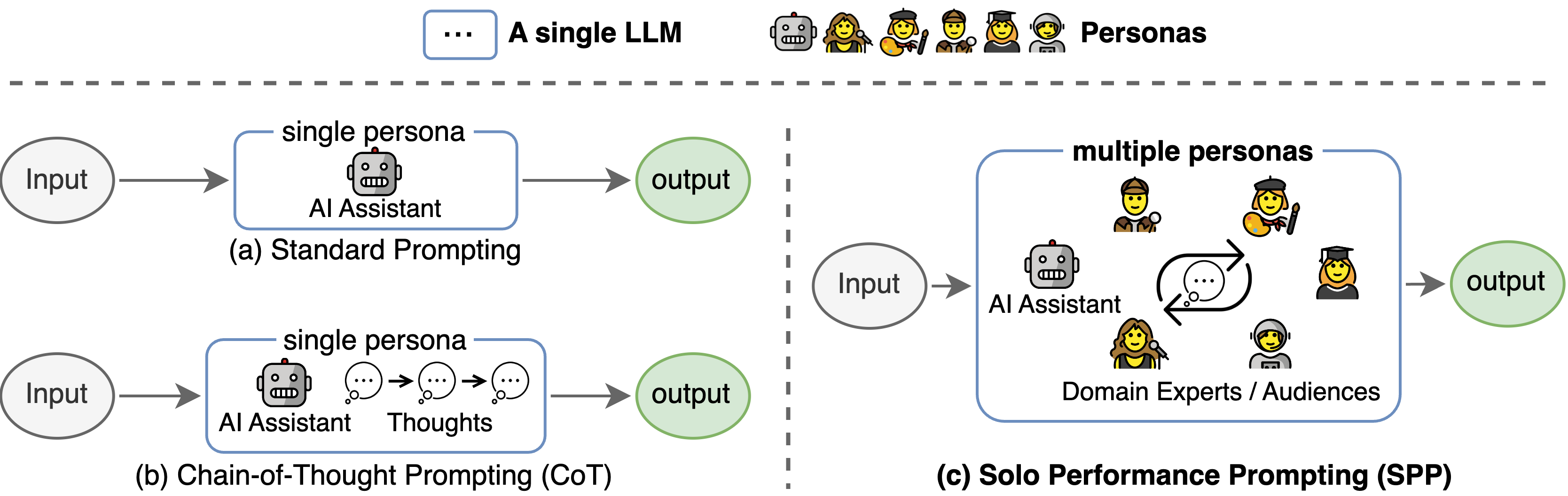

title={Unleashing Cognitive Synergy in Large Language Models: A Task-Solving Agent through Multi-Persona Self-Collaboration},

author={Wang, Zhenhailong and Mao, Shaoguang and Wu, Wenshan and Ge, Tao and Wei, Furu and Ji, Heng},

journal={arXiv preprint arXiv:2307.05300},

year={2023}

}

Esta base de código referenciou a estrutura do repositório oficial da Árvore do Pensamento. Agradecemos aos autores por seus esforços de código aberto.