Pesquisa AGI incrível

Artigos de leitura obrigatória sobre Inteligência Geral Artificial

? Notícias

- [2024-10] ? Nosso artigo foi aceito pelo TMLR 2024.

- [2024-05] ? Estamos organizando um Workshop AGI no ICLR 2024 e lançamos nosso documento de posicionamento, "How Far Are We From AGI?".

Nosso projeto é uma iniciativa contínua e aberta que evoluirá paralelamente aos avanços em AGI. Recebemos calorosamente comentários e solicitações da comunidade e planejamos atualizar nosso artigo anualmente. Os colaboradores no site do projeto serão reconhecidos com gratidão em futuras revisões.

Citação BibTex se você achar nosso trabalho/recursos úteis:

@article { feng2024far ,

title = { How Far Are We From AGI } ,

author = { Feng, Tao and Jin, Chuanyang and Liu, Jingyu and Zhu, Kunlun and Tu, Haoqin and Cheng, Zirui and Lin, Guanyu and You, Jiaxuan } ,

journal = { arXiv preprint arXiv:2405.10313 } ,

year = { 2024 }

} Contente

- Contente

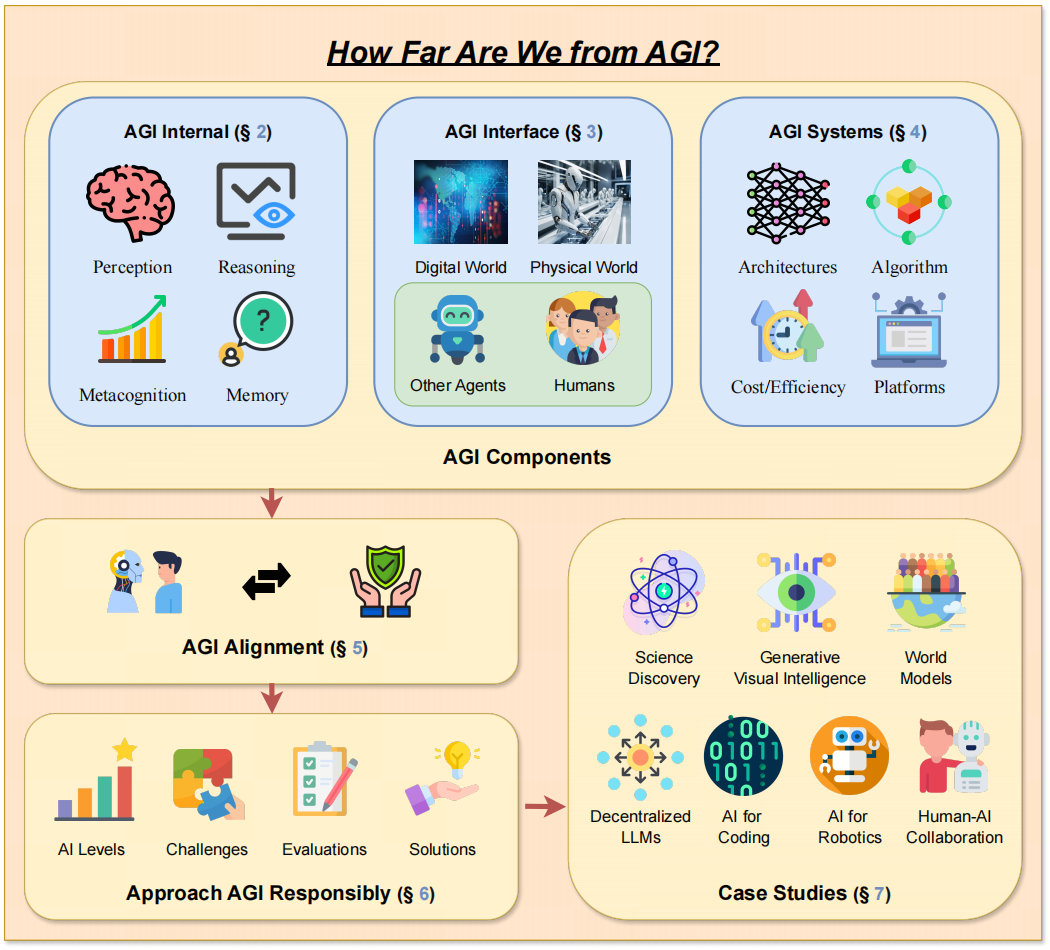

- 1. Introdução

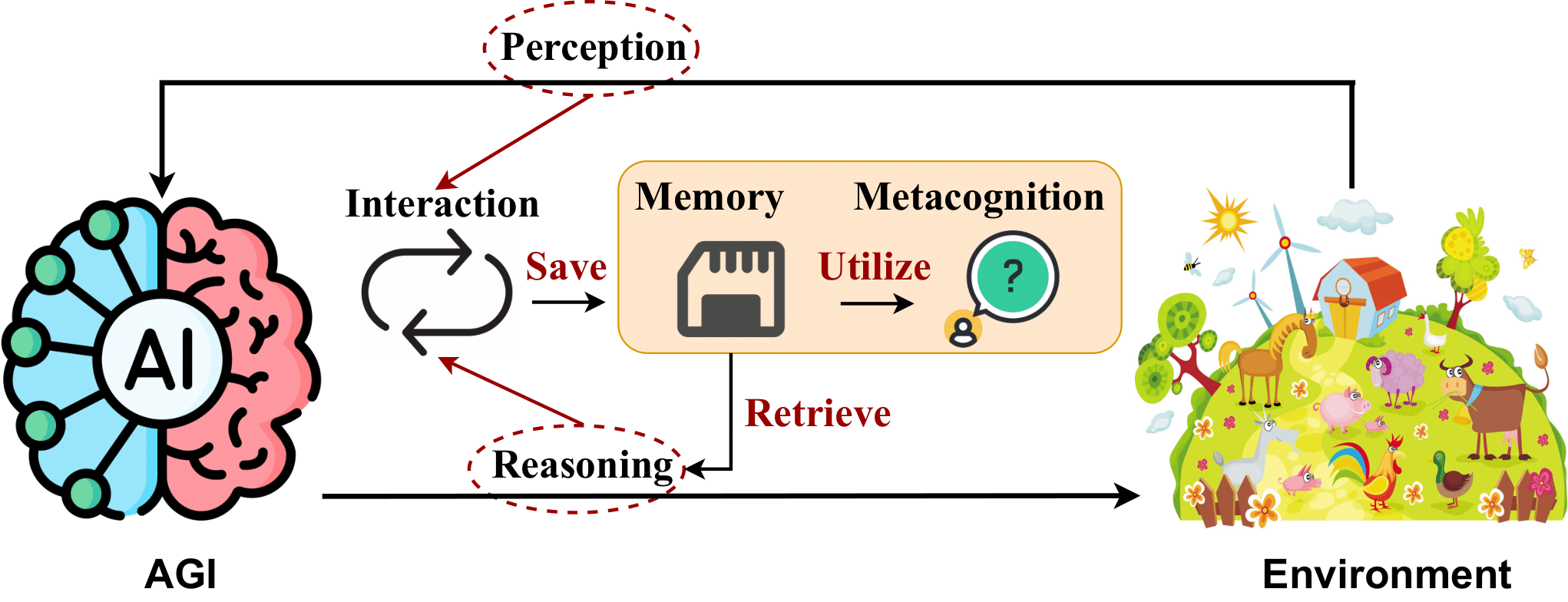

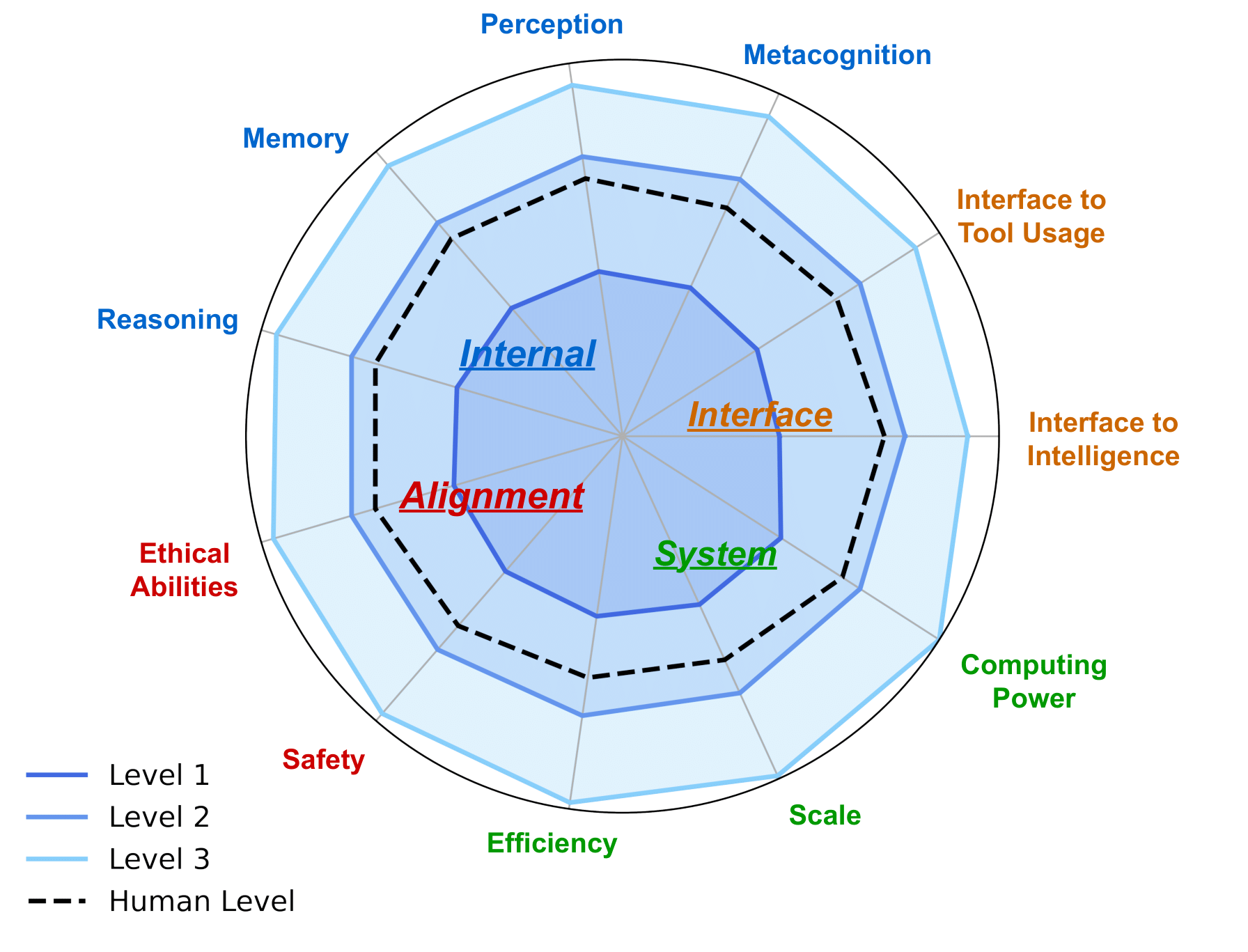

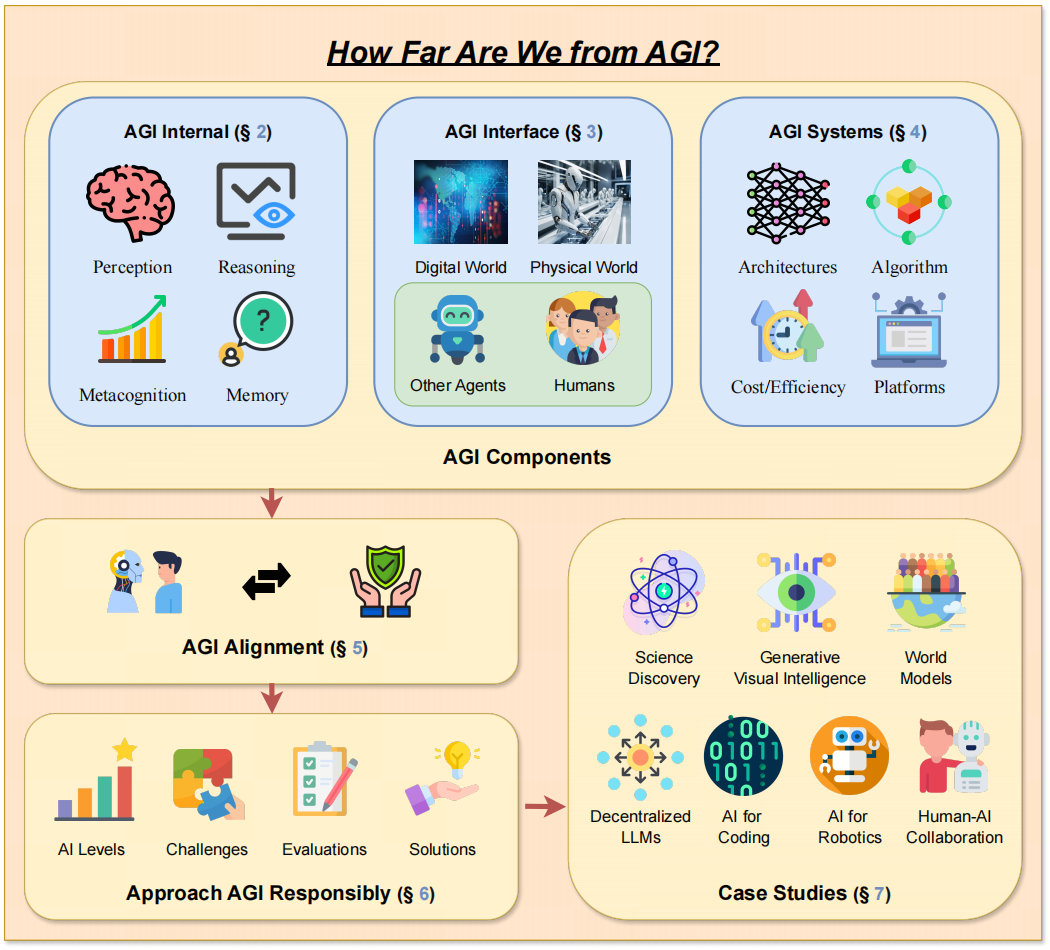

- 2. AGI Interno: Revelando a Mente do AGI

- 2.1 Percepção de IA

- 2.2 Raciocínio de IA

- 2.3 Memória IA

- 2.4 Metacognição de IA

- 3. Interface AGI: Conectando o Mundo com AGI

- 3.1 Interfaces de IA para o mundo digital

- 3.2 Interfaces de IA para o mundo físico

- 3.3 Interfaces de IA para Inteligência

- 3.3.1 Interfaces de IA para Agentes de IA

- 3.3.2 Interfaces de IA para Humanos

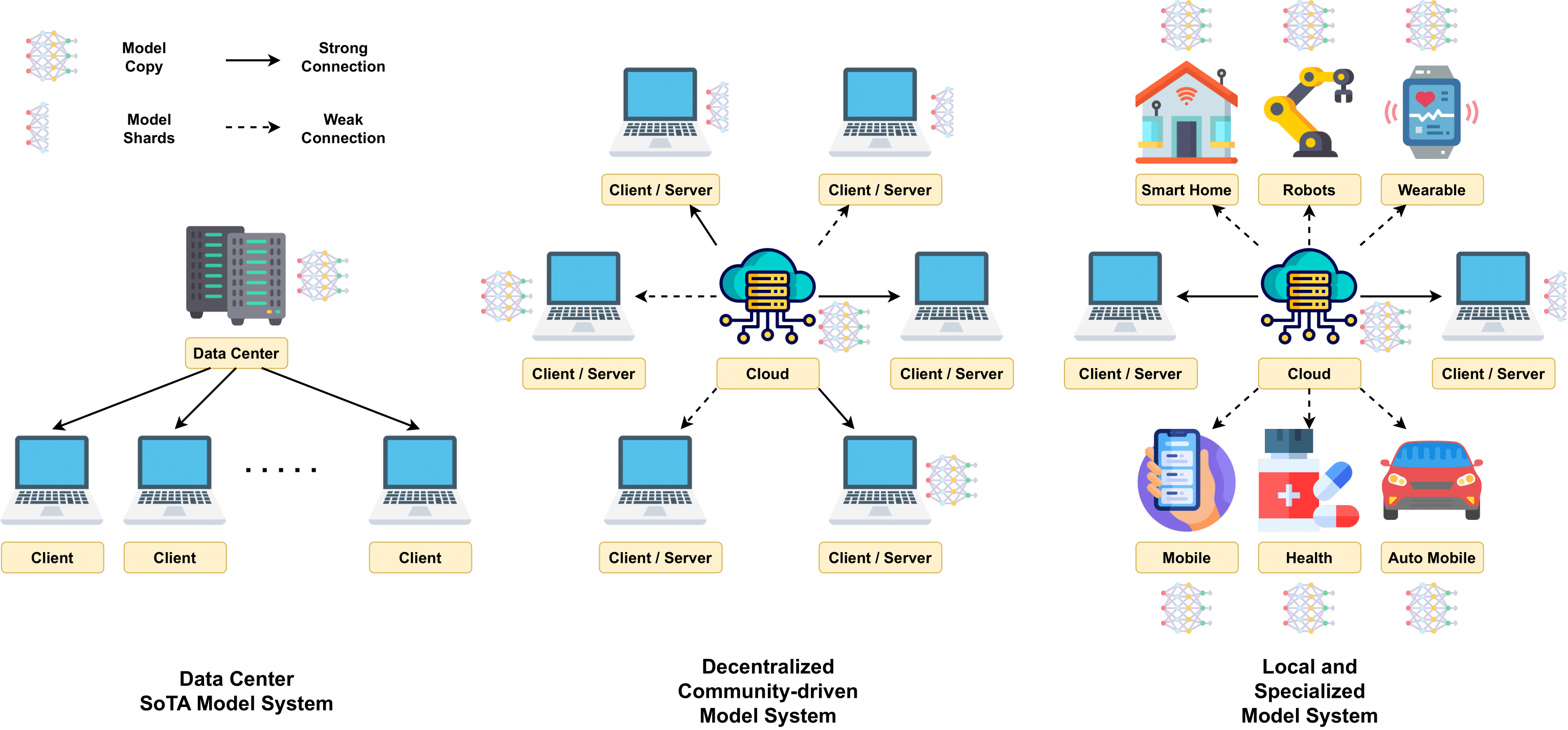

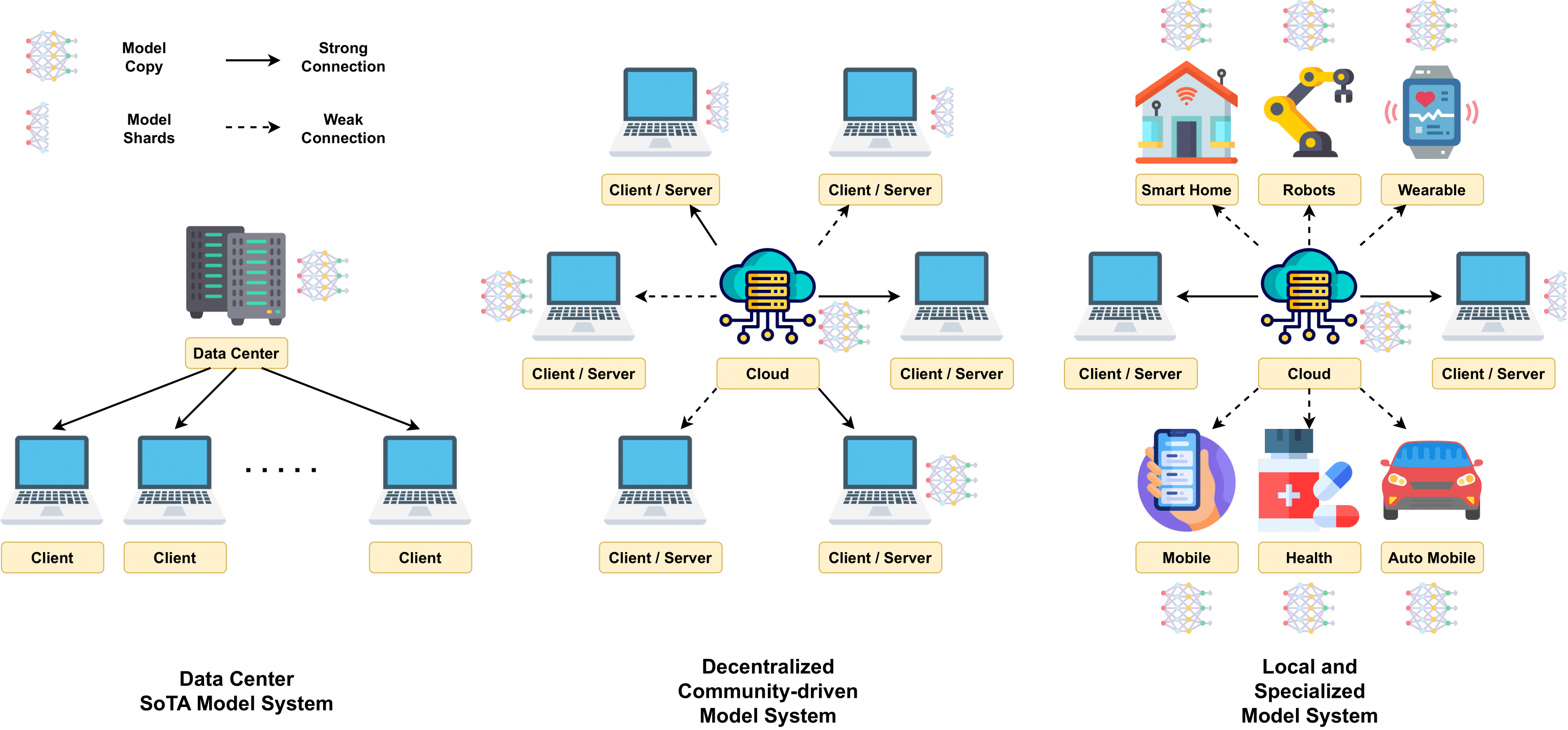

- 4. Sistemas AGI: Implementando o Mecanismo de AGI

- 4.2 Arquiteturas de Modelos Escaláveis

- 4.3 Treinamento em larga escala

- 4.4 Técnicas de Inferência

- 4.5 Custo e Eficiência

- 4.6 Plataformas de Computação

- 5. Alinhamento AGI: Garantir que o AGI atenda a diversas necessidades

- 5.1 Expectativas de Alinhamento AGI

- 5.2 Técnicas Atuais de Alinhamento

- 5.3 Como abordar os alinhamentos AGI

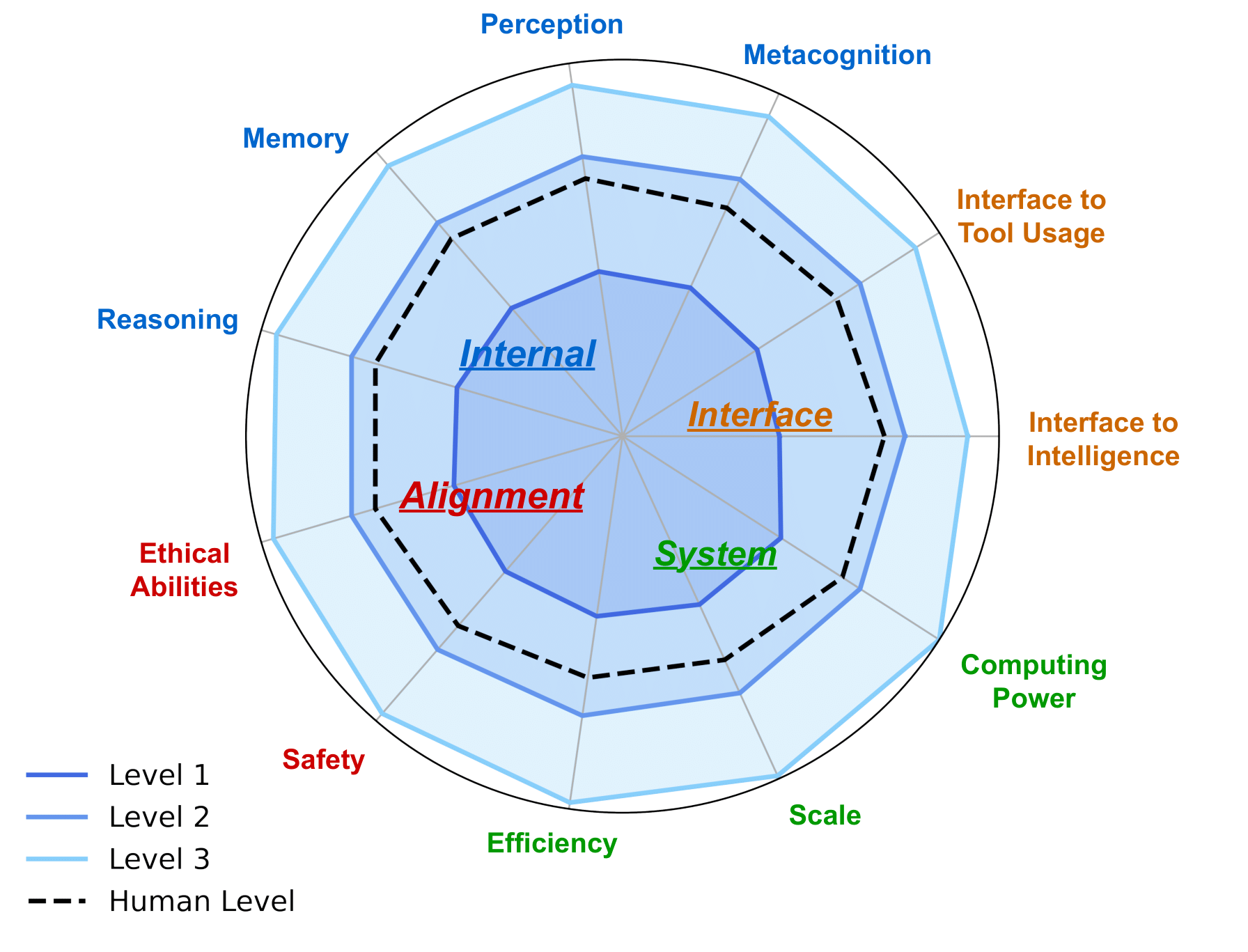

- 6. Roteiro AGI: Abordagem AGI Responsável

- 6.1 Níveis de IA: traçando a evolução da inteligência artificial

- 6.2 Avaliação AGI

- 6.2.1 Expectativas para Avaliação AGI

- 6.2.2 Avaliações Atuais e Suas Limitações

- 6.5 Considerações Adicionais durante o Desenvolvimento AGI

- 7. Estudos de caso

- 7.1 IA para descoberta e pesquisa científica

- 7.2 Inteligência Visual Gerativa

- 7.3 Modelos Mundiais

- 7.4 LLM Descentralizado

- 7.5 IA para codificação

- 7.6 IA para Robótica em Aplicações do Mundo Real

- 7.7 Colaboração Humano-IA

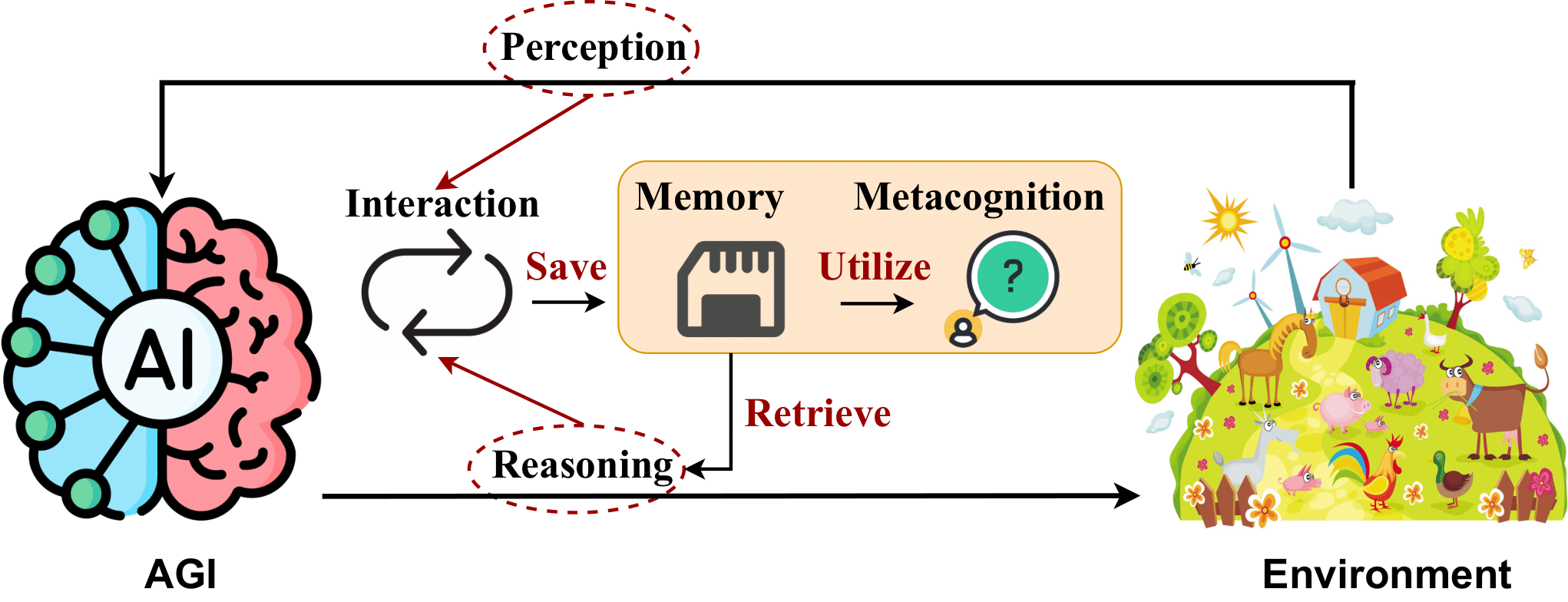

-> O design da estrutura do nosso artigo. <-

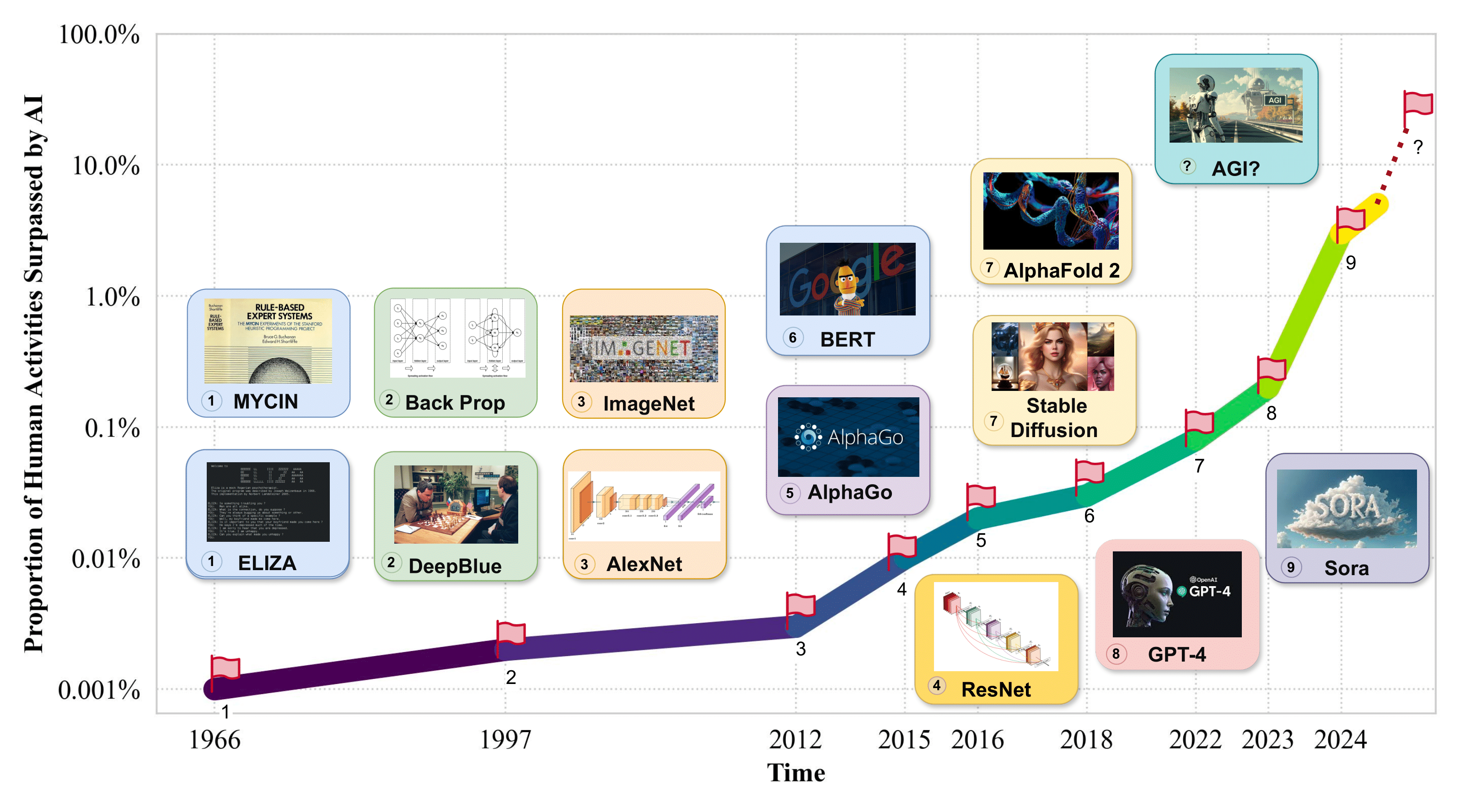

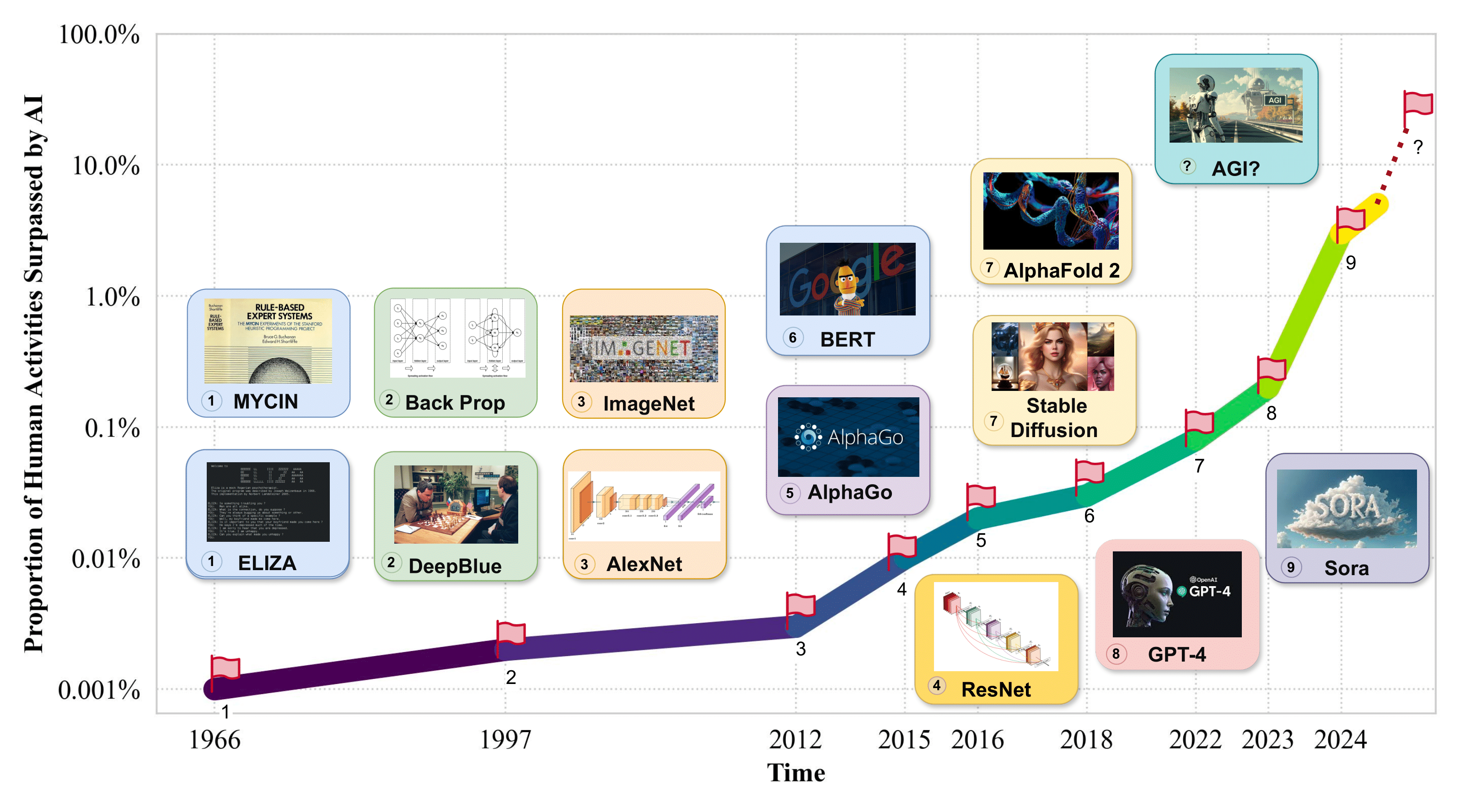

1. Introdução

-> Proporção de atividades humanas superadas pela IA. <-

2. AGI Interno: Revelando a Mente do AGI

2.1 Percepção de IA

- Flamingo: um modelo de linguagem visual para aprendizagem rápida . Jean-Baptiste Alayrac et al. NeurIPS 2022. [artigo]

- BLIP-2: Pré-treinamento de imagem-linguagem de inicialização com codificadores de imagem congelada e modelos de linguagem grandes . Junnan Li et al. ICML 2023. [artigo]

- SPHINX: A mistura conjunta de pesos, tarefas e incorporações visuais para modelos multimodais de grandes linguagens . Ziyi Lin et al. EMNLP 2023. [artigo]

- Ajuste de instrução visual . Haotian Liu et al. NeurIPS 2023. [artigo]

- GPT4Tools: ensinando modelo de linguagem grande para usar ferramentas por meio de autoinstrução . Rui Yang et al. NeurIPS 2023. [artigo]

- "Otter: um modelo multimodal com ajuste de instruções no contexto" . Bo Li et al. arXiv 2023. [artigo]

- VideoChat: compreensão de vídeo centrada no chat . KunChang Li et al. arXiv 2023. [artigo]

- mPLUG-Owl: Modularização capacita grandes modelos de linguagem com multimodalidade . Qinghao Ye et al. arXiv 2023. [artigo]

- Uma pesquisa sobre modelos multimodais de grandes linguagens . Shukang Yin et al. arXiv 2023. [artigo]

- PandaGPT: um modelo para seguir todas as instruções . Yixuan Su et al. arXiv 2023. [artigo]

- Adaptador LLaMA: Ajuste fino eficiente de modelos de linguagem com atenção de inicialização zero . Renrui Zhang et al. arXiv 2023. [artigo]

- Gemini: uma família de modelos multimodais altamente capazes . Rohan Anil et al. arXiv 2023. [artigo]

- "Shikra: Liberando a magia do diálogo referencial do Multimodal LLM" . Keqin Chen et al. arXiv 2023. [artigo]

- ImageBind: um espaço de incorporação para vincular todos eles . Rohit Girdhar et al. CVPR 2023. [artigo]

- MobileVLM: um assistente de linguagem rápido, forte e de visão aberta para dispositivos móveis . Xiangxiang Chu et al. arXiv 2023. [artigo]

- O que torna bons tokenizadores visuais para modelos de linguagem grandes? . Guangzhi Wang et al. arXiv 2023. [artigo]

- MiniGPT-4: Aprimorando a Compreensão da Visão-Linguagem com Modelos Avançados de Grandes Linguagens . Deyao Zhu et al. ICLR 2024. [artigo]

- LanguageBind: Estendendo o pré-treinamento de linguagem de vídeo para a modalidade N por meio do alinhamento semântico baseado em linguagem . Bin Zhu et al. ICLR 2024. [artigo]

2.2 Raciocínio de IA

- "A solicitação de cadeia de pensamento provoca raciocínio em grandes modelos de linguagem" . Jason Wei et al. NeurIPS 2022. [artigo]

- Teoria Neural da Mente? Sobre os limites da inteligência social em grandes LMs . Maarten Sap et al. EMNLP 2022. [artigo]

- Monólogo Interno: Raciocínio Incorporado por meio do Planejamento com Modelos de Linguagem . Wenlong Huang et al. CoRL 2022. [artigo]

- Pesquisa de Alucinações na Geração de Linguagem Natural . Ziwei Ji et al. ACM Computing Surveys 2022. [artigo]

- ReAct: Sinergizando raciocínio e atuação em modelos de linguagem . Shunyu Yao et al. ICLR 2023. [artigo]

- Solicitação decomposta: uma abordagem modular para resolver tarefas complexas . Tushar Khot et al. ICLR 2023. [artigo]

- Solicitação baseada em complexidade para raciocínio em várias etapas . Yao Fu et al. ICLR 2023. [artigo]

- "A solicitação do mínimo para o máximo permite raciocínio complexo em modelos de linguagem grandes" . Denny Zhou et al. ICLR 2023. [artigo]

- Rumo ao raciocínio em grandes modelos de linguagem: uma pesquisa . Jie Huang et al. Resultados do ACL 2023. [artigo]

- ProgPrompt: Gerando Planos de Tarefas de Robôs Situados Usando Modelos de Linguagem Grande . Ishika Singh et al. ICRA 2023. [artigo]

- Raciocinar com Modelo de Linguagem é Planejar com Modelo Mundial . Shibo Hao et al. EMNLP 2023. [artigo]

- Avaliando a alucinação de objetos em grandes modelos de visão-linguagem . Yifan Li et al. EMNLP 2023. [artigo]

- Árvore de pensamentos: solução deliberada de problemas com grandes modelos de linguagem . Shunyu Yao et al. NeurIPS 2023. [artigo]

- Auto-refinamento: refinamento iterativo com auto-feedback . Aman Madaan et al. NeurIPS 2023. [artigo]

- Reflexão: Agentes Linguísticos com Aprendizagem por Reforço Verbal . Noah Shinn et al. NeurIPS 2023. [artigo]

- Descrever, explicar, planejar e selecionar: planejamento interativo com grandes modelos de linguagem permite agentes multitarefa de mundo aberto . Zihao Wang et al. NeurIPS 2023. [artigo]

- LLM+P: Capacitando Grandes Modelos de Linguagem com Ótima Proficiência em Planejamento . Bo Liu et al. arXiv 2023. [artigo]

- Modelos de linguagem, modelos de agentes e modelos mundiais: a LEI para raciocínio e planejamento de máquinas . Zhiting Hu et al. arXiv 2023. [artigo]

- MMToM-QA: Resposta a perguntas da teoria multimodal da mente . Chuanyang Jin et al. arXiv 2024. [artigo]

- Gráfico de pensamentos: resolvendo problemas elaborados com grandes modelos de linguagem . Maciej Besta et al. AAAI 2024. [artigo]

- "Atingindo> 97% no GSM8K: Compreender profundamente os problemas torna os LLMs raciocinadores perfeitos" . Qihuang Zhong et al. arXiv 2024. [artigo] pendente

2.3 Memória IA

- Recuperação densa de passagens para resposta a perguntas de domínio aberto . Vladimir Karpukhin et al. EMNLP 2020. [artigo]

- Geração aumentada de recuperação para tarefas de PNL com uso intensivo de conhecimento . Patrick Lewis et al. NeurIPS 2020. [artigo]

- REALM: Pré-treinamento do modelo de linguagem aumentada com recuperação . Kelvin Guu et al. ICML 2020. [artigo]

- O aumento da recuperação reduz a alucinação na conversa . Kurt Shuster et al. Resultados do EMNLP 2021. [artigo]

- Melhorando os modelos de linguagem recuperando trilhões de tokens . Sebastian Borgeaud et al. ICML 2022. [artigo]

- Agentes Geradores: Simulacros Interativos do Comportamento Humano . Joon Sung Park et al. UIST 2023. [artigo]

- Arquiteturas Cognitivas para Agentes Linguísticos . Theodore R. Sumers et al. TMLR 2024. [artigo]

- Voyager: um agente incorporado e aberto com grandes modelos de linguagem . Guanzhi Wang et al. arXiv 2023. [artigo]

- Uma Pesquisa sobre o Mecanismo de Memória de Agentes Baseados em Grandes Modelos de Linguagem . Zeyu Zhang et al. arXiv 2024. [artigo]

- "O resumo recursivo permite memória de diálogo de longo prazo em modelos de linguagem grandes" . Qingyue Wang et al. arXiv 2023. [artigo] pendente

2.4 Metacognição de IA

- A consideração das meta-habilidades na externalização do conhecimento tácito e na aprendizagem organizacional . Jyoti Choudrie et al. HICSS 2006. [artigo]

- "Evoluindo Redes Neurais Auto-supervisionadas Inteligência Autônoma do Auto-ensino Evoluído" . Nam Le . arXiv 2019. [artigo]

- "Tornar modelos de linguagem pré-treinados melhores alunos em poucas tentativas" . Tianyu Gao et al. ACL 2021. [artigo]

- Identificando e manipulando os traços de personalidade dos modelos de linguagem . Graham Caron et al. arXiv 2022. [artigo]

- Brainish: Formalizando uma linguagem multimodal para inteligência e consciência . Paul Liang et al. arXiv 2022. [artigo]

- Uma teoria da consciência a partir de uma perspectiva teórica da ciência da computação: Insights da Máquina de Turing Consciente . Lenore Blum et al. PNAS 2022. [artigo]

- WizardLM: Capacitando Modelos de Linguagem Grande para Seguir Instruções Complexas . Xu et al. arXiv 2023. [artigo]

- Autoinstrução: Alinhando modelos de linguagem com instruções autogeradas . Yizhong Wang et al. ACL 2023. [artigo]

- ReST atende ReAct: Autoaperfeiçoamento para Multi-Step Reasoning LLM Agent . Renat Aksitov et al. arXiv 2023. [artigo]

- A psicologia cultural de grandes modelos de linguagem: ChatGPT é um pensador holístico ou analítico? . Chuanyang Jin et al. arXiv 2023. [artigo]

- Consciência em Inteligência Artificial: Insights da Ciência da Consciência . Patrick Butlin et al. arXiv 2023. [artigo]

- Revisitando a confiabilidade das escalas psicológicas em grandes modelos de linguagem . Jen-tse Huang et al. arXiv 2023. [artigo]

- Avaliando e induzindo personalidade em modelos de linguagem pré-treinados . Guangyuan Jiang et al. NeurIPS 2024. [artigo]

- Níveis de AGI: Operacionalizando o Progresso no Caminho para AGI . Meredith Ringel Morris et al. arXiv 2024. [artigo] pendente

- Investigar-Consolidar-Explorar: Uma Estratégia Geral para a Autoevolução do Agente Inter-Tarefas . Cheng Qian et al. arXiv 2024. [artigo] pendente

3. Interface AGI: Conectando o Mundo com AGI

3.1 Interfaces de IA para o mundo digital

- Princípios de interfaces de usuário de iniciativa mista . Eric Horvitz. SIGCHI 1999. [artigo]

- A ascensão e o potencial de grandes agentes baseados em modelos de linguagem: uma pesquisa . Zhiheng Xi et al. arXiv 2023. [artigo]

- Aprendizado de ferramentas com modelos básicos . Yujia Qin et al. arXiv 2023. [artigo]

- Criador: Desemaranhando raciocínios abstratos e concretos de grandes modelos de linguagem por meio da criação de ferramentas . Cheng Qian et al. arXiv 2023. [artigo]

- AppAgent: Agentes multimodais como usuários de smartphones . Zhao Yang et al. arXiv 2023. [artigo]

- Mind2Web: Rumo a um Agente Generalista para a Web . Xiang Deng et al. Benchmark NeurIPS 2023. [artigo]

- ToolQA: um conjunto de dados para resposta a perguntas LLM com ferramentas externas . Yuchen Zhuang et al. arXiv 2023. [artigo]

- Agentes geradores: simulacros interativos do comportamento humano . Joon Sung Park et al. arXiv 2023. [artigo]

- Toolformer: Os modelos de linguagem podem aprender sozinhos a usar ferramentas . Timo Schick et al. arXiv 2023. [artigo]

- Gorilla: modelo de linguagem grande conectado com APIs massivas . Shishir G Patil et al. arXiv 2023. [artigo]

- Voyager: um agente corporificado aberto com grandes modelos de linguagem . Guanzhi Wang et al. arXiv 2023. [artigo]

- OS-Copilot: Rumo a Agentes de Computador Generalistas com Autoaperfeiçoamento . Zhiyong Wu et al. arXiv 2024. [artigo]

- WebArena: um ambiente web realista para construção de agentes autônomos . Shuyan Zhou et al. ICLR 2024. [artigo]

- Grandes modelos de linguagem como criadores de ferramentas . Tianle Cai et al. ICLR 2024. [artigo]

3.2 Interfaces de IA para o mundo físico

- Lições do desafio de colheita da Amazon: Quatro aspectos da construção de sistemas robóticos . Clemens Eppner et al. RSS 2016. [artigo]

- Perceptor-Ator: Um Transformador Multitarefa para Manipulação Robótica . Mohit Shridhar et al. arXiv 2022. [artigo]

- Vima: Manipulação geral de robôs com prompts multimodais . Yunfan Jiang et al. arXiv 2022. [artigo]

- Faça o que posso, não o que digo: fundamentando a linguagem nas possibilidades robóticas . Michael Ahn et al. arXiv 2022. [artigo]

- Voxposer: Mapas de valores 3D combináveis para manipulação robótica com modelos de linguagem . Wenlong Huang et al. arXiv 2023. [artigo]

- MotionGPT: Movimento Humano como Língua Estrangeira . Biao Jiang et al. arXiv 2023. [artigo]

- "Rt-2: Modelos de visão-linguagem-ação transferem conhecimento da web para controle robótico" . Anthony Brohan et al. arXiv 2023. [artigo]

- Navegando para objetos no mundo real . Theophile Gervet et al. Robótica Científica 2023. [artigo]

- Lm-nav: Navegação robótica com grandes modelos pré-treinados de linguagem, visão e ação . Dhruv Shah et al. CRL 2023. [artigo]

- Palm-e: Um modelo de linguagem multimodal incorporado . Danny Driess et al. arXiv 2023. [artigo]

- LLM-Planner: planejamento fundamentado em poucas tentativas para agentes incorporados com grandes modelos de linguagem . Chan Hee Song et al. ICCV 2023. [artigo]

- Instruct2Act: Mapeando instruções multimodais para ações robóticas com modelo de linguagem grande . Siyuan Huang et al. arXiv 2023. [artigo]

- DROID: um conjunto de dados de manipulação de robôs em grande escala . Alexander Khazatsky et al. arXiv 2024. [artigo]

- BEHAVIOR-1K: Um benchmark de IA incorporado e centrado no ser humano com 1.000 atividades diárias e simulação realista . Chengshu Li et al. arXiv 2024. [artigo]

3.3 Interfaces de IA para Inteligência

3.3.1 Interfaces de IA para Agentes de IA

- Gradientes contrafactuais de política multiagente . Jakob Foerster et al. AAAI 2018. [artigo]

- Explicações de grandes modelos de linguagem tornam melhores os raciocinadores pequenos . Shiyang Li et al. arXiv 2022. [artigo]

- "Destilação de aprendizagem no contexto: transferindo a capacidade de aprendizagem rápida de modelos de linguagem pré-treinados" . Yukun Huang et al. arXiv 2022. [artigo]

- Autoagentes: uma estrutura para geração automática de agentes . Guangyao Chen et al. arXiv 2023. [artigo]

- "Inferência neural amortizada para raciocínio multiagente aninhado" . Kunal Jha et al. arXiv 2023. [artigo]

- Destilação de conhecimento de grandes modelos de linguagem . Yuxian Gu et al. arXiv 2023. [artigo]

- Metagpt: Metaprogramação para estrutura colaborativa multiagente . Sirui Hong et al. arXiv 2023. [artigo]

- Descrever, explicar, planejar e selecionar: O planejamento interativo com grandes modelos de linguagem permite agentes multitarefa de mundo aberto . Zihao Wang et al. arXiv 2023. [artigo]

- Agentverse: Facilitando a colaboração multiagente e explorando comportamentos emergentes nos agentes . Weize Chen et al. arXiv 2023. [artigo]

- Mindstorms em sociedades mentais baseadas na linguagem natural . Mingchen Zhuge et al. arXiv 2023. [artigo]

- Jarvis-1: Agentes multitarefa de mundo aberto com modelos de linguagem multimodal com memória aumentada . Zihao Wang et al. arXiv 2023. [artigo]

- "Destilação simbólica da cadeia de pensamento: modelos pequenos também podem "pensar" passo a passo" . Liunian Harold Li et al. ACL 2023. [artigo]

- Destilação passo a passo! superando modelos de linguagem maiores com menos dados de treinamento e tamanhos de modelo menores . Cheng-Yu Hsieh et al. arXiv 2023. [artigo]

- Generalização fraca para forte: extraindo capacidades fortes com supervisão fraca . Collin Burns et al. arXiv 2023. [artigo]

- Aprimorando os modelos de linguagem de bate-papo ampliando conversas instrucionais de alta qualidade . Ning Ding et al. arXiv 2023. [artigo]

- GAIA: uma referência para assistentes gerais de IA . Grégoire Mialon et al. ICLR 2024. [artigo]

- Voyager: um agente corporificado aberto com grandes modelos de linguagem . Guanzhi Wang et al. arXiv 2023. [artigo]

- Camel: Agentes comunicativos para a exploração da "mente" da sociedade modelo de linguagem em larga escala . Guohao Li et al. arXiv 2023. [artigo]

- Adaptando auto-racionalizadores com destilação multi-recompensa . Sahana Ramnath et al. arXiv 2023. [artigo]

- Superalinhamento de visão: generalização fraca a forte para modelos de base de visão . Jianyuan Guo et al. arXiv 2024. [artigo]

- WebArena: um ambiente web realista para construção de agentes autônomos . Shuyan Zhou et al. ICLR 2024. [artigo]

- Auto-alinhamento de modelos de linguagem baseado em princípios do zero com supervisão humana mínima . Zhiqing Sun et al. NeurIPS 2024. [artigo]

- Mind2web: Rumo a um agente generalista para a web . Xiang Deng et al. NeurIPS 2024. [artigo]

- Rumo ao controle geral do computador: um agente multimodal para Red Dead Redemption II como um estudo de caso . Weihao Tan et al. arXiv 2024. [artigo]

3.3.2 Interfaces de IA para Humanos

- Diretrizes para interação humano-IA . Saleema Amershi et al. CHI 2019. [artigo]

- Princípios de design para aplicações de IA generativa . Justin D. Weisz e outros. CHI 2024. [artigo]

- Grafólogo: Explorando respostas de modelos de linguagem grande com diagramas interativos . Peiling Jiang et al. UIST 2023. [artigo]

- Sensecape: Habilitando exploração multinível e criação de sentido com grandes modelos de linguagem . Sangho Suh et al. UIST 2023. [artigo]

- Apoiando a criação de sentido de resultados de modelos de linguagem de grande porte em escala . Katy Ilonka Gero et al. CHI 2024. [artigo]

- Luminate: Geração estruturada e exploração de espaço de design com grandes modelos de linguagem para cocriação humano-IA . Sangho Suh et al. CHI 2024. [Artigo]

- Cadeias de IA: interação humano-IA transparente e controlável por meio do encadeamento de grandes prompts de modelos de linguagem . Tongshuang Wu et al. CHI 2022. [artigo]

- Promptify: geração de texto para imagem por meio de exploração interativa de prompts com grandes modelos de linguagem . Stephen Brade et al. CHI 2023. [artigo]

- ChainForge: um kit de ferramentas visuais para engenharia imediata e testes de hipóteses LLM . Ian Arawjo et al. CHI 2024. [artigo]

- CoPrompt: Suporte ao compartilhamento e referência de prompts na programação colaborativa em linguagem natural . Li Feng et al. CHI 2024. [artigo]

- Gerando feedback automático em modelos de UI com modelos de linguagem grande . Peitong Duan et al. CHI 2024. [artigo]

- Rambler: Apoiando a escrita com fala por meio da manipulação de essência assistida por LLM . Susan Lin et al. CHI 2024. [artigo]

- Incorporando Grandes Modelos de Linguagem na Realidade Estendida: Oportunidades e Desafios para Inclusão, Engajamento e Privacidade . Efe Bozkir et al. arXiv 2024. [artigo]

- GenAssist: Tornando a geração de imagens acessível . Mina Huh et al. UIST 2023. [artigo]

- “Quanto menos eu digitar, melhor”: como os modelos de linguagem de IA podem melhorar ou impedir a comunicação para usuários AAC . Stephanie Valência et al. CHI 2023. [artigo]

- Reexaminando se, por que e como a interação humano-IA é extremamente difícil de projetar . Qian Yang et al. CHI 2020. [artigo]

4. Sistemas AGI: Implementando o Mecanismo de AGI

4.2 Arquiteturas de Modelos Escaláveis

- "Redes neurais escandalosamente grandes: a camada de mistura de especialistas com portas esparsas" . Noam Shazeer et al. arXiv 2017. [artigo]

- Os transformadores são RNNs: Transformadores Autoregressivos Rápidos com Atenção Linear . Angelos Katharopoulos et al. arXiv 2020. [artigo]

- Longformer: o transformador de documentos longos . Iz Beltagy et al. arXiv 2020. [artigo]

- LightSeq: uma biblioteca de inferência de alto desempenho para transformadores . Xiaohui Wang et al. arXiv 2021. [artigo]

- "Transformadores de comutação: dimensionando para trilhões de modelos de parâmetros com dispersão simples e eficiente" . William Fedus et al. arXiv 2022. [artigo]

- Modelagem eficiente de sequências longas com espaços de estados estruturados . Albert Gu et al. arXiv 2022. [artigo]

- "MegaBlocks: treinamento esparso eficiente com mistura de especialistas" . Trevor Gale et al. arXiv 2022. [artigo]

- Treinamento de modelos de linguagem grande com otimização de computação . Jordan Hoffmann et al. arXiv 2022. [artigo]

- Dimensionamento Eficaz de Modelos Fundamentais em Longo Contexto . Wenhan Xiong et al. arXiv 2023. [artigo]

- Hierarquia de hienas: em direção a modelos de linguagem convolucionais maiores . Michael Poli et al. arXiv 2023. [artigo]

- Stanford Alpaca: um modelo LLaMA que segue instruções . Rohan Taori et al. GitHub 2023. [código]

- Rwkv: Reinventando RNNs para a era dos transformadores . Bo Peng et al. arXiv 2023. [artigo]

- Deja Vu: Dispersão Contextual para LLMs Eficientes no Tempo de Inferência . Zichang Liu et al. arXiv 2023. [artigo]

- "Flash-LLM: Habilitando Inferência de Grandes Modelos Gerativos com boa relação custo-benefício e altamente eficiente com dispersão não estruturada" . Haojun Xia et al. arXiv 2023. [artigo]

- ByteTransformer: um transformador de alto desempenho aprimorado para entradas de comprimento variável . Yujia Zhai et al. arXiv 2023. [artigo]

- Tutel: mistura adaptativa de especialistas em escala . Changho Hwang et al. arXiv 2023. [artigo]

- Mamba: Modelagem de Sequência de Tempo Linear com Espaços de Estados Seletivos . Albert Gu, Tri Dao. arXiv 2023. [artigo]

- Hungry Hungry Hippos: Rumo à modelagem de linguagem com modelos de espaço de estado . Daniel Y. Fu et al. arXiv 2023. [artigo]

- Rede Retentiva: Um Sucessor do Transformador para Grandes Modelos de Linguagem . Yutao Sun et al. ArXiv, 2023.

- Projeto Mecanístico e Dimensionamento de Arquiteturas Híbridas . Michael Poli et al. arXiv 2024. [artigo]

- "Revisitando a destilação de conhecimento para modelos de linguagem autorregressivos" . Qihuang Zhong et al. arXiv 2024. [artigo]

- DB-LLM: Binarização dupla precisa para LLMs eficientes . Hong Chen et al. arXiv 2024. [artigo]

- Reduzindo o tamanho do cache de valor-chave do transformador com atenção entre camadas . William Brandon e outros. arXiv 2024.[papel]

- Você armazena em cache apenas uma vez: arquiteturas decodificador-decodificador para modelos de linguagem Yutao Sun et al. arXiv 2024. [artigo]

4.3 Treinamento em larga escala

- Treinamento de Deep Nets com custo de memória sublinear . Tianqi Chen et al. arXiv 2016. [artigo]

- Além do paralelismo de dados e modelos para redes neurais profundas . Zhihao Jia et al. arXiv 2018. [artigo]

- GPipe: Treinamento Eficiente de Redes Neurais Gigantes Usando Paralelismo de Pipeline . Yanping Huang et al. arXiv 2019. [artigo]

- Aprendizagem por transferência com eficiência de parâmetros para PNL . Neil Houlsby et al. ICML 2019. artigo

- Megatron-LM: Treinamento de modelos de linguagem de vários bilhões de parâmetros usando paralelismo de modelos . Mohammad Shoeybi et al. arXiv 2020. [artigo]

- Alpa: Automatizando o Paralelismo Inter e Intra-Operador para Aprendizado Profundo Distribuído . Lianmin Zheng et al. arXiv 2022. [artigo]

- Inferência DeepSpeed: permitindo inferência eficiente de modelos de transformadores em escala sem precedentes . Reza Yazdani Aminabadi et al. arXiv 2022. [artigo]

- Memorização sem overfitting: analisando a dinâmica de treinamento de grandes modelos de linguagem . Kushal Tirumala et al. arXiv 2022. [artigo]

- Paralelismo SWARM: treinar modelos grandes pode ser surpreendentemente eficiente em termos de comunicação . Max Ryabinin et al. arXiv 2023. [artigo]

- Trajetórias de treinamento de modelos de linguagem em escalas . Mengzhou Xia et al. arXiv 2023. [artigo]

- HexGen: Inferência Gerativa do Modelo de Fundação sobre Ambiente Descentralizado Heterogêneo . Youhe Jiang et al. arXiv 2023. [artigo]

- FusionAI: treinamento descentralizado e implantação de LLMs com GPUs massivas para consumidores . Zhenheng Tang et al. arXiv 2023. [artigo]

- "Toque a atenção com transformadores blockwise para contexto quase infinito" . Hao Liu et al. arXiv 2023. [artigo]

- Pythia: um conjunto para analisar grandes modelos de linguagem em treinamento e escalonamento . Stella Biderman et al. arXiv 2023. [artigo]

- "Ajustando modelos de linguagem em redes lentas usando compactação de ativação com garantias" . Jue Wang et al. arXiv 2023. [artigo]

- Adaptador LLaMA: Ajuste fino eficiente de modelos de linguagem com atenção de inicialização zero . Renrui Zhang et al. arXiv 2023. [artigo]

- QLoRA: Ajuste fino eficiente de LLMs quantizados . Tim Dettmers et al. arXiv 2023. [artigo]

- Gerenciamento eficiente de memória para atendimento de modelos de linguagem grande com PagedAttention . Woosuk Kwon et al. arXiv 2023. [artigo]

- Infinite-LLM: Serviço LLM eficiente para contexto longo com DistAttention e KVCache distribuído . Bin Lin et al. arXiv 2024. [artigo]

- OLMo: Acelerando a Ciência dos Modelos de Linguagem . Dirk Groeneveld et al. arXiv 2024. [artigo]

- Sobre Treinamento Eficiente de Modelos de Aprendizagem Profunda em Grande Escala: Uma Revisão da Literatura . Li Shen et al. arXiv 2023. [artigo] pendente

4.4 Técnicas de Inferência

- FlashAttention: atenção exata rápida e com uso eficiente de memória com IO-Awareness . Tri Dao et al. NeurIPS 2022. [artigo]

- Esboçar e verificar: aceleração de modelo de linguagem grande sem perdas por meio de decodificação autoespeculativa . Jun Zhang et al. arXiv 2023. [artigo]

- Rumo ao serviço eficiente e generativo de modelos de linguagem grande: uma pesquisa de algoritmos a sistemas . Xupeng Miao et al. arXiv 2023. [artigo]

- FlashDecoding++: inferência mais rápida de modelos de linguagem grande em GPUs . Ke Hong et al. arXiv 2023. [artigo]

- Inferência rápida de transformadores via decodificação especulativa . Yaniv Leviathan et al. arXiv 2023. [artigo]

- Serviço rápido de inferência distribuída para modelos de linguagem grande . Bingyang Wu et al. arXiv 2023. [artigo]

- S-LoRA: atendendo milhares de adaptadores LoRA simultâneos . Ying Sheng et al. arXiv 2023. [artigo]

- TensorRT-LLM: uma caixa de ferramentas TensorRT para inferência otimizada de modelos de linguagem grande . NVIDIA. GitHub 2023. [código]

- Punica: serviço LoRA multilocatário . Lequn Chen et al. arXiv 2023. [artigo]

- S$^3: Aumentando a utilização da GPU durante a inferência generativa para maior rendimento . Yunho Jin et al. arXiv 2023. [artigo]

- Servidor de inferência Multi-LoRA que pode ser dimensionado para milhares de LLMs ajustados . Predibase. GitHub 2023. [código]

- Decodificação de pesquisa imediata . Apoorv Saxena. GitHub 2023. [código]

- Transformador mais rápido . NVIDIA. GitHub 2021. [artigo]

- DeepSpeed-FastGen: Geração de texto de alto rendimento para LLMs via MII e DeepSpeed-Inference . Connor Holmes et al. arXiv 2024. [artigo]

- SpecInfer: Acelerando o atendimento generativo de modelos de linguagem grande com inferência e verificação especulativa baseada em árvore . Xupeng Miao et al. arXiv 2024. [artigo]

- Medusa: Estrutura simples de aceleração de inferência LLM com múltiplas cabeças de decodificação . Tianle Cai et al. arXiv 2024. [artigo]

- "O modelo informa o que descartar: compactação de cache KV adaptável para LLMs" . Suyu Ge et al. ICLR 2024. [artigo]

- Modelos de linguagem de streaming eficientes com coletores de atenção . Guangxuan Xiao et al. ICLR 2024. [artigo]

- "DeFT: Flash Tree-attention com IO-Awareness para inferência LLM eficiente baseada em pesquisa de árvore" . Jinwei Yao et al. arXiv 2024. [artigo]

- Programando com eficiência grandes modelos de linguagem usando SGLang . Lianmin Zheng et al. arXiv 2023. [artigo]

- VELOCIDADE: Execução especulativa em pipeline para decodificação eficiente . Coleman Hooper et al. arXiv 2023. [artigo]

- Sequoia: decodificação especulativa escalável, robusta e com reconhecimento de hardware . Zhuoming Chen et al. arXiv 2024. [artigo] pendente

4.5 Custo e Eficiência

- Demonstrar-Pesquisar-Prever: Compondo modelos de recuperação e linguagem para PNL com uso intensivo de conhecimento . Omar Khattab et al. arXiv 2023. [artigo]

- Aprendizado de máquina automatizado: métodos, sistemas, desafios . Frank Hutter et al. Springer Publishing Company, incorporada, 2019.

- Sopas de modelos: a média dos pesos de vários modelos ajustados melhora a precisão sem aumentar o tempo de inferência . Mitchell Wortsman et al. arXiv 2022. [artigo]

- Depuração de dados com importância do Shapley em pipelines de aprendizado de máquina de ponta a ponta . Bojan Karlaš et al. arXiv 2022. [artigo]

- Otimização econômica de hiperparâmetros para inferência de geração de modelos de linguagem grande . Chi Wang et al. arXiv 2023. [artigo]

- Grandes modelos de linguagem são engenheiros de alerta de nível humano . Yongchao Zhou et al. arXiv 2023. [artigo]

- Mesclando por Modelos Correspondentes em Subespaços de Tarefas . Derek Tam et al. arXiv 2023. [artigo]

- Editando Modelos com Aritmética de Tarefas . Gabriel Ilharco et al. arXiv 2023. [artigo]

- PriorBand: Otimização prática de hiperparâmetros na era do aprendizado profundo . Neeratyoy Mallik et al. arXiv 2023. [artigo]

- Um estudo empírico de fusão de modelos multimodais . Yi-Lin Sung et al. arXiv 2023. [artigo]

- DSPy: Compilando chamadas de modelo de linguagem declarativa em pipelines de autoaperfeiçoamento . Omar Khattab et al. arXiv 2023. [artigo]

- FrugalGPT: como usar grandes modelos de linguagem enquanto reduz custos e melhora o desempenho . Lingjiao Chen et al. arXiv 2023. [artigo]

- Transformadores Tandem para LLMs Eficientes em Inferência . Aishwarya PS et al. arXiv 2024. [artigo]

- AIOS: Sistema operacional do agente LLM . Kai Mei et al. arXiv 2024. [artigo]

- LoraHub: generalização eficiente de tarefas cruzadas por meio de composição LoRA dinâmica . Chengsong Huang et al. arXiv 2024. [artigo]

- AutoML na era dos grandes modelos de linguagem: desafios atuais, oportunidades e riscos futuros . Alexander Tornede et al. arXiv 2024. [artigo]

- "Mesclando Especialistas em Um: Melhorando a Eficiência Computacional da Mistura de Especialistas" . Shwai He et al. EMNLP 2023. [artigo] pendente

4.6 Plataformas de Computação

- TVM: um compilador automatizado de otimização ponta a ponta para aprendizado profundo . Tianqi Chen et al. arXiv 2018. [artigo]

- TPU v4: um supercomputador opticamente reconfigurável para aprendizado de máquina com suporte de hardware para incorporações . Norman P. Jouppi et al. arXiv 2023. [artigo]

5. Alinhamento AGI: Garantir que o AGI atenda a diversas necessidades

5.1 Expectativas de Alinhamento AGI

- Compatível com Humanos: Inteligência Artificial e o Problema de Controle . Stuart Russell . Viquingue, 2019.

- Inteligência Artificial, Valores e Alinhamento . Iasson Gabriel . Mentes e Máquinas, 2020. [artigo]

- Alinhamento de Agentes Linguísticos . Zachary Kenton et al. arXiv, 2021. [Artigo]

- O problema da aprendizagem de valores . Nate Soares . Relatório técnico do Machine Intelligence Research Institute [artigo]

- Problemas concretos na segurança da IA . Dario Amodei et al. arXiv, 2016. [artigo]

- Riscos éticos e sociais de danos causados por modelos de linguagem . Laura Weidinger et al. arXiv, 2021. [artigo]

- Sobre os perigos dos papagaios estocásticos: os modelos de linguagem podem ser grandes demais? . Emily M. Bender et al. FAccT 2021. [artigo]

- O cenário global das diretrizes de ética em IA . Anna Jobin et al. Nature Machine Intelligence, 2019. [artigo]

- Preconceito anti-muçulmano persistente em grandes modelos linguísticos . Abubakar Abid et al. AIES, 2021. [artigo]

- Rumo à resolução de co-referência inclusiva de gênero . Yang Trista Cao et al. ACL, 2020. [artigo]

- O impacto social do processamento de linguagem natural . Dirk Hovy et al. ACL 2016. [artigo]

- TruthfulQA: Medindo como os modelos imitam as falsidades humanas . Stephanie Lin et al. ACL 2022. [artigo]

- Os riscos de radicalização do GPT-3 e dos modelos avançados de linguagem neural . Kris McGuffie et al. arXiv, 2020. [artigo]

- Transparência de IA na era dos LLMs: um roteiro de pesquisa centrado no ser humano . P. Vera Liao et al. arXiv 2023. [artigo]

- Além da experiência e das funções: uma estrutura para caracterizar as partes interessadas do aprendizado de máquina interpretável e suas necessidades . Harini Suresh et al. CHI 2021. [artigo]

- Identificando e mitigando os riscos de segurança da IA generativa . Clark Barrett et al. arXiv, 2023. [artigo]

- Os agentes LLM podem hackear sites de forma autônoma . Richard Fang et al. arXiv, 2024. [artigo]

- Deepfakes, Frenologia, Vigilância e muito mais! Uma taxonomia de riscos de privacidade de IA . Hao-Ping Lee et al. CHI 2024. [artigo]

- Privacidade na era da IA . Sauvik Das et al. Comunicações da ACM, 2023. [artigo]

5.2 Técnicas Atuais de Alinhamento

- Aprendendo a resumir com feedback humano . Nisan Stiennon et al. NeurIPS 2020. [artigo]

- É melhor pensar duas vezes: aprender a se realinhar com os valores humanos a partir de edições de texto . Ruibo Liu et al. NeurIPS 2022. [artigo]

- Treinar modelos de linguagem para seguir instruções com feedback humano . Long Ouyang et al. NeurIPS 2022. [artigo]

- Controlando os demônios internos: autodesintoxicação para modelos de linguagem . Canwen Xu et al. AAAI 2022. artigo

- Alinhando modelos de linguagem generativa com valores humanos . Ruibo Liu et al. NAACL 2022. [artigo]

- Treinar um assistente útil e inofensivo com aprendizagem por reforço a partir de feedback humano . Yuntao Bai et al. arXiv 2022. [artigo]

- IA constitucional: inocuidade do feedback da IA . Yuntao Bai et al. arXiv 2022. [artigo]

- "Jangada: ajuste fino classificado como recompensa para alinhamento do modelo de base generativa" . Hanze Dong et al. arXiv 2023. [artigo]

- Melhorando modelos de linguagem com gradientes de política off-line baseados em vantagens . Ashutosh Baheti et al. arXiv 2023. [artigo]

- Treinamento de modelos linguísticos com feedback linguístico em escala . Jérémy Scheurer et al. arXiv 2023. [artigo]

- Um paradigma teórico geral para compreender a aprendizagem a partir das preferências humanas . Mohammad Gheshlaghi Azar et al. arXiv 2023. [artigo]

- Vamos verificar passo a passo . Hunter Lightman et al. arXiv 2023. [artigo]

- Problemas abertos e limitações fundamentais da aprendizagem por reforço a partir de feedback humano . Stephen Casper et al. arXiv 2023. [artigo]

- Alinhando grandes modelos de linguagem por meio de feedback sintético . Sungdong Kim et al. arXiv 2023. [artigo]

- RLAIF: Dimensionando a aprendizagem por reforço a partir de feedback humano com feedback de IA . Harrison Lee et al. arXiv 2023. [artigo]

- Otimização de classificação de preferência para alinhamento humano . Feifan Song et al. arXiv 2023. [artigo]

- Melhorando a factualidade e o raciocínio em modelos de linguagem por meio do debate multiagente . Yilun Du et al. arXiv 2023. [artigo]

- Alinhamento de modelo de linguagem grande: uma pesquisa . Tianhao Shen et al. arXiv 2023. [artigo]

- Otimização de preferência direta: seu modelo de linguagem é secretamente um modelo de recompensa . Rafael Rafailov et al. NeurIPS 2024. [artigo]

- Lima: Menos é mais para alinhamento . Chunting Zhou et al. NeurIPS 2024. [artigo]

5.3 Como abordar os alinhamentos AGI

- Riscos éticos e sociais de danos causados pela linguagem . Mellor Weidinger et al. arXiv 2021. [artigo]

- Consenso Internacional de Segurança de IA de Pequim . Academia de Inteligência Artificial de Pequim. 2024. [artigo]

- Explicações contrafactuais sem abrir a caixa preta: decisões automatizadas e o GDPR . Sandra Wachter et al. Harvard Journal of Law & Technology, 2017. [Artigo]

- Alinhamento de agente escalável via modelagem de recompensa: uma direção de pesquisa . Jan Like et al. ARXIV 2018. [Paper]

- Construindo ética em inteligência artificial . Han Yu et al. Ijcai 2018. Paper

- Compatível humano: inteligência artificial e o problema do controle . Stuart Russell . Viking, 2019. [Paper]

- Inteligência artificial responsável: como desenvolver e usar a IA de maneira responsável . Virginia Dignum . Springer Nature, 2019. [Papel]

- Ética em máquinas: o design e a governança de IA ética e sistemas autônomos . Alan F. Winfield et al. Anais do IEEE, 2019. [Artigo]

- Problemas abertos na IA cooperativa . Allan Dafoe et al. ARXIV 2020. [Papel]

- Inteligência Artificial, Valores e Alinhamento . Iason Gabriel . Mentes e máquinas, 2020. [Papel]

- AI cooperativa: as máquinas devem aprender a encontrar um terreno comum . Allan Dafoe et al. Natureza 2021. [Papel]

- Moralidade da máquina, progresso moral e desastre ambiental iminente . Ben Kenward et al. ARXIV 2021. [Papel]

- Análise de risco X para pesquisa de IA . Dan Hendrycks et al. ARXIV 2022. [Papel]

- Decomposição de tarefas para supervisão escalável (destilação Agisf) . Charbel-Raphaël Segerie. Blog 2023. [Blog]

- Generalização fraca a forte: provocando fortes capacidades com supervisão fraca . Collin Burns, et al. ARXIV 2023. [Papel]

- De quem as opiniões os modelos de linguagem refletem? . Shibani Santurkar et al. ICML 2023. [Papel]

- Alinhamento da IA: uma pesquisa abrangente . Jiaming Ji et al. ARXIV 2023. [Papel]

- Problemas abertos e limitações fundamentais do aprendizado de reforço com o feedback humano . Stephen Casper et al. ARXIV 2023. [Papel]

- O feitiço de desbloqueio no base LLMS: repensando o alinhamento por meio de aprendizado no contexto . Bill Yuchen Lin et al. ARXIV 2023. [Papel]

- Alinhamento de modelo de linguagem grande: uma pesquisa . Tianhao Shen et al. ARXIV 2023. [Papel]

6. Roteiro AGI: Aproximando -se com responsabilidade AGI

6.1 Níveis de IA: traçando a evolução da inteligência artificial

- Sparks de inteligência geral artificial: experimentos iniciais com o GPT-4 . Sébastien Bubeck et al. ARXIV 2023. [Papel]

- Níveis de AGI: operacionalizando o progresso no caminho para a AGI . Meredith Ringel Morris et al. Arxiv 2024. [Papel]

6.2 Avaliação AGI

6.2.1 Expectativas para avaliação da AGI

- Para o relatório sistemático das pegadas de energia e carbono do aprendizado de máquina . Peter Henderson et al. Journal of Machine Learning Research, 2020.

- Ai verde . Roy Schwartz Communications of the ACM, 2020.

- Avaliando grandes modelos de linguagem treinados no código . Mark Chen et al. Nenhum diário, 2021.

- Documentando Large Webtext Corpora: Um estudo de caso sobre o colossal corpus rastejado . Jesse Dodge et al. ARXIV 2021. [Papel]

- Sobre as oportunidades e riscos dos modelos de fundação . Rishi Bommasani et al. ARXIV 2021. [Papel]

- Generalização sistemática do tipo humano através de uma rede neural de meta-aprendizado . Brenden M Lake et al. Nature, 2023. [Paper]

- O Superbench está medindo LLMs em aberto: uma análise crítica . Equipe de Superbench. ARXIV 2023.

- Avaliação holística de modelos de linguagem . Percy Liang et al. ARXIV 2023. [Papel]

6.2.2 Avaliações atuais e suas limitações

- Esquadrão: mais de 100.000 perguntas para a compreensão da máquina do texto . Pranav Rajpurkar et al. ARXIV 2016. [Papel]

- Triviaqa: Um conjunto de dados de desafio de grande escala supervisionou distante para a compreensão da leitura . Mandar Joshi et al. ARXIV 2017. [Paper]

- Coqa: Um desafio de resposta a perguntas de conversação . Siva Reddy et al. Transações da Associação para Linguística Computacional, 2019.

- Avaliação de robustez precisa, confiável e rápida . Wieland Brendel et al. Neurips 2019. [Paper]

- Medindo o entendimento maciço da linguagem multitarefa . Dan Hendrycks et al. ARXIV 2020. [Papel]

- Avaliando a robustez do modelo e a estabilidade para a mudança de conjunto de dados . Adarsh Subbaswamy et al. Apresentado na Conferência Internacional sobre Inteligência e Estatística Artificial, 2021. Artigo

- MMDIALOG: Um conjunto de dados de diálogo em larga escala de várias turnos em direção a uma conversa de domínio aberto multimodal . Jiazhan Feng et al. ARXIV 2022. [Papel]

- Auto-instrução: alinhando modelos de linguagem com instruções auto-geradas . Yizhong Wang et al. ARXIV 2022. [Papel]

- Supernaturalinstructions: generalização por meio de instruções declarativas em mais de 1600 tarefas de NLP . Yizhong Wang et al. ARXIV 2022. [Papel]

- Análise holística da alucinação no GPT-4V (ISION): preconceitos e desafios de interferência . Chenhang Cui et al. ARXIV 2023. [Papel]

- Avaliando a robustez às instruções de grandes modelos de linguagem . Yuansheng Ni et al. ARXIV 2023. [Papel]

- GAIA: Uma referência para os assistentes gerais de IA . Grégoire Mialon et al. ARXIV 2023. [Papel]

- Uma estrutura de avaliação abrangente para a robustez profunda do modelo . Jun Guo et al. Reconhecimento de padrões, 2023. [Papel]

- AGIEVAL: Uma referência centrada no ser humano para avaliar modelos de fundação . Wanjun Zhong et al. ARXIV 2023. [Papel]

- MMMU: Um enorme entendimento multimodal multidisciplinar e referência de raciocínio para o especialista AGI . Xiang et al. ARXIV 2023. [Papel]

- Avaliando a criatividade do modelo de grande linguagem de uma perspectiva literária . Murray Shanahan et al. ARXIV 2023. [Papel]

- AGENTBEnch: Avaliando LLM . Xiao Liu et al. ICLR 2024. [Papel]

- Avaliação e compreensão da criatividade em grandes modelos de linguagem . Yunpu Zhao et al. Arxiv 2024. [Papel]

- Julgando LLM-AS-A-JUDGE com o MT-Bench e Chatbot Arena . Lianmin Zheng et al. Neurips 2024. [Papel]

6.5 Considerações adicionais durante o desenvolvimento da AGI

- Desafios fundamentais para garantir o alinhamento e a segurança de grandes modelos de linguagem . Usman Anwar et al. Arxiv 2024. [Papel]

- Melhores práticas e lições aprendidas sobre dados sintéticos para modelos de idiomas . Ruibo Liu et al. Arxiv 2024. [Papel]

- Avançar a inteligência social em agentes de IA: desafios técnicos e perguntas abertas . Leena Mathur et al. Arxiv 2024. [Papel]

7. Estudos de caso

7.1 AI para descoberta e pesquisa científica

- Previsão de estrutura de proteínas altamente precisa com alfafold . Jumper, John et al. Nature, 2021. [Papel]

- Descoberta científica automatizada: da descoberta de equações aos sistemas de descoberta autônomos . Kramer, Stefan et al. ARXIV 2023. [Papel]

- Prevendo efeitos de variantes não codificantes com modelo de sequência baseado em aprendizado profundo . Zhou, Jian et al. Nature Methods, 2015. [[Paper] (https://www.ncbi.nlm.nih.gov/pmc/articles/pmc4768299/]

- Aprendendo a ver a física via desanimação visual . Wu, Jiajun et al. Neurips 2017. [Paper]

- Aprendizagem profunda para detecção de ondas gravitacionais em tempo real e estimativa de parâmetros: resultados com dados avançados do LIGO . George, Daniel et al. Cartas de Física B, 2018. [Artigo]

- Identificando transições de fase quântica com redes neurais adversárias . Rem, Bart-Jan et al. Nature Physics, 2019. [Artigo]

- Openagi: Quando o LLM atende a especialistas em domínio . GE, Yingqiang et al. Neurips, 2023. [Papel]

- Da matéria escura às galáxias com redes convolucionais . Zhang, Xinyue et al. ARXIV 2019. [Artigo]

- Otimização global da dinâmica quântica com exploração profunda do Alphazero . Dalgaard, Mogens et al. NPJ Quantum Information, 2020. [Papel]

- Aprendendo a explorar a estrutura temporal para o processamento biomédico da linguagem da visão . Shruthi Bannur et al. CVPR, 2023. [Papel]

- Mathbert: Um modelo de idioma pré-treinado para tarefas gerais de PNL na educação em matemática . Shen, Jia Tracy et al. ARXIV 2021. [Papel]

- Otimização molecular usando modelos de linguagem . Maziarz, Krzysztof et al. ARXIV 2022. [Papel]

- Retrotrae: tradução retrosintética de ambientes atômicos com transformador . Ucak, Umit Volkan et al. Sem diário, 2022. [Artigo]

- Scholarbert: Bigger nem sempre é melhor . Hong, Zhi et al. ARXIV 2022. [Papel]

- Galactica: um grande modelo de linguagem para a ciência . Taylor, Ross et al. ARXIV 2022. [Papel]

- Aprendizagem do currículo de declaração de matemática formal . Polu, Stanislas et al. ARXIV 2022. [Papel]

- Prova co-treinamento de artefato para o teorema, provando com modelos de idiomas . Jesse Michael Han et al. ICLR 2022. [Papel]

- Resolvendo problemas quantitativos de raciocínio com modelos de linguagem . Lewkowycz, Aitor et al. ARXIV 2022. [Papel]

- BIOGPT: Transformador pré-treinado generativo para geração e mineração de texto biomédico . Luo, Renqian et al. Briefings em Bioinformática, 2022.

- ChemCrow: Aumentando modelos de grande língua com ferramentas de química . Bran, Andres M et al. ARXIV 2023. [Papel]

- Pesquisa química autônoma com grandes modelos de linguagem . Boiko, Daniil A et al. Nature, 2023. [Paper]

- Capacidades de pesquisa científica autônoma emergentes de grandes modelos de linguagem . Daniil A. Boiko et al. ARXIV 2023. [Papel]

- Mathprompter: raciocínio matemático usando grandes modelos de idiomas . Imani, Shima, et al. Apresentado em Anais da 61ª Reunião Anual da Associação de Linguística Computacional (Volume 5: Trilha da Indústria), 2023. [Paper]

- Aprendendo a explorar a estrutura temporal para o processamento biomédico da linguagem da visão . Shruthi Bannur et al. ARXIV 2023. [Papel]

- LLMS for Science: Uso para geração de código e análise de dados . Nejjar, Mohamed et al. ARXIV 2023. [Papel]

- Medagentes: grandes modelos de idiomas como colaboradores para o raciocínio médico zero . Xiangru Tang et al. Arxiv 2024. [Papel]

7.2 Inteligência visual generativa

- Aprendizagem profunda não supervisionada usando termodinâmica sem equilíbrio . Jascha Sohl-Dickstein et al. ICML 2015. [Paper]

- Modelagem generativa estimando gradientes da distribuição de dados . Yang Song et al. Neurips 2019. [Paper]

- Modelos probabilísticos de difusão de denoising . Jonathan Ho et al. Neurips 2020. [Papel]

- Modelagem generativa baseada em pontuação através de equações diferenciais estocásticas . Yang Song et al. ICLR 2021. [Papel]

- Glide: em direção à geração de imagens fotorrealistas e edição com modelos de difusão guiada por texto . Alex Nichol et al. ICML 2022. [Papel]

- SDEDIT: Síntese de imagem guiada e edição com equações diferenciais estocásticas . Chenlin Meng et al. ICLR 2022. [Papel]

- Modelos de difusão de vídeo . Jonathan Ho et al. Neurips 2022. [Papel]

- Geração de imagem condicional hierárquica de texto com latentes de clipes . Aditya Ramesh et al. ARXIV 2022. [Papel]

- Orientação de difusão sem classificador . Jonathan Ho et al. ARXIV 2022. [Papel]

- Paleta: modelos de difusão de imagem a imagem . Chitwan Saharia et al. Siggraph 2022. [Papel]

- Síntese de imagem de alta resolução com modelos de difusão latente . Robin Rombach et al. CVPR 2022. [Papel]

- Adicionando controle condicional aos modelos de difusão de texto a imagem . Lvmin Zhang et al. ICCV 2023. [Papel]

- Modelos de difusão escalável com transformadores . William Peebles et al. ICCV 2023. [Papel]

- A modelagem seqüencial permite o aprendizado escalável para grandes modelos de visão . Yutong Bai et al. ARXIV 2023. [Papel]

- Geração de vídeo modelos como simuladores mundiais . Tim Brooks et al. Openai 2024. [Papel]

7.3 Modelos mundiais

- Aprendendo a ver a física via desanimação visual . Wu, Jiajun et al. Neurips 2017. [Paper]

- Aprendizagem de reforço baseado em modelo seguro com garantias de estabilidade . Berkenkamp, Felix et al. Neurips, 2017. [Paper]

- SIMNET: Modelos mundiais baseados em simulação de aprendizagem para raciocínio físico . Vicol, Paul, Menapace et al. ICLR 2022. [Papel]

- Dreamix: Dreamfusion através da mistura espaço -temporal iterativa . Khalifa, Anji et al. ARXIV 2022. [Papel]

- Agente de IA incorporado de uso geral por meio de aprendizado de reforço com conhecimento em escala da Internet . Guo, Xiaoxiao et al. ARXIV 2022. [Papel]

- VQGAN-CLIP: geração de imagens de domínio aberto e edição com orientação de linguagem natural . Crowson, Katherine. ARXIV 2022. [Papel]

- Um caminho para a inteligência autônoma da máquina . LECUN YANN OpenReview, 2022. [Papel]

- Os modelos de idiomas atendem aos modelos mundiais: as experiências incorporadas aprimoram os modelos de linguagem . Jiannan Xiang et al. Neurips 2023. [Papel]

- Dominar diversos domínios através de modelos mundiais . Hafner, Danijar et al. ARXIV 2023. [Papel]

- Aquisição de modelos multimodais por recuperação . Reed, Scott et al. ARXIV 2023. [Papel]

- Modelos de idiomas como planejadores de tiro zero: extraindo conhecimento acionável para agentes incorporados . Dohan, David et al. ARXIV 2023. [Papel]

- Modelos de idiomas, modelos de agentes e modelos mundiais: a lei para raciocínio e planejamento de máquinas . Zhiting Hu et al. ARXIV 2023. [Papel]

- O raciocínio com o modelo de idioma está planejando o modelo mundial . Hao, Shibo et al. ARXIV 2023. [Papel]

- Metasim: Aprendendo a gerar conjuntos de dados sintéticos . Zhang, Yuxuan et al. ARXIV 2023. [Papel]

- Modelo mundial em um milhão de comprimentos de vídeo e idioma com ringattion . Hao Liu et al. Arxiv 2024. [Papel]

- Genie: ambientes interativos generativos . Jake Bruce et al. Arxiv 2024. [Papel]

7.4 LLM descentralizado

- Pétalas: inferência colaborativa e ajuste fino de grandes modelos . Alexander Borzunov et al. ARXIV 2022. [Papel]

- Blockchain for Deep Learning: Review and Open Challenres . Os tempos econômicos. Computação de cluster 2021. [Papel]

- FLEXGEN: Inferência generativa de alto rendimento de grandes modelos de linguagem com uma única GPU . Ying Sheng et al. ARXIV 2023. [Papel]

- Treinamento descentralizado de modelos de fundação em ambientes heterogêneos . Binhang Yuan et al. ARXIV 2023. [Papel]

7.5 IA para codificar

- Uma estrutura para a avaliação dos modelos de geração de código . Ben Allal et al. Github, 2023. [Código]

- Avaliando grandes modelos de linguagem treinados no código . Mark Chen et al. ARXIV 2021. [Papel]

- Síntese de programas com grandes modelos de linguagem . Jacob Austin et al. ARXIV 2021. [Papel]

- Geração de código no nível da competição com alfacode . Yujia Li et al. Science, 2022. [Papel]

- Treinamento eficiente de modelos de linguagem para preencher o meio . Mohammad Bavarian et al. ARXIV 2022. [Papel]

- Santacoder: Não pegue as estrelas! . Loubna Ben Allal et al. Mente, 2023. [Papel]

- Starcoder: Que a fonte esteja com você! . Raymond Li et al. ARXIV 2023. [Papel]

- Grandes modelos de linguagem para otimização do compilador . Chris Cummins et al. ARXIV 2023. [Papel]

- Livros didáticos são tudo o que você precisa . Suriya Gunasekar et al. ARXIV 2023. [Papel]

- Intercode: padronizando e benchmarking codificação interativa com feedback de execução . John Yang et al. ARXIV 2023. [Papel]

- Aprendizagem de reforço com feedback automático para geração de teste de unidade de alta qualidade . Benjamin Steenhoek et al. ARXIV 2023. [Papel]

- Incoder: Um modelo generativo para preenchimento e síntese de código . Daniel Fried et al. ARXIV 2023. [Papel]

- Refinando o código C descompilado com grandes modelos de linguagem . Wai Kin Wong et al. ARXIV 2023. [Papel]

- SWE-banch: modelos de idiomas podem resolver o mundo real