Converse com seus documentos offline usando IA. Nenhum dado sai do seu sistema. A conexão com a Internet só é necessária para instalar a ferramenta e baixar os modelos de IA. É baseado em PrivateGPT, mas possui mais recursos.

Conteúdo

chatdocs.yml| Extensão | Formatar |

|---|---|

.csv | CSV |

.docx , .doc | Documento do Word |

.enex | EverNote |

.eml | |

.epub | EPub |

.html | HTML |

.md | Remarcação |

.msg | Mensagem do Outlook |

.odt | Abrir texto do documento |

.pdf | Formato de documento portátil (PDF) |

.pptx , .ppt | Documento PowerPoint |

.txt | Arquivo de texto (UTF-8) |

Instale a ferramenta usando:

pip install chatdocsBaixe os modelos de IA usando:

chatdocs downloadAgora pode ser executado offline sem conexão com a internet.

Adicione um diretório contendo documentos para conversar usando:

chatdocs add /path/to/documentsOs documentos processados serão armazenados no diretório

dbpor padrão.

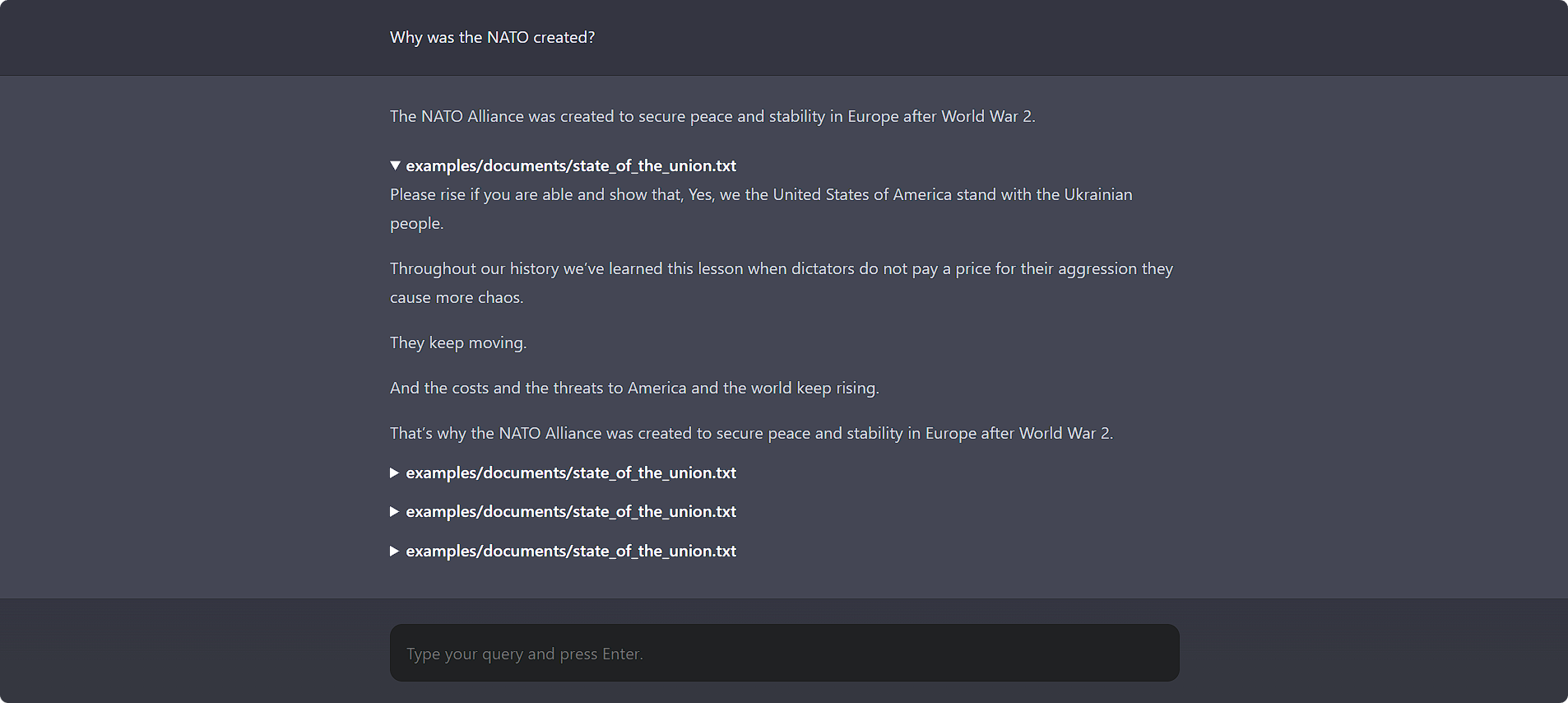

Converse com seus documentos usando:

chatdocs uiAbra http://localhost:5000 em seu navegador para acessar a IU da web.

Ele também possui uma interface de linha de comando agradável:

chatdocs chat

Todas as opções de configuração podem ser alteradas usando o arquivo de configuração chatdocs.yml . Crie um arquivo chatdocs.yml em algum diretório e execute todos os comandos desse diretório. Para referência, consulte o arquivo chatdocs.yml padrão.

Você não precisa copiar o arquivo inteiro, apenas adicione as opções de configuração que deseja alterar, pois elas serão mescladas com a configuração padrão. Por exemplo, consulte tests/fixtures/chatdocs.yml que altera apenas algumas das opções de configuração.

Para alterar o modelo de embeddings, adicione e altere o seguinte em seu chatdocs.yml :

embeddings :

model : hkunlp/instructor-largeNota: Ao alterar o modelo de embeddings, exclua o diretório

dbe adicione documentos novamente.

Para alterar o modelo CTransformers (GGML/GGUF), adicione e altere o seguinte em seu chatdocs.yml :

ctransformers :

model : TheBloke/Wizard-Vicuna-7B-Uncensored-GGML

model_file : Wizard-Vicuna-7B-Uncensored.ggmlv3.q4_0.bin

model_type : llamaNota: Ao adicionar um novo modelo pela primeira vez, execute

chatdocs downloadpara baixar o modelo antes de usá-lo.

Você também pode usar um arquivo de modelo local existente:

ctransformers :

model : /path/to/ggml-model.bin

model_type : llama Para usar? Modelos de Transformers, adicione o seguinte ao seu chatdocs.yml :

llm : huggingface Para alterar o ? Modelo Transformers, adicione e altere o seguinte em seu chatdocs.yml :

huggingface :

model : TheBloke/Wizard-Vicuna-7B-Uncensored-HFNota: Ao adicionar um novo modelo pela primeira vez, execute

chatdocs downloadpara baixar o modelo antes de usá-lo.

Para usar modelos GPTQ com ? Transformers, instale os pacotes necessários usando:

pip install chatdocs[gptq] Para ativar o suporte de GPU (CUDA) para o modelo de embeddings, adicione o seguinte ao seu chatdocs.yml :

embeddings :

model_kwargs :

device : cudaPode ser necessário reinstalar o PyTorch com CUDA habilitado seguindo as instruções aqui.

Para ativar o suporte de GPU (CUDA) para o modelo CTransformers (GGML/GGUF), adicione o seguinte ao seu chatdocs.yml :

ctransformers :

config :

gpu_layers : 50Talvez seja necessário instalar as bibliotecas CUDA usando:

pip install ctransformers[cuda] Para ativar o suporte de GPU (CUDA) para o ? Modelo Transformers, adicione o seguinte ao seu chatdocs.yml :

huggingface :

device : 0Pode ser necessário reinstalar o PyTorch com CUDA habilitado seguindo as instruções aqui.

MIT