Relembrando o processo de aprendizagem passado, os vídeos dos professores Ng Enda e Li Hongyi me forneceram grande ajuda em minha jornada de aprendizagem aprofundada. Seus métodos de explicação bem-humorados e explicações simples e intuitivas tornam o aprendizado teórico enfadonho animado e interessante.

Porém, na prática, muitos alunos inicialmente se preocuparão em como obter a API de grandes modelos estrangeiros. Embora possam eventualmente encontrar uma solução, o medo da dificuldade pela primeira vez sempre atrasará o progresso do aprendizado e mudará gradualmente. de “apenas assistir ao vídeo”. Muitas vezes vejo discussões semelhantes na área de comentários, então decidi usar meu tempo livre para ajudar os alunos a ultrapassar esse limite. Essa também é a intenção original do projeto.

Este projeto não fornecerá tutoriais sobre acesso científico à Internet, nem dependerá de interfaces personalizadas para a plataforma. Em vez disso, usará o SDK OpenAI mais compatível para ajudar todos a aprender mais conhecimentos gerais.

O projeto começará com simples chamadas de API e levará você gradualmente ao mundo dos grandes modelos. No processo, você dominará habilidades como resumo de vídeo de IA , ajuste fino de LLM e geração de imagens de IA .

É altamente recomendável assistir ao curso "Introdução à Inteligência Artificial Gerativa" do professor Li Hongyi para aprendizagem simultânea: acesso rápido aos links relacionados ao curso

Agora, o projeto também oferece CodePlayground. Você pode configurar o ambiente de acordo com a documentação, executar o script com uma linha de código e experimentar o charme da IA.

?Os ensaios de tese estão localizados no PaperNotes, e os artigos básicos relacionados a grandes modelos serão carregados gradualmente.

A imagem básica está pronta. Se você ainda não configurou seu próprio ambiente de aprendizado profundo, experimente o Docker.

Fazer boa viagem!

--- : Conhecimento básico, assista conforme necessário ou pule temporariamente. Os resultados do arquivo de código serão mostrados no artigo, mas ainda é recomendado executar o código manualmente. Pode haver requisitos de memória de vídeo.API : O artigo usa apenas API de modelos grandes, não está sujeito a restrições de dispositivo e pode ser executado sem GPU.LLM : Prática relacionada a modelos de linguagem grandes, arquivos de código podem ter requisitos de memória de vídeo.SD : Difusão Estável, uma prática relacionada aos diagramas vicentinos, e os arquivos de código possuem requisitos de memória de vídeo.File e o efeito de aprendizagem será o mesmo.Setting -> Accelerator ->选择GPU .代码执行程序->更改运行时类型->选择GPU .| Guia | Marcação | Descrever | Arquivo | On-line |

|---|---|---|---|---|

| 00. Etapas de obtenção da API Alibaba Big Model | API | Iremos guiá-lo passo a passo para obter a API. Se for a primeira vez que se cadastra, será necessário realizar uma verificação de identidade (reconhecimento facial). | ||

| 01. Primeira introdução à API LLM: configuração do ambiente e demonstração de diálogo multi-rodada | API | Esta é uma configuração e demonstração introdutória. O código de conversação é modificado nos documentos de desenvolvimento do Alibaba. | Código | Kaggle Colab |

| 02. Fácil de começar: crie aplicativos de IA por meio de API e Gradio | API | Oriente como usar o Gradio para construir um aplicativo simples de IA. | Código | Colab |

| 03. Guia avançado: personalize o prompt para melhorar os recursos de resolução de problemas de modelos grandes | API | Você aprenderá a personalizar um prompt para melhorar a capacidade de modelos grandes de resolver problemas matemáticos. Também serão fornecidas versões Gradio e não Gradio, e detalhes do código serão mostrados. | Código | Kaggle Colab |

| 04. Compreendendo o LoRA: da camada linear ao mecanismo de atenção | --- | Antes de entrar oficialmente na prática, você precisa conhecer os conceitos básicos do LoRA. Este artigo irá levá-lo desde a implementação do LoRA na camada linear até o mecanismo de atenção. | ||

05. Entenda a série AutoModel do Hugging Face: classes de carregamento automático de modelos para diferentes tarefas | --- | O módulo que estamos prestes a usar é AutoModel in Hugging Face. Este artigo também é um pré-requisito de conhecimento (é claro que você pode ignorá-lo e lê-lo mais tarde se tiver dúvidas). | Código | Kaggle Colab |

| 06. Comece: implante seu primeiro modelo de linguagem | LLM | Implementando uma implantação de modelo de linguagem muito básica, o projeto não possui requisitos rígidos para GPU até o momento, você pode continuar aprendendo. | Código app_fastapi.py app_flask.py | |

| 07. Explore a relação entre os parâmetros do modelo e a memória de vídeo e o impacto das diferentes precisão | --- | Compreender a correspondência entre os parâmetros do modelo e a memória de vídeo e dominar os métodos de importação de diferentes precisões tornará a seleção do seu modelo mais habilidosa. | ||

| 08. Tente ajustar o LLM: deixe-o escrever poesia Tang | LLM | Este artigo é igual ao 03. Guia Avançado: Personalizando o prompt para melhorar as habilidades de resolução de problemas de modelos grandes. Ele se concentra essencialmente em "usar" em vez de "escrever". seção de hiperparâmetros para ver o impacto no ajuste fino. | Código | Kaggle Colab |

| 09. Compreensão aprofundada do Beam Search: princípios, exemplos e implementação de código | --- | Indo de exemplos a demonstrações de código, explicando a matemática do Beam Search, isso deve esclarecer alguma confusão da leitura anterior e, finalmente, fornecer um exemplo simples de uso da biblioteca Hugging Face Transformers (você pode tentar se pulou o artigo anterior) . | Código | Kaggle Colab |

| 10. Top-K vs Top-P: Estratégia de amostragem e influência da temperatura em modelos generativos | --- | Além disso, mostrarei outras estratégias de geração. | Código | Kaggle Colab |

| 11. Exemplo de ajuste fino de DPO: Otimizando o modelo de linguagem grande LLM de acordo com as preferências humanas | LLM | Um exemplo de ajuste fino usando DPO. | Código | Kaggle Colab |

| 12. Atribuição de recurso Inseq: interprete visualmente o resultado do LLM | LLM | Exemplos visuais de tarefas de tradução e geração de texto (preencher as lacunas). | Código | Kaggle Colab |

| 13. Entenda possíveis preconceitos na IA | LLM | Nenhuma compreensão de código é necessária e pode ser usada como uma exploração divertida durante os momentos de lazer. | Código | Kaggle Colab |

| 14. PEFT: aplique LoRA rapidamente a modelos grandes | --- | Aprenda como adicionar camadas LoRA após importar o modelo. | Código | Kaggle Colab |

| 15. Use API para implementar o resumo de vídeo de IA: Faça seu próprio assistente de vídeo de IA | API e LLM | Você aprenderá os princípios por trás dos assistentes comuns de resumo de vídeo de IA e começará a implementar o resumo de vídeo de IA. | Código - versão completa Código - versão Lite ?roteiro | Kaggle Colab |

| 16. Use LoRA para ajustar a difusão estável: desmonte a fornalha de alquimia e implemente sua primeira pintura de IA | SD | Use LoRA para ajustar o modelo de diagrama Vincent e agora você também pode fornecer seus arquivos LoRA para outras pessoas. | Código Código - versão Lite | Kaggle Colab |

| 17. Uma breve discussão sobre a quantização do modelo RTN: assimétrico vs simétrico.md | --- | Para entender melhor o comportamento de quantificação do modelo RTN, este artigo usa INT8 como exemplo para explicar. | Código | Kaggle Colab |

| 18. Visão geral da tecnologia de quantificação de modelos e análise do formato de arquivo GGUF/GGML | --- | Este é um artigo de visão geral que pode tirar algumas de suas dúvidas ao usar GGUF/GGML. | ||

| 19a. Do carregamento à conversação: executando modelos grandes LLM quantizados (GPTQ e AWQ) localmente usando Transformers 19b. Do carregamento à conversação: executando modelos grandes LLM quantizados (GGUF) localmente usando Llama-cpp-python | LLM | Você implantará um modelo quantitativo com 7 bilhões (7B) de parâmetros em seu computador. Observe que este artigo não requer placa gráfica. 19 a Utilizando Transformers, envolvendo carregamento de modelos nos formatos GPTQ e AWQ. 19 b Usando Llama-cpp-python, envolvendo carregamento de modelo no formato GGUF. Além disso, você também completará a função de interação de diálogo do modelo local grande. | Transformadores de código Código-Llama-cpp-python ?roteiro | |

| 20. Prática introdutória do RAG: da divisão de documentos ao banco de dados vetorial e construção de perguntas e respostas | LLM | Práticas relacionadas ao RAG. Aprenda como funciona a fragmentação recursiva de texto. | Código | |

| 21. BPE vs WordPiece: Entenda o princípio de funcionamento do Tokenizer e do método de segmentação de subpalavras | --- | Operações básicas do Tokenizer. Aprenda sobre métodos comuns de segmentação de subpalavras: BPE e WordPiece. Entenda a máscara de atenção (Máscara de atenção) e os IDs de tipo de token (IDs de tipo de token). | Código | Kaggle Colab |

| 22. Tarefa - Bert ajustando a resposta a perguntas extrativas | Esta é uma tarefa que usa BERT para ajustar as tarefas posteriores de perguntas e respostas. Você pode experimentá-la e tentar participar da "competição" do Kaggle. Um artigo guia com todas as dicas será fornecido após uma semana. ou deixe para depois. O artigo introdutório não cobrirá a descrição da tarefa e duas versões do código serão carregadas para aprendizado, então não se preocupe. Não haverá prazo aqui. | Código - Atribuição | Kaggle Colab |

Dica

Se você preferir extrair o warehouse para ler .md localmente, quando ocorrer um erro de fórmula, use Ctrl+F ou Command+F , procure por \_ e substitua tudo por _ .

Leitura adicional:

| Guia | Descrever |

|---|---|

| a. Use HFD para acelerar o download de modelos e conjuntos de dados do Hugging Face. | Se você achar que o download do modelo está muito lento, consulte este artigo para configuração. Se você encontrar erros 443 relacionados ao proxy, também pode tentar verificar este artigo. |

| b. Verificação rápida dos comandos básicos da linha de comando (aplicáveis ao Linux/Mac) | Uma verificação rápida de comando de linha de comando contém basicamente todos os comandos envolvidos no warehouse atual. Verifique-o quando estiver confuso. |

| c. Soluções para alguns problemas | Aqui resolveremos alguns problemas que podem ser encontrados durante a operação do projeto. - Como puxar o armazém remoto para substituir todas as modificações locais? - Como visualizar e excluir arquivos baixados pelo Hugging Face e como modificar o caminho para salvar? |

| d. Como carregar o modelo GGUF (solução para Shared/Shared/Split/00001-of-0000...) | - Conheça os novos recursos do Transformers sobre o GGUF. - Use Transformers/Llama-cpp-python/Ollama para carregar arquivos de modelo no formato GGUF. - Aprenda a mesclar arquivos GGUF fragmentados. - Resolva o problema de que o LLama-cpp-python não pode ser descarregado. |

| e. Aprimoramento de dados: análise de métodos comuns de torchvision.transforms | - Compreender os métodos de melhoria de dados de imagem comumente usados. Código | |

| f. Função de perda de entropia cruzada nn.CrossEntropyLoss() explicação detalhada e lembrete de pontos-chave (PyTorch) | - Compreender os princípios matemáticos da perda de entropia cruzada e da implementação do PyTorch. - Aprenda no que prestar atenção ao usá-lo pela primeira vez. |

| g. Camada de incorporação nn.Embedding() explicação detalhada e lembrete de pontos principais (PyTorch) | - Compreender os conceitos de incorporação de camadas e incorporação de palavras. - Visualize a incorporação usando modelos pré-treinados. Código | |

| h. Use o Docker para configurar rapidamente o ambiente de aprendizagem profunda (Linux) h. Introdução aos comandos básicos do Docker e resolução de erros comuns | - Use duas linhas de comandos para configurar o ambiente de aprendizagem profunda - Introdução aos comandos básicos do Docker - Resolva três erros comuns durante o uso |

Explicação da pasta:

Demonstrações

Todos os arquivos de código serão armazenados lá.

dados

Não há necessidade de ficar atento a esta pasta para armazenar pequenos dados que podem ser utilizados no código.

GenAI_PDF

Aqui estão os arquivos PDF das tarefas do curso [Introdução à Inteligência Artificial Generativa]. Eu os carreguei porque foram originalmente salvos no Google Drive.

Guia

Todos os documentos de orientação serão armazenados lá.

ativos

Aqui estão as imagens usadas no arquivo .md. Não há necessidade de prestar atenção a esta pasta.

Notas de papel

Ensaio de Tese.

CodePlayground

Alguns exemplos interessantes de scripts de código (versão Toy).

README.md

sumário.py ?script

Resumo de vídeo/áudio/legendas AI.

chat.py?script

Conversa de IA.

Introdução aos recursos de aprendizagem de inteligência artificial generativa

Página inicial do curso

Vídeo oficial | YouTube |

A produção e compartilhamento da versão espelhada chinesa foi autorizada pelo professor Li Hongyi. Obrigado ao professor por seu altruísta compartilhamento de conhecimento!

A imagem PS chinesa realizará totalmente todas as funções do código de trabalho (operação local Kaggle é uma plataforma online que pode ser conectada diretamente na China. O conteúdo do Colab chinês e do Kaggle é consistente. Basta escolher um deles para concluir o estudo.

De acordo com as necessidades reais, selecione um método abaixo para preparar o ambiente de aprendizagem, clique em ► ou no texto para expandir .

Kaggle (conexão direta doméstica, recomendada): Leia o artigo "Kaggle: Guia de uso gratuito de GPU, uma alternativa ideal ao Colab" para saber mais.

Colab (requer acesso científico à Internet)

Os arquivos de código do projeto são sincronizados em ambas as plataformas.

Linux (Ubuntu) :

sudo apt-get update

sudo apt-get install gitmacOS :

Instale o Homebrew primeiro:

/bin/bash -c " $( curl -fsSL https://raw.githubusercontent.com/Homebrew/install/HEAD/install.sh ) "Então execute:

brew install gitJanelas :

Baixe e instale do Git para Windows.

Linux (Ubuntu) :

sudo apt-get update

sudo apt-get install wget curlmacOS :

brew install wget curlJanelas :

Baixe e instale nos sites oficiais do Wget para Windows e Curl.

Visite o site oficial do Anaconda, digite seu endereço de e-mail e verifique seu e-mail. Você deverá ver:

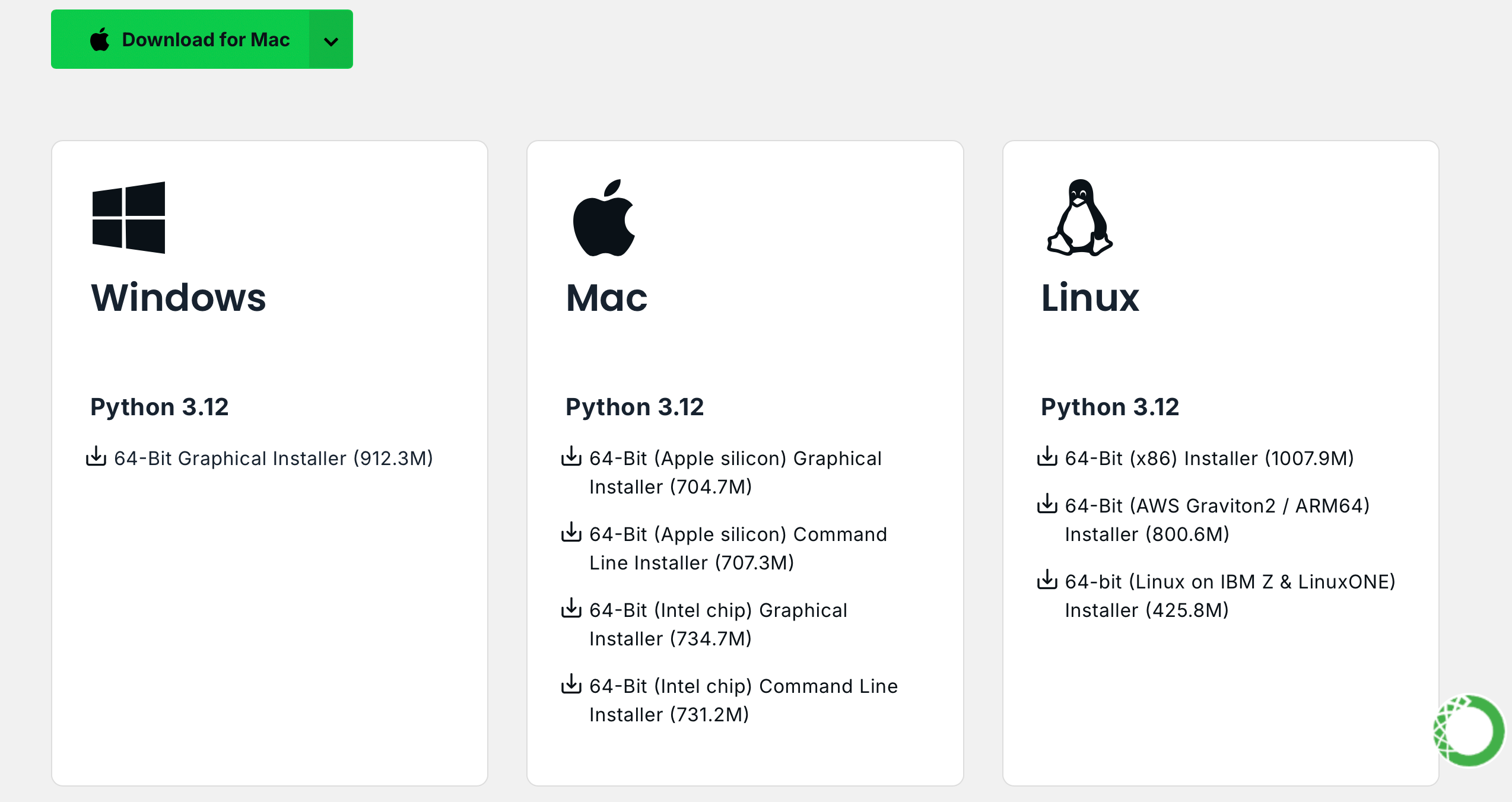

Clique em Download Now , selecione a versão apropriada e faça o download (ambos Anaconda e Miniconda estão disponíveis):

Linux (Ubuntu) :

Instale o Anaconda

Visite repo.anaconda.com para seleção de versão.

# 下载 Anaconda 安装脚本(以最新版本为例)

wget https://repo.anaconda.com/archive/Anaconda3-2024.10-1-Linux-x86_64.sh

# 运行安装脚本

bash Anaconda3-2024.10-1-Linux-x86_64.sh

# 按照提示完成安装(先回车,空格一直翻页,翻到最后输入 yes,回车)

# 安装完成后,刷新环境变量或者重新打开终端

source ~ /.bashrcInstale Miniconda (recomendado)

Visite repo.anaconda.com/miniconda para seleção de versão. Miniconda é uma versão simplificada do Anaconda, contendo apenas Conda e Python.

# 下载 Miniconda 安装脚本

wget https://repo.anaconda.com/miniconda/Miniconda3-latest-Linux-x86_64.sh

# 运行安装脚本

bash Miniconda3-latest-Linux-x86_64.sh

# 按照提示完成安装(先回车,空格一直翻页,翻到最后输入 yes,回车)

# 安装完成后,刷新环境变量或者重新打开终端

source ~ /.bashrcmacOS :

Substitua correspondentemente o URL no comando do Linux.

Instale o Anaconda

Visite repo.anaconda.com para seleção de versão.

Instale Miniconda (recomendado)

Visite repo.anaconda.com/miniconda para seleção de versão.

Digite o seguinte comando no terminal. Se as informações da versão forem exibidas, a instalação foi bem-sucedida.

conda --versioncat << ' EOF ' > ~/.condarc

channels:

- defaults

show_channel_urls: true

default_channels:

- https://mirror.nju.edu.cn/anaconda/pkgs/main

- https://mirror.nju.edu.cn/anaconda/pkgs/r

- https://mirror.nju.edu.cn/anaconda/pkgs/msys2

custom_channels:

conda-forge: https://mirror.nju.edu.cn/anaconda/cloud

pytorch: https://mirror.nju.edu.cn/anaconda/cloud

EOF[!observação]

Muitas fontes de espelho que estavam disponíveis no ano passado não estão mais disponíveis para a configuração atual de outros sites de espelho, você pode consultar este documento muito bom da NTU: Mirror Usage Help.

Nota : Se o Anaconda ou Miniconda já estiver instalado, pip será incluído no sistema e nenhuma instalação adicional será necessária.

Linux (Ubuntu) :

sudo apt-get update

sudo apt-get install python3-pipmacOS :

brew install python3Janelas :

Baixe e instale o Python, certificando-se de que a opção "Adicionar Python ao PATH" esteja marcada.

Abra um prompt de comando e digite:

python -m ensurepip --upgradeDigite o seguinte comando no terminal. Se as informações da versão forem exibidas, a instalação foi bem-sucedida.

pip --versionpip config set global.index-url https://mirrors.aliyun.com/pypi/simpleExtraia o projeto com o seguinte comando:

git clone https://github.com/Hoper-J/AI-Guide-and-Demos-zh_CN.git

cd AI-Guide-and-Demos-zh_CNNão há limite de versão, pode ser superior:

conda create -n aigc python=3.9 Pressione y e enter para continuar. Após a conclusão da criação, ative o ambiente virtual:

conda activate aigcEm seguida, você precisa instalar as dependências básicas. Consulte o site oficial do PyTorch, tomando CUDA 11.8 como exemplo (se a placa gráfica não suportar 11.8, você precisa alterar o comando), escolha um dos dois para instalar:

# pip

pip3 install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu118

# conda

conda install pytorch torchvision torchaudio pytorch-cuda=11.8 -c pytorch -c nvidiaAgora configuramos com sucesso todos os ambientes necessários e estamos prontos para começar a aprender :) As dependências restantes serão listadas separadamente em cada artigo.

[!observação]

As imagens Docker possuem dependências pré-instaladas, portanto não há necessidade de reinstalá-las.

Primeiro instale jupyter-lab , que é muito mais fácil de usar do que jupyter notebook .

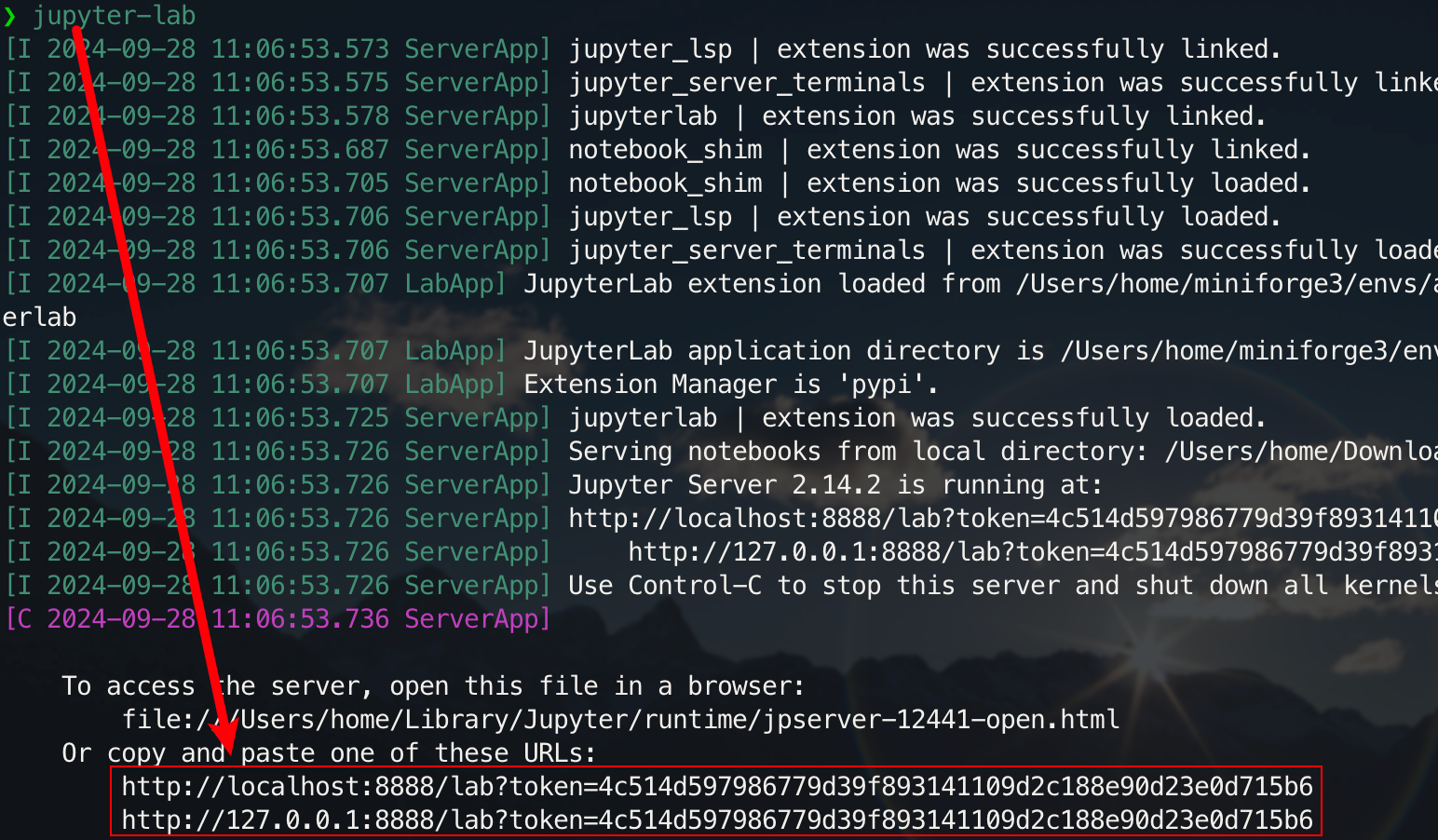

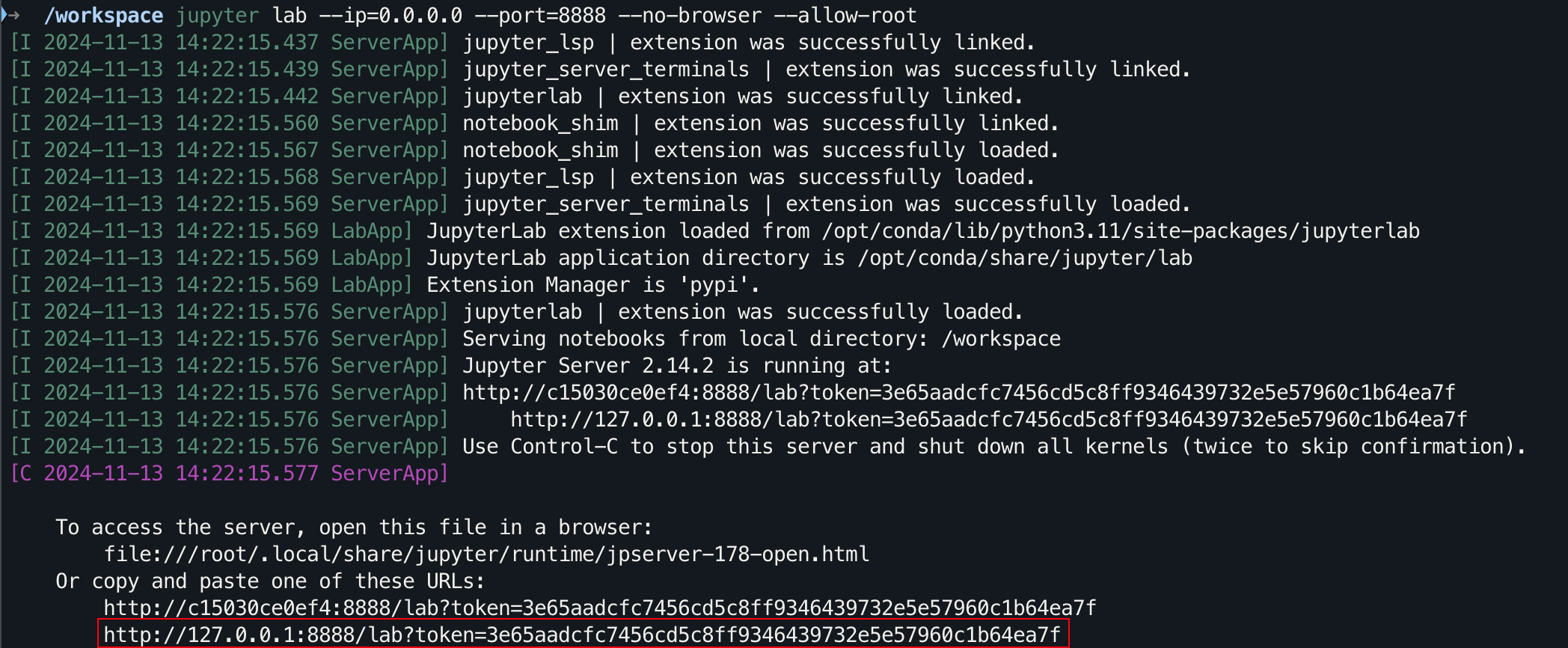

pip install jupyterlabApós a conclusão da instalação, execute o seguinte comando:

jupyter-lab

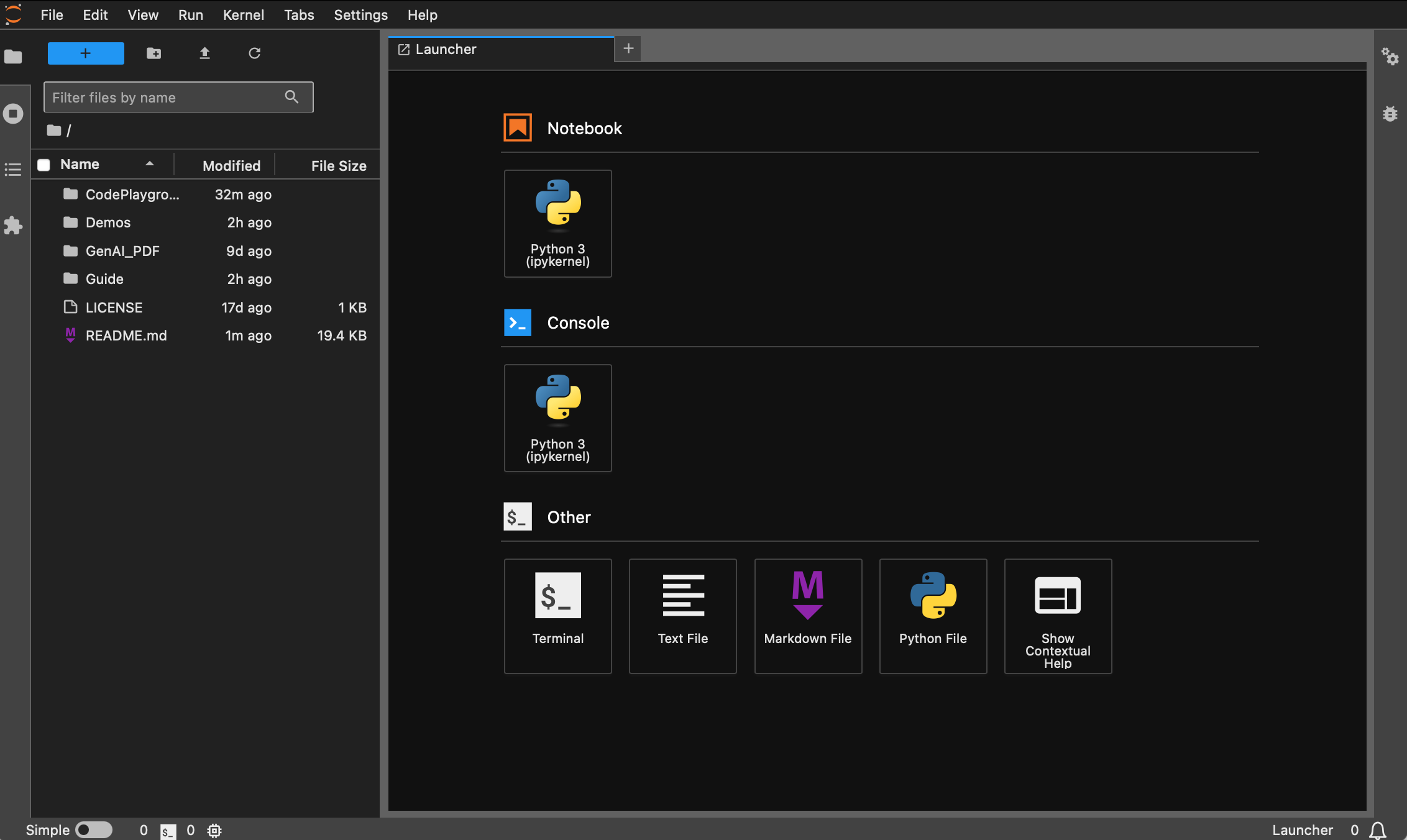

Agora você poderá acessá-lo através do link pop-up, geralmente localizado na porta 8888. Para a interface gráfica, mantenha pressionada Ctrl no Windows/Linux, mantenha pressionada a tecla Command no Mac e clique no link para pular diretamente. Neste ponto, você terá uma visão completa do projeto:

Os alunos que não instalaram o Docker podem ler o artigo "Use o Docker para configurar rapidamente o ambiente de aprendizado profundo (Linux)". Recomenda-se que os iniciantes leiam "Introdução aos comandos básicos do Docker e resolução de erros comuns".

Todas as versões são pré-instaladas com ferramentas comuns como sudo , pip , conda , wget , curl e vim , e as fontes de imagem domésticas de pip e conda foram configuradas. Ao mesmo tempo, ele integra zsh e alguns plug-ins práticos de linha de comando (preenchimento automático de comando, destaque de sintaxe e ferramenta de salto de diretório z ). Além disso, jupyter notebook e jupyter lab foram pré-instalados e o terminal padrão é definido como zsh para facilitar o desenvolvimento do aprendizado profundo. A exibição em chinês no contêiner foi otimizada para evitar caracteres ilegíveis. O endereço do espelho doméstico do Hugging Face também está pré-configurado.

pytorch/pytorch:2.5.1-cuda11.8-cudnn9-devel . A versão padrão python é 3.11.10. A versão pode ser modificada diretamente por meio de conda install python==版本号.Instalação adequada :

wget , curl : ferramentas de download de linha de comandovim , nano : editor de textogit : ferramenta de controle de versãogit-lfs : Git LFS (armazenamento de arquivos grandes)zip , unzip : ferramentas de compactação e descompactação de arquivoshtop : ferramenta de monitoramento do sistematmux , screen : ferramentas de gerenciamento de sessãobuild-essential : ferramentas de compilação (como gcc , g++ )iputils-ping , iproute2 , net-tools : ferramentas de rede (fornecendo comandos como ping , ip , ifconfig , netstat , etc.)ssh : ferramenta de conexão remotarsync : ferramenta de sincronização de arquivostree : exibe árvores de arquivos e diretórioslsof : Visualiza os arquivos atualmente abertos no sistemaaria2 : ferramenta de download multithreadlibssl-dev : biblioteca de desenvolvimento OpenSSLinstalação do pip :

jupyter notebook , jupyter lab : ambiente de desenvolvimento interativovirtualenv : ferramenta de gerenciamento de ambiente virtual Python, você pode usar conda diretamentetensorboard : ferramenta de visualização de treinamento de aprendizado profundoipywidgets : biblioteca de widgets Jupyter para exibir barras de progresso corretamentePlug-in :

zsh-autosuggestions : preenchimento automático do comandozsh-syntax-highlighting : destaque de sintaxez : Salta rapidamente para o diretórioA versão dl (Deep Learning) é baseada na base e instala adicionalmente ferramentas e bibliotecas básicas que podem ser usadas em deep learning:

Instalação adequada :

ffmpeg : ferramenta de processamento de áudio e vídeolibgl1-mesa-glx : Dependência da biblioteca gráfica (resolve alguns problemas relacionados a gráficos da estrutura de aprendizado profundo)instalação do pip :

numpy , scipy : cálculos numéricos e cálculos científicospandas : análise de dadosmatplotlib , seaborn : visualização de dadosscikit-learn : ferramentas de aprendizado de máquinatensorflow , tensorflow-addons : outra estrutura popular de aprendizado profundotf-keras : implementação TensorFlow da interface Kerastransformers , datasets : ferramentas de PNL fornecidas por Hugging Facenltk , spacy : ferramentas de processamento de linguagem naturalSe forem necessárias bibliotecas adicionais, elas poderão ser instaladas manualmente com o seguinte comando:

pip install --timeout 120 <替换成库名> Aqui --timeout 120 define um tempo limite de 120 segundos para garantir que ainda haja tempo suficiente para instalação, mesmo se a rede estiver ruim. Se você não configurá-lo, poderá encontrar uma situação em que o pacote de instalação falhará devido ao tempo limite de download em um ambiente doméstico.

Observe que todas as imagens não serão retiradas do armazém com antecedência.

Supondo que você instalou e configurou o Docker, você só precisa de duas linhas de comando para concluir a configuração do ambiente de aprendizado profundo. Para o projeto atual, você pode fazer uma seleção após visualizar a descrição da versão. O image_name:tag correspondente dos dois é como. segue:

hoperj/quickstart:base-torch2.5.1-cuda11.8-cudnn9-develhoperj/quickstart:dl-torch2.5.1-cuda11.8-cudnn9-develO comando pull é:

docker pull < image_name:tag >A seguir, use a versão dl como exemplo para demonstrar o comando. Escolha um dos métodos para concluir.

docker pull dockerpull.org/hoperj/quickstart:dl-torch2.5.1-cuda11.8-cudnn9-develdocker pull hoperj/quickstart:dl-torch2.5.1-cuda11.8-cudnn9-develOs arquivos podem ser baixados através do Baidu Cloud Disk (o Alibaba Cloud Disk não oferece suporte ao compartilhamento de arquivos compactados grandes).

Os arquivos com o mesmo nome possuem o mesmo conteúdo.

.tar.gzé uma versão compactada. Após o download, descompacte-o com o seguinte comando:gzip -d dl.tar.gz

Supondo dl.tar seja baixado em ~/Downloads , mude para o diretório correspondente:

cd ~ /DownloadsEm seguida, carregue a imagem:

docker load -i dl.tarNeste modo, o contêiner usará diretamente a configuração de rede do host e todas as portas serão iguais às portas do host sem mapeamento separado. Se você precisar apenas mapear uma porta específica, substitua

--network hostpor-p port:port.

docker run --gpus all -it --name ai --network host hoperj/quickstart:dl-torch2.5.1-cuda11.8-cudnn9-devel /bin/zsh Para alunos que precisam usar um proxy, adicione -e para definir variáveis de ambiente. Você também pode consultar o artigo estendido a:

Suponha que o número da porta HTTP/HTTPS do proxy seja 7890 e SOCKS5 seja 7891:

-e http_proxy=http://127.0.0.1:7890-e https_proxy=http://127.0.0.1:7890-e all_proxy=socks5://127.0.0.1:7891Integrado ao comando anterior:

docker run --gpus all -it

--name ai

--network host

-e http_proxy=http://127.0.0.1:7890

-e https_proxy=http://127.0.0.1:7890

-e all_proxy=socks5://127.0.0.1:7891

hoperj/quickstart:dl-torch2.5.1-cuda11.8-cudnn9-devel

/bin/zsh[!dica]

Confira as operações comuns com antecedência :

- Inicie o contêiner :

docker start <容器名>- Execute o contêiner :

docker exec -it <容器名> /bin/zsh

- Saia dentro do contêiner :

Ctrl + Douexit.- Pare o contêiner :

docker stop <容器名>- Exclua um contêiner :

docker rm <容器名>

git clone https://github.com/Hoper-J/AI-Guide-and-Demos-zh_CN.git

cd AI-Guide-and-Demos-zh_CNjupyter lab --ip=0.0.0.0 --port=8888 --no-browser --allow-root

Para a interface gráfica, mantenha pressionada Ctrl no Windows/Linux, mantenha pressionada a tecla Command no Mac e clique no link para pular diretamente.

Obrigado pela sua ESTRELA ?, espero que isso ajude.