minichat

1.0.0

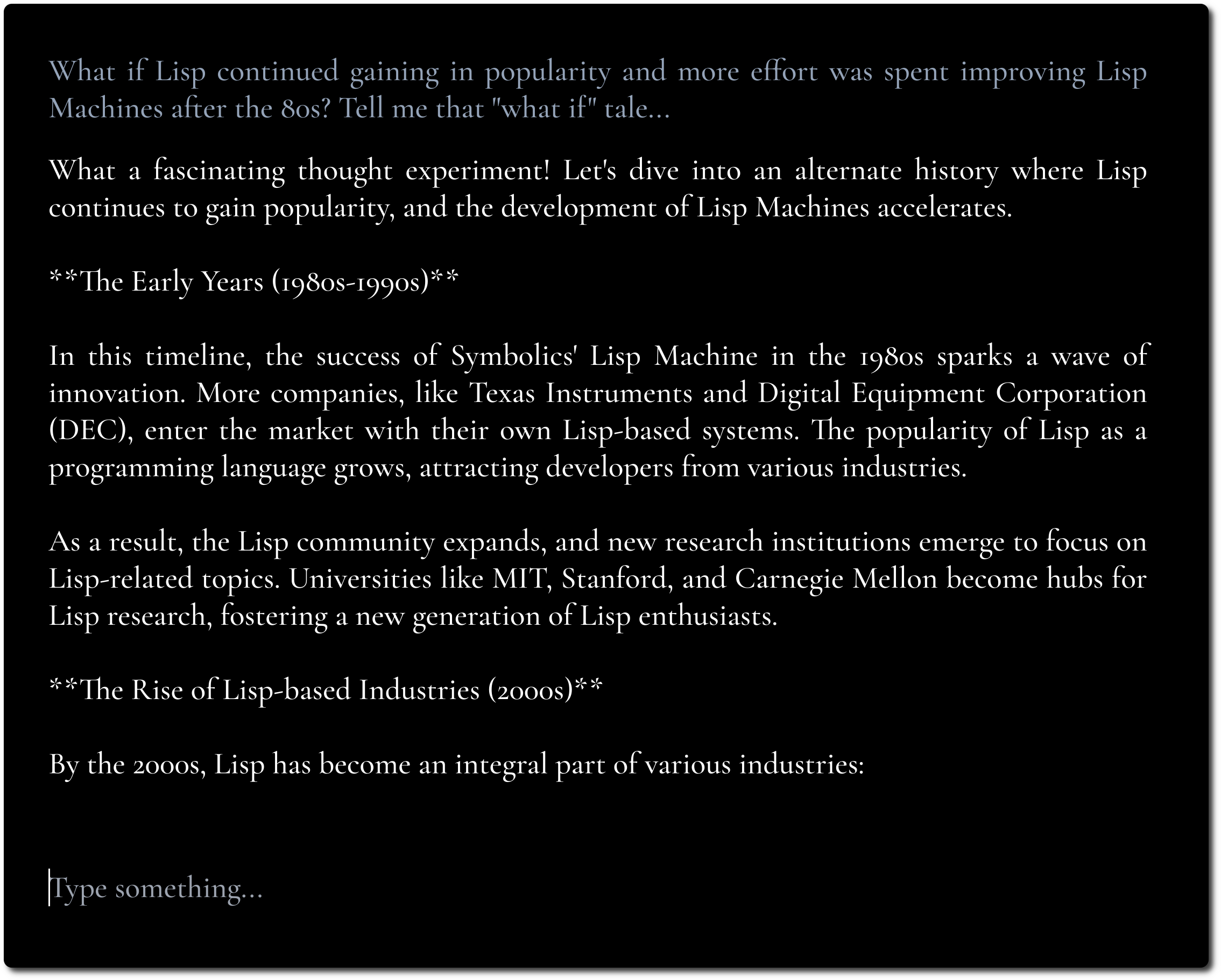

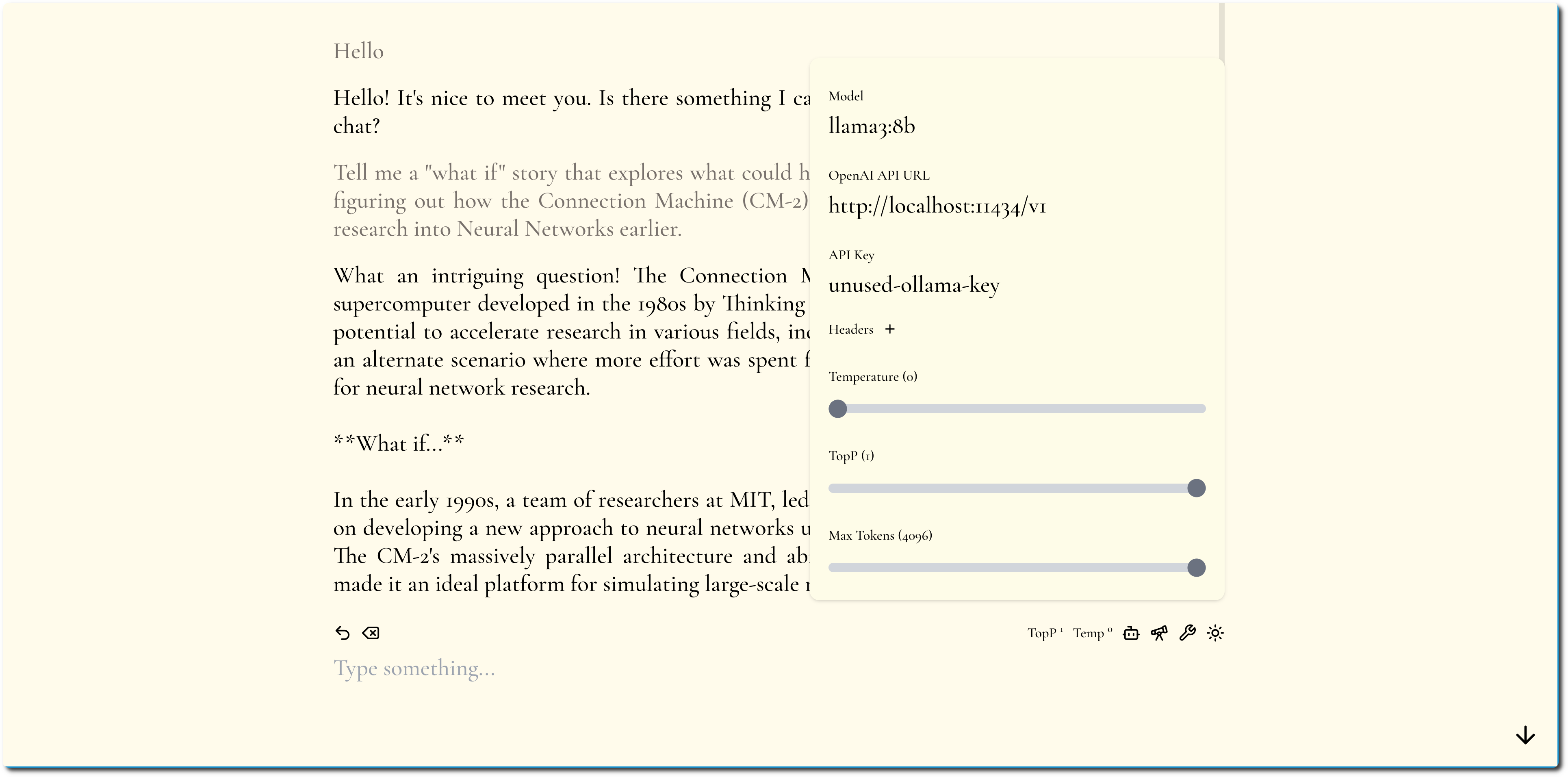

Uma interface de chat LLM minimalista, inspirada em Fooocus e Pi.

Se você tiver um endpoint de API habilitado para CORS para usar, você pode experimentá-lo aqui.

O objetivo é focar no conteúdo e esconder o máximo possível de ajustes e ajustes.

Enfatizamos o conteúdo usando tipografia ousada e design minimalista.

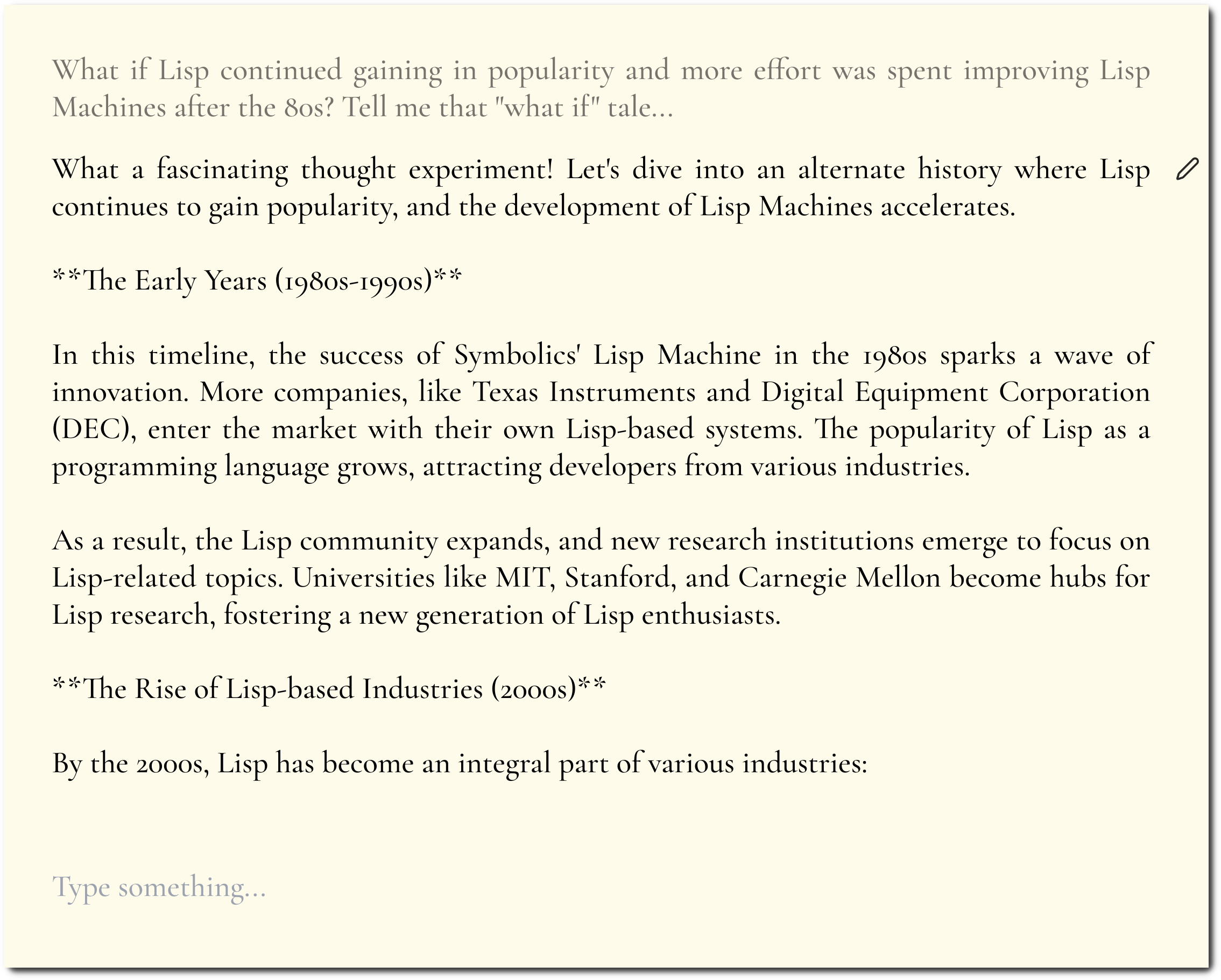

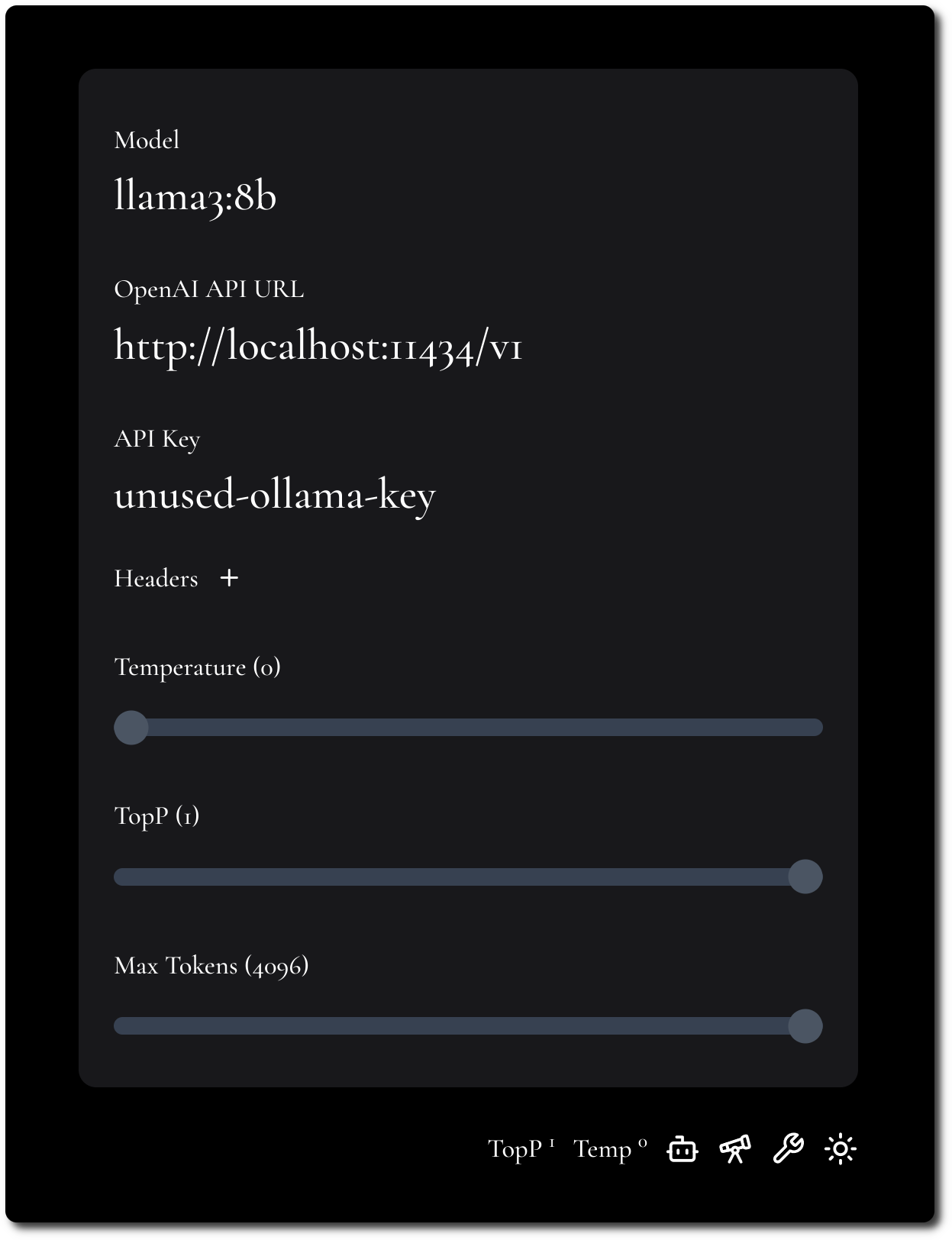

Tentamos manter a configuração mínima, mas flexível.

MiniChat oferece suporte a APIs compatíveis com OpenAI, consulte a seção Docker Compose para executar o MiniChat com vários provedores de modelo, aproveitando gateways como Portkey.

Você pode executar o MiniChat com Docker, a imagem tem menos de 2 MB.

docker run -p 3216:3216 ghcr.io/functorism/minichat:master

Correr

docker compose -f docker-compose-ollama.yml up

docker exec minichat-ollama-1 ollama pull llama3:8b

Configurações da IU:

Correr

docker compose -f docker-compose-portkey.yml up

Configurações da IU:

Correr

docker compose -f docker-compose-tf-tgi.yml up

Configurações da IU: