Organização: Universidade de Nova Gales do Sul(UNSW) AI4Science & GreenDynamics AI

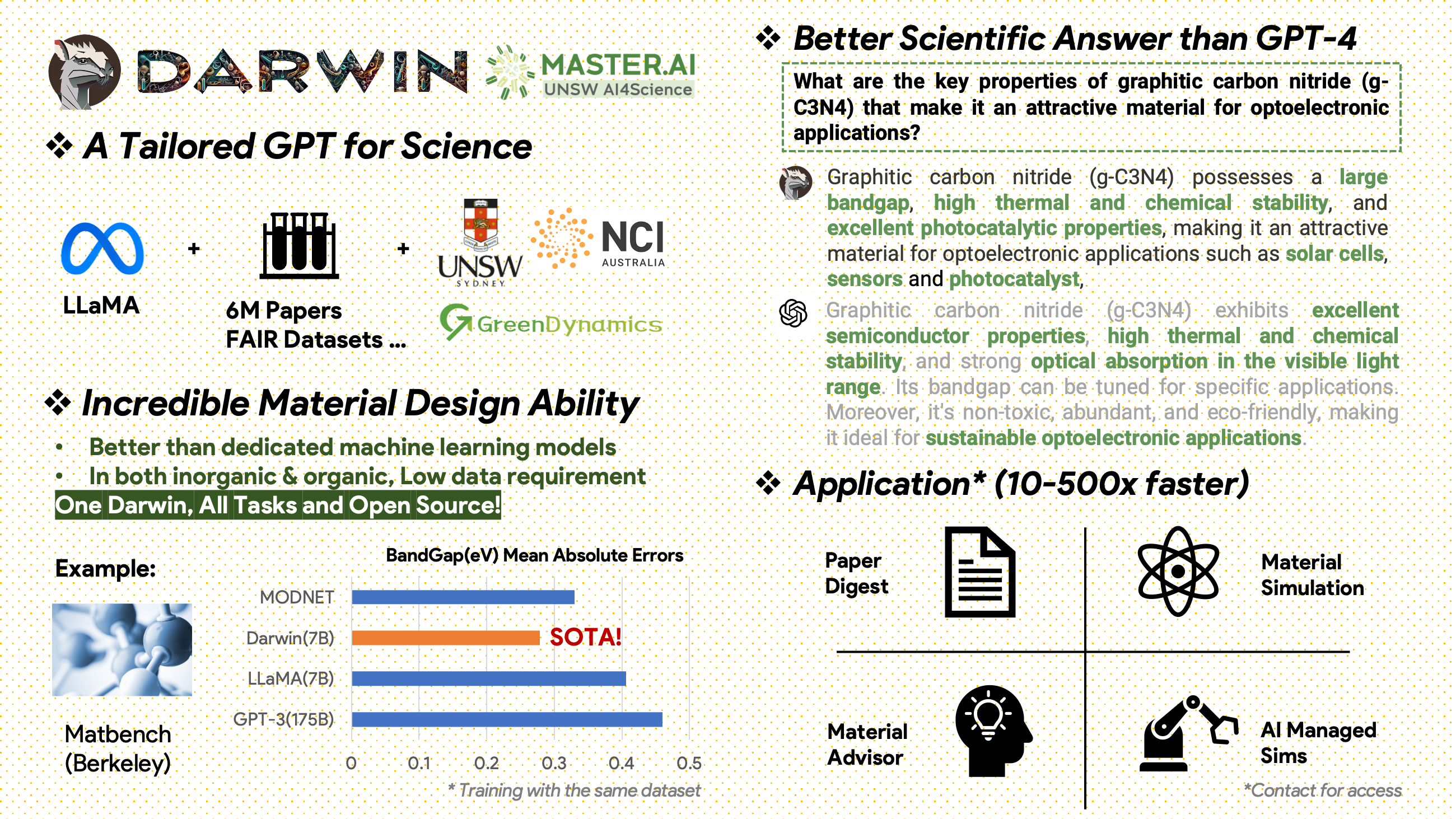

Darwin é um projeto de código aberto dedicado a pré-treinar e ajustar o modelo LLaMA em literatura científica e conjuntos de dados. Projetado especificamente para o domínio científico com ênfase na ciência dos materiais, química e física, Darwin integra conhecimento científico estruturado e não estruturado para aumentar a eficácia dos modelos de linguagem na pesquisa científica.

Avisos de uso e licença : Darwin é licenciado e destinado apenas para uso em pesquisa. O conjunto de dados é licenciado sob CC BY NC 4.0, permitindo uso não comercial. Os modelos treinados com este conjunto de dados não devem ser usados fora dos fins de pesquisa. A diferença de peso também está sob licença CC BY NC 4.0

[2024.11.20]

Principais conquistas

Insights de desempenho do modelo

Estratégias e insights de dados

[2024.02.15] SOTA no MatBench por Material Projects: DARWIN é o modelo SOTA em tarefas experimentais de previsão de bandgap e tarefas de classificação metálica, melhor do que GPT3.5 ajustado e modelos de ML dedicados. https://matbench.materialsproject.org/Leaderboards%20Per-Task/matbench_v0.1_matbench_expt_gap/

☆ [2023.09.15] Versão do Google Colab disponível: experimente nosso DARWIN com Google Colab: inference.ipynb

Darwin, baseado no modelo 7B LLaMA, é treinado em mais de 100.000 pontos de dados de seguimento de instruções gerados pelo Darwin Scientific Instruction Generator (SIG) a partir de vários conjuntos de dados científicos FAIR e um corpus de literatura. Ao focar na exatidão factual das respostas do modelo, Darwin representa um avanço significativo no sentido de aproveitar os Grandes Modelos de Linguagem (LLMs) para a descoberta científica. Avaliações humanas preliminares indicam que o Darwin 7B supera o GPT-4 em perguntas e respostas científicas e o GPT-3 aprimorado na resolução de problemas de química (como gptChem).

Estamos desenvolvendo ativamente o Darwin para experimentos de domínio científico mais avançados e também integrando o Darwin ao LangChain para resolver tarefas científicas mais complexas (como um assistente de pesquisa privado para computadores pessoais).

Observe que Darwin ainda está em desenvolvimento e muitas limitações precisam ser abordadas. Mais importante ainda, ainda temos que ajustar o Darwin para segurança máxima. Incentivamos os usuários a relatar qualquer comportamento preocupante para ajudar a melhorar a segurança e as considerações éticas do modelo.

LINK DE DEMONSTRAÇÃO

Primeiro instale os requisitos:

pip install -r requirements.txtBaixe os pontos de verificação dos pesos Darwin-7B do onedrive. Depois de baixar o modelo, você pode experimentar nossa demonstração:

python inference.py < your path to darwin-7b >Observe que a inferência requer pelo menos 10 GB de memória GPU para o Darwin 7B.

Para ajustar ainda mais nosso Darwin-7b com diferentes conjuntos de dados, abaixo está um comando que funciona em uma máquina com 4 GPUs A100 80G.

torchrun --nproc_per_node=8 --master_port=1212 train.py

--model_name_or_path < your path to darwin-7b >

--data_path < your path to dataset >

--bf16 True

--output_dir < your output dir >

--num_train_epochs 3

--per_device_train_batch_size 1

--per_device_eval_batch_size 1

--gradient_accumulation_steps 1

--evaluation_strategy " no "

--save_strategy " steps "

--save_steps 500

--save_total_limit 1

--learning_rate 2e-5

--weight_decay 0.

--warmup_ratio 0.03

--lr_scheduler_type " cosine "

--logging_steps 1

--fsdp " full_shard auto_wrap "

--fsdp_transformer_layer_cls_to_wrap ' LlamaDecoderLayer '

--tf32 FalseNossos dados vêm de duas fontes principais:

Um corpus de literatura bruta contendo 6,0 milhões de artigos sobre ciência de materiais, química e física foi publicado depois de 2000. Os editores incluem ACS, RSC, Springer Nature, Wiley e Elsevier. Agradecemos a eles pelo apoio.

Conjuntos de dados FAIR - Coletamos dados de 16 conjuntos de dados FAIR.

Desenvolvemos o Darwin-SIG para gerar instruções científicas. Ele pode memorizar textos longos de textos completos de literatura (média de aproximadamente 5.000 palavras) e gerar dados de perguntas e respostas (Q&A) com base em palavras-chave de literatura científica (da API da web of science)

Nota: Você também pode usar GPT3.5 ou GPT-4 para geração, mas essas opções podem ser caras.

Esteja ciente de que não podemos compartilhar o conjunto de dados de treinamento devido a acordos com os editores.

Este projeto é um esforço colaborativo dos seguintes:

UNSW e GreenDynamics: Tong Xie, Shaozhou Wang

UNSW: Imran Razzak, Cody Huang

Centro USYD e DARE: Clara Grazian

GreenDynamics: Yuwei Wan, Yixuan Liu

Bram Hoex e Wenjie Zhang da UNSW Engineering aconselharam a todos.

Se você usar os dados ou código deste repositório em seu trabalho, cite-os adequadamente.

Modelo básico de linguagem grande DAWRIN e ajuste fino de instrução semi-automática

@misc{xie2023darwin,

title={DARWIN Series: Domain Specific Large Language Models for Natural Science},

author={Tong Xie and Yuwei Wan and Wei Huang and Zhenyu Yin and Yixuan Liu and Shaozhou Wang and Qingyuan Linghu and Chunyu Kit and Clara Grazian and Wenjie Zhang and Imran Razzak and Bram Hoex},

year={2023},

eprint={2308.13565},

archivePrefix={arXiv},

primaryClass={cs.CL}

}

GPT-3 e LLaMA aprimorados para descoberta de materiais (treinamento de tarefa única)

@article{xie2023large,

title={Large Language Models as Master Key: Unlocking the Secrets of Materials Science},

author={Xie, Tong and Wan, Yuwei and Zhou, Yufei and Huang, Wei and Liu, Yixuan and Linghu, Qingyuan and Wang, Shaozhou and Kit, Chunyu and Grazian, Clara and Zhang, Wenjie and others},

journal={Available at SSRN 4534137},

year={2023}

}

Este projeto referiu-se aos seguintes projetos de código aberto:

Agradecimentos especiais à NCI Austrália pelo suporte ao HPC.

Expandimos continuamente a equipe de desenvolvimento de Darwin. Junte-se a nós nesta emocionante jornada de avanço da pesquisa científica com IA!

Para cargos de doutorado ou pós-doutorado, entre em contato com [email protected] ou [email protected] para obter detalhes.

Para outras posições, visite www.greendynamics.com.au