ai-fun é uma biblioteca experimental de funções alimentada por LLM. Ele permite definir a finalidade da função, os parâmetros e o esquema de saída e gera e executa o código para você em segundo plano. Pense no Cursor/GitHub Copilot, mas como uma biblioteca conectável.

npm i ai-fun

Exemplo completo:

example.ts

import { z } from 'zod'

import AIFunctionBuilder from 'ai-fun'

import NodeExec from 'ai-fun/src/backends/node'

import { anthropic } from '@ai-sdk/anthropic'

// Provide a LLM model

const llm = anthropic . chat ( 'claude-3-5-sonnet-20240620' )

// Create a new AI Function Builder using Node/exec backend

const backend = new NodeExec ( )

const ai = new AIFunctionBuilder ( llm , backend )

// Define the input parameters and output parameters of the function

const parameters = z . object ( { a : z . number ( ) , b : z . number ( ) } )

const output = z . number ( )

// Generate the function

const f = await ai . function ( 'add values provided' , parameters , output )

// Call the function and log the result

const result = await f ( { a : 1 , b : 2 } )

console . log ( result )Saída:

> bun example.ts

3Mais exemplos encontrados em exemplos/

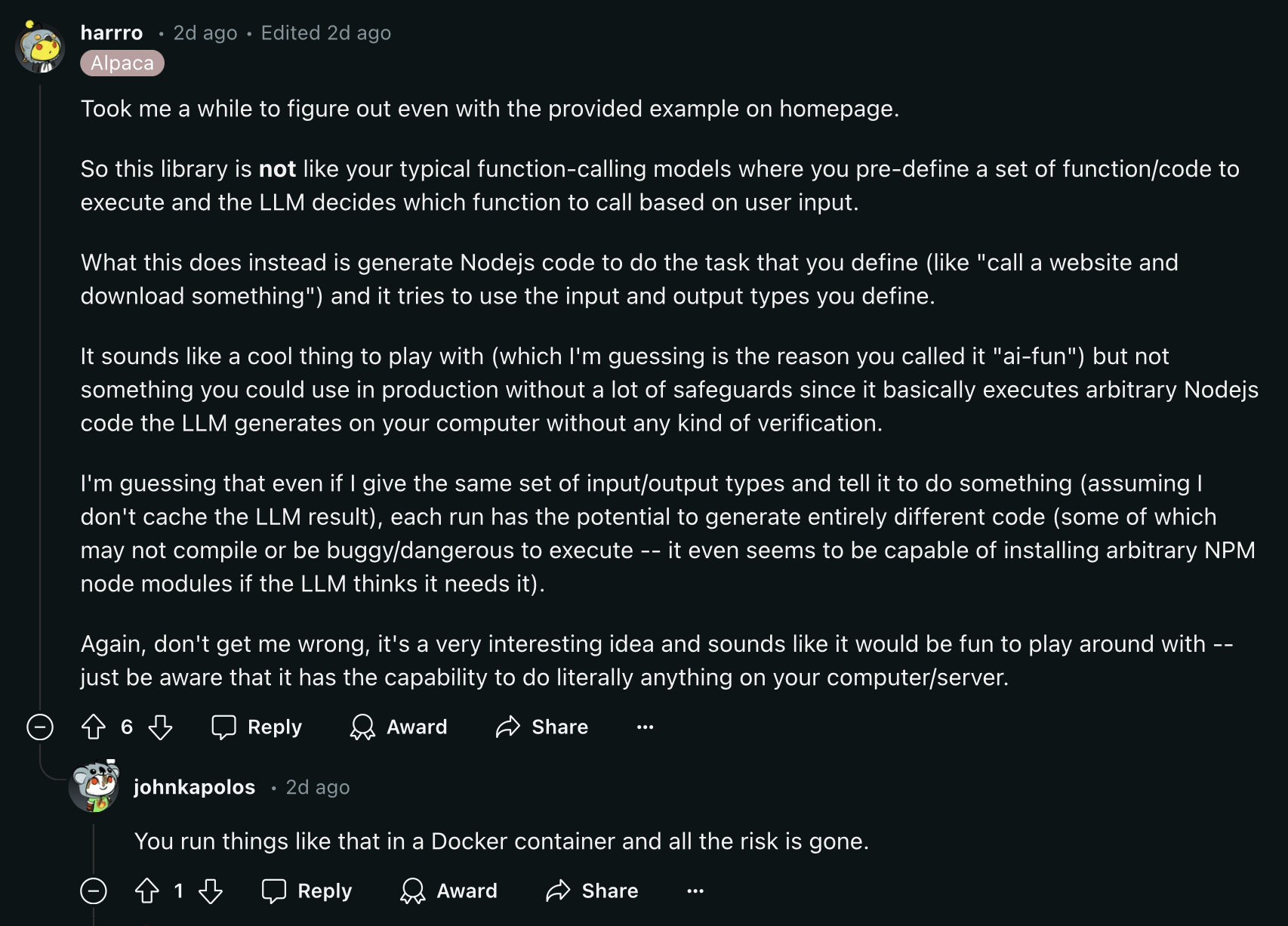

Leia este comentário do Reddit antes de continuar:

O cache de funções é habilitado por padrão para medidas de redução de custos. Por padrão, as funções são armazenadas em um arquivo chamado .ai-fun.json .

Opções que você pode fornecer ao AIFunctionBuilder :

{

debug ?: boolean

esModules?: boolean

cache?: boolean

cacheFile?: string

} Você pode criar seus próprios back-ends implementando a classe AIFunctionBackend :

export abstract class AIFunctionBackend {

abstract init ( codeContent : CodeContent ) : Promise < void >

abstract exec ( params : any ) : Promise < any >

}Veja src/backends/node por exemplo.

Executa as funções geradas pela IA usando a função node:vm exec.

Opções:

{

debug ?: boolean

packageFile?: string

installPackages?: boolean

} Como um projeto de código aberto, aceitamos contribuições da comunidade. Se você estiver enfrentando algum bug ou quiser adicionar algumas melhorias, sinta-se à vontade para abrir um problema ou pull request.