“É como se o AutoGPT tivesse uma brew install ”, possibilitada pela Kurtosis.

NOTA : Agora funciona com 0.4.0, que elimina o suporte para Milvus, Weaviate e PineCone. Você pode executar o Kurtosis em 0.3.1 fazendo kurtosis run github.com/kurtosis-tech/[email protected] com os argumentos desejados

YOUR_API_KEY_HERE pela sua chave de API OpenAI) kurtosis run github.com/kurtosis-tech/autogpt-package --enclave autogpt ' {"OPENAI_API_KEY": "YOUR_API_KEY_HERE"} 'kurtosis service shell autogpt autogpt --exec " python -m autogpt "

YOUR_API_KEY_HERE pela sua chave de API OpenAI) kurtosis run github.com/kurtosis-tech/autogpt-package --enclave autogpt ' {"OPENAI_API_KEY": "YOUR_API_KEY_HERE"} 'kurtosis service shell autogpt autogpte então dentro do prompt:

> python -m autogpt kurtosis enclave rm -f autogpt

Para passar qualquer um dos valores de configuração do AutoGPT listados aqui, passe o argumento como uma propriedade do objeto JSON que você está passando para Kurtosis, assim como passou em OPENAI_API_KEY .

Por exemplo, é assim que você passaria o sinalizador RESTRICT_TO_WORKSPACE :

kurtosis run github.com/kurtosis-tech/autogpt-package --enclave autogpt ' {"OPENAI_API_KEY": "YOUR_API_KEY_HERE", "RESTRICT_TO_WORKSPACE": "False"} ' NOTA: este pacote ativa o AutoGPT usando o back-end local por padrão. Outros back-ends estão disponíveis definindo o parâmetro MEMORY_BACKEND no objeto JSON que você passa ao executar o comando kurtosis run acima.

Por exemplo, para definir o backend de memória redis :

kurtosis run github.com/kurtosis-tech/autogpt-package --enclave autogpt ' {"OPENAI_API_KEY": "YOUR_API_KEY_HERE", "MEMORY_BACKEND": "redis"} 'NOTA : Redis não está funcionando com 0.4.0 por enquanto

Para executar com uma imagem diferente daquela codificada em main.star use

kurtosis run github.com/kurtosis-tech/autogpt-package --enclave autogpt ' {"OPENAI_API_KEY": "YOUR_API_KEY_HERE", "AUTOGPT_IMAGE": "significantgravitas/auto-gpt:v0.4.0"} ' Kurtosis oferece suporte ao sinalizador de configuração ALLOWLISTED_PLUGINS que acompanha o AutoGPT. Por exemplo, para executar o plugin AutoGPTTwitter faça o seguinte:

kurtosis run github.com/kurtosis-tech/autogpt-package --enclave autogpt ' {"OPENAI_API_KEY": "YOUR_API_KEY_HERE", "ALLOWLISTED_PLUGINS": "AutoGPTTwitter"} 'Para fazer com que vários plug-ins sejam executados ao mesmo tempo; separe-os com vírgula sem espaços assim:

kurtosis run github.com/kurtosis-tech/autogpt-package --enclave autogpt '{"OPENAI_API_KEY": "YOUR_API_KEY_HERE", "ALLOWLISTED_PLUGINS": "AutoGPTTwitter,AutoGPTEmailPlugin"}'

Nos bastidores, o Kurtosis fará o download e instalará o pacote para você.

A partir de agora, os seguintes plug-ins são suportados:

Para adicionar suporte para mais plug-ins, basta criar um problema ou criar um PR adicionando uma entrada em plugins.star .

Entendemos que o OpenAI pode ser caro para algumas pessoas; mais ainda, algumas pessoas podem estar tentando usar isso com seus próprios modelos. AutoGPT-Package suporta a execução de AutoGPT em um modelo GPT4All executado via LocalAI . Para usar um modelo local -

kurtosis run github.com/kurtosis-tech/autogpt-package ' {"GPT_4ALL": true} ' Isso usa o modelo padrão https://gpt4all.io/models/ggml-gpt4all-j.bin

Para usar um modelo diferente, tente o parâmetro MODEL_URL como -

kurtosis run github.com/kurtosis-tech/autogpt-package ' {"GPT_4ALL": true, "MODEL_URL": "https://gpt4all.io/models/ggml-gpt4all-l13b-snoozy.bin"} ' Para desenvolver neste pacote, clone este repositório e execute o seguinte:

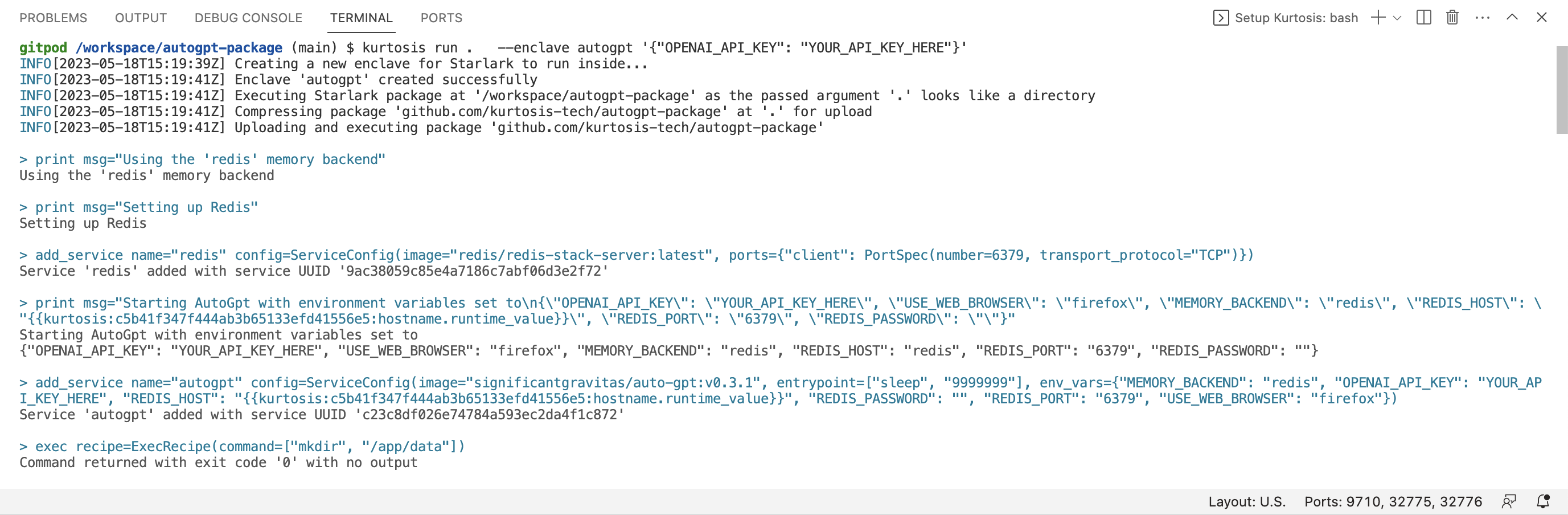

kurtosis run . --enclave autogpt ' {"OPENAI_API_KEY": "YOUR_API_KEY_HERE"} ' Observe o . - diz ao Kurtosis para usar a versão do pacote em sua máquina local (em vez da versão no Github).

Kurtosis também possui uma extensão disponível no mercado VSCode que fornece destaque de sintaxe e preenchimento automático para o Starlark que compõe este pacote.

Deixe-nos saber em nosso Discord ou no Twitter @KurtosisTech!

Sinta-se à vontade para criar um problema no GitHub se tiver algum bug ou solicitação de recurso.